… and if he does not do it solely for his own pleasure, he is not an artist at all.

OSCAR WILDE, The Soul of Man under Socialism

Un científico encuentra muchos motivos para escribir un libro de divulgación científica, aunque también hay muchas razones para no hacerlo. Desde luego, lo primordial en toda actividad científica es y será siempre la investigación: con ella se forja una carrera profesional y se ganan premios. Todo lo demás hace perder un tiempo precioso, al menos tal como lo ven algunos colegas que se ven obligados a sopesar ventajas e inconvenientes a la hora de tomar una decisión importante.

Pero ¿para qué sirven todos los avances científicos si uno no puede transmitirlos? ¿Realmente comprendemos el universo cuando no somos capaces de explicárselo a alguien que no haya estudiado previamente una carrera de varios años? Con demasiada frecuencia resulta que el aprendizaje de una materia compleja queda limitado a la aceptación de unos conceptos fundamentales y a entrenarse para manejar unos métodos de cálculo. La auténtica prueba para saber si hemos comprendido todo surge cuando hemos de explicar nuestros conocimientos a cualquier lego de mentalidad abierta. Por ejemplo, la mecánica cuántica, a pesar de todo su éxito y sus múltiples aplicaciones tecnológicas, es difícil de entender, cosa que se podrá comprobar en el capítulo 3 de este libro. Para un científico escribir un libro de divulgación científica es, pues, un buen ejercicio, además de resultar extremadamente importante para la propia investigación.

Además, un libro de divulgación científica es el medio idóneo para mostrar la unidad de la ciencia, la literatura y las artes plásticas. En todos estos ámbitos la persona se hace una imagen del mundo e intenta transmitirla. Por supuesto, esta unidad no existe realmente; es solo un ideal. Sin embargo, un libro que pretenda ser comprensible para todo el mundo tiene también derecho a intentar forjar esa síntesis ideal. Por consiguiente, quiero expresar mi agradecimiento a todos los autores citados en este libro que me han ayudado a configurar dicha unidad. En el contexto de las artes plásticas, merece una mención especial Gianni Caravaggio por las obras de arte aquí reproducidas, que ilustran algunas de las ideas que a continuación se exponen. También debo dar las gracias a Rüdiger Vaas, que, a lo largo de los últimos años y a través de muchas discusiones, ha contribuido notablemente a aumentar mis conocimientos y mi capacidad para transmitirlos. Fue uno de los primeros que se interesaron por los resultados de mis investigaciones y consideraron que valía la pena difundirlos ampliamente. Es imposible mencionar aquí a todos los que me han animado, aunque haya sido solo mediante un breve correo electrónico, a descender de la torre de marfil de la ciencia. No obstante, quisiera nombrar en especial a Hartmut Schneeweiss, de la Astronomische Vereinigung Weikersheim.

Este libro no existiría sin la iniciativa de Jörg Bongs, de la editorial S. Fischer, y el posterior apoyo de Alexander Roesler durante la redacción del texto. También quiero expresar mi agradecimiento al Departamento de Física de la Universidad del Estado de Pensilvania, que se afana en proporcionar a sus miembros un ambiente extraordinariamente agradable y estimulante. Además, sin ser consciente de ello, me ha ayudado en la redacción del libro mediante la oferta de un semestre sabático, aunque la noble institución no sabía nada de mis planes al respecto.

Agradezco a Elisabeth y Stefan Bojowald la lectura crítica de una versión previa de este libro, así como algunas sugerencias, por ejemplo las relativas a las imágenes cíclicas que ofrece la egiptología. Para la elaboración de algunos pasajes ha sido de gran ayuda la calma que encontré en un acogedor lugar junto al Eifel.

State College, Pensilvania, abril de 2008

Cuanto más abstracta sea la verdad que quieres enseñar, más tendrás que tentar con ella a los sentidos.

FRIEDRICH NIETZSCHE, Más allá del bien y del mal

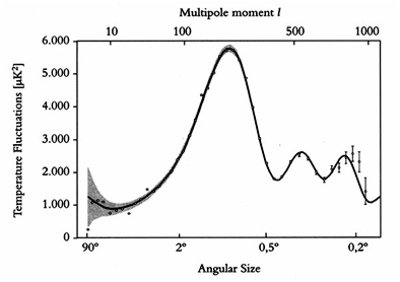

Durante el último siglo ha avanzado mucho la investigación en el campo de la física y ha desarrollado un imponente andamiaje teórico: la teoría cuántica y la teoría de la relatividad general. Este avance ha permitido comprender la naturaleza tanto a gran escala como en pequeñas dimensiones, desde la totalidad del universo mediante la cosmología, hasta las moléculas, los átomos e incluso las partículas elementales con ayuda de la teoría cuántica. Uniéndolo todo, se obtiene, para fenómenos muy diversos, una descripción precisa y una comprensión profunda que han sido verificadas de manera espectacular mediante observaciones. En los últimos años se ha conseguido esto ante todo en la cosmología del universo primitivo.

Además de su importancia tecnológica, en casi todos los ámbitos de la vida cotidiana la indiscutible marca de calidad de este progreso científico se hace patente por el hecho de que, desde hace algún tiempo, ciertos aspectos de la investigación chocan con los planteamientos tradicionales de la filosofía. (Como sostiene el físico y filósofo Abner Shimony, se puede hablar aquí de «metafísica experimental» con toda justicia, admitiendo también una deliberada contradicción interna). Desde Aristóteles, el objetivo de la construcción teórica es el examen de los hechos en general y la comprensión de sus causas, en vez de conformarse con una mera recopilación de conocimientos individuales. En cambio, la filosofía se pregunta por los fundamentos o principios más profundos de la realidad existente. En este sentido, la fusión de algunos planteamientos físicos con otros de índole filosófica se ha de entender como el rasgo característico del progreso científico. Cuando la física se abre paso entre estos interrogantes, consigue situarse en una posición desde la cual pueden abordarse discusiones relativas a intereses muy generales y de largo alcance. Por lo que respecta a la combinación de cosmología y física cuántica, la cuestión más importante es la relativa al origen y las primeras etapas del universo, algo que ha intrigado a la humanidad desde los inicios de la filosofía e incluso con anterioridad.

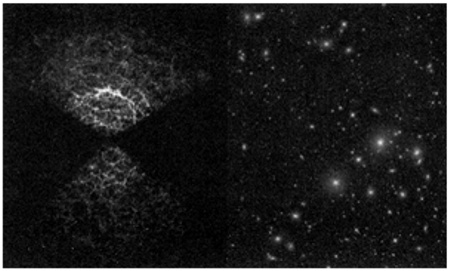

Otro ejemplo, tanto en la teoría cuántica como en la teoría de la relatividad general, es el papel de los observadores en el universo y la cuestión relativa a qué es lo que puede observarse y lo que no es posible observar. La aplicación de los métodos de la física en la cosmología implica la obtención de modelos del universo empíricamente comprobables. El modelo del big bang se basa tanto en la teoría de la relatividad general para la descripción del espacio, el tiempo y la fuerza de la gravitación, como en la teoría cuántica, que sirve para conocer las propiedades de la materia en el universo primitivo. En conjunto se obtiene una explicación asombrosa de la aparición sucesiva de los núcleos atómicos, de los átomos y de la materia que va configurando formas cada vez más complejas hasta llegar a las galaxias a partir de una fase inicial extremadamente caliente.

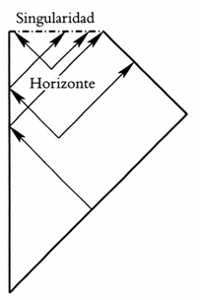

Sin embargo, es precisamente en este punto cuando también se ponen de manifiesto los límites del modelo del universo así establecido. A pesar de todos los éxitos obtenidos, la teoría de la relatividad general, junto con la teoría cuántica, tal como se utiliza actualmente, no consigue dar una descripción completa del universo. Si resolvemos las ecuaciones matemáticas de la teoría de la relatividad general para obtener un modelo de la evolución temporal del universo, se obtiene siempre un punto en el tiempo, la llamada «singularidad del big bang», en el que la temperatura del universo era infinitamente elevada. No decimos nada nuevo si afirmamos que el universo en la fase del big bang estaba muy caliente; hay que tener en cuenta que el universo en expansión de aquellos tiempos era mucho más pequeño y estaba mucho más comprimido que ahora, lo cual suponía un enorme aumento de la temperatura. Pero hablar de infinito como resultado de una teoría física significa sencillamente que se está abusando de dicha teoría. En ese punto, sus ecuaciones pierden todo su sentido. En el caso del modelo del big bang no debe confundirse esto con una predicción del comienzo del universo, aunque a menudo se representa así. Un momento en el que una ecuación matemática da como resultado «infinito» no es el principio (o el final) de los tiempos. Es simplemente un momento en el que la teoría muestra sus limitaciones. A pesar de todos los éxitos obtenidos en otros campos, es necesario ampliar esta teoría, que se ha desarrollado a partir de la teoría de la relatividad general en combinación con la teoría cuántica.

El problema tiene su raíz en el hecho de que la revolución que tuvo lugar en la investigación física del siglo pasado sigue siendo incompleta. La teoría cuántica se utiliza para explicar la materia en el universo, pero no se ha aplicado a la fuerza de la gravitación, ni siquiera a la cuestión del espacio y el tiempo. Esta última es el dominio de la teoría de la relatividad general, que sin embargo es en gran medida independiente de la teoría cuántica. Una combinación adecuada de la teoría cuántica y la teoría de la relatividad general que incluyera las cuestiones relativas al espacio y el tiempo ampliaría de manera considerable la teoría que actualmente se conoce. Esta combinación, la gravitación cuántica, es importante sobre todo para explicar la fase caliente del big bang en el universo, y es de esperar que podrá aclarar lo que sucedió en ese momento de resultado infinito, en la llamada singularidad del big bang. ¿Fue ese el instante inicial del universo y el tiempo, o hubo algo con anterioridad? Y, si hubo algo antes del big bang, ¿qué pudo ser?

Por desgracia, la gravitación cuántica resulta extraordinariamente complicada. En sí mismas la teoría de la relatividad general y la teoría cuántica se caracterizan por un enorme despliegue matemático como nunca se había conocido en teorías físicas anteriores. Además, los métodos matemáticos que se utilizan en estos dominios son muy diferentes entre sí. Una combinación de teorías físicas exige también una unificación de los objetos matemáticos que las sustentan, lo cual aumenta el grado de dificultad del proceso. Por esto, a pesar de las muchas décadas de investigación y de los grandes esfuerzos de numerosos científicos, no disponemos todavía de una formulación completa para la gravitación cuántica. Sin embargo, lo que sí hemos visto sobre todo en los últimos años es una gran cantidad de prometedores indicios relativos a sus propiedades, que ya pueden ser analizadas. Tal como suele suceder en la investigación, la situación se parece a la de los momentos iniciales en la configuración de un puzzle, cuando quizá se pueda intuir en parte la imagen final, pero también se podría estar emprendiendo un camino falso. Por ahora, la imagen de que disponemos nos da un indicio de lo que se podría conseguir completando la teoría física: nos permite ver lo que pudo suceder durante el big bang, e incluso antes. Nos hacemos una idea de cómo pudieron ser los instantes más remotos de la existencia de nuestro universo, y por primera vez podemos analizar el modo en que surgió.

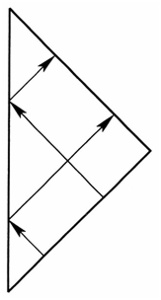

En este libro se hablará tanto de los resultados más recientes de la teoría como de las observaciones planificadas para un futuro cercano en el ámbito del universo, y se mostrará lo radical que podrá ser el cambio que produzcan en nuestra concepción del mismo. En particular, con la gravitación cuántica de bucles, una de las variantes que se manejan actualmente como combinación de la teoría de la relatividad general y la teoría cuántica, se ha conseguido establecer los elementos básicos para una descripción del big bang sin singularidades. En este marco el universo existía ya antes del big bang, y es posible valorar aproximadamente en qué medida sus características de entonces se diferencian de las actuales. A través de la influencia sobre fases posteriores de la expansión cósmica que unas observaciones sensibles ponen de manifiesto, se puede investigar la historia inicial del universo. A continuación se expondrá esta historia a partir de los resultados más recientes de la investigación, y seguiremos con los agujeros negros, que producen, asimismo, unos efectos fascinantes. Los capítulos finales tocan el planteamiento de cuestiones que van más allá, que se refieren a una comprensión general del universo, y entre las cuales se situarían la cosmogonía, el misterio del tiempo y su dirección, así como el Grial de la «fórmula universal». Al igual que la imagen científica del universo, también la senda humana hacia el conocimiento se verá ilustrada mediante ejemplos extraídos de la investigación moderna. En esta parte del libro se ofrecerán algunas ideas formuladas desde un punto de vista personal.

Aunque la teoría utiliza unas matemáticas de alto nivel, muchas ecuaciones pueden comprenderse de una forma intuitiva. La intuición no solo es útil a la hora de investigar en un campo desconocido, sino que permite también una explicación divulgativa. Esto es lo que pretende conseguir este libro, renunciando al formalismo matemático (salvo en la ilustración del apartado «La utilidad de las matemáticas», en el capítulo 5) y siguiendo fielmente la máxima de Nietzsche que se cita al principio de la introducción. Aunque para descubrir y examinar estos hechos es imposible renunciar a las matemáticas, se puede llegar a una clara comprensión de los mismos sin tanta profusión de fórmulas. Desde luego, no siempre se llegará a comprender por qué las cosas son así, y no de otra manera, pero con un poco de confianza en el guía turístico será posible reconocer algunas de estas relaciones.

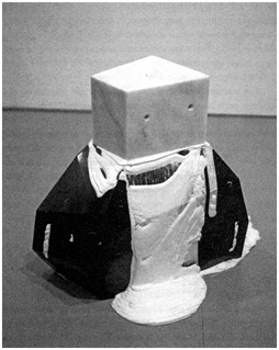

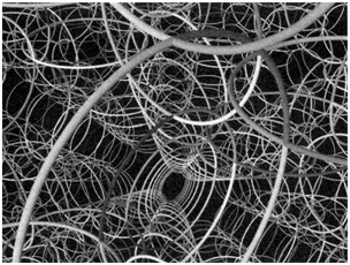

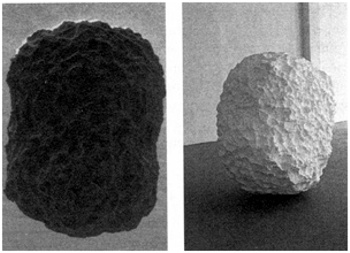

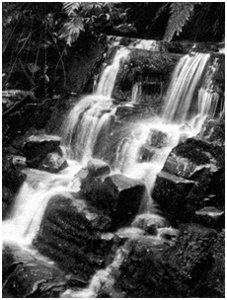

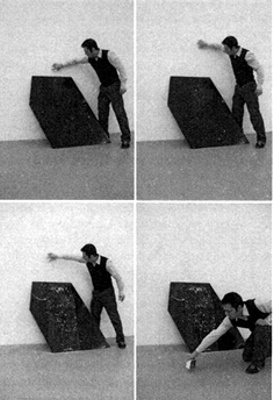

Figura 1: La piedra filosofal se derrite: un conocimiento que se da por seguro puede necesitar rectificaciones si se examina con más detenimiento. El análisis de los resultados o de las promesas de la ciencia debe tener en cuenta siempre los límites de esta. A menudo esos límites son incluso más importantes que los resultados ya obtenidos, porque indican el camino que llevará a nuevos descubrimientos. (Escultura de Gianni Caravaggio: Spreco di energia assoluta [Despilfarro total de energía], 2006, mármol negro marquina, mármol cepillado, crema, lente negra, 50 × 70 × 80 cm. Fotografía de Roberto Marossi).

No obstante, es necesario formular una advertencia: muchos dominios de la investigación de la gravitación cuántica han de ser considerados todavía como especulativos. A diferencia de lo sucedido durante la primera mitad del siglo pasado, cuando se desarrollaron la teoría de la relatividad general y la teoría cuántica, no existen (todavía) unas observaciones que puedan valer como pauta para la reformulación teórica de la gravitación cuántica. Lo que actualmente impulsa la investigación son ponderaciones conceptuales del estado incompleto que presenta la teoría de la relatividad general, así como los requisitos de coherencia matemática en la formulación de ecuaciones. Por ejemplo, no está en absoluto garantizado que la combinación de determinados métodos matemáticos, como los utilizados en la teoría de la relatividad general y en la física cuántica, conduzca a unas soluciones que permitan una descripción fiable del universo. De hecho, los métodos matemáticos son tan restrictivos que la formulación de una teoría con soluciones que tuvieran sentido constituiría un éxito extraordinario. La posibilidad de que hubiera otras teorías con esta característica es otra cuestión que hasta ahora no se ha investigado plenamente. Esto revela la fragilidad de los fundamentos en los que se apoya hoy día la gravitación cuántica. Sin embargo reina el optimismo, ya que hay muchos indicios independientes, como los que se presentan en este libro, que apuntan en la misma dirección. Por otra parte, y es lo más importante, para un futuro próximo se espera la realización de unas observaciones cosmológicas que podrían poner de manifiesto los fenómenos que predice la gravitación cuántica. Tales observaciones, que también se describen en este libro, convertirían la gravitación cuántica definitivamente en una teoría comprobada de forma empírica.

El estado en que se encuentra la gravitación cuántica es todavía equivalente a la primera etapa de explotación de un nuevo territorio. El papel del pionero lo desempeñan aquí las matemáticas, que abren nuevos dominios más allá de las fronteras establecidas. En nuestro caso las fronteras son las del universo y el tiempo. Las matemáticas sirven también para la exploración de ese territorio recién conquistado, pero la observación es el único procedimiento para asegurarlo definitivamente en el marco de una ciencia empírica como la física. Esto es lo que por ahora le falta a la gravitación cuántica, que por esta razón es todavía como un territorio lleno de peligros. En él es demasiado fácil extraviarse o hundirse en la ciénaga de la especulación.

Un terreno como este exige un profundo respeto a la naturaleza, pero no siempre se satisface esta exigencia. Aunque el lenguaje de los físicos al referirse a la naturaleza suele sonar muy preciso (a veces incluso pedante), en general se cumple lo que decía Rudolf Carnap: « [Una ley natural] puede ser verdadera, pero también falsa. Cuando no es verdadera, la culpa la tiene el físico, no la naturaleza».

[1] El físico formula leyes de la naturaleza, pero, si estas no se cumplen, la responsabilidad es de él. Nadie es vasallo del físico, ni siquiera la naturaleza. Esto es especialmente válido en el caso de ciertos bosquejos teóricos, como la gravitación cuántica. Mientras tanto, hasta que las observaciones muestren que la naturaleza siente al menos algún respeto por las leyes que aquí se proponen y detallan, la intuición sirve de guía para el viajero que se adentra en un territorio desconocido y emprende la aventura de viajar a la época anterior al big bang.

Cuando se me cae algo por la ventana (aunque sea una cosa de tamaño mínimo), hay que ver cómo se abalanza la ley de la gravedad, poderosa como un viento marino, sobre una pelota cualquiera y sobre una simple baya, para arrastrarlas hacia el núcleo del universo.

RAINER MARIA RILKE, El libro de horas

Contenido:

3.1. Espacio-tiempo curvo

3.2. Límites del espacio y el tiempo

3.3. Carencia de fuerzas antagonistas

Se puede decir que, grosso modo, el universo está gobernado por la fuerza de la gravitación. En física, cuando una fuerza actúa, se produce movimiento o algún tipo de transformación. El reposo total solo existe cuando no actúa fuerza alguna. Esto es posible, por ejemplo, en ausencia de materia, en lo que se denomina el vacío. Pero la materia evidentemente existe, y solo a causa de su masa ejerce una fuerza gravitatoria sobre otras masas. Para que se den estados de reposo, al menos aproximados, es preciso que las fuerzas presentes se compensen entre sí. Además de la fuerza de la gravitación hay que tener en cuenta las fuerzas eléctrica y magnética, así como, en principio, otros dos tipos de fuerza que se denominan interacción débil e interacción fuerte, y actúan en el ámbito de las partículas elementales.

Mientras que la fuerza eléctrica necesita la existencia de cargas positivas y negativas para mantenerse activa a grandes distancias, las fuerzas que actúan en el interior de los núcleos atómicos tienen solo un alcance extremadamente corto. Por lo tanto, la única que en cualquier caso se mantiene a grandes distancias es la fuerza de la gravitación. Esta fuerza explica la atracción que se produce en general entre masas y acumulaciones de energía en el espacio, así como el comportamiento del propio universo a través del tiempo. A diferencia de lo que sucede en el caso de la electricidad, aquí no existen masas negativas: la atracción gravitatoria no puede contrarrestarse. Una vez que aparecen objetos dotados de una gran masa, como las estrellas o las galaxias, la interacción gravitatoria que estos objetos ocasionan domina todo lo que vaya a suceder. El tema de este libro son precisamente las múltiples facetas de esta fuerza, que tan a menudo ha sido ignorada en lo cotidiano y en las primeras investigaciones —tanto en cosmología como en lo relativo a los agujeros negros—, y que, sin embargo, produce tal multiplicidad de fenómenos curiosos.

1. La ley de la gravitación de Newton

La primera ley de la gravitación universal fue formulada por Isaac Newton. Siguiendo la pauta habitual de muchos avances importantes en la investigación relativa a la gravitación, fueron decisivas en este caso las observaciones cotidianas de la naturaleza, aunque también fue determinante una larga serie de trabajosas observaciones de objetos espaciales, concretamente de la Luna y algunos planetas. Todo ello fue posible gracias al desarrollo técnico, que para la época era muy avanzado, y a su vez las propias observaciones influyeron y propiciaron el desarrollo de nuevos instrumentos. Esta historia de logros obtenidos mediante una combinación de cuestiones fundamentales y aplicaciones tecnológicas ha seguido de manera ininterrumpida hasta el día de hoy en muchos campos de la investigación científica, incluido el de la investigación relativa a la gravitación.

Con anterioridad a Newton, el casi desbordante flujo de datos obtenidos por astrónomos como Tycho Brahe, Johannes Kepler y muchos otros se había ordenado ya para configurar un modelo de sistema solar. Desde los tiempos de Nicolás Copérnico y Johannes Kepler este modelo había adoptado una forma similar en gran medida a la que conocemos actualmente: los planetas se mueven alrededor del Sol siguiendo trayectorias que en una buena aproximación pueden describirse como elipses, es decir, como círculos un tanto estirados. Pero ¿a qué se debía que los planetas siguieran unas trayectorias curvas especialmente determinadas para cada uno de ellos? A partir de la experiencia cotidiana sabemos que es necesaria una fuerza para modificar el movimiento rectilíneo de un cuerpo. ¿Cómo se puede describir o explicar esa fuerza en el caso de los planetas?

Es impresionante el impacto de la revolucionaria idea de Newton, según la cual existe una única fuerza, la fuerza de la gravitación, que no solo determina la trayectoria de todos los planetas alrededor del Sol, y de la Luna en torno a la Tierra, sino también los sucesos ordinarios de caída de cuerpos sobre nuestro planeta. Constituye un ejemplo excelente para entender los orígenes del razonamiento científico: no se da respuesta a una pregunta sobre el «porqué» en el sentido de una motivación antropomórfica, sino que múltiples y diversos fenómenos, que parecen complicados y aparentemente inconexos, serán remitidos a un único mecanismo, una ley natural. Además, la descripción matemática formulada por Newton es muy compacta y, por lo tanto, altamente eficaz para la predicción de fenómenos descritos por la misma ley. En el caso de la ley de la gravitación de Newton, esta se ha utilizado en repetidas ocasiones, por ejemplo para el descubrimiento de nuevos planetas considerando las ligeras desviaciones que estos ocasionan en las trayectorias de planetas conocidos, o para planificar las misiones de los modernos satélites.

Estos casos históricamente fulgurantes en los que una elegante descripción matemática logra explicar muchos fenómenos diferentes son frecuentes en la física y constituyen los hitos que marcan el progreso de esta ciencia. A menudo estas ideas son tan impresionantes que los científicos recurren al concepto de belleza, una belleza pragmática cuyo núcleo dentro de la formulación matemática solo es visible para los iniciados, si bien los legos también la reconocen en los logros concretos.

La ley de la gravitación de Newton describe concretamente la fuerza de atracción que existe entre dos cuerpos en virtud de sus masas. La fuerza aumenta en proporción a las dos masas, de tal modo que la fuerza de atracción es mayor entre objetos muy pesados que entre otros más ligeros. Depende también de la distancia que separa los cuerpos, pero en proporción inversa al cuadrado de dicha distancia. En consecuencia, la fuerza de la gravitación se debilita cuando los cuerpos se alejan el uno del otro. Aparte de estas proporcionalidades, la magnitud exacta de la fuerza puede calcularse utilizando una constante matemática, llamada constante de la gravitación de Newton. También aquí se pone de manifiesto con total claridad la unificación de los fenómenos terrestres con los celestes: la constante de la gravitación se puede calcular a partir de la débil atracción que se produce entre dos masas sobre la Tierra, tal como lo hizo Henry Cavendish por primera vez entre 1797 y 1798 en su laboratorio. Si se utiliza el mismo valor para calcular la fuerza que el Sol ejerce sobre los planetas, se obtienen exactamente las trayectorias observadas para estos cuerpos celestes.

Mientras la dependencia de la distancia es un hecho claro, por el contrario sucede que la fuerza de la gravitación de Newton es totalmente independiente del tiempo. Esto suena plausible, pues una ley natural básica como esta debe aplicarse del mismo modo en cualquier instante. Asimismo concuerda con las opiniones sobre el tiempo y el espacio que predominaron en la época de Newton e incluso mucho después, por no hablar de nuestras ideas cotidianas al respecto. Aunque es posible cambiar la posición y la distancia de los objetos en el espacio, este último resulta en sí mismo invariable. También el tiempo transcurre de una manera sencilla y regular, sin dejarse impresionar por los fenómenos físicos. Dado que, según Newton, la gravitación actúa sin que para ello tenga que transcurrir un tiempo, con independencia de la distancia a la que se encuentren las masas, la ley se aplica solo en el caso de que ambas masas no estén en el mismo lugar, pero sí en el mismo instante. Por lo tanto, la ley es totalmente independiente del tiempo, e incluso la «distancia temporal» existente entre las masas es irrelevante, al contrario de lo que sucede con la distancia espacial.

A pesar de su enunciado plausible y de los logros que he mencionado antes, la teoría de Newton tiene un defecto estético. Al igual que sucede con la belleza de la teoría, esta imperfección solo puede comprenderse del todo si se posee un conocimiento suficiente del trasfondo, pero, aunque se considere superficialmente, es un buen ejemplo del modo en que avanza la física teórica. Parece ser que el propio Newton lamentaba el hecho de que su ley de la gravitación mostrara «tendencias animalísticas»: del mismo modo que un animal se siente atraído desde lejos por la visión de algo comestible, así también un cuerpo pesado se mueve desde la lejanía hacia otro. A pesar de todos los logros concretos a que dio lugar, ese efecto que se produce desde lejos, y no como las interacciones locales ocasionadas cuando los cuerpos entran en contacto directo, se consideró una debilidad conceptual.

Subsanar este punto débil mediante una teoría que contemple solo interacciones locales, y que además tenga que ser compatible con los logros de la teoría newtoniana en astronomía, es una empresa extremadamente difícil. Además, es necesario tener en cuenta también la dimensión temporal, ya que una interacción local de este tipo tendría que propagarse de un cuerpo a otro. Como ya se ha comprobado, esto solo puede conseguirse dando la vuelta radicalmente a los planteamientos newtonianos, y evidentes, relativos al espacio y al tiempo. Para ello se necesita un despliegue matemático de mucha más envergadura, que sin embargo se vería recompensado con una teoría de una belleza insospechada, en el sentido que se ha mencionado anteriormente. Todo esto exigía una exhaustiva investigación física, así como un mayor desarrollo de los fundamentos matemáticos. Albert Einstein sería el encargado de solucionar el defecto de la teoría newtoniana en una época muy posterior a la de Newton.

2. La relatividad del espacio y el tiempo

Todo esto duró mucho tiempo, o poco, porque, hablando con propiedad, en esta tierrano haytiempo para tales cosas.

FRIEDRICH NIETZSCHE, Así habló Zaratustra

Las primeras fisuras en la visión newtoniana del mundo se pusieron de manifiesto con la teoría de la relatividad especial. El espacio y el tiempo no podían ya verse como conceptos separados, sino como pertenecientes al mismo ámbito. Son dimensiones de un objeto físico único, el espacio-tiempo. ¿Cómo puede determinarse esto con métodos físicos? Para responder a esta pregunta y explicar el papel que desempeñan las dimensiones, vamos a empezar por considerar solo el espacio. También este tiene varias dimensiones, concretamente tres: podemos desplazarnos lateralmente, adelante o atrás, y hacia arriba o hacia abajo. Podríamos preguntarnos por qué se consideran como tres dimensiones de un único espacio, en vez de tres direcciones completamente independientes: ancho, largo y alto.

La respuesta es sencilla: la anchura, la longitud y la altura no son absolutamente independientes entre sí, sino que pueden «intercambiarse». Basta con que giremos en el espacio para que, por ejemplo, la altura de un cubo se presente como su anchura; en este sentido, la altura y la anchura son intercambiables. No se trata de un cambio realizado mediante un proceso físico, o una reacción química, sino de algo mucho más sencillo, pues basta con cambiar la posición del observador. Lo que llamamos anchura, longitud y altura depende de la posición del observador (o de convenios tales como medir la superficie terrestre según la anchura y la longitud) y, por lo tanto, no han de considerarse como características del espacio como objeto físico. Por ello se habla de espacio tridimensional, en vez de sobre la existencia de tres direcciones unidimensionales.

El tiempo se comporta de una forma parecida, aunque aquí el cambio es más difícil. El modo de ver el espacio se puede modificar mediante un simple giro: la variación del ángulo de visión (o, más exactamente, de la tangente del ángulo de visión como función matemática que, sin embargo, en el caso de ángulos pequeños no difiere mucho del valor del propio ángulo) viene dada por la proporción de una dimensión espacial, por ejemplo de la altura, antes y después del cambio de posición del observador. Por lo tanto, mediante la variación del ángulo solo pueden intercambiarse las dimensiones espaciales. Cuando queremos que el espacio se intercambie con el tiempo, debemos modificar una magnitud que viene dada por la proporción entre la dimensión espacial y la temporal: la velocidad. Si en un tiempo determinado recorremos una longitud concreta, nos estamos moviendo con una velocidad que viene dada por la proporción, o sea, el cociente, entre el espacio recorrido y el tiempo necesario para recorrerlo.

De hecho, esta reflexión conduce a la formulación básica de la teoría de la relatividad especial. Cuando estamos observando una situación y nos movemos a más velocidad que un segundo observador, los intervalos del espacio y el tiempo correspondientes a los sucesos observados resultan diferentes para nosotros y para el otro observador. Del mismo modo que un cambio del ángulo de visión produce un intercambio de dimensiones espaciales, así también un cambio en la velocidad del observador produce una conversión de las dimensiones espaciales en temporales, y viceversa. Esta es la razón por la cual la diferenciación entre dimensiones espaciales y temporales depende de la posición del observador (o, más exactamente, de la «trayectoria del observador», si en realidad estamos moviéndonos) y no tiene base física alguna que sea independiente de los observadores. No hay separación entre el espacio y el tiempo, puesto que solo existe un único objeto común: el espacio-tiempo.

Por supuesto, este ejemplo no constituye una prueba, ya que no es cierto que toda proporción lleve a una conversión solo modificando su valor. Por ejemplo, el índice de natalidad de un país se obtiene como la proporción de nacimientos con respecto a la población total, pero haciendo una modificación de dicho índice no se consigue que ningún habitante del país se convierta en recién nacido. Una diferencia importante con respecto a los ejemplos anteriores es el papel del observador: las modificaciones se producen mediante cambios en la posición o el movimiento de quien observa y, dado que los enunciados físicos han de ser independientes de las características especiales de quienes realizan la observación, queda descartada cualquier separación de aquellos conceptos que solo sean diferenciables por la posición del observador. En la teoría de la relatividad especial esta especie de «convertibilidad» entre el espacio y el tiempo no se fundamenta solo en las matemáticas, sino que también se ha comprobado experimentalmente en repetidas ocasiones. Mientras que la idea newtoniana de un espacio fijo y un tiempo independiente de él no concordaría con muchas de las mediciones realizadas durante el siglo pasado, desde la perspectiva de la teoría de la relatividad especial no surge contradicción alguna.

El punto de vista newtoniano tuvo éxito durante tantos siglos porque, para que se produzca una transformación perceptible entre el espacio y el tiempo, es preciso que los observadores se desplacen a unas velocidades altísimas que alcancen de manera apreciable la enorme velocidad de propagación de la luz (unos trescientos mil kilómetros por segundo). Esta es la razón por la cual esa convertibilidad de espacio y tiempo no es perceptible en el entorno cotidiano.[2] Para llevar a cabo una comprobación experimental se necesitan o bien velocidades muy altas, o unas mediciones del tiempo muy precisas para unas transformaciones mínimas que se producen a bajas velocidades. Ambas cosas han llegado a ser posibles durante el siglo pasado: mediciones muy precisas se consiguen con los relojes atómicos, que hacen observables las transformaciones del espacio y el tiempo incluso con las velocidades características de las aeronaves. (Dado que los aviones tienen que desplazarse a cierta altura, aparecen efectos adicionales a causa de una merma de la gravitación que influye en el reloj. Más adelante volveré sobre esta cuestión).

A altas velocidades, cercanas a la de la luz, las transformaciones son drásticas: se produce una transformación casi completa del tiempo en espacio, y con ello el tiempo transcurre cada vez más lentamente. Cuando se alcanza por fin la velocidad de la luz, lo cual solo es posible para objetos carentes de masa, como la propia luz, al moverse tan rápido el sistema, desaparecen en él los intervalos de tiempo. La velocidad no puede ir más allá de esa frontera, pues cuando se alcanza la velocidad de la luz se ha agotado ya todo el tiempo. Por lo tanto, ninguna señal puede propagarse más rápidamente que la luz. Se llega siempre a desaceleraciones que, aunque son pequeñas, en el caso de grandes distancias pueden hacerse perceptibles. (Esta velocidad máxima es la velocidad de la luz en el vacío. En materiales transparentes, como el agua, la luz suele propagarse más lentamente que en el vacío. En estos medios puede suceder también que haya señales que se desplacen más rápido que la luz en el mismo medio, pero no con mayor rapidez que la luz en el vacío).

Las altas velocidades pueden también investigarse, aunque no sometiendo un reloj a una fuerte aceleración, sino mediante la utilización de algunos relojes rápidos que nos proporciona la naturaleza: la Tierra recibe bombardeos de partículas de alta energía que proceden del universo y se desplazan con una velocidad cercana a la de la luz.[3] La mayoría de estas partículas no alcanzan la superficie terrestre, sino que reaccionan con núcleos atómicos en la parte superior de la atmósfera, dando lugar a nuevas partículas, entre las cuales se encuentran los muones. Estos son una especie de electrones pesados y se diferencian poco de los electrones, salvo por su masa y por el hecho de no ser estables: un muón en reposo se desintegra aproximadamente en una millonésima de segundo y da lugar a un electrón y a otras dos partículas estables, que reciben el nombre de neutrinos. Este tiempo de desintegración se puede utilizar como unidad de tiempo de un reloj, que, en comparación con los relojes atómicos, no sería muy preciso. Sin embargo, es mucho más fácil acelerar muones hasta que alcancen altas velocidades que hacer lo mismo con relojes atómicos, y además es algo que la naturaleza nos proporciona sin coste alguno mediante la radiación cósmica.

Esto lleva a una impresionante confirmación de la teoría de la relatividad especial y su convertibilidad del espacio y el tiempo. Incluso con las altas velocidades con las que surgen los muones en la zona superior de la atmósfera, el tiempo de vida de una millonésima de segundo no es suficiente para que puedan llegar desde allí a la superficie terrestre. Sin embargo, es posible medir un gran número de esos muones mediante detectores, aunque en realidad dichas partículas se hayan desintegrado ya por el camino. La razón de esto es que esa millonésima de segundo que tarda el muón en reposo en desintegrarse parece mucho más larga para un muón que se mueve a gran velocidad y que está siendo observado desde una superficie terrestre en reposo. A causa de su gran velocidad, para los muones es tanta la cantidad de espacio que se convierte en tiempo que pueden alcanzar la superficie terrestre antes de desintegrarse, cosa que no sería posible sin esa dilatación del tiempo, a pesar de su alta velocidad.

Cuando estaba desarrollando su teoría de la relatividad especial, Einstein no tenía todavía a su alcance las mediciones con relojes atómicos o mediante muones. En vez de eso, se dedicó a deducir las ecuaciones que describen la conversión del espacio y el tiempo, basándose en profundas reflexiones sobre la teoría de la luz, tal como la había expuesto James Clerk Maxwell en 1861. La aplicación de esos principios, prescindiendo de cualquier observación, se puede comparar con la visión de Newton en relación con la imperfección de su propia teoría. La ley de la gravitación de Newton tuvo un gran éxito en el momento de su aparición, y posteriormente durante mucho tiempo, a la hora de explicar diversos fenómenos astronómicos observados. Pasaron siglos hasta que se realizaron ciertas observaciones que sin duda se desviaban de lo que establecía la ley de Newton. Sin embargo, este científico nunca estuvo del todo satisfecho con su ley, porque, como él mismo afirmó, resultaba demasiado anomalística: ¿qué es lo que induce a dos masas a atraerse mutuamente, si pueden estar todo lo alejadas que quieran la una de la otra?

Este defecto que Newton ya intuía llegó a ser crítico en el contexto de la teoría de la relatividad especial. En la idea newtoniana de separación del tiempo y el espacio no hay en principio problema alguno con la ley de la gravitación; como mucho hay un problema estético. Sin embargo, en la teoría de la relatividad especial la ley de Newton resulta sencilla y llanamente incoherente: la fuerza gravitatoria newtoniana depende de la distancia espacial entre dos cuerpos, pero no aparece en su fórmula ninguna magnitud temporal. Si se intenta combinar esto con una convertibilidad del espacio y el tiempo, entonces cualquier aplicación consecuente de la ley implica que la fuerza gravitatoria depende del estado de movimiento y de la velocidad del aparato de medición. Esto es así porque cualquier variación de la velocidad tendría que convertir el espacio en tiempo, y con ello ocasionaría una dependencia temporal en la ley de Newton. La reducción de la distancia espacial se vería entonces compensada por la dilatación del tiempo, de tal modo que cualquier observador pueda medir la fuerza correcta. Al formular su ley, Newton no tuvo en cuenta esta posibilidad, por lo que se hace necesario ampliar la teoría newtoniana.

En la teoría electromagnética surge una situación parecida. La ley de Coulomb para la atracción (o repulsión) electrostática de dos cuerpos dotados de cargas eléctricas, que recibe su nombre de Charles-Augustin de Coulomb, se parece mucho a la ley newtoniana relativa a la atracción gravitatoria de dos masas. Lo único que hay que hacer es sustituir las masas por las cargas, y la constante de la gravitación de Newton por un parámetro que cuantifica la fuerza eléctrica. (Además, es necesario invertir el signo de la fuerza, ya que dos cargas del mismo signo se repelen, mientras que dos masas, siempre positivas, se atraen). Sin embargo, el comportamiento de las distancias espaciales es el mismo, y aquí tampoco interviene ninguna dimensión temporal. En este caso, y por otros motivos, basados en la relación entre fenómenos eléctricos y magnéticos, Maxwell halló una formulación que era compatible con la convertibilidad del espacio y el tiempo. Esto sucedió antes de Einstein y desempeñó un papel importante en las reflexiones de este científico. Sin embargo, Maxwell no reconoció la relación de su ampliación de la ley de Coulomb con la convertibilidad del espacio y el tiempo.

En 1905, cuando Einstein desarrolló su teoría de la relatividad especial, no existía ninguna reformulación de la ley de la gravitación de Newton. Esta generalización de la teoría, de la cual se encargó el propio Einstein, resultaría mucho más difícil que la de Maxwell. Transcurrieron diez años hasta que Einstein presentó en 1915 su forma definitiva: la teoría de la relatividad general. La, recompensa no consistió solo en el logro de una ley de la gravitación compatible con los principios de la teoría de la relatividad especial, sino en un cambio radical de nuestra manera de entender el espacio y el tiempo, así como una fundamentación matemática de la cosmología. En este capítulo me centraré principalmente en la estructura del espacio y el tiempo, para luego, en el capítulo relativo a la cosmogonía (capítulo 9, sección titulada Cosmología física), volver al papel que desempeñan estas magnitudes en el comportamiento del universo en su conjunto.

Él mueve el universo sin esfuerzo, tan solo con su sabiduría y su voluntad.

JENÓFANES DE COLOFÓN, Fragmento

La teoría de la relatividad general incluye una ley de la gravitación que es compatible con la teoría de la relatividad especial. Sin embargo, la teoría de la relatividad general no es solo una versión más ampliada y compleja de la ley de Newton, sino que consagra definitivamente el espacio-tiempo como un objeto de la investigación física. La determinación de qué se considera espacio y qué se considera tiempo no depende únicamente de la situación del observador, sino que es algo sometido a procesos físicos: la forma del espacio-tiempo viene determinada por la materia. Así como en la teoría de la relatividad especial las velocidades han de ser muy grandes para ver claros los efectos, la influencia de la materia en el espacio-tiempo es normalmente escasa. Con la tecnología de que disponemos en la actualidad no es posible influir en el espacio-tiempo (aunque ocasionalmente se especula sobre la construcción de agujeros de gusano, motores de curvatura o pequeños agujeros negros). Sin embargo, en astrofísica o en cosmología nos encontramos a menudo con unos objetos tan pesados que, para hacer una descripción precisa de los mismos, no solo se ha de tener en cuenta la materia que contienen, sino también el espacio y el tiempo. Hasta la fecha, esto ha llevado a la realización de numerosas comprobaciones de la teoría de la relatividad general y, como veremos más adelante, a una nueva imagen del universo en el marco de la cosmología.

No obstante, como en el caso de la teoría de la relatividad especial, Einstein no disponía en 1915 de observaciones de este tipo; sus construcciones se basaban en la posibilidad de una formulación matemáticamente coherente de sus principios. El resultado fue una teoría dotada de una elegancia que nunca antes se había logrado en física. Basándose en principios generales y en una versión geométrica de las matemáticas que se remonta a los sublimes comienzos de la ciencia en la antigua Grecia a través de una larga e ilustre línea de antepasados (en el caso de la geometría, sobre todo, Platón y Euclides), surgió casi necesariamente un tipo de ecuaciones que describen el universo en su totalidad.

Einstein tuvo que esforzarse durante mucho tiempo, hasta que logró comprender cuáles eran los principios correctos y las matemáticas necesarias, pero su trabajo acabó siendo coronado por un extraordinario éxito. La teoría no solo satisfacía las más altas exigencias de las matemáticas, en cuyo contexto hasta hoy día ha producido importantes estímulos para la investigación, sino que más tarde explicaría muchas observaciones en las que siempre habría fracasado la teoría de Newton.

En cualquier caso, esto justifica el gran interés que suscitaron Einstein y sus logros; sin embargo, en las últimas décadas lamentablemente el éxito se ha convertido a menudo en una maldición: a menudo surgen amplios colectivos de físicos a los que les parece que la teoría de la relatividad general se comprende perfectamente y está totalmente confirmada de un modo experimental. En ocasiones incluso se utiliza esto como argumento para suprimir investigaciones en este campo y prescindir del personal vinculado con las mismas. Precisamente en Alemania, la cuna de la teoría de la relatividad general, se da lamentablemente esta circunstancia. Por supuesto, nunca es posible la confirmación completa de una teoría, por lo que, sobre todo en algo tan importante como la teoría de la relatividad general, nunca se debería renunciar a realizar nuevos experimentos que puedan proporcionar comparaciones independientes entre la teoría y la observación. La cantidad de experimentos que sirven para comprobar una teoría nunca llega a cubrir más que una porción limitada de todos los fenómenos posibles. Una teoría comprobada experimentalmente puede resultar adecuada en un marco concreto, pero no hay seguridad alguna de que pueda describir correctamente todos los posibles procesos a los que en principio sería aplicable. Del mismo modo que la teoría de Newton estuvo durante mucho tiempo en concordancia con los fenómenos observados, hasta que se descubrió que solo era válida como un caso extremo de la teoría de la relatividad general, también podría suceder que esta última fuera quizá tan solo un caso extremo de alguna teoría que todavía es desconocida. Incluso en su aspecto teórico la teoría de la relatividad se comprende aún de una manera incompleta, y son innumerables las preguntas sin respuesta que tienen una incidencia directa sobre todo en el campo de la cosmología. Sigue siendo perentoria la necesidad de realizar investigaciones. De hecho, muchos indicios apuntan a que la teoría de la relatividad general aún ha de completarse, como veremos más adelante.

En su mayoría, las teorías físicas se desarrollan mediante un laborioso y largo proceso que arranca de una idea creativa o de una observación que no se explica con los conocimientos existentes. O bien se procede a desarrollar esa idea, porque pueda resultar atractiva desde un punto de vista estético y matemático, o se intenta modificar las teorías ya conocidas, para que concuerden con el nuevo fenómeno observado. Este proceso puede durar décadas, y lo más frecuente es que en él participen muchos físicos, tanto teóricos como experimentales. Muchas de las teorías que son actualmente objeto de acaloradas discusiones, como la física de partículas elementales o la gravitación cuántica, las cuales se recogen en este libro, están todavía dentro de ese proceso. También el desarrollo de la mecánica cuántica transcurrió de este modo durante mucho tiempo, hasta que quedó forjada tal como la conocemos hoy día. (Aquí también hay un gran número de interrogantes fundamentales que continúan abiertos, pero desde la perspectiva de su aplicación se considera que la mecánica cuántica se comprende totalmente). El resultado final, tal como luego se expone en los libros de texto, a menudo no es reconocible si se compara con los primeros esbozos, ya que se ha puesto de manifiesto que muchas de las aportaciones históricas realizadas durante la evolución del proceso eran en realidad nada importantes, demasiado complicadas o incluso erróneas. En el caso de las teorías que se encuentran aún en fase de desarrollo no se puede prever si surgirá de ellas un sólido componente del conocimiento del universo; hay ramas de la física que han resultado en su totalidad un callejón sin salida, aunque lo cierto es que de la investigación siempre se aprende algo que luego se puede utilizar para otra cosa.

En el desarrollo que hizo Einstein de la teoría de la relatividad general fue todo completamente diferente. Fue Einstein en solitario, apoyado solo por algunos amigos como Marcel Grossmann y, de algún modo, rivalizando con el matemático David Hilbert, quien realizó los trabajos decisivos. No todo encajó de forma coherente, y habría que reconocer que algunas de las ideas publicadas demostraron ser inutilizables. Sin embargo, en un tiempo relativamente corto Einstein llegó a su resultado final, que, manteniendo su propia forma, respondió maravillosamente bien al aplicarlo a fenómenos observados. Es fácil que al saber esto tengamos la impresión de que Einstein habría creado su teoría de manera directa y en su forma perfecta, y que no sería necesario proceso alguno de aburrida investigación, ni pesadas tareas de perfeccionamiento; esto explica seguramente por qué muchos físicos consideran que la teoría de la relatividad general no necesita más investigaciones[4].

Pero la realidad es muy diferente. Solo se comprenden las soluciones más sencillas de la teoría de la relatividad general, lo cual afortunadamente basta para dar respuesta a muchas cuestiones de la física, porque incluso las soluciones más elementales y dotadas de una alta simetría permiten llegar a explicaciones asombrosas relativas a la cosmología y a objetos astronómicos tales como los agujeros negros. Sin embargo, cuando se quiere ir más allá de estas soluciones, aparecen unas dificultades enormes a causa de la complejidad de la teoría. Esta es la razón por la cual muchos matemáticos se interesan por ciertas cuestiones de la teoría de la relatividad general y no cesan de hacer aportaciones a su comprensión. También existen preguntas abiertas, como la relativa a la predictibilidad (mencionada, por ejemplo, en la página 240), que afectan a la coherencia global de la física.

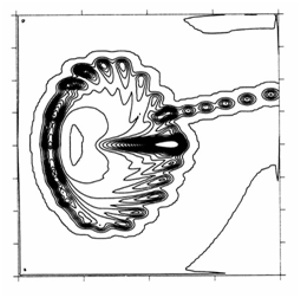

La realización por ordenador de un análisis numérico de las ecuaciones de Einstein es a menudo el último recurso cuando las resoluciones matemáticas directas resultan demasiado difíciles, pero, incluso así, dicho análisis constituye una tarea extremadamente complicada. Los intentos iniciales se hicieron en la década de 1970 y se intensificaron en la de 1990. Se trataba en especial de comprender mejor las colisiones entre estrellas pesadas o agujeros negros, ya que estos fenómenos están considerados como fuentes potentes de un fenómeno totalmente nuevo: las ondas gravitatorias. En los próximos años se espera poder demostrar la existencia de estas ondas mediante detectores sensibles, no solo para seguir comprobando la teoría de la relatividad general, sino también para abrir una nueva rama de la astronomía. De esta forma se mediría el cosmos, no mediante la luz u otra radiación electromagnética, sino con ayuda de las ondas gravitatorias. Esto sería como si, además de mirar lo que hay en el cielo, pudiéramos también escuchar lo que sucede en él. Esta analogía muestra claramente que las ondas gravitatorias posibilitarán nuevas experiencias y nuevos conocimientos.

Para realizar una comprobación mediante detectores es necesario, en primer lugar, saber qué es exactamente lo que se busca; también se ha de conocer la forma de las ondas: el curso temporal de la intensidad de una onda gravitatoria, cómo surge esta a partir de una colisión y el modo en que se propaga hasta nosotros a través del cosmos, una propagación similar a la de una onda en el agua. Lamentablemente, las ecuaciones matemáticas son demasiado complicadas para poder hacer una resolución directa, e incluso fue imposible durante mucho tiempo preparar los ordenadores para esta tarea: a causa de problemas de cálculo los programas informáticos disponibles interrumpían su funcionamiento demasiado pronto para conseguir mostrar resultados interesantes. Era como si se intentara escribir un largo texto con un programa que se bloqueara tras la introducción de cada palabra. Fue necesario el trabajo intensivo de algunos grupos (cuyo número sigue siendo modesto en comparación con los dedicados a las partículas elementales o a la física del estado sólido) durante muchos años para poder llegar recientemente (los primeros fueron los trabajos de Frans Pretorius en 2005) a abrir una vía en el desarrollo de los programas informáticos que proporcionaran al menos información numérica sobre el resultado de una colisión. Pero estos avances han llegado a tiempo, porque también la construcción de detectores de ondas gravitatorias, como el LIGO en Estados Unidos o el GEO600 en Hannover, ha progresado considerablemente, de tal modo que el sueño de una astronomía de ondas gravitatorias podría ser realidad en breve. Todo ello no hubiera sido posible sin la teoría de la relatividad general y la comprensión de dicha teoría, que no ha dejado de ampliarse mediante investigaciones realizadas de manera continua.

Volvamos al desarrollo histórico: por supuesto, Einstein no prescindió totalmente de las observaciones a la hora de realizar su trabajo, ya que intentaba ampliar la ley newtoniana de la gravitación, que había sido comprobada en el marco de la astronomía. Este contacto con leyes ya establecidas es importante para cualquier avance que se pretenda lograr en la física. Aparte de sus principios generales, Einstein no tenía prácticamente ningún indicio experimental que le permitiera saber hasta dónde podía llegar con su ampliación. Lo único que existía eran unas pequeñas desviaciones que se habían medido en las trayectorias de algunos planetas, especialmente en la de Mercurio, cuya órbita observada se desviaba del cálculo newtoniano por una pequeñísima diferencia: 43 segundos de arco (más o menos la centésima parte de un grado sexagesimal) cada siglo. Esto se debe precisamente a la influencia de Venus, el planeta más próximo a Mercurio. Otras anomalías, como las posibles irregularidades en la forma del Sol, tampoco concordaban con lo observado. Einstein fue el primero que pudo explicar la desviación de la órbita mediante sus nuevas ecuaciones del movimiento en el marco de la teoría de la relatividad general.

Afortunadamente, no tardaron en aparecer otros datos que eran incompatibles con la ley de Newton, pero que Einstein ya había predicho correctamente antes de que fueran recogidos. Se trata de unas pequeñísimas desviaciones que sufre la luz de las estrellas al pasar cerca del Sol. Fue Arthur Eddington quien las midió en 1919 durante un eclipse total del Sol, y estos datos condujeron a la primera y triunfal confirmación de la teoría de la relatividad general. (Desde entonces se han realizado mediciones exactas de este tipo utilizando ondas de radio emitidas por quásares. Los primeros en realizar estas mediciones fueron Edward Fomalont y Richard Sramek en 1976). Si hubiera habido divergencias con los cálculos, la teoría de Einstein habría caído rápidamente en el olvido, a pesar de que este científico dijo: «Si la naturaleza no concuerda con la teoría, pues peor para la naturaleza».

La teoría de la relatividad general fue comprobada por primera vez mediante un experimento terrestre por Robert Pound y Glen Rebka en 1960, y superó la prueba de manera impecable. En este experimento se midió la conversión del tiempo a distintas altitudes, es decir, en distintas posiciones del espacio-tiempo. Cuanto más nos alejemos del centro de la Tierra, la fuerza de la gravedad es más débil, lo cual, desde un punto de vista matemático, significa, como veremos más adelante, una modificación del espacio-tiempo. En lugares elevados el tiempo transcurre de una manera algo diferente (en este caso, con mayor rapidez) a como transcurre en zonas profundas. Normalmente, esto no se percibe, pero con mediciones precisas se puede detectar este comportamiento. Para ello, Pound y Rebka aprovecharon el efecto Mössbauer, por el cual algunos cristales tienen una frecuencia de emisión y absorción de la luz claramente determinada. En general, la materia, como un átomo, puede emitir determinadas frecuencias cercanas a la de la luz dentro de lo que se conoce como espectro, y luego absorberlas de nuevo, como sucede con la luminosidad de los tubos fluorescentes o con el láser. La razón de esto es la naturaleza cuántica de la materia, a la que volveré en el capítulo siguiente, que trata de la teoría cuántica. Puesto que los átomos o las moléculas con los que se realizan estas mediciones se mueven dentro de un gas, las emisiones y absorciones se producen en distintos estados de movimiento. En última instancia, se mueven a causa del calor. Estos procesos de emisión y absorción se dan, por lo tanto, a distintas velocidades y, dado que el paso del tiempo, y con él la frecuencia como número de oscilaciones por intervalo de tiempo, según la teoría de la relatividad general dependen del estado de movimiento, no se emitirá o absorberá solo luz de una determinada frecuencia, sino de un intervalo de frecuencias de una amplitud determinada.

En los cuerpos sólidos sometidos al efecto Mössbauer, la emisión y la absorción no tiene lugar en átomos individuales, sino en todo el cristal. En conjunto, este se mueve mucho menos que los átomos dentro de un gas, por lo que las frecuencias de emisión y absorción están establecidas de una manera mucho más exacta. La teoría de la relatividad general no conduce a ninguna desviación de frecuencias; sin embargo, cuando un cristal emisor y otro receptor de luz se encuentran a distintas alturas, entra en juego la teoría de la relatividad general. El tiempo transcurre de manera diferente para el cristal emisor y para el cristal absorbente, por lo que la frecuencia de la luz que llega al cristal seleccionado como absorbente no coincide con la frecuencia necesaria para que se produzca una buena absorción. Esto también se puede medir, porque no se necesitan para ello grandes alturas; basta con un edificio de unos cuantos pisos.

J. C. Hafele y Richard Keating realizaron en 1971 unas mediciones del mismo efecto de la teoría de la relatividad general que no se basaban en el efecto Mössbauer, sino en la precisión de los relojes atómicos. Para esto utilizaron comparaciones exactas del tiempo en aviones. En este caso son importantes tanto la teoría de la relatividad especial, a causa de la velocidad del avión, como la teoría de la relatividad general, a causa de las distintas situaciones en altura. Sin embargo, incluso después de estos experimentos siguió sin reconocerse del todo la importancia de la teoría de la relatividad general. El 23 de junio de 1977 se puso en órbita el satélite NTS-2, el primero que iba provisto de un reloj atómico de cesio con fines experimentales. Este reloj atómico estaba configurado de tal manera que podía compensar las correcciones relativistas basadas en la velocidad del satélite. Sin embargo, los diseñadores del satélite no veían con pleno convencimiento la necesidad de las correcciones de la teoría de la relatividad general. Por este motivo se instaló, además del reloj, un aparato con el cual, en caso de que fuera necesario, se podía cambiar la frecuencia del reloj para darle los valores adecuados. Tras veinte días en el espacio las señales indicaban una desviación de la andadura del satélite con respecto a los relojes situados sobre la Tierra, exactamente como había predicho la teoría de la relatividad general. En este caso, afortunadamente, pudo corregirse el error conectando el modulador de frecuencias.

La confirmación de la teoría de la relatividad general que resulta quizá más impresionante es la que se obtuvo mediante observaciones de púlsares dobles. En este caso se trata de un sistema formado por dos estrellas que orbitan a corta distancia una de la otra, siendo una de ellas (el púlsar) la que emite radiación a intervalos regulares. Esto puede atribuirse, por ejemplo, a una estrella de neutrones que rota muy rápido y que, como un faro, emite al espacio unas señales que también llegan hasta nosotros. Según la posición del púlsar en este sistema binario de estrellas, las señales tendrán distintas demoras, puesto que recorrerán trayectorias diferentes para llegar hasta nosotros. A partir de esto se pueden determinar con mucha precisión la trayectoria de la órbita y sus posibles variaciones. La teoría de la relatividad general predice que mientras se describe la órbita son enviadas ondas gravitatorias, con lo cual el sistema pierde energía. Esta pérdida de energía hace que las dos estrellas se acerquen más la una a la otra, y esto es algo que se ha de notar al realizar una medición precisa de la trayectoria.

La pérdida de energía será máxima cuando ambas estrellas se encuentren ya a una distancia muy pequeña. Entonces cada una de ellas se encuentra plenamente introducida en el campo gravitatorio de su compañera, de tal modo que los efectos de la teoría de la relatividad general serán más intensos. En 1974, Joseph Taylor y Russell Hulse identificaron un púlsar binario formado por dos estrellas de neutrones muy próximas entre sí que describían la órbita en tan solo la tercera parte de un día. ¡La distancia entre ambas era solo de diez mil kilómetros! Este es un sistema de comprobación idóneo para detectar ligeras variaciones de la trayectoria, tal como las predice la teoría de la relatividad general. De hecho, las comprobaciones que se han realizado hasta ahora concuerdan exactamente con las predicciones. La concesión del premio Nobel de Física del año 1993 a Hulse y Taylor puso de manifiesto la importancia de estas pruebas. (En este sistema tiene lugar, además, como en el caso de Mercurio, otro desplazamiento de la trayectoria sin variación de la distancia. Dado que aquí la desviación es de cuatro grados al año, resulta claramente superior a la de Mercurio y puede utilizarse para valorar las masas de las estrellas de neutrones). Desde entonces se han descubierto cada vez más púlsares binarios con distintas características en sus trayectorias, y esto hace posible que se realicen una gran variedad de comprobaciones.

Uno de los experimentos más recientes es el del Gravity Probe-B, un satélite que fue puesto en órbita el 20 de abril de 2004 y estuvo recogiendo datos durante dieciséis meses. La idea que subyace en estos experimentos se remonta a 1959, pero el desarrollo de la tecnología necesaria para su puesta en práctica tuvo un largo y difícil recorrido bajo la dirección de Francis Everitt. Por ejemplo, los efectos que se investigan, concretamente un «arrastre» del espacio-tiempo en las proximidades de la Tierra en rotación, predicho por la teoría de la relatividad general, exigen para su medición unas brújulas giroscópicas de alta precisión. Para evitar que interfieran ciertas desigualdades que podrían invalidar las mediciones de estos efectos sensibles, las brújulas giroscópicas deben estar construidas con las esferas más perfectas que puedan conseguirse. Es poca la competencia, incluso en la totalidad del universo: solo algunas estrellas de neutrones extremadamente densas son esferas lisas. Los primeros resultados se dieron a conocer a principios de 2007 y confirman de nuevo la teoría de la relatividad general.

3.1. Espacio-tiempo curvo

Como resultado de la teoría de la relatividad general se determina la forma del espacio-tiempo mediante la materia contenida en él. Se apela aquí precisamente a la fuerza gravitatoria, que así queda estrechamente vinculada a la estructura del espacio-tiempo, cosa que no sucede con ninguna de las otras fuerzas físicas conocidas. Esto se describe matemáticamente como un espacio-tiempo curvo en el que el grado de conversión del espacio y el tiempo depende de la posición.

El ejemplo típico de un espacio curvo es la superficie bidimensional de una esfera. Por su curvatura es una superficie cerrada en sí misma, lo cual no es necesariamente el caso de todos los espacios curvos. Pero lo que caracteriza la superficie de una esfera es el hecho de que las líneas trazadas sobre ella, para estar realmente contenidas en dicha superficie, han de verse curvas cuando se observan desde un entorno tridimensional. Cualquier línea recta del espacio que se inicie sobre esta superficie la abandonará inmediatamente. Este comportamiento puede considerarse como una consecuencia directa de la curvatura, aunque en el caso de espacios curvos abstractos no tiene por qué existir siempre un entorno tridimensional. El propio espacio-tiempo, por ejemplo, es cuatridimensional y, por lo tanto, debería tener en su entorno un espacio de dimensión mucho más elevada. Es posible describir matemáticamente todas las consecuencias de la curvatura sin hacer referencia a esos espacios del entorno, un hecho que Einstein aprovechó de forma decisiva al formular la teoría de la relatividad general. La teoría matemática correspondiente, llamada geometría diferencial, se remonta al siglo XIX, principalmente a ciertos trabajos de Bernhard Riemann.

Volviendo al ejemplo de la superficie esférica rodeada de un espacio tridimensional, se pone de manifiesto otra importante consecuencia de la curvatura. Cuando nos movemos sobre una esfera y cambiamos de lugar, tal como hacemos a menudo sobre la superficie terrestre, desde la perspectiva del entorno espacial estamos obligados a girar en el espacio. Pero esto no lo percibimos, ya que, por una parte, la Tierra es muy grande y, por otra, rara vez podemos adoptar esa perspectiva desde el espacio que nos rodea; pero esto se puede explicar con facilidad sobre un globo terráqueo: la cabeza de una persona que se encuentra en Europa señala en el espacio una dirección totalmente diferente a la que indica la cabeza de una persona que está en América, aunque ambas estén de pie. Se puede ver que esto es una consecuencia de la curvatura porque este giro no se produciría en una superficie plana como, por ejemplo, una mesa.

El espacio-tiempo se curva a causa de la materia que contiene y debería poner de manifiesto unos fenómenos similares. Esto es difícil de explicar, porque se trata de un espacio cuatridimensional en el que, además, está implicado el tiempo. Sin embargo, nuestra anterior analogía muestra la consecuencia más importante, que tiene relación directa con la fuerza de la gravedad: la convertibilidad del espacio y el tiempo va ligada a las variaciones de velocidad, del mismo modo que la convertibilidad de las tres dimensiones espaciales está relacionada con las variaciones del ángulo. Del mismo modo que una superficie curva en el espacio obliga a realizar un giro cuando se efectúa un cambio de posición, así también una variación de posición en el espacio-tiempo curvo tendría que producir un cambio en la velocidad. Las variaciones de la velocidad, llamadas también aceleraciones, son ocasionadas en la física siempre por fuerzas. Por lo tanto, la curvatura del espacio-tiempo produce una fuerza, que, según la teoría de la relatividad general, es precisamente la fuerza de la gravedad.

Gracias a este asombroso truco, Einstein consiguió ampliar con éxito la teoría de Newton y al mismo tiempo reparar su defecto. En la gravitación de Einstein no aparece de manera directa interacción alguna de objetos muy alejados. Mediante la inclusión del espacio y el tiempo —no como el escenario rígido y prefijado de Newton, sino como un objeto cambiante y sometido a interacciones en su estructura— se elimina de la física esa acción a distancia. Las masas curvan el espacio-tiempo que las rodea, tras lo cual otras masas perciben una fuerza gravitatoria a causa de la curvatura. Si se hace que la primera masa se mueva, es posible ver que este movimiento no produce una acción a distancia. A causa de esto, durante el movimiento debe variar la fuerza de la gravedad que actúa sobre otras masas. Como indica la teoría de la relatividad general, esto no surge inmediatamente: la variación de la curvatura debe propagarse primero en el espacio-tiempo, antes de poder llegar hasta masas lejanas. Por consiguiente, las interacciones físicas tienen lugar siempre de manera local, y con ello se elimina el punto débil de la teoría de Newton.

Junto a esto, la teoría de la relatividad general predice también que el propio espacio-tiempo puede verse afectado por oscilaciones que se propagan como olas sobre el mar, o, en forma de luz, como ondas en un campo electromagnético. Estas ondas gravitatorias que acabo de mencionar desempeñan un papel importante en la investigación actual sobre la gravitación. Las consecuencias del espacio-tiempo curvo, que resultan tan impactantes, se ponen de manifiesto en la cosmología, donde la teoría de la relatividad general determina la evolución del universo en el tiempo.

3.2. Límites del espacio y el tiempo

Guardaos de pedir más tiempo: el infortunio nunca lo concede.

MIRABEAU

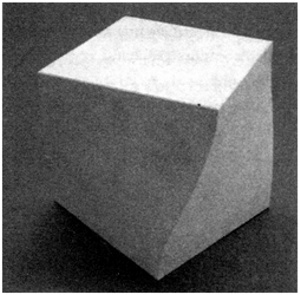

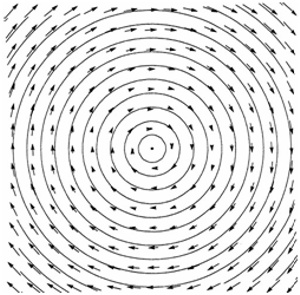

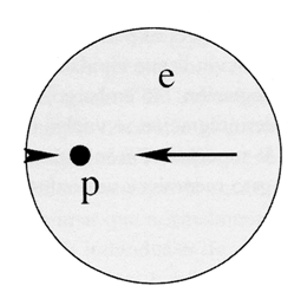

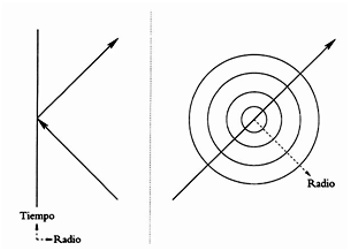

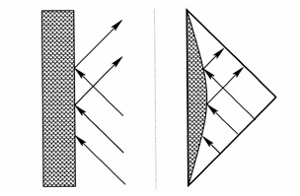

El incremento de importancia que ha experimentado el espacio-tiempo, desde ser un mero escenario hasta convertirse en un objeto físico dentro de la teoría de la relatividad (véase la figura 2), constituye una novedad revolucionaria. En principio, la complicada interacción —la materia hace que se curve el espacio, y a su vez se verá también afectada en su movimiento por la curvatura— conduce a una descripción matemática de una dificultad nunca vista, que hasta la fecha tiene ocupados no solo a los físicos, sino también a los matemáticos. Tiene asimismo consecuencias fundamentales para nuestra comprensión de los fenómenos físicos y, sobre todo, del universo. El papel que el espacio-tiempo desempeña en la física se ha comparado a menudo con una novela en la que el libro es por sí mismo un personaje. Las consecuencias de esto en la novela serían sorprendentes, aunque difíciles de imaginar. Con independencia de lo que pueda suceder en el ámbito de la imaginación, las consecuencias del papel desempeñado por el espacio-tiempo en la física pueden calcularse afortunadamente de una manera fiable con ayuda de las matemáticas. Como veremos más adelante, esto tiene en la teoría de la relatividad general unas consecuencias aún más desastrosas que las planteadas en el símil novelístico.

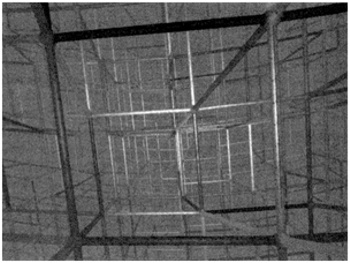

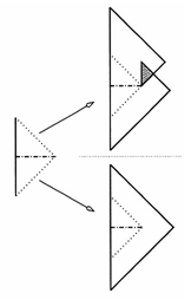

Figura 2: Los objetos se desplazan siguiendo sus trayectorias en el espacio y el tiempo, pero el espacio-tiempo es en sí mismo variable. (Órbita, 2007, yeso, lente roja, 43 × 45 × 45 cm. Diseño y fotografía de Gianni Caravaggio.

Pero antes de llegar a esto vamos a considerar una vez más la relación de la gravitación con la convertibilidad del espacio y el tiempo. Esta tiene como consecuencia que no solo la velocidad de un observador influye en la división en espacio y tiempo, sino también la gravitación ocasionada por la materia. Así, por ejemplo, el tiempo transcurre con mayor rapidez cuando el observador se encuentra en una posición más elevada, ya que allí la distancia a la masa terrestre es mayor. También aquí las variaciones son en la mayoría de los casos imperceptibles, pero, sin embargo, tienen una gran importancia técnica. Los relojes atómicos más precisos detectan una notable diferencia en la velocidad cuando se aumenta tan solo en diez metros la altura. Como ya se ha dicho, si se desea comprobar la teoría de la relatividad con ayuda de relojes atómicos situados a bordo de aviones, es necesario tener en cuenta estos efectos, además de los de las variaciones de velocidad. (El efecto de la gravitación es en este caso mayor incluso que el de la velocidad, y contrario a este: a una velocidad mayor los relojes deberían marchar más despacio, pero a causa de la altura van más rápido).

El sistema de posicionamiento global (Global Positioning System, GPS) es un ejemplo de tecnología aplicada en el que estos efectos son importantes. Es un sistema de veinticuatro satélites que llevan todos ellos relojes atómicos. Están distribuidos en torno a la Tierra de tal modo que por (casi) cada punto hay cuatro satélites situados sobre el horizonte. Cada satélite envía con regularidad unas señales que codifican su posición y el tiempo que dicho satélite mide. Mediante la comparación de las señales que llegan desde varios satélites a un punto situado en la Tierra, puede determinarse la posición con bastante exactitud, generalmente con una precisión de entre cinco y diez centímetros. (Este sistema se desarrolló en principio para fines militares y sigue siendo gestionado por el Departamento de Defensa estadounidense. Inicialmente, las señales fueron modificadas mediante un dispositivo especial para dedicarlas también a usos no militares, de tal modo que solo permitían una precisión de unos cien metros. Pero con el tiempo se desarrollaron cada vez más aplicaciones, y muy lucrativas, por lo que en mayo de 2000 se desactivó la limitación de las señales según una orden emitida durante el mandato del presidente Clinton).

Si al realizar la medición de los tiempos se ignorara la teoría de la relatividad, las determinaciones de posición resultantes serían erróneas, y por lo tanto inservibles. A los dos minutos se observarían ya algunas desviaciones en las posiciones medidas y, después de un día completo, los datos de posición diferirían en hasta diez kilómetros con respecto a los valores correctos. Por consiguiente, el papel que desempeña la teoría de la relatividad general en este sistema tiene una importancia enorme, pero es muy complicado y durante mucho tiempo no llegó a comprenderse del todo. Los primeros satélites del sistema fueron puestos en órbita en 1978, pero en los años 1979, 1985 y finalmente en 1995 —el año en que fue puesto en servicio oficialmente— se organizaron congresos únicamente para intentar comprender el papel de la teoría de la relatividad general en el funcionamiento del GPS. Sin embargo, parece ser que en 1996 se hizo un informe técnico erróneo. Ejemplos de estas dificultades son la sincronización y la comparación de los relojes de los satélites o la posible influencia del campo gravitatorio solar (!), que presenta unas diferencias muy pequeñas entre el lado de la Tierra que está más próximo al Sol y el que está más alejado. Esto último resultó insignificante dada la precisión que habían alcanzado los relojes. (Desde luego, son muy precisos: se trata de relojes atómicos de rubidio, cuyas lecturas después de diez días solo se diferencian en medio nanosegundo, es decir, media milmillonésima de segundo). Pero el cambiante campo gravitatorio de la Tierra y especialmente las divergencias con respecto a la forma esférica debidas al aplanamiento de la Tierra en rotación son extraordinariamente importantes cuando se trata de conseguir precisión. También aquí puede uno preguntarse si prevalecen los efectos de la teoría de la relatividad especial o de la general. Este es también el caso del proyecto GALILEO, planificado por ESA, cuyos satélites están previstos para una altura de 30 000 kilómetros.

Las aplicaciones del GPS son cada vez más variadas, por ejemplo en una función del teléfono móvil que es especialmente popular en los países islámicos y consiste en indicar la dirección exacta en que se encuentra La Meca. En la actualidad, las aplicaciones militares se han quedado claramente en minoría, y en la exploración terrestre predominan aplicaciones tales como la utilización de receptores de GPS ligeros en las tormentas tropicales para medir la temperatura y la presión en cualquier lugar. También pueden seguirse con precisión los desplazamientos de la corteza terrestre en el marco de la tectónica de placas, y quizá sea posible algún día aplicar esto a la predicción de seísmos. Incluso el comportamiento de edificios o puentes bajo distintas cargas puede registrarse gracias a la enorme precisión del GPS. En la agricultura se aplica en parte el GPS para la precisa dosificación localizada de abonos y pesticidas, y los arqueólogos lo utilizan para detectar y cartografiar antiguos yacimientos. El GPS tiene asimismo su función en la propia investigación de la teoría de la relatividad general, ya que sirve para la definición de un estándar universal de relojes que, por ejemplo, se usa en la determinación exacta de trayectorias del púlsar binario hallado por Hulse y Taylor.

Todo esto muestra la importancia tecnológica de la teoría de la relatividad, cuya repercusión, aun siendo pequeña en este caso, resulta, sin embargo, importante a causa de lo sensibles que son las aplicaciones. En cambio, son enormes las consecuencias de la teoría de la relatividad en la observación a escalas cosmológicas. El tiempo no es rígido, como en las teorías newtonianas, sino que sufre la influencia de la materia que hay en el universo. Según la teoría de la relatividad general, en situaciones extremas esto puede incluso desembocar en el hecho de que el propio tiempo se acabe. La influencia de la materia en el espacio-tiempo es aquí tan grande que el tiempo se detiene o el espacio acaba tropezando con un límite insalvable. La teoría de la relatividad nos dice que, por ejemplo, esto fue lo que sucedió en el big bang (si observamos el universo en una serie de situaciones dirigida temporalmente hacia atrás), o también es el caso de los agujeros negros. En estos fenómenos las fuerzas gravitatorias llegan a ser tan potentes que las distancias espaciales o temporales se hacen cada vez más pequeñas y al final desaparecen totalmente. Cuando ya no existe ningún tipo de distancia temporal entre los posibles sucesos, el tiempo se ha extinguido, y con él todos los sucesos. Esto es válido para todos los cuerpos y para el propio universo: nada puede ir más allá de este punto.

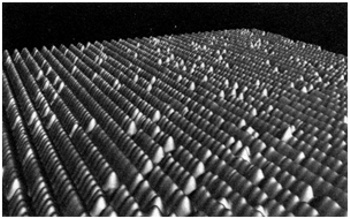

Entonces ¿qué es lo que sucede exactamente? Para comprender esto es preciso analizar las ecuaciones matemáticas de la teoría de la relatividad general, ya que estas ecuaciones describen la estructura del espacio y el tiempo. De acuerdo con la forma continua del espacio-tiempo, tal como se representa matemáticamente mediante la geometría diferencial, estas ecuaciones son ecuaciones diferenciales. Es decir, las ecuaciones de Einstein establecen cómo está configurada la forma del espacio-tiempo en las proximidades de un punto según la materia que hay allí, o más concretamente su densidad de energía y su presión. En consecuencia, las ecuaciones se corresponden con la idea del continuo que puede ser concebida con respecto al espacio-tiempo (continuo espaciotemporal), como en el caso de un tejido curvado, pero en cuatro dimensiones. A diferencia de una tela real, que está tejida con hilos y tiene entre estos espacios vacíos, en la teoría de la relatividad general el tejido del espacio-tiempo no presenta ningún tipo de estructura cuando se observa a distancias mínimas; de ahí la utilización de ecuaciones diferenciales, que reflejan los cambios que se producen en el espacio-tiempo cuando las desviaciones son mínimas. Estas desviaciones no son atómicas, sino menores que cualquier magnitud prevista: corresponden a un proceso matemático de límite que idealiza la noción del continuo.