El pensamiento matemático - Parte III

Morris Kline

Capítulo 34

La teoría de números en el siglo XIX

1. Introducción

2. La teoría de congruencias

3. Números algebraicos

4. Los ideales de Dedekind

5. La teoría de las formas

6. Teoría analítica de números

Bibliografía.

Es cierto que Fourier pensaba que el objeto principal de las matemáticas era el uso público y la explicación de los fenómenos naturales; pero un filósofo como él debía saber que el único objetivo de la ciencia es el honor del espíritu humano y que bajo esta perspectiva un problema de [la teoría de] números es tan valioso como un problema sobre el sistema del mundo.

C. G. J. Jacobi

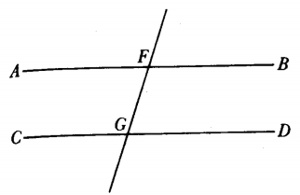

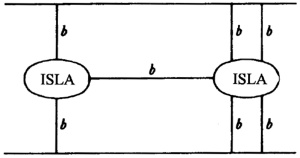

Hasta el siglo XIX, la teoría de números era una serie de resultados aislados, aunque muchas veces brillantes. Una nueva era se inició con elDisquisitiones Arithmeticae (Disquisiciones Aritméticas)[1], de Gauss, que compuso a la edad de veinte años. Esta gran obra había sido enviada a la Academia Francesa en 1800 pero la rechazaron y entonces Gauss la publicó él mismo. En este libro estableció la notación; sistematizó y extendió la teoría existente; clasificó los problemas que debían ser estudiados y los métodos conocidos para atacarlos e introdujo nuevos métodos. En el trabajo de Gauss sobre la teoría de números hay tres ideas principales: la teoría de congruencias, la introducción de los números algebraicos y la teoría de las formas como idea básica en el análisis diofántico. Este trabajo no solamente inició la teoría moderna de números, sino que determinó las direcciones de trabajo en la materia hasta el presente. Las Disquisitiones son difíciles de leer, pero Dirichlet las explicó.

Otro avance importante en el siglo XIX es la teoría analítica de números, que además de usar el álgebra se vale del análisis para tratar problemas concernientes a los enteros. Dirichlet y Riemann se erigieron como figuras en esta innovación.

2. La teoría de congruencias

A pesar de que la noción de congruencia no se originó con Gauss —ya que aparece en los trabajos de Euler, Lagrange y Legendre—, introdujo la notación en la primera sección del Disquisitiones, aplicándola a partir de ahí sistemáticamente. La idea básica es simple: el número 27 es congruente con el 3 módulo 4,

27 = 3 módulo 4,

ya que 27 — 3 es exactamente divisible por 4. (La palabra módulo con frecuencia es abreviada como mód.) En general, si a, b y m son enteros:a = b módulo m

si a — b es (exactamente) divisible por m o si a yb tienen los mismos restos (o residuos), en la división porm. Entonces se dice que b es un residuo de a módulo m y a es un residuo de b módulo m. Como Gauss muestra, todos los residuos de a módulo m, para una a y m fijas, están dados por a + km, donde k = 0, ± 1, ± 2, ...Las congruencias con respecto al mismo módulo se tratan hasta cierto punto como ecuaciones. Algunas congruencias pueden ser añadidas, sustraídas y multiplicadas. Es posible además preguntarnos acerca de la solución de congruencias donde haya incógnitas. Así, ¿qué valores de x satisfacen 2x = 25 módulo 12?

Esta ecuación no tiene soluciones ya que 2x es par y 2x - 25 es impar. De aquí que 2x — 25 no puede ser múltiplo de 12. El teorema básico sobre congruencias polinomiales, que Gauss vuelve a probar en la segunda sección, ya lo había establecido Lagrange. [2] Una congruencia del grado n,

Axn + Bxn-1 + ... + Mx + N = 0 módulo p

cuyo módulo es un número primo p que no divide a A no puede tener más de n raíces no congruentes.

En la tercera sección Gauss toma los restos de potencias. Proporciona una prueba en términos de congruencias del teorema menor de Fermat, que, enunciado en términos de potencias, se lee: si p es primo y a no es múltiplo de p entonces:

ap-1≡ 1 módulo p.

El teorema se sigue de su estudio de congruencias de grado superior, a saber,xn ≡ a módulo m

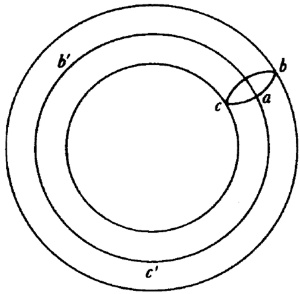

donde a y m son primos entre sí. Este estudio fue continuado por muchos autores después de Gauss.La cuarta sección de las Disquisitiones trata de los residuos cuadráticos. Si p es primo y a no es múltiplo de p y si existe una x tal que x2 ≡ a mód. p., entonces a es residuo cuadrático de p; si no es así, a no es un residuo cuadrático de p. Después de demostrar algunos teoremas subordinados sobre residuos cuadráticos, Gauss proporcionó la primera demostración rigurosa de la ley de reciprocidad cuadrática (cap. 25, sec. 4). Euler, a su vez, había dado un enunciado completo muy parecido al de Gauss en un ensayo de sus Opuscula Analytica (Opúsculos Analíticos) de 1783 (cap. 25, sec. 4). Sin embargo, en el parágrafo 151 de las Disquisitiones, Gauss afirma que nadie ha presentado el teorema en una forma tan simple como él lo ha hecho. Se refiere a otros trabajos de Euler, incluyendo otro ensayo en el Opuscula, y al trabajo de Legendre de 1785. De estos ensayos Gauss dice, correctamente, que las pruebas eran incompletas.

Se supone que Gauss descubrió una prueba de la ley en 1796 cuando tenía 19 años. Aportó otra demostración en las Disquisitiones y más tarde publicó otras cuatro. Entre sus ensayos inéditos se encontraron otras dos. Gauss afirma que buscó muchas pruebas porque deseaba hallar una que pudiera usarse para establecer el teorema de reciprocidad bicuadrática (véase más adelante). La ley de reciprocidad bicuadrática, que Gauss llamó la joya de la aritmética, es un resultado básico sobre congruencias. Después de que Gauss diera sus pruebas, otras 50 más fueron proporcionadas por matemáticos posteriores.

Gauss también trató las congruencias de polinomios. Si A y B son dos polinomios en x con, digamos, coeficientes reales, entonces se sabe que es factible encontrar polinomios únicos Q y R tales que:

A = BQ + R,

donde el grado de R es menor que el grado de B. Se dice entonces que dos polinomios A1y A2 son congruentes módulo un tercer polinomio P si tienen el mismo resto R de la división por P.Cauchy se valió de esta idea [3] para definir los números complejos usando congruencias polinomiales. Así, si f(x) es un polinomio con coeficientes reales, entonces con la división por x2+ 1:

f (x) ≡ a + bx mod x2 + 1

ya que el residuo es de grado menor que el divisor. En este caso, a y b son necesariamente reales en virtud del proceso de división. Si g(x) es otro polinomio:g (x) ≡ c + dx mod x2 + 1.

Ahora, Cauchy señala que si A1A2y B son polinomios cualesquiera y siA1 = BQ1 + R1y A2 = BQ2 + R2,

entonces,A1 + A2 ≡ R1 + R2 modB, y A1A2 ≡ R1R2 mod B.

Ahora podemos ver fácilmente quef(x ) + g(x) ≡ (a + c) + (b + d)x mod x2 + 1

y ya quex2 ≡ - 1 mod. x2 + 1,

quef (x)g(x) ≡ (ac — bd) + (ad + bc)x mod x2 + 1.

Vemos así que los números a + bx y c + dx se combinan como números complejos; esto es, tienen las propiedades formales de los números complejos, tomando x el lugar de i. Cauchy también demostró que todo polinomio g(x) no congruente con 0 módulo x2 + 1 tiene inverso, ello significa que existe un polinomio h(x) tal que b(x)g(x) es congruente con 1 módulo x2 + 1.Cauchy introdujo i por x, siendo i para él una cantidad indeterminada real. Entonces demostró que para cualquier

f (i ) = a0 + a1i + a2i2 + ...

se tienef(i) ≡ a0— a2+ a4— ... + (a1 — a3 + a5 — ...) i mod i2 + 1.

De aquí que cualquier expresión con números complejos se comporta como una de las formas c + di y todo el aparato necesario para trabajar con expresiones complejas está disponible. Para Cauchy, entonces, los polinomios en i, con su concepción de i, toman el lugar de los números complejos y es posible situar dentro de una clase todos aquellos polinomios teniendo el mismo residuo módulo i2 + 1. Estas clases son los números complejos.Es interesante que en 1847 Cauchy aún tuviera sus dudas acerca de √—1. Dice: «En la teoría de equivalencias algebraicas sustituida por la teoría de números imaginarios, la letra i cesa de representar al signo simbólico √—1, que repudiamos completamente y el cual podemos abandonar sin remordimiento ya que no se sabe lo que este supuesto signo significa ni qué sentido atribuirle. Por el contrario, representamos por la letra i una cantidad real pero indeterminada, y al sustituir el signo = por el signo = transformamos lo que ha sido llamado una ecuación imaginaria en una equivalencia algebraica relativa a la variable i y al divisor i2 + 1. Ya que el divisor permanece igual en todas las fórmulas, se evita el escribirlo.»

En la segunda década del siglo, Gauss procedió a buscar las leyes de reciprocidad aplicables a las congruencias de grado superior. Estas leyes introducen de nuevo residuos de congruencias. Así, para la congruencia

x4 ≡ q mod p

se define q como un residuo bicuadrático de p si existe un valor entero de x satisfaciendo la ecuación. Llegó a la ley de reciprocidad cuadrática (véase más abajo) y a una ley de reciprocidad cúbica. Gran parte de este trabajo apareció en los artículos de 1808 a 1817 y el propio teorema sobre residuos bicuadráticos aparece en ensayos de 1828 y 1832 [4].Para obtener elegancia y sencillez en su teoría de residuos cúbicos y bicuadráticos, Gauss hizo uso de enteros complejos, esto es, números de la forma a + bi con a y b enteros o cero. En el trabajo de Gauss sobre residuos bicuadráticos fue necesario considerar el caso donde el módulo p es primo de la forma 4n + 1 y Gauss necesitaba los factores complejos en los cuales los números primos de la forma 4n + 1 podían ser descompuestos. Para obtener éstos, Gauss se percató de que se debía ir más allá del dominio de los enteros ordinarios para introducir los enteros complejos. A pesar de que Euler y Lagrange habían introducido tales enteros en la teoría de números, fue Gauss quien les dio su importancia.

Mientras que en la teoría ordinaria de los enteros las unidades son +1 y —1, en la teoría de Gauss de enteros complejos las unidades son ±1 y ±i. A un entero complejo se le llama compuesto si es el producto de dos de tales enteros, donde ninguno es una unidad. Si tal descomposición no es posible, el entero es llamado primo. Así, 5 = (1 +2i) (1 - 2 i) es compuesto, mientras que 3 es un primo complejo.

Gauss demostró que los enteros complejos tienen esencialmente las mismas propiedades que los enteros ordinarios. Euclides había demostrado (cap. 4, sec. 7) que cada entero es descomponible unívocamente en un producto de primos. Gauss demostró que esta descomposición única, a la que se llama frecuentemente el teorema fundamental de la aritmética, se mantiene también para enteros complejos siempre y cuando no pensemos en las cuatro unidades como factores diferentes. Esto es, si a = be = (ib) (- ic), las dos descomposiciones son la misma. Gauss demostró igualmente que el proceso de Euclides para encontrar el máximo común divisor de dos enteros es aplicable a los enteros complejos.

Muchos teoremas para primos ordinarios siguen siendo válidos para los primos complejos. Así, el teorema de Fermat se extiende en la forma: si p es un primo complejo a + bi, y k cualquier entero complejo no divisible por p, entonces

k Np - 1 ≡ 1 módulo p

donde Np es la norma (a2 + b2) de p. También existe una ley de reciprocidad cuadrática para enteros complejos, establecida por Gauss en su ensayo de 1828.En términos de los enteros complejos, Gauss fue capaz de enunciar con simplicidad la ley de reciprocidad bicuadrática. Un entero no par se define como uno no divisible entre 1 + i. Un entero primariamente no par es un entero no par a + bi tal que b es par y a + b - 1 es par. Así, -7 y - 5+2i son números primariamente no pares. La ley de reciprocidad para residuos bicuadráticos establece que si α y β son dos primos primariamente no pares y A y B son sus normas, entonces

k(Np-1)/4 ≡ i módulo p

donde Np denota la norma de p. Esta ley es equivalente al enunciado: los caracteres bicuadráticos de dos números primos primarios no pares uno con respecto al otro son idénticos, esto es (α/β)4 = (β/α)4 pero si ninguno de los primos satisface la congruencia, entonces los dos caracteres bicuadráticos son opuestos, es decir (α/β) 4 = -(β/α)4.Gauss enunció este teorema de reciprocidad, pero no publicó su demostración. Esta fue proporcionada por Jacobi en sus clases en Königsberg en 1836-1837. Ferdinand Gotthold Eisenstein (1823-1852), un alumno de Gauss, publicó cinco demostraciones de la ley, de las cuales las dos primeras aparecieron en 1844. [5]

Para la reciprocidad cúbica, Gauss encontró que podía obtener una ley usando los «enteros» a + bρ, donde ρ es una raíz de x2+ x + 1 = 0 y a y b son dos enteros (racionales) ordinarios, pero Gauss no publicó este resultado, el cual se halló entre sus papeles después de su muerte. La ley de reciprocidad cúbica la establece por primera vez Jacobi [6] y es demostrada por él en sus clases en Königsberg. La primera demostración publicada se le debe a Eisenstein. [7] Al conocer esta demostración, Jacobi [8] reclamó que era precisamente la que él había dado en sus clases, pero Eisenstein negó indignadamente cualquier plagio. [9] También hay leyes de reciprocidad para congruencias de grado mayor que cuatro.

3. Números algebraicos

La teoría de enteros complejos es un paso en dirección de un dominio muy vasto, la teoría de los números algebraicos. Ni Euler ni Lagrange vieron las ricas posibilidades que abrió su trabajo con enteros complejos. Tampoco lo hizo Gauss.

La teoría surgió de los intentos por demostrar la aserción de Fermat acerca de xn + yn = zn. Los casos n = 3, 4 y 5 ya han sido discutidos (cap. 25, sec. 4). Gauss intentó demostrar la aserción para n = 7, pero falló. Tal vez porque estaba a disgusto con su fracaso, dijo en una carta de 1816 a Heinrich W. M. Olbers (1758-1840):

« Confieso, por supuesto, que el teorema de Fermat como una proposición aislada tiene poca importancia para mí, ya que multitud de tales proposiciones, que uno no puede demostrar o refutar, pueden ser fácilmente formuladas. »Este caso particular de n = 7 fue resuelto por Lamé en 1839 [10], y Dirichlet estableció la aserción para n = 14. [11]

Sin embargo, la proposición general quedaba sin probar.

Ernst Eduard Kummer (1810-1893), quien se desvió de la teología a las matemáticas, se impuso como tarea probarla. Se convirtió en alumno de Gauss y Dirichlet y más tarde trabajó como profesor en Breslau y Berlín. A pesar de que su trabajo principal versó sobre teoría de números, hizo bellos descubrimientos en geometría que tuvieron su origen en problemas ópticos; también realizó importantes contribuciones al estudio de la refracción de la luz en la atmósfera.

Kummer tomó xp + yp, donde p es primo, y lo factorizó en

(x + y)(x + ay)... (x + ap-1y),

donde a es una raíz imaginaria p-ésima de la unidad. Ello significa que α es una raíz deαp-1 + αp-2 + ... + α + 1 = 0. (1)

Esto lo llevó a extender la teoría de enteros complejos de Gauss a los números algebraicos en tanto que éstos son introducidos por ecuaciones tales como (1), esto es, números de la formaf (α) = a0 + a1α + ... + a p-2αp-2,

donde cada ai es un entero (racional) ordinario. (Ya que a satisface (1), los términos en αρ-1 pueden ser reemplazados por términos con menores potencias). Kummer llamó a los números f(α) enteros complejos.En 1843, Kummer dio definiciones apropiadas de enteros, enteros primos, divisibilidad, y así sucesivamente (proporcionaremos las definiciones habituales dentro de un momento) y entonces cometió el error de suponer que la factorización única se mantiene en la clase de los números algebraicos que él había introducido. Señaló, mientras le transmitía su manuscrito a Dirichlet en 1843, que esta suposición era necesaria para demostrar el teorema de Fermat. Dirichlet le informó de que la factorización única es válida sólo para ciertos primos p. Incidentalmente, Cauchy y Lamé cometieron el mismo error de suponer la factorización única para los números algebraicos. En 1844, Kummer [12] reconoció lo correcto de la crítica de Dirichlet.

Para restaurar la factorización única, Kummer creó la teoría de números ideales en una serie de ensayos iniciados en 1844.[13] A fin de entender su idea consideremos el dominio de a + b √-5, donde a y b son enteros. En este dominio

6 = 2 · 3 = (1 + √-5)(1-√-5)

y se demuestra fácilmente que los cuatro factores son enteros primos. Por tanto la descomposición única no tiene lugar. Introduzcamos, para este dominio, los números ideales α = √2, β1 = (1 + √-5)/√2, β2 = (1 - √-5)/√2. Vemos que 6 = β1·β 2Entonces 6 está ahora expresado unívocamente como el producto de cuatro factores, todos números ideales en cuanto se refiere al dominioa - b√-5. [14]

En términos de estos ideales y otros primos la factorización en el dominio es única (aparte de los factores formados por unidades). Con los números ideales es posible demostrar algunos de los resultados de la teoría de números ordinaria en todos los dominios que previamente carecían de factorización única.

Los números ideales de Kummer, aunque números ordinarios, no pertenecen a la clase de números algebraicos que él había introducido. Más aún, los números ideales no fueron definidos en ninguna forma general. En cuanto se refiere al teorema de Fermat, Kummer tuvo éxito al demostrar con sus números ideales que era cierto para algunos números primos. De los primeros cien enteros, sólo el 37, 59 y 67 no eran cubiertos por la demostración de Kummer. Entonces, en su ensayo de 1857, [15] extendió sus resultados a estos primos excepcionales. Tales resultados los amplió aún más Dimitri Mirimanoff (1861-1945), profesor de la universidad de Ginebra, quien perfeccionó los métodos de Kummer. [16] Mirimanoff demostró que el teorema de Fermat es cierto para todo n hasta 256 si x, y y z son primos con ese exponente n.

Mientras que Kummer trabajó con números algebraicos formados a partir de las raíces de la unidad, Richard Dedekind (1831-1916), un alumno de Gauss —quien dedicó cincuenta años de su vida a enseñar en un instituto técnico de Alemania— estudió el problema de la factorización única de una manera enteramente nueva y fresca. Dedekind publicó sus resultados en el suplemento 10 a la segunda edición de la Zaklentheorie (Teoría de Números) de Dirichlet, que Dedekind editó. Difundió estos resultados en los suplementos de las tercera y cuarta ediciones del mismo libro. [17] Allí creó la teoría moderna de los números algebraicos.

La teoría de Dedekind de los números algebraicos es una generalización de los enteros complejos de Gauss y los números algebraicos de Kummer, pero la generalización está de alguna manera divorciada de los enteros complejos de Gauss. Un número r que es una raíz de

a0xn + a1xn 1 +... + an-1x + an = 0, (2)

donde las aison enteros ordinarios (positivos o negativos), y que no es una raíz de una ecuación de grado menor que n es llamado un número algebraico de grado n. Si el coeficiente de la máxima potencia de x en (2) es 1, las soluciones son llamadas enteros algebraicos de grado n. La suma, diferencia y producto de enteros algebraicos son enteros algebraicos, y si un entero algebraico es un número racional, es un entero ordinario.Debemos señalar que con las nuevas definiciones un entero algebraico puede contener fracciones ordinarias. Así (-3 + √-115)/2 es un entero algebraico de segundo grado porque se trata de una raíz de x2 +13 + 71 = 0. Por otro lado, (1 - √-5)/2 es un número algebraico de grado 2 pero no un entero algebraico, porque es una raíz de 2x2 - 2 x + 3 = 0.

Dedekind introdujo después el concepto de cuerpo de números, que es una colección F de números reales o complejos tal que si α y β pertenecen a F, entonces también lo hacen α + β , α - β, αβ y, si β ≠ 0, α/β. Todo cuerpo de números contiene a los números racionales, ya que si α pertenece, entonces también α/α ó 1 y consecuentemente 1 + 1, 1 + 2, y de ahí en adelante. No es difícil demostrar que el conjunto de todos los números algebraicos forma un cuerpo.

Si se empieza con el cuerpo de los números racionales y θ es un número algebraico de grado n, entonces el conjunto formado por la combinación de θ consigo mismo y los números racionales bajo las cuatro operaciones es también un cuerpo de grado n. Este cuerpo puede ser descrito alternativamente como el cuerpo mínimo conteniendo los números racionales y θ. También se le denomina un cuerpo de extensión de los números racionales. Tal cuerpo no consiste en todos los números algebraicos y es un campo de números algebraicos específico. La notación R(θ) es ahora común. Aunque fuera razonable esperar que los miembros deR(θ) son los cocientes f(θ)/g(θ), donde f(x) y g(x) son polinomios cualesquiera con coeficientes racionales, se puede demostrar que si θ es de grado n, entonces cualquier miembro a de R(θ) se expresa en la forma

α = a0θn-1 + a1θn-2 +... + an-1

donde las ai son números racionales ordinarios. Más aún, existen enteros algebraicos θ1, θ2,…, θ n de este cuerpo tales que los enteros algebraicos del cuerpo son de la formaA1 θ1 + A2θ2 +… + An θn

donde las Ai son enteros ordinarios positivos y negativos.Un anillo, concepto introducido por Dedekind, es esencialmente cualquier colección de números tales que si α y β pertenecen, lo hacen asimismo α + β, α - β, α · β . El conjunto de todos los enteros algebraicos forma un anillo, al igual que lo hace el conjunto de todos los enteros algebraicos de cualquier cuerpo de números algebraicos específico.

Se dice que el entero algebraico α es divisible por el entero algebraico β si existe un entero algebraico γ tal que α = βγ. Si γ es un entero algebraico que divide cualquier otro entero de un cuerpo de números algebraicos, entonces γ es llamada una unidad de ese cuerpo. Estas unidades, que incluyen al +1 y -1, son una generalización de las unidades +1 y -1 de la teoría de números ordinaria. El entero algebraico α es primo si no es cero o una unidad y si cualquier factorización de α en βγ, donde β y γ pertenecen al mismo cuerpo de números algebraicos, implica que β o γ es una unidad en ese cuerpo.

Vemos ahora hasta qué punto se mantiene el teorema fundamental de la aritmética. En el anillo de todos los enteros algebraicos no hay primos. Consideremos el anillo de los enteros en un cuerpo R(θ) específico de números algebraicos, digamos el cuerpo a + b √-5, donde a y b son dos números racionales ordinarios. En este cuerpo la factorización única no se mantiene. Por ejemplo,

21=3 · 7 = (4 + √-5)(4 - √5) = (1 +2√ - 5)(1 - 2√5)

Cada uno de estos últimos cuatro factores es primo en el sentido de que no se expresa como un producto de la forma (c + d √-5) (e + f√-5) con c, d, e y f enteros.Por otra parte, consideremos el cuerpo a + b√6, donde a y b son números racionales ordinarios. Si se aplican las cuatro operaciones algebraicas a estos números se obtienen números de la misma clase. Si a y b son restringidos a los enteros, se obtienen los enteros algebraicos (de grado 2) de este dominio. En este dominio podemos tomar como definición equivalente de unidad que el entero algebraico M es una unidad si 1/M es también un entero algebraico. Así 1, -1, 5 -2 √6 y 5 + 2√6 son unidades. Todo entero es divisible por cualquiera de las unidades. Además, un entero algebraico del dominio es primo si es divisible únicamente por él mismo y las unidades. Ahora,

6 = 2 · 3 = √6 · √6.

Parecería como si no existiera una descomposición única en primos. Pero los factores mostrados no son primos. De hecho6 = 2 ·3 = √6 ·√6 = (2 + √6)(-2 + √6)(3 + √6)(3 - √6)

Cada uno de los últimos cuatro factores es primo en el dominio y la descomposición única se cumple en el dominio.En el anillo de los enteros de un cuerpo de números algebraicos la factorización específica de los enteros algebraicos en primos siempre es posible, pero la factorización única no siempre lo es. De hecho, para los dominios de la forma a + b √-D, donde D puede tener cualquier valor entero positivo no divisible por un cuadrado, el teorema de factorización única es válido sólo cuando D = 1, 2, 3, 7, 11, 19, 43, 67 y 163, al menos para D hasta 109. [18] Así, los propios números algebraicos no poseen la propiedad de la factorización única. 1758-1840

4. Los ideales de Dedekind

Después de generalizar la noción de número algebraico, Dedekind se dedicó a restaurar la factorización única en los cuerpos de números algebraicos mediante un esquema bastante diferente al de Kummer. En lugar de números ideales, Dedekind introdujo las clases de números algebraicos que llamó ideales, en honor a los números ideales de Kummer.

Antes de definir los ideales de Dedekind, señalemos cuál es el pensamiento subyacente. Considérense los enteros ordinarios. En lugar del entero 2, Dedekind toma la clase de los enteros 2m, donde m es cualquier entero. Esta clase consiste de todos los enteros divisibles por 2. De la misma manera, el 3 es reemplazado por la clase de todos los enteros 3n divisibles por 3. El producto 6 se convierte en la colección de todos los números 6p, donde p es cualquier entero. Entonces el producto 2 · 3 = 6 es reemplazado por la afirmación de que la clase 2m «multiplicada» por la clase 3n es igual a la clase 6p. Más aún, la clase 2m es un factor de la clase 6 p, a pesar del hecho de que la clase anterior contiene a la última. Estas clases son ejemplos en el anillo de los enteros ordinarios de lo que Dedekind llama ideales. Para seguir el trabajo de Dedekind, uno debe acostumbrarse a pensar en términos de clases de números.

Con mayor generalidad, Dedekind definió los ideales como sigue: sea A un cuerpo de números algebraicos específico. Un conjunto de enteros A de K se dice que forma un ideal si cuando α y β son dos enteros cualesquiera en el conjunto, los enteros μα y νβ, donde μ y ν son otros dos enteros cualesquiera en A, también pertenecen al conjunto. Alternativamente, un ideal A se dice que es generado por los enteros algebraicos α1, α2, ..., α n de A si A consiste en todas las sumas

λ1α1 + λ2α2 +…+ λ nαn

donde los λi son enteros cualesquiera de un cuerpoK. Este ideal es denotado mediante (α1, α2, ..., αn). El ideal cero consiste en el número 0 únicamente y por consiguiente es denotado por (0). El ideal unidad es el generado por el número 1, esto es, (1). Un ideal A es llamado principal si es generado por un entero único α, de tal forma que (α) consta de todos los enteros algebraicos divisibles por α. En el anillo de los enteros algebraicos todo ideal es un ideal principal.Un ejemplo de un ideal en el campo a + b √5 de los números algebraicos, donde a y b son números racionales ordinarios, es el ideal generado por los enteros 2 y 1 + √-5. Este ideal consiste en todos los enteros de la forma 2μ + (1 + √-5) ν, donde μ y ν son enteros arbitrarios del cuerpo. El ideal también es un ideal principal, ya que está generado sólo por el número 2 en virtud del hecho de que (1 + √-5) 2 debe pertenecer también al ideal generado por 2.

Dos ideales (α1, α2,..., αp) y (β 1, β2,..., βq) son iguales si cada miembro del primer ideal es un miembro del segundo y conversamente. Para atacar el problema de la factorización debemos primero considerar el producto de dos ideales. El producto del ideal A = (α1, α 2,..., αs) y el ideal B =(β1 , β2,..., βt) de K está definido como el ideal

AB = (α1β1, α1β2, α2β1..., αiβj,..., α sβt ).

Es casi evidente que este producto es conmutativo y asociativo. Con la definición podemos decir que A divide a B si existe un ideal C tal que B = AC. Se escribe A/B y A es llamado un factor de B. Como ya se había sugerido mediante nuestro ejemplo de los enteros ordinarios, los elementos de B están incluidos en los elementos de A y la divisibilidad ordinaria es reemplazada por la inclusión de clases.Los ideales que son los análogos de los números primos ordinarios son llamados ideales primos. Tal tipo de ideal P es definido como uno que no tiene factores que no sean él mismo y el ideal (1), de tal forma que P no está contenido en ningún otro ideal de K. Por esta razón un ideal primo es también llamado maximal. Todas estas definiciones y teoremas condujeron a los teoremas básicos para ideales de un cuerpo de números algebraicos K. Cualquier ideal es divisible únicamente por un número finito de ideales y si un ideal primo divide el producto AB de dos ideales (de la misma clase de números) divide a A o a B. Finalmente, el teorema fundamental en la teoría de ideales es que todo ideal puede ser factorizado unívocamente en ideales primos.

En nuestros primeros ejemplos de cuerpos de números algebraicos de la forma a + b √D), siendo entero D, encontramos que algunos permitían la factorización única de los enteros algebraicos de aquellos cuerpos y otros no. La respuesta a la pregunta de cuáles lo permiten y cuáles no está dada por el teorema de que la factorización de los enteros de un cuerpo K de números algebraicos en primos es única si y sólo si todos los ideales de K son principales.

A partir de estos ejemplos del trabajo de Dedekind podemos ver que su teoría de los ideales es por supuesto una generalización de los enteros ordinarios. En particular, suministra los conceptos y propiedades en el dominio de los números algebraicos que permiten establecer la factorización única.

Leopold Kronecker (1823-1891), fue el estudiante favorito de Kummer y le sucedió como profesor en la universidad de Berlín; también se dedicó al estudio de los números algebraicos y lo desarrolló siguiendo líneas similares a las de Dedekind. La tesis doctoral de Kronecker «Sobre unidades complejas», escrita en 1845, aunque no publicada sino mucho más tarde, [19] fue su primer trabajo en el tema. La tesis trata de las unidades que pueden existir en los cuerpos de números algebraicos creados por Gauss.

Kronecker creó otra teoría de cuerpos (dominios de racionalidad). [20] Su concepto de cuerpo es mucho más general que el de Dedekind, ya que consideró campos de funciones racionales en cualquier número de variables (indeterminadas). Específicamente, Kronecker introdujo (1881) la noción de una indeterminada adjunta a un cuerpo siendo únicamente la indeterminada una nueva cantidad abstracta. Esta idea de extender un cuerpo añadiendo una indeterminada la convirtió en la piedra angular de su teoría de números algebraicos. Aquí utilizó el conocimiento ya construido desde Liouville, Cantor y otros, sobre la distinción entre los números algebraicos y los trascendentes. En particular, observó que si x es trascendente sobre un cuerpo K (x es una indeterminada) entonces el campo K(x) obtenido al añadir la indeterminada xa K, esto es, el cuerpo más pequeño conteniendo K y x, es isomorfo al cuerpo A[x] de funciones racionales de una variable con coeficientes en K.[21] Subrayó que la indeterminada era únicamente un elemento de un álgebra y no una variable en el sentido del análisis.[22] Más adelante, en 1887, [23] demostró que a cada número primo ordinario p le corresponde dentro del anillo A(x) de polinomios con coeficientes racionales un polinomio primo p{x) que es irreducible en el campo racional Q. Considerando dos polinomios como iguales si son congruentes módulo un polinomio primo p(x) dado, el anillo de los polinomios en Q(x) se convierte en un cuerpo de clases de restos poseyendo las mismas propiedades algebraicas que el cuerpo de los números algebraicosK(δ) obtenido del cuerpo K al añadir una raíz δ de p(x) = 0. Aquí utilizó la idea que Cauchy ya había empleado para introducir los números imaginarios al utilizar polinomios congruentes módulo x2 + 1. En este mismo trabajo demostró que la teoría de los números algebraicos es independiente del teorema fundamental del álgebra y de la teoría del sistema completo de los números reales.

En su teoría de cuerpos (en los «Grundzüge»), cuyos elementos están formados empezando con un campo K y adjuntando indeterminadas x1, x2,..., xn, Kronecker introdujo la noción de un sistema modular que jugó el papel de los ideales en la teoría de Dedekind. Para Kronecker, un sistema modular es el conjunto M de aquellos polinomios en n variables x1, x2,..., xn, tales que si P1 y P2 pertenecen al conjunto, también lo hace P1 + P2, y si P pertenece, también lo hace QP, donde Q es cualquier polinomio en x1, x2,..., xn.

Una base del sistema modular M es cualquier conjunto de polinomios B1, B2... de M tal que cada polinomio de M es expresable en la forma

R1B1 + R2B2 +...,

donde R1, R2... son constantes o polinomios (no perteneciendo necesariamente a M). La teoría de la divisibilidad en los cuerpos generales de Kronecker fue definida en términos de sistemas modulares, un poco como lo había hecho Dedekind con los ideales.El trabajo sobre la teoría algebraica de números llegó a su clímax en el siglo XIX con el famoso artículo de Hilbert sobre números algebraicos. [24] Este trabajo es esencialmente una descripción de lo que se había hecho durante el siglo. Sin embargo, Hilbert retrabajó toda esta teoría anterior y proporcionó nuevos, elegantes y poderosos métodos para asegurar sus resultados. Empezó a crear nuevas ideas en la teoría algebraica de números alrededor de 1892 aproximadamente, y una de las nuevas creaciones sobre los cuerpos de números galoisianos fue incorporada también en el trabajo. Posteriormente, Hilbert y muchos otros autores extendieron ampliamente la teoría de números algebraicos. Sin embargo, estos últimos desarrollos, relativos a cuerpos galoisianos, cuerpos de números abelianos relativos y cuerpos de clases, cada uno de ellos estimulando una inmensa cantidad de trabajo en el siglo XX, son de interés principalmente para los especialistas.

La teoría algebraica de números, que originalmente era un esquema para investigar las soluciones de los problemas de la vieja teoría de números, se ha convertido en un fin en sí misma. Ha llegado a ocupar una posición entre la teoría de números y el álgebra abstracta, y ahora la teoría de números y el álgebra superior moderna se mezclan en la teoría algebraica de números. Por supuesto, la teoría algebraica de números también ha producido nuevos teoremas en la teoría ordinaria de números.

5. La teoría de las formas

Otra clase de problemas en la teoría de números es la representación de los enteros por medio de formas. La expresión

ax2 + 2bxy + cy2 (3)

donde a, b y c son enteros, es una forma binaria ya que hay dos variables implicadas y es una forma cuadrática porque es de segundo grado. Se dice que un número M está representado por la forma si para valores enteros concretos de a, b, c, x e y, la expresión anterior es igual a M. Uno de los problemas es encontrar el conjunto de números M que son representables por una forma dada o clase de formas. El problema inverso, dado M y dados a, b y c, o alguna clase de a, b y c, encontrar los valores de x e y que representa M, es igualmente importante. El último problema pertenece al análisis diofántico y el anterior puede ser igualmente considerado parte de la misma materia.Euler había obtenido algunos resultados particulares sobre estos problemas. Sin embargo, Lagrange hizo el descubrimiento clave de que si un número es representable por una forma, es también representable por muchas otras formas, que llamó equivalentes. Las últimas podían ser obtenidas a partir de la forma original mediante un cambio de variables

x = αx' + βy', y = γx' + δy' (4)

donde las α, β, γ y δ son enteros y αγ y β,δ= 1 [25]. En particular, Lagrange mostró que para un discriminante dado (Gauss usó la palabra determinante) b2 - ac existe un número finito de formas tal que cada forma con ese discriminante es equivalente a una de ese número finito. De esta manera, todas las formas con un discriminante dado pueden ser divididas en clases, consistiendo cada clase en formas equivalentes a un miembro de esa clase. Este resultado y otros obtenidos inductivamente por Legendre atrajeron la atención de Gauss. En un paso audaz, Gauss extrajo del trabajo de Lagrange la noción de equivalencia de formas y se concentró en ella. La quinta sección de sus Disqmsitiones, con mucho la sección más larga, está dedicada a este tema.Gauss sistematizó y extendió la teoría de las formas. Primero definió la equivalencia de formas. Sea

F = ax2 + 2bxy + cy2

transformada por medio de (4) en la forma

F = a'x2' + 2b'x'y' + c'y2.

Entoncesb '2 - a'c' = ( b2 - ac)(αδ - βγ)2.

Si ahora (αδ - βγ)2 = 1, los discriminantes de las dos formas son iguales. Entonces el inverso de la transformación (4) también contendrá coeficientes enteros (por la regla de Cramer) y transformará F enF'. Se dice que F y F’ son equivalentes. Si (αδ - βγ) 2 = 1, se dice que F y F' son propiamente equivalentes, y si (αδ - βγ)2 = -1, entonces se dice que F y F' son impropiamente equivalentes.Gauss demostró un buen número de teoremas sobre la equivalencia de formas. Por ejemplo, si F es equivalente a F y F' a P', entonces F es equivalente a F''. Si F es equivalente a F', cualquier número M representable por F es representable por F' y de tantas maneras por una como por la otra. Más adelante demuestra, si F y F' son equivalentes, cómo encontrar todas las transformaciones de F en F'. También encuentra todas las representaciones de un número dado M por la forma F, siempre que los valores de x y y sean primos entre sí.

Por definición, dos formas equivalentes tienen el mismo valor para su discriminante D = b2 - ac. Sin embargo, dos formas con el mismo discriminante no son necesariamente equivalentes. Gauss demuestra que todas las formas con un D dado pueden ser divididas en clases; los miembros de cualquier clase son propiamente equivalentes entre sí. Aunque el número de formas con un D dado es infinito, el número de clases para una D dada es finito. En cada clase puede ser tomada una forma como representativa y Gauss proporciona criterios para la elección de la representación más simple. La forma más simple de todas aquellas con determinante D tiene a = 1, b = 0 y c = - D. A esto llama Gauss la forma principal y la clase a la que pertenece es llamada clase principal.

Gauss, entonces, ataca la composición (producto) de formas. Si la forma

F = AX2 + 2BXY + CY2

se transforma en el producto de dos formasf = ax2 4- 2bxy + cy2 y f ' = a'x'2 + 2b'x'y' + c'y'2

por la sustituciónX = p1xx' + p2xy' + p3x'y + p4yy'

Y = q1xx' + q2xy' + q3x'y + q4yy'

entonces se dice que F es transformable en ff'. Si además los seis númerosp1q2 - q1p2, p1q3 - q1p3, p1q4 - q1p4 , p2q3 - q2p3, p2q4 - q2p4, p3q4 - q3p4

no tienen un divisor común, entonces se dice que F es compuesta de las formas f y f '.Más adelante, Gauss demostró un teorema esencial: si f y g pertenecen a la misma clase y f ' y g' pertenecen a la misma clase, entonces la forma compuesta de f y f ' pertenecerá a la misma clase que la forma compuesta de g y g'. Entonces se puede hablar de una clase de formas compuesta de dos (o más) clases dadas. En esta composición de clases, la clase principal actúa como una clase unidad; esto es, si la clase K es compuesta con la clase principal, la clase resultante será K.

Gauss pasa ahora al tratamiento de las formas cuadráticas ternarias

Ax2 + 2 Bxy + Cy2 + 2 Dxz + 2 Eyz + Fz2,

donde los coeficientes son enteros y realiza un estudio muy parecido al que había llevado a cabo para formas binarias. La meta, como en el caso de las formas binarias, es la representación de los enteros. Gauss no desarrolló la teoría de las formas ternarias.El objetivo del trabajo entero de la teoría de formas fue, como se mencionó con anterioridad, obtener teoremas en teoría de números. En el curso de su tratamiento de las formas, Gauss muestra cómo la teoría puede ser usada para demostrar un gran número de teoremas sobre los enteros incluyendo muchos que habían sido previamente demostrados por autores tales como Euler y Lagrange. Así, Gauss demuestra que cualquier número primo de la forma 3 n + 1 puede ser representado como una suma de cuadrados de una manera única. Cualquier número primo de la forma 8n + 1 o 8n + 3 puede ser representado en la forma x2 + 2y2 (para enteros positivos x e y) en una y sólo una manera. Muestra cómo encontrar todas las representaciones de un número dadoM mediante la forma dada ax2+ 2 bxy + cy2, siempre que el discriminante D sea un número positivo que no es un cuadrado. Además, si F es una forma primitiva (los valores de a, b y c son primos entre sí) con el discriminante D y si p es un número primo que divide a D, entonces los números no divisibles por p que pueden ser representados por F coinciden en que todos ellos o son residuos cuadráticos de p o no residuos de p.

Entre los resultados que Gauss dedujo de su trabajo sobre formas cuadráticas ternarias está la primera prueba del teorema de que cada número puede ser representado como suma de tres números triangulares. Estos, recordamos, son los números

1, 3, 6, 10, 15,…, (n2+n)/2,…

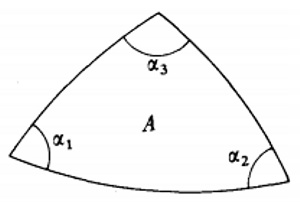

También volvió a demostrar el teorema ya probado por Lagrange de que cualquier entero positivo puede ser expresado como la suma de cuatro cuadrados. A propósito del primer resultado, es importante notar que Cauchy leyó un ensayo ante la Academia de París en 1815 donde establecía el resultado general (afirmado primero por Fermat) de que cada entero es la suma de k, o menos, números k-gonales. [26] (El número k-gonal general es n + (n2 — n) (k - 2)/2).La teoría algebraica de las formas cuadráticas binarias y ternarias —como la presentó Gauss— tiene una analogía geométrica interesante que inició el propio Gauss. En una reseña, que apareció en elGöttingische Gelehrte Anzaigen de 1830, [27] de un libro sobre formas cuadráticas ternarias, cuyo autor fuera Ludwig August Seeber (1793-1855), Gauss bosquejó la representación geométrica de las formas y de las clases de formas. [28] Este trabajo es el inicio de una rama llamada la teoría geométrica de números, que ganó primero importancia cuando Hermann Minkowski (1864-1909), quien trabajó como profesor en varias universidades, publicó su Geometrie der Zahlen (Geometría de los Números, 1896).

El campo de las formas adquirió importancia en la teoría de números del siglo XIX. Trabajo posterior sobre formas cuadráticas binarias y ternarias y sobre formas con más variables y de grado superior, [29] fue realizado por multitud de autores.

6. Teoría analítica de números

Uno de los principales avances en la teoría de números es la presentación de métodos analíticos, y de resultados analíticos, para expresar y demostrar hechos acerca de los enteros. De hecho, Euler había usado el análisis en la teoría de números (véase más adelante) y Jacobi utilizó funciones elípticas para obtener resultados en la teoría de congruencias y en la teoría de formas. [30] Sin embargo, los usos de Euler del análisis en la teoría de números fueron menores y los resultados de Jacobi, casi productos accidentales de su trabajo en análisis.

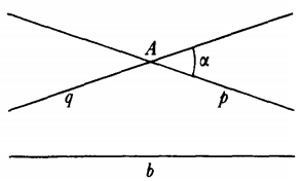

El primer uso deliberado y profundo del análisis para atacar lo que parecía ser un claro problema de álgebra fue realizado por Peter Gustav Lejeune-Dirichlet (1805-1859), alumno de Gauss y Jacobi, profesor en Breslau y Berlín, y más adelante sucesor de Gauss en Göttingen. El gran libro de Dirichlet, Vorlesungen über Zahlentheorie (Lecturas sobre la teoría de números), [31] explicó las Disqmsitiones de Gauss y dio sus propias contribuciones.

El problema que llevó a Dirichlet a emplear el análisis fue demostrar que cada sucesión aritmética

a , a + b, a + 2b, a + 3b, ..., a + nb, ...,

donde a y b son primos entre sí, contiene un número infinito de primos. Euler [32] y Legendre [33] hicieron esta conjetura y en 1808 Legendre [34] proporcionó una demostración que era errónea. En 1837, Dirichlet [35] dio una demostración correcta. Este resultado generaliza el teorema de Euclides sobre la infinitud de primos en la sucesión 1, 2, 3,... La demostración analítica de Dirichlet era larga y complicada. Específicamente, usaba lo que ahora son llamadas las series de Dirichlet,

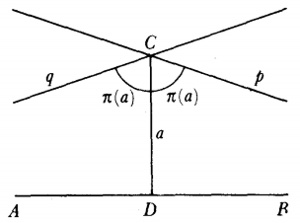

El problema principal que implicaba la introducción del análisis concernía a la función que representa el número de primos que no exceden a x. Así π(8) es 4 ya que 2, 3, 5 y 7 son primos, y π(11) es 5. Cuando x se incrementa, los primos adicionales se hacen escasos y el problema era: ¿cuál es la expresión analítica para π(x)? Legendre, quien había demostrado que ninguna expresión racional puede servir, en algún momento perdió la esperanza de que pudiera ser encontrada cualquier expresión. Entonces Euler, Legendre, Gauss y otros supusieron que

También sabía que

La función zeta para z real aparece en el trabajo de Euler [39], donde introdujo

![]()

En 1896, Hadamard, [43] aplicando la teoría de funciones enteras (de una variable compleja), que investigó con el propósito de demostrar el teorema de los números primos y probando el hecho crucial que ζ(z) ≠ 0 para x = 1, estuvo finalmente en condiciones de demostrar el teorema de los números primos. Charles-Jean de la Vallée Poussin (1866-1962) obtuvo el resultado para la función zeta y demostró el teorema de los números primos en el mismo momento. [44] Este teorema es central en la teoría analítica de números.

Bibliografía

- · Bachmann, P.: «Uber Gauss’ zahlentheoretische Arbeiten». Nacbncbten Kóning. Ges. der Wiss. zh Gótt., 1911, 455-508; también en Gauss: Werke, 10, 1-69.

- Bell, Eric T.: The development of mathematics, 2ª ed., McGraw-Hill, 1945, caps. 9-10.

- Carmichael, Robert D.: «Some recent researches in the theory of numbers». Amer. Math. Monthly, 39, 1932, 139-160.

- Dedekind, Richard: Über die Theorie derganzen algebraischen Zahlen (reimpreso del undécimo suplemento del Zahlentheorie de Dirichlet), F. Vieweg und Sohn, 1964: -Gesammelte mathematische Werke, 3 vols., F. Vieweg und Sohn, 1930-1932, Chelsea (reimpresión), 1968: -«Sur la théorie des nombres entiers algébriques», Bull. des Sci. Math., (1), 11, 1876, 278-288; (2), 1, 1877, 17-41, 69-92, 144-164, 207-248 = Ges. math. Werke, 3, 263-296.

- Dickson, Leonard E.: History of the theory of numbers, 3 vols., Chelsea (reimpresión), 1951. Studies in the theory of numbers (1930), Chelsea (reimpresión), 1962: - y cols.: Algebraic numbers, Report of Committee on algebraic numbers, National Research Council, 1923 y 1928; Chelsea (reimpresión), 1967.

- Dirichlet, P. G. L.: Werke (1889-1897); Chelsea (reimpresión), 1969, 2 vols.

- Dirichlet, P. G. L., y Dedekind, R.: Vorlesungen über Zahlentheorie, 4.a ed., 1894 (contiene el suplemento de Dedekind); Chelsea (reimpresión), 1968.

- Gauss, C. F.: Disquisitiones Arithmeticae, traducción al inglés A. A. Clarke, Yale University Press, 1965.

- Hasse, H.: «Bericht über neuere Untersuchungen und Probleme aus der Theorie der algebraischen Zahlkórper», Jabres, der Deut. Math.-Verein, 35, 1926, 1-55 y 36, 1927, 233-311.

- Hilbert, David: «Die Theorie der algebraischen Zahlkórper», ]abres, der Deut. Math.-Verein, 4, 1897, 175-546 = Gesammelte Abhandlungen, 1, 63-363.

- Klein, Félix: Vorlesungen über die Entwicklung der Mathematik im 19. Jahrhundert, Chelsea (reimpresión), 1950, vol. 1.

- Kronecker, Leopold: Werke, 5 vols. (1895-1931), Chelsea (reimpresión), 1968. Véase especialmente vol. 2, pp. 1-10 sobre la ley de reciprocidad cuadrática.

- Grundzüge einer arithmetischen Theorie der algebraischen Gróssen, G. Reimer, 1882 = Jour. fur Math., 92, 1881/1882, 1-122 = Werke, 2, 237-388.

- Landau, Edmund: Handbuch der Lehre von der Verteilung der Primzahlen, B. G. Teubner, 1909, vol. 1, págs. 1-55.

- Mordell, L. J.: «An introductory account of the arithmetical theory of algebraic numbers and its recent development». Amer. Math. Soc. Bull., 29, 1923, 445-463.

- Reichardt, Hans (ed.): C. F. Gauss, Leben und Werk, Haude und Spenersche Verlagsbuchhandlund, 1960, pp. 38-91; también B. G. Teubner, 1957.

- Scott, J. F.: A history of mathematics, Taylor and Francis, 1958, cap. 15.

- Smith, David, E.: A source book in mathematics, Dover (reimpresión), 1959, vol. 1, 107-148.

- Smith, H. J. S.: Collected mathematicalpapers, 2 vols. (1890-1894), Chelsea (reimpresión), 1965. El vol. 1 contiene el Report on the theory of numbers de Smith, que también ha sido publicado por separado en Chelsea, 1965.

- Vandiver, H. S.: «Fermat’s last theorem», Amer. Math. Monthly, 53, 1946, 555-578.

Capítulo 35

El resurgimiento de la geometría proyectiva

Las doctrinas de la geometría pura, frecuentemente, y en muchas cuestiones, proporcionan una manera simple y natural de penetrar en los orígenes de las verdades, para aclarar la misteriosa cadena que las une, y para hacerlas conocer individual, luminosa y completamente.

Michael Chasles

1. El renovado interés por la geometría1. El renovado interés por la geometría

2. Geometría euclídea sintética

3. El resurgimiento de la geometría proyectiva sintética

4. Geometría proyectiva algebraica

5. Curvas planas de orden superior y superficies

Bibliografía.

Por más de 100 años después de la introducción de la geometría analítica por Descartes y Fermat, los métodos algebraicos y analíticos dominaron la geometría, hasta la casi exclusión de los métodos sintéticos. Durante este período algunos autores, por ejemplo los matemáticos ingleses que persistían en intentar fundar el cálculo rigurosamente sobre la geometría, consiguieron nuevos resultados sintéticamente. Los métodos geométricos, elegantes e intuitivamente claros, siempre cautivaron algunas mentes. Especialmente, Maclaurin prefirió la geometría sintética al análisis. La geometría pura, entonces, retuvo algo de vida aún si no se encontraba en el corazón de los desarrollos más vitales de los siglos XVII y XVIII. Al principio del siglo XIX varios grandes matemáticos decidieron que la geometría sintética había sido rechazada injusta y totalmente e hicieron un esfuerzo positivo por revivir y extender su enfoque.

Uno de los nuevos campeones de los métodos sintéticos, Jean-Victor Poncelet, concedió las limitaciones de la vieja geometría pura. Dice: «Mientras que la geometría analítica ofrece por su método general característico y uniforme medios de proceder a la solución de las cuestiones que se nos presentan... mientras que llega a resultados cuya generalidad no tiene frontera, la otra [geometría sintética] procede por casualidad; su camino depende completamente de la sagacidad de aquellos que la emplean y sus resultados casi siempre están limitados a la figura particular que considera». Pero Poncelet no creía que los métodos sintéticos estuvieran necesariamente tan limitados, y propuso crear nuevos métodos que rivalizarían con el poder de la geometría analítica.

Michel Chasles (1793-1880) fue otro gran defensor de los métodos geométricos. En su Aperçu historique sur Vorigine et le développement des méthodes en géométrie (Resumen histórico sobre los orígenes y desarrollo de los métodos en geometría, 1837), un estudio histórico en el cual Chasles admitió que ignoraba a los escritores alemanes porque desconocía su idioma, afirma que los matemáticos de su tiempo, y anteriores, habían declarado la geometría un lenguaje muerto que en el futuro no tendría uso ni influencia. No solamente Chasles niega esto, sino que cita a Lagrange, que era enteramente un analista, afirmando en su sesenta aniversario [45], cuando había encontrado un problema muy difícil de mecánica celeste: «A pesar de que el análisis pueda tener ventajas sobre los viejos métodos geométricos, los cuales comúnmente, pero indebidamente, llamamos sintéticos, hay sin embargo problemas en el que el último aparece más ventajosamente, en parte debido a su claridad intrínseca y en parte debido a la elegancia y facilidad de sus soluciones. Hay aún algunos problemas para los cuales el análisis algebraico en alguna medida no es suficiente y que, según parece, sólo los métodos sintéticos pueden resolver.» Lagrange cita como ejemplo el muy difícil problema de la atracción que un elipsoide de revolución ejerce sobre un punto (unidad de masa) sobre su superficie o en el interior. Este problema había sido resuelto de modo puramente sintético por Maclaurin.

Chasles también proporciona un extracto de una carta que recibió de Lambert Adolphe Quetelet (1796-1874), el astrónomo y estadístico belga. Quetelet dice: «No es propio que la mayoría de nuestros matemáticos jóvenes valoren la geometría pura tan ligeramente.» Los jóvenes se quejaban de la carencia de generalidad del método, continúa Quetelet, pero es éste un fallo de la geometría o de aquellos que cultivan la geometría, se pregunta. Para compensar esta carencia de generalidad, Chasles proporciona dos reglas a los futuros geómetras. Deberán generalizar teoremas particulares para obtener los resultados más generales, que deberán ser al mismo tiempo simples y naturales. Segundo, no habrán de estar satisfechos con la demostración del resultado si no es parte de un método general o doctrina de la que depende naturalmente. Saber cuándo uno tiene realmente la base verdadera para un teorema, dice; siempre existe una verdad principal que uno reconocerá porque otros teoremas resultarán de la simple transformación, o como consecuencia inmediata. Las grandes verdades, que son el fundamento del conocimiento, siempre tienen las características de la simplicidad y la intuición.

Otros matemáticos atacaron los métodos analíticos con lenguaje más fuerte. Carnot deseaba «liberar a la geometría de los jeroglíficos del análisis». Más tarde, en el mismo siglo, Eduard Study (1862-1922) se refirió al proceso «mecánico» de la geometría con coordenadas como el «estruendo del molino coordenado».

Las objeciones a los métodos analíticos en geometría estuvieron basadas en algo más que una preferencia o gusto personal. Había, ante todo, la pregunta genuina de si la geometría analítica era realmente geometría, ya que el álgebra era la esencia del método y los resultados, y la significación geométrica de ambas estaba escondida. Más aún, señaló Chasles, el análisis, a través de sus procesos formales, niega todos los pequeños pasos que continuamente da la geometría. Los rápidos y tal vez penetrantes pasos del análisis no revelan el sentido de lo que se consigue. La conexión entre el punto inicial y el resultado final no es claro. Chasles pregunta: «¿Es entonces suficiente en un estudio filosófico y básico de una ciencia saber que algo es verdadero si uno no sabe por qué es así y qué lugar debería ocupar en la serie de verdades a la que pertenece? » El método geométrico, por otro lado, permite pruebas y conclusiones simples y evidentemente intuitivas.

Había otro argumento, el cual, mencionado primero por Descartes, aún gustaba en el siglo XIX. La geometría era considerada como la verdad sobre el espacio y el mundo exterior. El álgebra y el análisis no eran verdades significantes en sí mismas, ni siquiera acerca de números y funciones. Estos consistían únicamente en métodos para llegar a las verdades, y en eso se presentaban como, artificiales. Esta visión del álgebra y del análisis estaba desapareciendo gradualmente. Sin embargo, la crítica era aún rigurosa al principio del siglo XIX, ya que los métodos del análisis eran incompletos y todavía sin base lógica. Los geómetras cuestionaban correctamente la validez de las pruebas analíticas y las aceptaban únicamente como sugiriendo resultados. El análisis sólo podía responder mordazmente que las demostraciones geométricas eran torpes y sin elegancia.

El resultado de la controversia es que los geómetras puros reafirmaban su papel en las matemáticas. Como si se tuvieran que vengar de Descartes porque su creación de la geometría analítica los había obligado a abandonar la geometría pura, los geómetras de principios del siglo XIX se propusieron como objetivo vencer a Descartes en su juego de la geometría. La rivalidad entre geómetras y analistas se hizo tan amarga que Steiner —un geómetra puro— amenazó con no publicar en el Journal für Mathematik de Crelle si éste continuaba publicando los artículos analíticos de Plücker.

El estímulo para revivir la geometría sintética vino principalmente de un solo autor, Gaspard Monge. Ya hemos discutido sus valiosas contribuciones a la geometría analítica y diferencial y sus inspiradoras clases en la Escuela Politécnica durante los años de 1795 a 1809. El mismo Monge no intentaba más que hacer regresar la geometría al rebaño de las matemáticas como un enfoque sugestivo y una interpretación de los resultados analíticos, y buscó únicamente el subrayar ambos modos de pensamiento. Sin embargo, su propio trabajo en geometría y su entusiasmo inspiró a sus alumnos Charles Dupin, François Joseph Servois, Charles Julien Brianchon, Jean Baptiste Biot (1744-1862), Lazare Nicholas Marguerite Carnot y Jean Victor Poncelet, la urgencia por revitalizar la geometría pura.

La contribución de Monge a la geometría pura fue su Traité de géométrie descriptive (Tratado de geometría descriptiva, 1799). Esta materia muestra cómo proyectar ortogonalmente un objeto tridimensional en dos planos (uno horizontal y otro vertical) de tal forma que a partir de esta representación sea factible deducir propiedades matemáticas del objeto. El esquema es útil en arquitectura, diseño de fortificaciones, perspectiva, carpintería y talla de piedras, y fue el primero en tratar la proyección de una figura tridimensional en dos bidimensionales. Las ideas y métodos de la geometría descriptiva no demostraron ser una fuente de desarrollos posteriores en geometría o, en ese aspecto, en cualquier otra parte de las matemáticas.

2. Geometría euclídea sintética

A pesar de que los geómetras que reaccionaron a la inspiración de Monge se dedicaron a la geometría proyectiva, debemos detenernos para señalar algunos nuevos resultados en la geometría euclídea sintética. Estos resultados, tal vez pequeños en significación, muestran sin embargo nuevos temas y la casi infinita riqueza de esta vieja materia. De hecho, cientos de nuevos teoremas fueron obtenidos, de los cuales sólo podemos dar unos cuantos ejemplos.

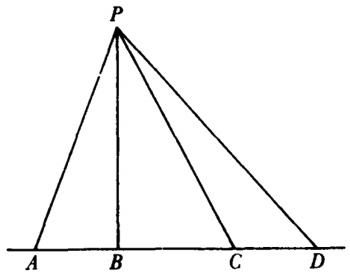

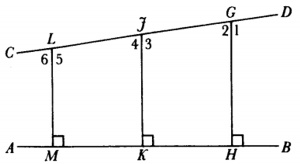

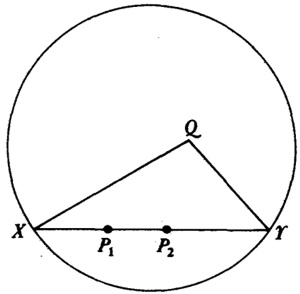

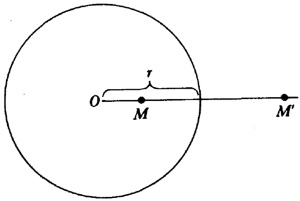

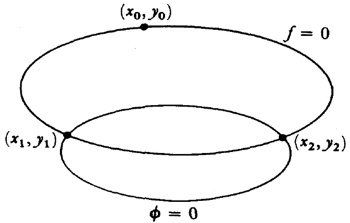

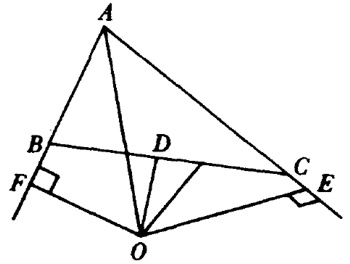

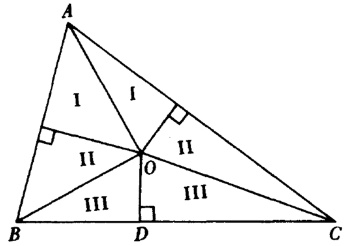

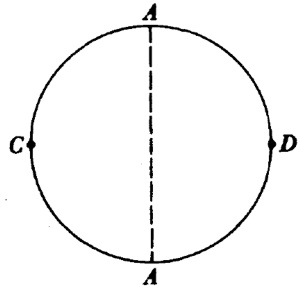

Asociados con cada triángulo ABC están nueve puntos particulares, los puntos medios de los lados, los pies de las tres alturas y los puntos medios de los segmentos que unen los vértices con los puntos de intersección de las alturas. Los nueve puntos yacen sobre un círculo, llamado el círculo de los nueve puntos. Gergonne y Poncelet publicaron este teorema por primera vez [46]. Se le acredita frecuentemente a Karl Wilhelm Feuerbach (1800-1834), un maestro de escuela, quien publicó su demostración en Eigenschaften einiger merkwürdigen Punkte des geradlinigen Dreiecks (Propiedades de algunos puntos distinguidos del triángulo rectilíneo, 1822). En este libro, Feuerbach añadió otro hecho al círculo de los nueve puntos, un excírculo es uno que es tangente a uno de los lados y a las extensiones de los otros dos lados. (El centro de un excírculo yace sobre los bisectores de los dos ángulos exteriores y el ángulo interior más alejado.) El teorema de Feuerbach establece que el círculo de nueve puntos es tangente al círculo inscrito y a los tres excírculos.

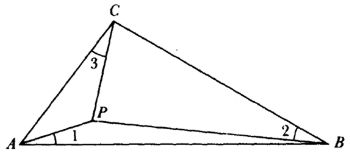

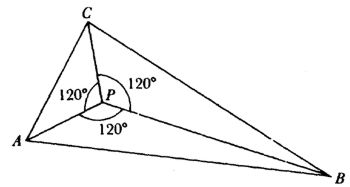

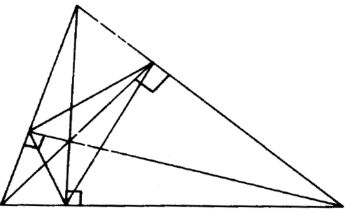

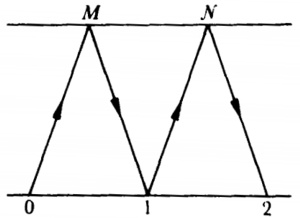

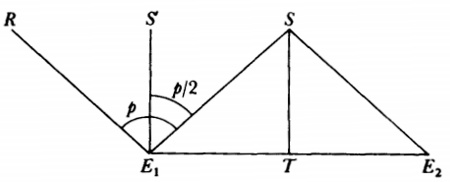

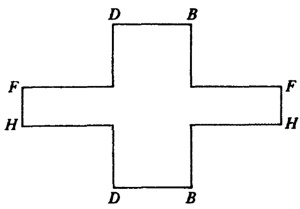

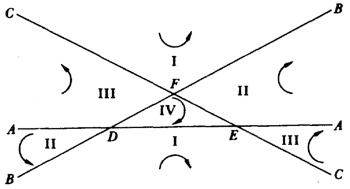

En un pequeño libro publicado en 1816, Uber einige Eigenschaften des ebenen geradlinigen Dreiecks (Sobre algunas propiedades de triángulos rectilíneos planos), Crelle mostró cómo determinar un punto P dentro de un triángulo tal que las líneas uniendo P a los vértices del triángulo y los lados del triángulo formen ángulos iguales. Esto es, ∠ 1 = ∠ 2 = ∠ 3 en la figura 35.1.

Figura 35.1

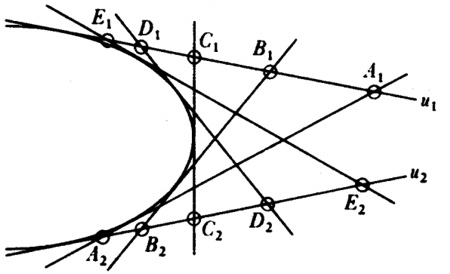

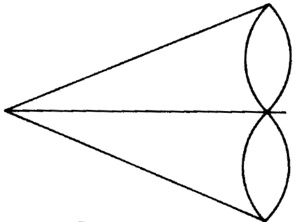

Las secciones cónicas, como sabemos, fueron tratadas definitivamente por Apolonio como secciones de un cono y más tarde introducidas como lugares geométricos planos en el siglo XVII. En 1822, Germinal Dandelin (1794-1847) demostró [47] un teorema muy interesante acerca de las secciones cónicas en relación con un cono. Su teorema establece que si dos esferas están inscritas en un cono circular de tal manera que son tangentes a un plano dado cortando al cono en una sección cónica, los puntos de contacto de las esferas con el plano son los focos de la sección cónica, y las intersecciones del plano con los planos de los círculos a lo largo de los que las esferas tocan el cono son las directrices de la cónica.

Otro tema interesante estudiado en el siglo XIX fue la solución de problemas de máximos y mínimos por métodos puramente geométricos, esto es, sin apoyarse en el cálculo de variaciones. De los varios teoremas que Jacob Steiner demostró usando únicamente métodos sintéticos, el resultado más famoso es el teorema isoperimétrico: de todas las figuras planas con un perímetro dado el círculo encierra el área máxima. Steiner proporcionó varias demostraciones [48]. Desafortunadamente, Steiner supuso que existe una curva que tiene área máxima. Dirichlet intentó varias veces persuadirlo de que sus demostraciones eran incompletas en ese punto pero Steiner insistía que esto era autoevidente. Una vez, sin embargo, escribió (en el primero de los ensayos de 1842) [49]: « y la demostración se hace rápidamente si se supone que existe una figura máxima ».

La demostración de la existencia de una curva maximizante frustró a los matemáticos por muchos años hasta que Weierstrass, en sus clases dadas durante los 1870 en Berlín, recurrió al cálculo de variaciones [50]. Más tarde, Constantin Caratheodory (1873-1950) y Study [51], en un artículo conjunto, rigorizaron las demostraciones de Steiner sin emplear el cálculo. Sus demostraciones (hubo dos) fueron directas en lugar de indirectas, como en el método de Steiner. Hermann Amandus Schwarz, quien realizó una gran labor en ecuaciones en derivadas parciales y análisis y trabajó como profesor en diversas universidades, incluyendo Göttingen y Berlín, proporcionó una demostración rigurosa para el problema isoperimétrico en tres dimensiones. [52]

Steiner también demostró (en el primero de los ensayos de 1842) que de todos los triángulos con un perímetro dado, el equilátero tiene el área máxima.

Figura 35.2

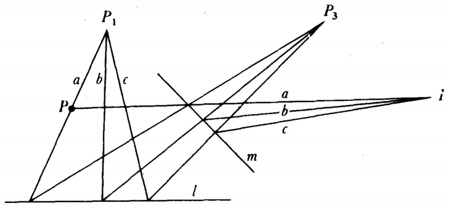

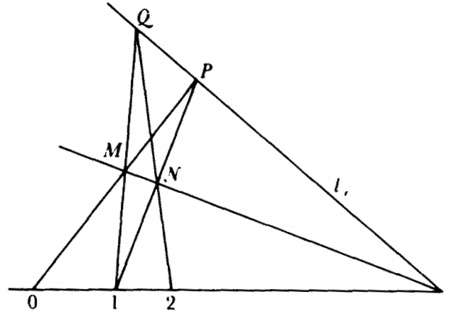

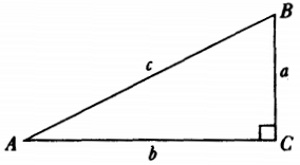

Schwarz resolvió el siguiente problema: dado un triángulo con ángulos agudos, considérense todos los triángulos tales que cada uno tiene sus vértices sobre los tres lados del triángulo original: el problema es encontrar el triángulo con el perímetro mínimo. Schwarz demostró sintéticamente [54] lo que los vértices de este triángulo de perímetro mínimo son los pies de las alturas del triángulo dado (fig. 35.3) [55].

Figura 35.3

Figura 35.4

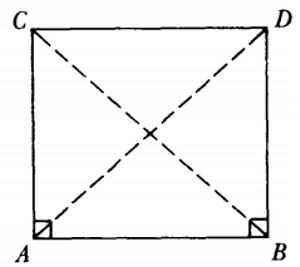

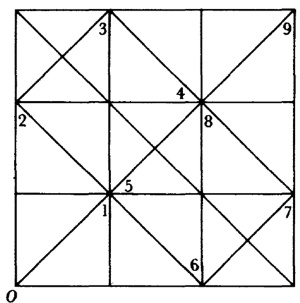

Algunos esfuerzos fueron dirigidos hacia la reducción del uso de regla y compás, en la misma línea iniciada por Mohr y Mascheroni (cap. 12, sec. 2). En su Traité de 1822, Poncelet demostró que todas las construcciones posibles con regla y compás (excepto la construcción de arcos circulares) eran posibles simplemente con regla, siempre que nos sea dado un círculo fijo con su centro. Steiner redemostró el mismo resultado más elegantemente en su pequeño libro Die geometriscken Constructionen ausgefübrt mittelst der geraden Linie und eines festen Kreises ( Las construcciones geométricas ejecutadas por medio de regla y un círculo fijo ). [57]

A pesar de que Steiner escribió el libro con fines pedagógicos, asegura en el prefacio del libro que establecerá la conjetura que un matemático francés había expresado.

La breve muestra anterior de teoremas euclídeos establecidos mediante métodos sintéticos no debe dejar al lector con la impresión' de que no se usaron los métodos de la geometría analítica. De hecho, Gergonne proporcionó demostraciones analíticas de muchos teoremas geométricos que publicó en la revista fundada por él, los Annales de Mathématiques.

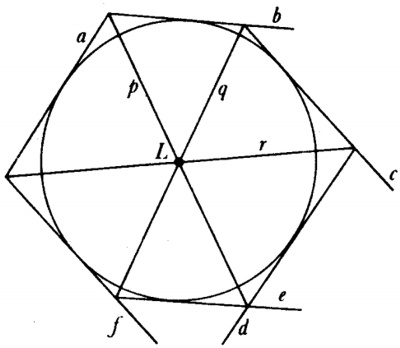

3. El resurgimiento de la geometría proyectiva sintética

El área principal hacia la que se volvieron Monge y sus alumnos fue la geometría proyectiva. Esta materia había tenido una explosión de actividad vigorosa, pero de breve vida, en el siglo XVII (cap. 14), pero fue menospreciada por el surgimiento de la geometría analítica, el cálculo y el análisis. Como ya hemos notado, el trabajo fundamental de Desargues de 1639 se perdió de vista hasta 1845 y el principal ensayo de Pascal sobre cónicas (1639) nunca fue recuperado. Sólo los libros de La Hire, que usaba algunos de los resultados de Desargues, estaban disponibles. Lo que los autores del siglo XIX aprendieron de los libros de La Hire, a menudo se lo atribuían a él incorrectamente. En general, estos geómetras ignoraban el trabajo de Desargues y Pascal y tuvieron que recrearlo. El resurgimiento de la geometría proyectiva fue iniciado por Lazare N. M. Carnot (1753-1823), alumno de Monge y padre del distinguido físico Sadi Carnot. Su principal obra fue la Géométrie de position (Geometría de la posición, 1803) y también contribuyó al Essai sur la théoríe des transversales (Ensayo sobre la teoría de las transversales, 1806). Monge defendió el uso conjunto del análisis y la geometría pura, pero Carnot rehusó emplear métodos analíticos y empezó la cruzada de la geometría pura. Muchas de las ideas que discutiremos en breve están sugeridas casi en su totalidad en el trabajo de Carnot.

Así, el principio que Monge llamó de las relaciones contingentes, conocido también como principio de correlatividad, y más comúnmente como principio de continuidad, se encuentra ahí. Carnot, a fin de evitar que las figuras sean separadas para los distintos tamaños de los ángulos y las direcciones de las líneas, no usó los números negativos, que consideraba contradictorios, y sí introdujo en cambio un complicado esquema llamado «correspondencia de signos».

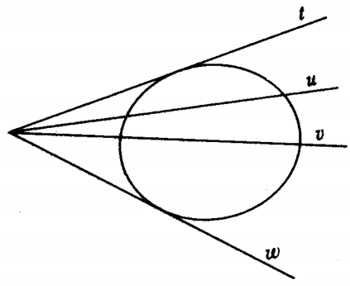

Figura 35.5

Brianchon derivó ese teorema utilizando la relación polo-polar.

El resurgimiento de la geometría proyectiva recibió su ímpetu principal de Poncelet (1788-1867). Poncelet fue alumno de Monge y también aprendió mucho de Carnot. Mientras servía como oficial en la campaña de Napoleón contra Rusia, es capturado y permanece el año 1813-1814 en una prisión rusa en Saratoff. Ahí Poncelet reconstruyó —sin la ayuda de libro alguno— lo que había aprendido de Monge y Carnot, creando nuevos resultados. Después amplió y revisó su trabajo, publicándolo bajo el título de Traité des propriétés projectives des figures (Tratado de las propiedades proyectivas de las figuras, 1822). Este trabajo constituye su principal contribución a la geometría proyectiva y a la erección de una nueva disciplina. En su vida posterior se vio obligado a dedicar gran parte de su tiempo al servicio gubernamental, a pesar de que tuvo algunos nombramientos de profesor por períodos limitados.

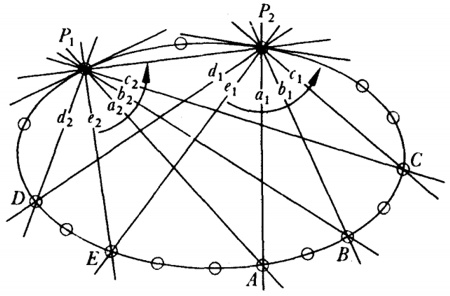

Poncelet se convirtió en el más ardiente defensor de la geometría sintética y hasta atacó el análisis. Aunque había sido amigo del gran analista Joseph Diez Gergonne (1771-1859) y publicó ensayos en los Annales de Mathématiques, de Gergonne, sus ataques también fueron en breve dirigidos a Gergonne. Poncelet estaba convencido de la autonomía e importancia de la geometría pura. A pesar que admitía el poder del análisis, creía que era posible otorgar el mismo poder a la geometría sintética. En un ensayo de 1818, publicado en los Annales de Gergonne [59], afirmó que el poder de los métodos analíticos no yacía en su uso del álgebra sino en su generalidad, y su ventaja resultaba del hecho que las propiedades métricas descubiertas para una figura típica permanecían aplicables, con la posible excepción del cambio de signo, a todas las figuras relacionadas que surgían de la típica o básica. Esta generalidad era asegurada en la geometría sintética por el principio de continuidad (que examinaremos en breve).

Poncelet fue el primer matemático en apreciar completamente que la geometría proyectiva era una nueva rama de las matemáticas, con métodos y metas propios. Mientras que los geómetras del siglo XVII habían tratado con problemas específicos, Poncelet entreveía el problema general de buscar todas las propiedades de las figuras geométricas que eran comunes a todas las secciones de cualquier proyección de una figura, esto es, permanecían sin alteración mediante la proyección y la sección. Este es el tema que él y sus sucesores estudiaron. Ya que las distancias y los ángulos son alterados por proyección y sección, Poncelet seleccionó y desarrolló la teoría de involución y de conjuntos armónicos de puntos, pero no el concepto de razón doble. Monge había utilizado la proyección paralela en su trabajo; como Desargues, Pascal, Newton y Lambert, Poncelet se valió de la proyección central, esto es, la proyección desde un punto, y elevó este concepto a un método de aproximación a los problemas geométricos. Poncelet también consideraba la transformación proyectiva a partir de una figura del espacio en otra, por supuesto, en una forma puramente geométrica. Aquí pareció perder interés en las propiedades proyectivas y estaba más interesado por el uso del método en bajo-relieve y diseño de andamios.

Su trabajo se centra en tres ideas. La primera es la de las figuras homologas; dos figuras son homologas si se deriva una de la otra mediante una proyección y una sección, que se denomina una perspectividad, o mediante una secuencia de proyecciones y secciones, esto es, una proyectividad. Al trabajar con figuras homologas, su plan era encontrar para una figura dada una figura homologa más simple, y, estudiándola, encontrar propiedades que son invariantes bajo proyección y sección, obteniendo propiedades de la figura más complicada. Desargues y Pascal emplearon la esencia de este método; y Poncelet, en su Traité, elogió la originalidad de Desargues en este y otros aspectos.

El segundo tema principal de Poncelet es el principio de continuidad. En su Traité lo establece de la siguiente manera: «Si una figura es derivada de otra mediante un cambio continuo y la última es tan general como la anterior, entonces cualquier propiedad de la primera figura puede ser establecida inmediatamente para la segunda.» La determinación de cuándo ambas figuras son generales no es explicada. El principio de Poncelet también afirma que si una figura degenera, como lo hace un hexágono en un pentágono cuando se hace que un lado se aproxime a cero, cualquier propiedad de la figura original será transmitida con un argumento apropiadamente redactado para la figura degenerada.

El principio no era realmente nuevo con Poncelet. En su sentido filosófico amplio se remite a Leibniz, quien estableció en 1687 que cuando las diferencias entre dos casos se pueden hacer más pequeñas que cualquier dato dado, las diferencias se pueden hacer más pequeñas que cualquier cantidad dada en el resultado. Desde los tiempos de Leibniz el principio fue reconocido y usado constantemente. Monge empezó a valerse del principio de continuidad para establecer teoremas. Quería demostrar un teorema general, pero utilizó una posición especial de la figura para demostrarlo y entonces mantuvo que el teorema era cierto en general, aun cuando algunos elementos de las figuras se hicieran imaginarios. Así, para demostrar un teorema acerca de una recta y una superficie lo demostraba cuando la recta corta la superficie y mantiene entonces que el resultado es válido aun cuando la línea ya no corta a la superficie y los puntos de intersección son imaginarios. Ni Monge ni Carnot, quienes también aplicaron este principio, proporcionaron ninguna justificación.

Poncelet, quien acuñó el término «principio de continuidad», propuso el principio como una verdad absoluta y lo aplicó con libertad en su Traité. Para «demostrar» su solidez toma el teorema sobre la igualdad de los productos de los segmentos de cuerdas que se cortan en un círculo y nota que cuando el punto de intersección se mueve fuera del círculo se obtiene la igualdad de los productos de las secantes y sus segmentos externos. Más aún, cuando una secante se convierte en tangente, la tangente y su segmento externo se hacen iguales y su producto continúa siendo igual al producto de las otras secantes y su segmento externo. Todo esto era suficientemente razonable, pero Poncelet aplicó el principio para demostrar muchos teoremas y, como Monge, extendió el principio para hacer aserciones acerca de figuras imaginarias. (Mencionaremos algunos ejemplos más tarde.)

Los otros miembros de la Academia de Ciencias de París criticaron el principio de continuidad y lo consideraban como si tuviera únicamente un interés heurístico. Cauchy, en particular, criticó el principio, pero desafortunadamente la crítica fue dirigida hacia aplicaciones que Poncelet había realizado donde el principio sí funcionaba. Los críticos también mencionaron que la confianza que Poncelet y otros tenían en el principio provenía realmente del hecho de que podía ser justificado sobre una base algebraica. De hecho, las notas que Poncelet hizo en prisión muestran que utilizó el análisis para probar la solidez de su principio. Estas notas, incidentalmente, fueron escritas por Poncelet y publicadas por él en dos volúmenes titulados Applications d’analyse et de géométrie (Aplicaciones del análisis y la geometría, 1862-1864), que es realmente una revisión de su Traité de 1822, y en el último trabajo sí usa métodos analíticos. Poncelet admitió que una demostración podía estar basada sobre el álgebra, pero insistió en que el principio no dependía de tal prueba. Sin embargo, es bastante seguro que Poncelet se apoyaba en el método algebraico para ver qué sucedía y entonces asegurar los resultados geométricos usando el principio como justificación.

Chasles, en su Aper ç u, defendió a Poncelet. La posición de Chasles era que el álgebra es una demostración a posteriori del principio. Sin embargo, él se protegía señalando que había que ser cuidadoso en no llevar de una figura a otra cualquier propiedad que dependa esencialmente de que los elementos sean reales o imaginarios. De esta forma, una sección de un cono puede ser una hipérbola, y ésta tiene asíntotas. Cuando la sección es una elipse, las asíntotas se hacen imaginarias. De aquí que no era posible demostrar un resultado acerca de las asíntotas por sí solas, porque éstas dependían de la naturaleza particular de la sección. Como no se debían llevar los resultados para una parábola al caso de la hipérbola, porque el plano que corta no tiene una posición general en el caso de la parábola. Más adelante discute el caso de dos círculos intersecándose que tienen una cuerda en común. Cuando los círculos ya no se intersecan, la cuerda común es imaginaria. El hecho de que la cuerda común real pase por dos puntos reales es, dice, una propiedad incidental o contingente. Una cuerda se ha de definir en algún modo que no dependa del hecho de que pasa por puntos reales cuando los círculos se intersecan, sino que sea una propiedad permanente de los dos círculos en cualquier posición. Así, uno puede definirlo como el eje radical (real), que significa que es una recta tal que a partir de cualquier punto sobre ella, las tangentes a los dos círculos son iguales, o bien se puede definir por medio de la propiedad de que cualquier círculo trazado con cualquier punto de la recta como centro corta los dos círculos ortogonalmente.

Chasles también insistía en que el principio de continuidad era el adecuado para tratar los elementos imaginarios en geometría. Primero explica lo que se quiere decir por imaginario en geometría. Los elementos imaginarios pertenecen a una condición o estado de una figura en el cual ciertas partes son no existentes, siempre que estas partes sean reales en otro estado de la figura. Porque, añade, uno no puede tener ninguna idea de las cantidades imaginarias, excepto pensando en los estados relacionados en que las cantidades son reales. Estos últimos estados son los que uno llama «accidentales» y los que proporcionan la clave para lo imaginario en geometría. Para demostrar resultados acerca de los elementos imaginarios sólo es necesario tomar la condición general de la figura en la que los elementos son reales, y entonces, de acuerdo con el principio de relaciones accidentales o el principio de continuidad, se concluye que los resultados se mantienen cuando los elementos son imaginarios. « Así se observa que el uso y la consideración de los imaginarios está completamente justificada. » El principio de continuidad fue aceptado durante el siglo XIX como intuitivamente claro y, por tanto, considerado como un axioma. Los geómetras lo usaron libremente y nunca juzgaron que requiriera una demostración.

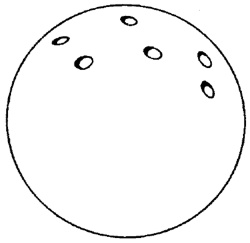

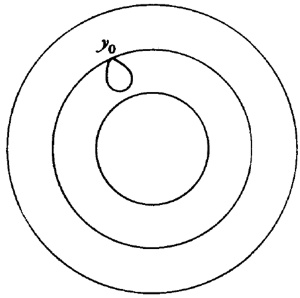

A pesar de que Poncelet utilizó el principio de continuidad para aseverar resultados acerca de los puntos y líneas imaginarios, nunca proporcionó una definición general de tales elementos. Para introducir algunos puntos imaginarios proporcionó una definición geométrica que es complicada y nada clara. Entenderemos estos elementos imaginarios con más facilidad cuando sean discutidos desde un punto de vista algebraico. A pesar de la falta de claridad en el acercamiento de Poncelet, a él debe acreditársele la introducción de la noción de los puntos circulares en el infinito, esto es, dos puntos imaginarios situados sobre la recta en el infinito, y comunes a dos círculos cualesquiera [60]. También presentó los círculos esféricos imaginarios que dos esferas cualesquiera tienen en común. Más adelante demostró que dos cónicas reales que no se intersecan tienen dos cuerdas comunes imaginarias y dos cónicas se intersecan en cuatro puntos, reales o imaginarios.

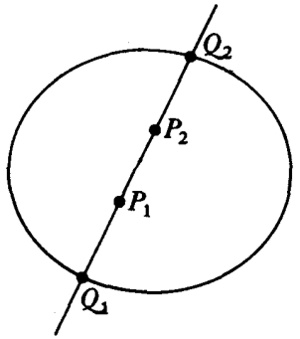

La tercera idea conductora del trabajo de Poncelet es la noción de polo y polar con respecto a una cónica. El concepto data de Apolonio y fue usado por Desargues (cap. 14, sec. 3) y por otros en los trabajos del siglo XVII sobre geometría proyectiva: Euler, Legendre, Monge, Servois y Brianchon ya lo habían utilizado. Pero Poncelet proporcionó una formulación general de la transformación de polo a polar, y conversamente, y la usó en su Traité de 1822 y en su « Mémoire sur la théorie générale des polaires reciproques» («Memoria sobre la teoría general de polares recíprocas»), presentada a la Academia de París en 1824 [61] como un método para establecer muchos teoremas.

Uno de los objetivos de Poncelet al estudiar la polar recíproca con respecto a una cónica era establecer el principio de dualidad. Los que trabajaban en geometría proyectiva habían observado que los teoremas relativos a figuras situadas en un plano, cuando eran parafraseados reemplazando la palabra «punto» por «recta» y «recta» por «punto», no solamente tenían sentido, sino que eran ciertos. La razón para la validez de los teoremas resultantes de tal paráfrasis no era clara, y de hecho Brianchon cuestionó el principio. Poncelet pensó que la relación entre polo y polar era la razón.

Sin embargo, esta relación requería la mediación de una cónica. Gergonne [62] insistió en que el principio era general y aplicable a todos los enunciados y teoremas, excepto aquellos que involucraban propiedades métricas. No se necesitaba del polo y la polar como un objeto de apoyo intermedio. Introdujo el término «dualidad» para denotar la relación entre el teorema original y el nuevo. También observó que en situaciones tridimensionales el punto y el plano constituyen elementos duales y la recta es dual es sí misma.