El sorprendente libro de las rarezas matemáticas

David Darling y Agnijo Banerjee

Las matemáticas son la creación más hermosa y más poderosa del espíritu humano.

STEFAN BANACH

Profundiza lo suficiente en cualquier tema y encontrarás las matemáticas.

DEAN SCHLICTER

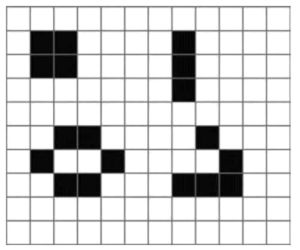

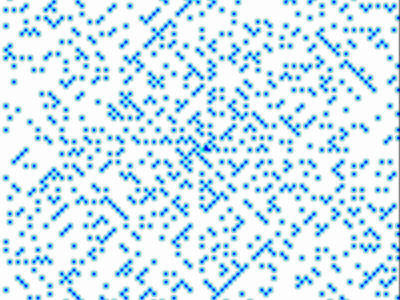

Las matemáticas son extrañas. Los números continúan para siempre, y hay diferentes clases de para siempre. Los números primos ayudan a sobrevivir a las cigarras. Una bola (matemática) puede cortarse en pedazos y luego unirse de nuevo, sin dejar ningún hueco, para formar una bola cuyo tamaño sea el doble o un millón de veces mayor que el original. Hay formas que tienen dimensiones fraccionarias y curvas que llenan un plano sin dejar huecos. Aburrido durante una presentación, el físico Stanislaw Ulam escribió números a partir del cero, en forma de espiral, marcó todos los números primos y descubrió que muchos se sitúan en largas diagonales, un hecho todavía no explicado del todo.

A veces olvidamos lo extrañas que son las matemáticas porque estamos muy acostumbrados a tratar con lo que parecen números y cálculos ordinarios, aquello que aprendemos en el colegio o que empleamos a diario. No obstante, resulta sorprendente el hecho de que nuestro cerebro sea tan hábil para pensar matemáticamente y, si así lo decidimos, para hacer matemáticas realmente complejas y abstractas. Después de todo, nuestros antepasados, decenas o centenares de miles de años atrás, no necesitaban resolver ecuaciones diferenciales ni aventurarse en el álgebra abstracta para sobrevivir el tiempo suficiente para transmitir sus genes a la siguiente generación. A la hora de buscar la próxima comida o un lugar donde refugiarse, de nada servía reflexionar sobre geometría en dimensiones superiores o sobre teorías de números primos. Sin embargo, nacemos dotados de un cerebro que posee el potencial para hacer tales cosas y para desvelar, cada año que pasa, verdades cada vez más extraordinarias acerca del universo matemático. La evolución nos ha proporcionado esta habilidad, pero ¿cómo y por qué? ¿Por qué somos, como especie, tan buenos haciendo algo que tiene todo el aspecto de ser un mero juego intelectual?

De algún modo, las matemáticas están entrelazadas con el tejido mismo de la realidad. Si profundizamos lo suficiente, descubrimos que lo que parecían trozos tangibles de materia o energía —electrones o fotones, por ejemplo—, se disuelven en inmaterialidad, convirtiéndose en meras ondas de probabilidad, y todo cuanto nos queda es una fantasmal tarjeta de visita en forma de algún intrincado, pero hermoso, conjunto de ecuaciones. En cierto sentido, las matemáticas apuntalan el mundo físico que nos rodea formando una infraestructura invisible. Pero también lo trascienden en ámbitos abstractos de posibilidad, que pueden continuar siendo para siempre puros ejercicios de la mente.

En este libro hemos optado por destacar algunas de las áreas más extraordinarias y fascinantes de las matemáticas, incluidas aquellas en las que se vislumbran en el horizonte nuevos desarrollos emocionantes. En ciertos casos, tienen vínculos con la ciencia y la tecnología: física de partículas, cosmología, ordenadores cuánticos y cosas por el estilo. En otros, se representan, al menos por ahora, como un fin en sí mismo, y son aventuras en un territorio desconocido que solo existe en la imaginación. Hemos decidido no esquivar ciertos temas solo porque sean arduos. Uno de los retos a la hora de describir numerosos aspectos de las matemáticas para un público general es la enorme distancia que los separa de la experiencia cotidiana. Pero, a la postre, siempre puede hallarse algún modo de conectar lo que están haciendo en la actualidad los exploradores y los pioneros en las fronteras de las matemáticas con el mundo de lo familiar, incluso si el lenguaje que tenemos que usar no es tan preciso como el que escogerían idealmente los académicos. Tal vez sea cierto que si algo, por oscuro que sea, no puede explicarse razonablemente bien a una persona de inteligencia normal, entonces es aquel que explica quien necesita mejorar su comprensión.

Este libro nació de una manera inusual. Uno de nosotros (David) es un autor científico desde hace más de treinta y cinco años, y ha escrito numerosos libros sobre astronomía, cosmología, física y filosofía, e incluso una enciclopedia de matemáticas recreativas. El otro (Agnijo) es un matemático joven y brillante, y un niño prodigio (con un coeficiente intelectual —CI— al menos de 162, según Mensa) que, en el momento de redactar este libro, acaba de terminar en Hungría su preparación para la Olimpiada Internacional de Matemáticas de 2017. Agnijo empezó a recibir clases particulares de matemáticas y ciencias de David a los doce años. Tres años después, decidimos escribir juntos un libro.

Nos sentamos a hacer una lluvia de ideas sobre los temas que queríamos cubrir. David, por ejemplo, propuso las dimensiones superiores, la filosofía de las matemáticas y las matemáticas de la música, en tanto que Agnijo tenía muchas ganas de escribir sobre los números grandes (su pasión personal), la computación y los misterios de los números primos. Desde el primer instante decidimos inclinarnos hacia cualquier cosa inusual o realmente rara, y conectar, en la medida de lo posible, estas matemáticas extrañas con temas del mundo real y con la experiencia cotidiana. También nos comprometimos a no huir de los asuntos por el mero hecho de que fueran complejos, y adoptamos como un mantra que si no eres capaz de explicar algo en un lenguaje sencillo, entonces no lo entiendes adecuadamente. En general, David se ha encargado de los aspectos históricos, filosóficos y anecdóticos de cada capítulo, mientras que Agnijo se ha peleado con los aspectos más técnicos. Agnijo ha revisado y verificado el trabajo de David, y David ha organizado todo lo escrito en capítulos completos. ¡Todo ha funcionado sorprendentemente bien! Esperamos que disfrutes del resultado.

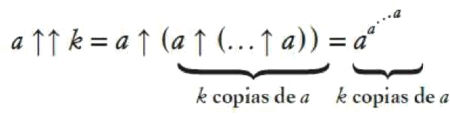

Al hojear las páginas de este libro, advertirás que contiene algunos símbolos como x, 𝜔 (omega) e incluso el extraño ℵ (álef). Encontrarás de forma ocasional una ecuación o una combinación de caracteres que se te antojará desconocida, como 3↑↑3↑↑3 (especialmente en los capítulos sobre los números grandes y el infinito). Si no eres matemático, no te desanimes. No son sino taquigrafía para las ideas que intentaremos explicar debidamente de antemano, y nos ayudarán a indagar en el tema en cuestión con algo más de rapidez y profundidad de la que sería posible sin estos recursos. Uno de nosotros (David) lleva muchos años impartiendo clases particulares de matemáticas, y todavía no ha conocido a ningún estudiante al que estas no se le den bien una vez que cree en sí mismo. Lo cierto es que todos somos matemáticos por naturaleza, nos demos cuenta o no de ello. Así pues, teniendo esto presente, aventurémonos...

Capítulo 1

Las matemáticas detrás del mundo

Han ocurrido cosas más extrañas todavía; y quizá la más extraña de todas sea la maravilla de que las matemáticas sean posibles para una raza parecida a los simios.

ERIC T. BELL, Historia de las matemáticas

La física es matemática no por lo mucho que sabemos sobre el mundo físico, sino por lo poco que sabemos; sus propiedades matemáticas son las únicas que somos capaces de descubrir.

BERTRAND RUSSELL

En cuanto a su capacidad intelectual, el Homo sapiens apenas ha cambiado a lo largo de los últimos cien mil años. Si metiéramos en una escuela actual a los niños de la época en la que los rinocerontes y los mastodontes lanudos todavía vagaban por la tierra, se desarrollarían igual de bien que los típicos jóvenes del siglo XXI. Su cerebro asimilaría la aritmética, la geometría y el álgebra. Y, si sintieran esa inclinación, nada les impediría profundizar en el tema y tal vez llegarían a ser algún día profesores de matemáticas en Cambridge o en Harvard.

Nuestro aparato neuronal desarrolló el potencial para hacer cálculos avanzados y para comprender cosas tales como la teoría de conjuntos y la geometría diferencial, mucho antes de aplicarse en este sentido. De hecho, resulta un tanto misterioso por qué tenemos este talento innato para las matemáticas superiores, cuando estas carecen de un valor evidente para la supervivencia. Al mismo tiempo, la razón por la cual surgió y sobrevivió nuestra especie es que tenía una ventaja sobre sus rivales en lo que atañe a la inteligencia y a la capacidad de pensar lógicamente, planear con antelación y preguntar «¿Y si...?». A falta de otras destrezas para la supervivencia, tales como la velocidad y la fuerza, nuestros antepasados se vieron obligados a depender de su astucia y de su previsión. La capacidad de pensamiento lógico se convirtió en nuestro gran superpoder, y, con el tiempo, dimanaría de ella nuestra facultad de comunicarnos de una manera compleja, de simbolizar y de comprender en términos racionales el mundo que nos rodea.

Como todos los animales, hacemos, en efecto, muchas matemáticas difíciles sobre la marcha. El simple acto de coger una pelota (o de evitar a los depredadores o de cazar una presa) implica resolver simultáneamente múltiples ecuaciones a alta velocidad. Si intentamos programar un robot para que haga lo mismo, la complejidad de los cálculos implicados es evidente. Pero la gran fortaleza de los humanos era su capacidad para pasar de lo concreto a lo abstracto, analizar las situaciones, hacer preguntas del tipo «Si..., entonces...» y planear con antelación.

Los egipcios tenían un buen conocimiento de las matemáticas prácticas y lo aplicaron a la construcción de la pirámide de Kefrén, el Guiza mostrada aquí junto a la Gran Esfinge.

El nacimiento de la agricultura conllevó la necesidad de seguir con precisión el ritmo de las estaciones, y la aparición del comercio y las comunidades asentadas significó la necesidad de llevar a cabo transacciones y llevar las cuentas. Estos dos propósitos prácticos, los calendarios y las transacciones comerciales, requerían el desarrollo de alguna clase de cálculo, y de este modo hicieron su aparición las matemáticas elementales. Una de las regiones en las que surgió fue Oriente Medio. Los arqueólogos han desenterrado fichas comerciales de arcilla sumerias que se remontan a alrededor del año 8000 a. C. que demuestran que aquellas personas manejaban representaciones del número. Pero, al parecer, en ese periodo temprano, no trataban el concepto como separado de la cosa contada. Por ejemplo, disponían de fichas de diferentes formas para cosas diferentes, como las ovejas o las tinajas de aceite. Cuando las partes tenían que intercambiarse muchas fichas, estas se sellaban en el interior de recipientes llamados bullae, que tenían que romperse para abrirlas, a fin de comprobar su contenido. Con el tiempo, comenzaron a aparecer marcas en las bullae para indicar cuántas fichas había en su interior. Las representaciones simbólicas evolucionaron entonces hacia un sistema numérico escrito, en tanto que las fichas llegaron a generalizarse para contar cualquier clase de objetos y, finalmente, se transformaron en una forma temprana de sistema monetario. A lo largo del camino, el concepto de número se abstrajo del tipo de objeto contado, de suerte que, por ejemplo, cinco, era cinco, tanto si se refería a cinco cabras como a cinco hogazas de pan.

La conexión entre las matemáticas y la realidad cotidiana parece fuerte en aquella etapa. El cálculo y el mantenimiento de registros son herramientas prácticas del agricultor y del comerciante, y si esos métodos cumplen su misión, ¿a quién le importa la filosofía que hay detrás? La aritmética simple parece bien arraigada en el mundo «de ahí fuera»: una oveja más una oveja son dos ovejas, dos ovejas más dos ovejas son cuatro ovejas. Nada podría ser más sencillo. Ahora bien, si observamos con más atención, vemos que ha sucedido ya algo un tanto extraño. Al decir «una oveja y una oveja», se está asumiendo que las ovejas son idénticas o, al menos, a efectos del cálculo, que las diferencias no importan. Pero no hay dos ovejas iguales. Lo que hemos hecho es abstraer una cualidad percibida que tiene que ver con la oveja (su identidad o singularidad) y operar sobre esta cualidad con otra abstracción, que denominamos adición. Se trata de un gran paso. En la práctica, sumar una oveja y una oveja puede significar ponerlas juntas en el mismo campo. Pero, también en la práctica, las ovejas son diferentes, y, ahondando un poco más, lo que llamamos oveja —como cualquier otro elemento del mundo— no está separado en realidad del resto del universo. Además, tenemos el hecho ligeramente inquietante de que lo que consideramos objetos (como las ovejas) que están «ahí fuera» son construcciones de nuestro cerebro, creadas por señales que penetran en nuestros sentidos. Incluso si aceptamos que una oveja posee alguna realidad externa, la física nos dice que se trata de un ensamblaje temporal enormemente complejo de partículas subatómicas en flujo constante. Sin embargo, de algún modo, al contar ovejas somos capaces de ignorar esta monumental complejidad, o, más bien, en la vida cotidiana, ni siquiera somos conscientes de ella.

De todas las disciplinas, la matemática es la más precisa e inmutable. La ciencia y otros ámbitos de la actividad humana son, a lo sumo, aproximaciones a algún ideal, y no cesan de cambiar y evolucionar a lo largo del tiempo. Como señalara el matemático alemán Hermann Hankel: «En la mayoría de las ciencias, una generación derriba lo que otra ha construido, y lo que una ha establecido otra lo deshace. Solo en las matemáticas cada generación añade un nuevo piso a la vieja estructura». Desde el principio, esta diferencia entre las matemáticas y cualquier otra disciplina resulta inevitable, pues en las matemáticas la mente empieza por extraer aquello que reconoce como más fundamental y constante entre los mensajes que recibe a través de los sentidos. Esto conduce al concepto de número natural, como una forma de medir la cantidad, y de adición y sustracción, como formas básicas de combinar cantidades. Unidad, dualidad, trinidad, y así sucesivamente, se consideran rasgos comunes de conjuntos de cosas, cualesquiera que esas cosas resulten ser y por muy diferentes que sean los individuos del mismo tipo de cosa. Así pues, el hecho de que las matemáticas posean esta cualidad adamantina y eterna está garantizado desde el comienzo y supone su mayor fortaleza.

Las matemáticas existen. De eso no cabe la menor duda. El teorema de Pitágoras, por ejemplo, forma parte de nuestra realidad de algún modo. Ahora bien, ¿dónde existen cuando no están siendo usadas ni ejemplificadas en alguna forma material, y dónde existían hace muchos miles de años, antes de que alguien hubiera pensado en ellas? Los platónicos creen que los objetos matemáticos, tales como los números, las formas geométricas y las relaciones entre ellos, existen independientemente de nosotros, de nuestros pensamientos, de nuestro lenguaje y del universo físico. No especifican qué clase de reino etéreo habitan, pero suponen habitualmente que están «ahí fuera». Probablemente sea justo decir que la mayoría de los matemáticos participan de esta escuela de pensamiento y, por consiguiente, también de la creencia de que las matemáticas se descubren, no se inventan. Además, probablemente la mayoría de ellos no propenden a filosofar y se contentan con continuar haciendo matemáticas, del mismo modo que a la mayoría de los físicos, al trabajar en el laboratorio o al resolver problemas teóricos, no les preocupa mucho la metafísica. Con todo, la naturaleza última de las cosas —en este caso, de las cosas matemáticas— es interesante, incluso si nunca llegamos a una respuesta definitiva. El matemático y lógico prusiano Leopold Kronecker pensaba que solo los números enteros eran dados, o en sus palabras: «Dios hizo los números enteros; todo el resto es obra del hombre». El astrofísico inglés Arthur Eddington fue más allá al afirmar: «Las matemáticas no están ahí hasta que nosotros las ponemos ahí». El debate sobre si las matemáticas son inventadas o descubiertas, o acaso una combinación de ambas cosas surgida de una sinergia de la mente y la materia, seguirá coleando, sin duda, y, en última instancia, puede que no admita una respuesta simple.

Un hecho está claro: si se ha demostrado la verdad de un elemento matemático, este seguirá siendo verdadero para siempre. No es una cuestión de opiniones ni depende de influencias subjetivas. «Me gustan las matemáticas —observaba Bertrand Russell— porque no son humanas y no tienen nada que ver en particular con este planeta ni con la totalidad del universo accidental». David Hilbert expresó algo similar: «Las matemáticas no entienden de razas ni de fronteras geográficas; para las matemáticas, el mundo cultural es un solo país». Esta cualidad universal e impersonal de las matemáticas es su mayor fortaleza, si bien, para el ojo entrenado, no desmerece su atractivo estético. «La belleza es la primera prueba: no existe ningún lugar permanente en el mundo para las matemáticas feas», observa el matemático inglés G. H. Hardy. El mismo sentimiento, pero desde el campo de la física teórica, fue expresado por Paul Dirac: «Uno de los rasgos esenciales de la naturaleza parece ser que las leyes físicas fundamentales se describen en términos de una teoría matemática de gran belleza y poder».

No obstante, la otra cara de la universalidad de las matemáticas es que pueden parecer frías y estériles, desprovistas de pasión y sentimiento. Como resultado podemos encontrarnos con que, aunque los seres inteligentes de otros mundos compartan nuestras mismas matemáticas, estas no sean la mejor forma de comunicarnos con ellos sobre muchas de las cosas que nos importan. «Muchos sugieren el uso de las matemáticas para hablar con los alienígenas», comenta Seth Shostak, investigador del Search for Extraterrestrial Intelligence (SETI). De hecho, el matemático neerlandés Hans Freudenthal desarrolló un lenguaje entero (Lincos) basado en esta idea. «Ahora bien — dice Shostak—, mi opinión personal es que las matemáticas pueden ser un modo arduo de describir ideas tales como amor o democracia.»

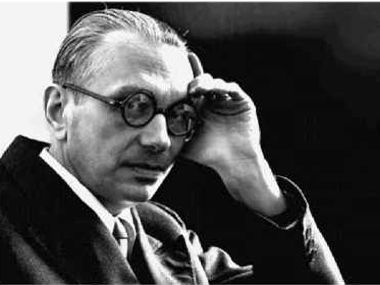

El objetivo último de los científicos, ciertamente de los físicos, es reducir lo que observan en el mundo a una descripción matemática. Los cosmólogos, los físicos de partículas y similares nunca se sienten más felices que cuando han medido y cuantificado cosas, y luego han descubierto una relación entre las cantidades. La idea de que el universo es matemático en su núcleo posee raíces antiguas, que se remontan cuando menos a los pitagóricos. Galileo veía el mundo como un «gran libro» escrito en el lenguaje de las matemáticas, y, mucho más recientemente, en 1960, el físico y matemático húngaro-estadounidense Eugene Wigner escribió un artículo titulado «The Unreasonable Effectiveness of Mathematics in the Natural Sciences» [La irrazonable eficacia de las matemáticas en las ciencias naturales].

No vemos los números directamente en el mundo real, por lo que no resulta evidente de inmediato que las matemáticas estén a nuestro alrededor. Pero sí que vemos las formas —la forma cuasi esférica de los planetas y las estrellas, la trayectoria curva de los objetos cuando se lanzan o están en órbita, la simetría de los copos de nieve, y así sucesivamente—, y estas pueden describirse mediante relaciones entre números. Otros patrones, traducibles a las matemáticas, surgen de la forma en que se comportan la electricidad o el magnetismo, rotan las galaxias y actúan los electrones dentro de los confines de los átomos. Estos patrones, y las ecuaciones que los describen, sustentan acontecimientos individuales y parecen representar verdades intemporales y profundas, que subyacen a la complejidad cambiante en la que nos encontramos. El físico alemán Heinrich Hertz, que demostró de manera concluyente por primera vez la existencia de ondas electromagnéticas, observaba: «Es inevitable la sensación de que estas fórmulas matemáticas poseen una existencia independiente y una inteligencia propia, que son más sabias que nosotros, más sabias incluso que sus descubridores, que sacamos de ellas más de lo que fue puesto en ellas originalmente».

Es indiscutiblemente cierto que la base de la ciencia moderna es de naturaleza matemática. Ahora bien, eso no significa necesariamente que la realidad misma sea fundamentalmente matemática. Desde la época de Galileo, la ciencia ha separado lo subjetivo de lo objetivo o mensurable, y se ha centrado en esto último. Ha hecho todo lo posible por desalojar todo lo que tenga algo que ver con el observador y por prestar atención solo a aquello que supuestamente yace más allá de las intromisiones y las influencias del cerebro y los sentidos. La forma en la que se ha desarrollado la ciencia moderna garantiza prácticamente que esta sea de naturaleza matemática. Pero esto deja muchas cosas que la ciencia tiene problemas para abordar, especialmente la conciencia. Puede que algún día dispongamos de un modelo bueno y exhaustivo del funcionamiento del cerebro en lo que atañe a la memoria, el procesamiento visual y demás. Pero la razón por la que tenemos también una experiencia interna, un sentimiento de «lo que significa ser», sigue estando —y tal vez permanezca siempre— fuera del ámbito de la ciencia convencional y, por extensión, de las matemáticas.

¿Por qué ha evolucionado el cerebro humano para ser tan extraordinariamente bueno en un ámbito, las matemáticas, que no necesita para la supervivencia?

Por un lado, los platónicos creen que las matemáticas son un territorio ya existente, a la espera de nuestra exploración. Por otro lado, están aquellos que insisten en que nosotros inventamos las matemáticas conforme avanzamos en la consecución de nuestros propósitos. Ambas posiciones tienen sus puntos débiles. Los platónicos se afanan por explicar dónde pueden estar cosas como pi (π) fuera del universo físico o de la mente inteligente. Los no platónicos tienen dificultades para negar el hecho de que, por ejemplo, los planetas continuarían orbitando en elipses alrededor del Sol con independencia de que hagamos o no matemáticas. Una tercera escuela de filosofía matemática ocupa una posición intermedia entre las otras dos, y señala que, al describir el mundo real, las matemáticas no tienen tanto éxito como a veces se da a entender. Sí, las ecuaciones son útiles para decirnos cómo dirigir una nave espacial a la Luna o a Marte, o para diseñar un nuevo avión o para predecir el tiempo con varios días de antelación. Pero estas ecuaciones son meras aproximaciones a la realidad de lo que pretenden describir y, además, solo se aplican a una pequeña porción de todas las cosas que acontecen a nuestro alrededor. Al pregonar el éxito de las matemáticas, diría el realista, restamos importancia a la inmensa mayoría de los fenómenos que son demasiado complejos o mal comprendidos para captarlos de forma matemática, o que, por su propia naturaleza, son irreductibles a esta clase de análisis.

¿Es posible que el universo no sea matemático en realidad? Después de todo, el espacio y los objetos que contiene no nos presentan directamente nada matemático. Los humanos racionalizamos y hacemos aproximaciones con el fin de modelizar aspectos del universo. Al hacerlo, las matemáticas nos resultan extremadamente útiles al permitirnos entenderlo. Eso no implica necesariamente que las matemáticas sean algo más que una cómoda creación nuestra. Ahora bien, si las matemáticas no están presentes de entrada en el universo, ¿cómo podemos ser capaces de inventarlas con tal propósito?

Las matemáticas se dividen, a grandes rasgos, en dos áreas: puras y aplicadas. Las matemáticas puras son las matemáticas como un fin en sí mismo. Las matemáticas aplicadas ponen a trabajar sus asuntos en los problemas del mundo real. Pero, con frecuencia, los desarrollos en las matemáticas puras, que aparentemente no guardan relación alguna con nada tangible, se han revelado más tarde sorprendentemente útiles para los científicos y los ingenieros. En 1843, el matemático irlandés William Hamilton fraguó la idea de los cuaterniones, generalizaciones tetradimensionales de números ordinarios sin ningún interés práctico en su momento, pero que, más de un siglo después, han resultado ser una herramienta eficaz en robótica y en gráficos por ordenador y videojuegos. Una cuestión abordada por primera vez por Johannes Kepler en 1611, acerca de la manera más eficiente de empaquetar esferas en el espacio tridimensional, se ha aplicado a la transmisión eficiente de información a través de canales ruidosos. La disciplina matemática más pura, la teoría de números, buena parte de la cual se pensaba que apenas poseía valor práctico, ha conducido a avances importantes en el desarrollo de cifrados seguros. Y la nueva geometría iniciada por Bernhard Riemann, que se ocupaba de las superficies curvas, se reveló ideal para la formulación de la teoría general de la relatividad de Einstein —una nueva teoría de la gravedad—, más de cincuenta años después.

En julio del año 1915, uno de los científicos más grandes de todos los tiempos conoció a uno de los matemáticos más grandes de la época, cuando Albert Einstein visitó a David Hilbert en la Universidad de Gotinga. El diciembre siguiente, ambos publicaron casi simultáneamente las ecuaciones que describían el campo gravitatorio de la teoría general de Einstein. Pero mientras que las ecuaciones mismas eran el objetivo para Einstein, Hilbert confiaba en que fueran un escalón hacia un plan más ambicioso todavía. La pasión de Hilbert, la fuerza motriz que impulsaba buena parte de su labor, era la búsqueda de los principios fundamentales o axiomas que podrían subyacer a todas las matemáticas. Parte de esta búsqueda, tal como él la concebía, consistía en descubrir un conjunto mínimo de axiomas a partir de los cuales pudiera deducir no solo las ecuaciones de la teoría general de Einstein, sino también cualquier otra teoría física. Kurt Gödel, con sus teoremas de incompletitud, minó la fe en la idea de que las matemáticas pudieran tener las respuestas a todas las preguntas. No obstante, seguimos sin saber con certeza hasta qué punto el mundo en el que vivimos es verdaderamente matemático o solo matemático en apariencia.

Puede que nunca se lleven a la práctica áreas enteras de las matemáticas, más allá de contribuir a abrir nuevas vías de investigación pura. Por otra parte, hasta donde sabemos, es posible que buena parte de las matemáticas puras se represente, de formas inesperadas, en el universo físico, o, si no en este universo, entonces en otros que podrían existir a través de lo que los cosmólogos sospechan que es un multiverso de escala incomprensible. Quizá todo aquello que sea matemáticamente verdadero y válido esté representado en algún lugar, en algún tiempo y de algún modo en la realidad en la que nos hallamos insertos. Por el momento, nuestro viaje nos mantendrá ocupados: la extraña y maravillosa aventura de la mente humana en su exploración incesante de las fronteras del número, el espacio y la razón.

En los capítulos siguientes nos sumergiremos en temas extraños y asombrosos que, al mismo tiempo, tienen conexiones muy reales con el mundo que conocemos. Cierto es que hay partes de las matemáticas que pueden antojarse esotéricas, fantasiosas e incluso carentes de sentido, como un extraño y enrevesado juego de la imaginación. Pero, en su núcleo, las matemáticas son un asunto práctico, enraizado en el comercio, la agricultura y la arquitectura. Aunque se han desarrollado de formas que nuestros antepasados jamás podrían haber soñado, esos vínculos con nuestra vida cotidiana permanecen todavía en su corazón.

Una de las características más extrañas de la teoría de cuerdas es que requiere más de las tres dimensiones espaciales que vemos directamente en el mundo que nos rodea. Esto suena a ciencia ficción, pero es un resultado incuestionable de la teoría de cuerdas.

BRIAN GREENE

Vivimos en un mundo de tres dimensiones: arriba y abajo, de lado a lado, y hacia atrás y hacia delante, o cualesquiera otras tres direcciones que formen ángulos rectos entre sí. Resulta fácil imaginar algo en una dimensión, como una línea recta, o dos dimensiones, como un cuadrado dibujado en una hoja de papel. Ahora bien, ¿cómo podemos aprender a ver en una dimensión adicional a aquellas con las que estamos familiarizados? ¿Dónde está esta dirección adicional que es perpendicular a las tres que conocemos?

Estas preguntas pueden antojarse puramente académicas. Si nuestro mundo es tridimensional, ¿por qué preocuparnos de 4D, 5D, etcétera? El caso es que la ciencia puede necesitar dimensiones superiores para explicar lo que sucede en el plano subatómico. Estas dimensiones adicionales pueden contener la clave para la comprensión del gran esquema de la materia y la energía. Mientras tanto, en un ámbito más práctico, si pudiéramos aprender a ver en 4D, dispondríamos de una herramienta nueva y poderosa para su uso en medicina y educación.

A veces, la cuarta dimensión se considera algo distinto de una dirección extra en el espacio. Después de todo, la palabra dimensión, del latín dimensio, -onis, significa simplemente «medida». En física, se considera que las dimensiones básicas que conforman los componentes esenciales de otras cantidades son la longitud, la masa, el tiempo y la carga eléctrica. Con mucha frecuencia, en un contexto diferente, los físicos hablan de tres dimensiones del espacio y una del tiempo, especialmente desde que Albert Einstein demostró que, en el mundo en que vivimos, el espacio y el tiempo están siempre vinculados entre sí en una entidad única denominada espaciotiempo. No obstante, incluso antes de la aparición de la teoría de la relatividad, se había especulado con la posibilidad de moverse hacia atrás y hacia delante a lo largo de la dimensión temporal, al igual que podemos movernos en cualquier dirección que deseemos en el espacio. En su novela The Time Machine (La máquina del tiempo),[1] publicada en 1895, H. G. Wells explica que no puede existir, por ejemplo, un cubo instantáneo. El cubo que vemos momento a momento es solo una sección transversal de una cosa tetradimensional que tiene longitud, anchura, profundidad y duración. «No existe diferencia —dice el Viajero del Tiempo— entre el tiempo y cualquiera de las tres dimensiones de espacio, excepto que nuestra conciencia se mueve a lo largo de este.»

Los victorianos también se sentían fascinados por la idea de una cuarta dimensión del espacio, tanto desde un punto de vista matemático como por las posibilidades que parecía ofrecer de explicar otra obsesión de la época: el espiritismo. El final del siglo XIX fue un periodo en el que muchas personas, incluidas lumbreras tales como Arthur Conan Doyle, Elizabeth Barrett Browning y William Crookes, se sentían atraídas por las afirmaciones de los médiums y la posibilidad de comunicarse con los muertos. La gente se preguntaba si el más allá podría existir en una cuarta dimensión paralela o superpuesta a la nuestra, de suerte que los espíritus de los difuntos pudieran ingresar con facilidad en nuestro reino material y regresar de nuevo.

Nuestra incapacidad de visualizar en dimensiones superiores hace tentador pensar que la cuarta dimensión es un tanto misteriosa o ajena a cualquier cosa que conocemos. Los matemáticos, sin embargo, no tienen problemas para trabajar con objetos o espacios tetradimensionales, pues no necesitan imaginar cómo son estos en realidad para describir sus propiedades. Estas propiedades pueden descubrirse utilizando el álgebra y el cálculo, sin tener que recurrir a ninguna gimnasia mental multidimensional. Comencemos con una circunferencia, por ejemplo. Una circunferencia es una curva formada por todos los puntos de un plano que se encuentran a la misma distancia (el radio) de un punto dado (el centro). Al igual que la línea recta, solo tiene longitud —ni anchura ni altura—, por lo que es una cosa unidimensional. Imagínate que estás situado y constreñido en una línea. La única libertad de movimiento que tendrías sería a lo largo de la línea, en uno u otro sentido. Lo mismo sucede con una circunferencia. Aunque la circunferencia existe en un espacio al menos de dos dimensiones, si estuvieras situado y confinado dentro de la circunferencia, no tendrías ni más ni menos libertad de movimiento que si estuvieses situado en una línea. Solo podrías avanzar o retroceder a lo largo de la circunferencia, efectivamente atado a una única dimensión del movimiento.

Los no matemáticos piensan a veces que una circunferencia incluye también su interior. Pero una «circunferencia rellena» para un matemático no es una circunferencia, sino un objeto muy diferente llamado disco. Una circunferencia es un objeto unidimensional que puede «insertarse» en un objeto bidimensional, un plano (una circunferencia finamente trazada en una hoja de papel se aproxima a ello). La longitud o perímetro de una circunferencia viene dada por 2πr, donde r es el radio, y el área delimitada por la circunferencia es πr2. Al ascender una dimensión, llegamos a la esfera, constituida por todos los puntos situados a la misma distancia de un punto dado en un espacio tridimensional. Una vez más, el lego puede confundir una esfera auténtica, que es solo una superficie bidimensional, con el objeto que incluye asimismo todos los puntos delimitados por esta superficie. Pero los matemáticos establecen de nuevo una distinción tajante y designan esto último como bola. Una esfera es un objeto bidimensional que puede insertarse en un espacio tridimensional. Tiene un área superficial de 4 πr2 y delimita un volumen de 4/3πr3. Dado que una esfera ordinaria es bidimensional, los matemáticos la denominan 2-esfera, mientras que una circunferencia, empleando el mismo sistema de denominación, es una 1-esfera. Las esferas de dimensiones superiores se definen como hiperesferas y pueden etiquetarse de la misma forma. La hiperesfera más simple, la 3-esfera, es un objeto tridimensional inserto en un espacio tetradimensional. No podemos captar esto en nuestra imaginación, pero podemos comprenderlo por analogía. Al igual que una circunferencia es una línea curva y una (2- )esfera ordinaria es una superficie curva, una 3-esfera es un volumen curvo. Mediante un sencillo cálculo, los matemáticos pueden demostrar que este volumen curvo viene dado por 2 π 2r3. Es la 3-esfera equivalente al área superficial de una esfera ordinaria y se designa asimismo como hiperárea cúbica o volumen superficial. El espacio tetradimensional delimitado por una 3-esfera tiene un volumen tetradimensional, o hipervolumen cuártico, de 1/2π2r4. Demostrar estos datos relativos a la 3-esfera no es mucho más difícil que demostrarlos para la circunferencia o la esfera ordinaria, y no implica tener que comprender cómo es en realidad una 3-esfera.

Análogamente, podemos afanarnos por captar el aspecto auténtico de un cubo tetradimensional o teseracto, aunque, como veremos, podemos tratar de representarlo en dos o tres dimensiones. Pero resulta sencillo describir la progresión del cuadrado al cubo al teseracto: un cuadrado tiene 4 vértices (esquinas) y 4 aristas; un cubo tiene 8 vértices, 12 aristas y 6 caras; un teseracto tiene 16 vértices, 32 aristas, 24 caras y 8 celdas (los equivalentes tridimensionales de las caras) que consisten en cubos. Este último dato es el que desafía nuestras tentativas de visualización: un teseracto tiene 8 celdas cúbicas dispuestas de tal manera que delimitan un espacio tetradimensional, al igual que un cubo tiene 6 caras cuadradas dispuestas de tal manera que delimitan un espacio tridimensional.

Lo mejor que podemos hacer normalmente para asimilar la cuarta dimensión es trazar analogías con la tercera. Por ejemplo, si preguntamos: «¿Cómo sería un hiperespacio tetradimensional si atravesara nuestro espacio?», podemos hacernos una idea al considerar lo que sucede si una esfera atraviesa un plano. Supongamos que existen seres bidimensionales que habitan ese plano. Al observar la superficie de su mundo, que es todo cuanto pueden hacer, solo ven puntos o líneas de diferente longitud, que solo pueden interpretar como figuras bidimensionales. Cuando nuestra esfera en 3D entra en contacto inicialmente con su espacio en 2D, la ven como un punto, que luego crece hasta convertirse en una circunferencia, que alcanza un diámetro máximo igual al diámetro de la esfera, antes de que la circunferencia se contraiga de nuevo hasta convertirse en un punto y luego desaparezca, cuando la esfera atraviese el plano. Análogamente, si una 4- esfera se intersecara con nuestro espacio, la veríamos como un punto que se expandiría, como una burbuja, hasta convertirse en una esfera tridimensional de tamaño máximo antes de contraerse y finalmente desaparecer. La auténtica naturaleza —la extradimensionalidad— de la 4-esfera permanecería oculta para nosotros, aunque su misteriosa aparición, crecimiento y desaparición probablemente nos llevarían a preguntarnos qué está sucediendo.

Los seres tetradimensionales tendrían poderes aparentemente mágicos en nuestro mundo. Por ejemplo, podrían coger un zapato del pie derecho, darle la vuelta en la cuarta dimensión y volver a ponérselo en el pie izquierdo. Si esto resulta difícil de entender, pensemos en un zapato bidimensional, que sería como una suela infinitamente fina con forma de uno u otro pie. Podríamos recortar una forma semejante en un papel, levantarla, darle la vuelta y volver a bajarla, con lo que habríamos cambiado su lateralidad para el pie. A una criatura de 2D esto le resultaría totalmente asombroso, pero, para nosotros, con el beneficio de la dimensión extra, el truco nos parecería evidente.

En principio, un ser de 4D podría dar la vuelta a una persona (en 3D) completa en la cuarta dimensión, aunque la ausencia de casos de personas en las que de repente todo se ha invertido de derecha a izquierda o de izquierda a derecha sugiere que esto no ha sucedido en realidad. En su relato breve «The Plattner Story» («La historia de Plattner»),[2] H. G. Wells describe el extraordinario caso de Gottfried Plattner, un profesor que desaparece durante nueve días a raíz de una explosión en el laboratorio de química de un colegio. A su regreso, es efectivamente una imagen especular de su yo anterior, aunque sus recuerdos de lo que había ocurrido durante el periodo de ausencia se reciben con incredulidad. Que te invirtieran de verdad en la cuarta dimensión sería malo para tu salud, aparte de la conmoción de verte diferente en el espejo (las caras son sorprendentemente asimétricas). Muchas de las sustancias químicas cruciales de nuestro cuerpo, incluida la glucosa y la mayoría de los aminoácidos, poseen una cierta lateralidad. Las moléculas de ADN, por ejemplo, que adoptan la forma de doble hélice, giran siempre como una rosca de tornillo. Si se invirtiera la lateralidad de todas estas sustancias químicas, moriríamos rápidamente de malnutrición, porque muchos de los nutrientes esenciales de nuestra comida, de las plantas y los animales, tendrían una forma que no podríamos asimilar.

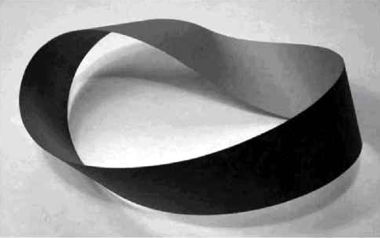

El interés matemático en una cuarta dimensión espacial surgió en la primera mitad del siglo XIX con la obra del alemán Ferdinand Möbius. Este es recordado sobre todo por su estudio de una figura que lleva su nombre, la banda de Möbius, y como pionero del campo conocido como topología. Fue él quien advirtió que, en una cuarta dimensión, una forma tridimensional podía rotarse hasta convertirse en su imagen especular. En la segunda mitad del siglo XIX, tres matemáticos sobresalieron como exploradores del nuevo ámbito de la geometría multidimensional: el suizo Ludwig Schlafli, el inglés Arthur Cayley y el alemán Bernhard Riemann.

Schlafli comenzaba su obra maestra, Theorie der Vielfachen Kontinuitat [Teoría de la continuidad múltiple], diciendo: «El tratado [...] es un intento de fundar y desarrollar una nueva rama de análisis que sería, por así decirlo, una geometría de n dimensiones, que contendría la geometría del plano y del espacio como casos especiales para ℵ = 2, 3». Proseguía describiendo análogos multidimensionales de polígonos y poliedros, que denominaba poliesquemas. Estos se conocen hoy habitualmente como politopos, un término acuñado por el matemático alemán Reinhold Hoppe e introducido entre los investigadores ingleses por Alicia Boole Stott, hija del matemático y lógico inglés George Boole, que ideó el álgebra booleana, y Mary Everest Boole, matemática autodidacta que escribió sobre el tema.

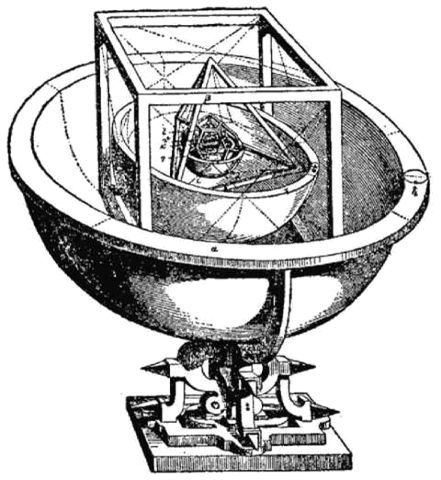

A Schlafli se le atribuye, asimismo, el descubrimiento de los equivalentes de dimensiones superiores de los sólidos platónicos. Un sólido platónico es una forma convexa (con todas las esquinas señalando hacia fuera) con caras poligonales regulares y con el mismo número de caras encontrándose en cada esquina. Son cinco en total: el cubo, el tetraedro, el octaedro, el dodecaedro (de 12 caras) y el icosaedro (de 20 caras). Los equivalentes tetradimensionales de los sólidos platónicos son los 4-politopos regulares (también llamados polícoros), que Schlafli descubrió que eran seis, nombrados en función de su número de celdas. El 4-politopo más simple es el 5-celda, que tiene 5 celdas tetraédricas, 10 caras triangulares, 10 aristas y 5 vértices, y es análogo al tetraedro. Luego está el 8-celda, o teseracto, y su «doble», el 16-celda, obtenido al reemplazar las celdas por vértices, las caras por aristas, y viceversa. El 16-celda tiene 16 celdas tetraédricas, 32 caras triangulares, 24 aristas y 8 vértices, y es el análogo tetradimensional del octaedro. Otros dos 4-politopos son el 120-celda, un análogo del dodecaedro, y el 600-celda, un análogo del icosaedro. Finalmente está el 24-celda, que tiene 24 celdas octaédricas y ningún equivalente tridimensional. Schlafli descubrió que curiosamente el número de politopos regulares convexos es el mismo en todas las dimensiones superiores: solo tres.

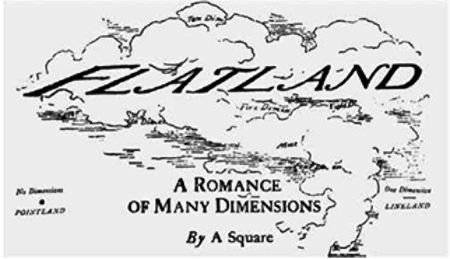

Mediante los trabajos de Cayley, Riemann y otros, los matemáticos aprendieron a hacer álgebra compleja en 4D y a ramificarse en geometrías multidimensionales que iban más allá de las reglas prescritas por Euclides. Pero lo que todavía no podían hacer era ver realmente en cuatro dimensiones. La pregunta era si alguien podría ser capaz de hacerlo. Este problema intrigaba al matemático y profesor británico, escritor de romances científicos, Charles Howard Hinton. Siendo veinteañero y treintañero, Hinton dio clases en dos colegios privados de Inglaterra: primero en el Cheltenham College, en Gloucestershire, y luego en la Uppingham School, en Rutland, donde tuvo como compañero —de hecho, el primer maestro de matemáticas de Uppingham— a Howard Candler, un amigo de Edwin Abbott. Fue durante este periodo, en 1884, cuando Abbott publicó su ya clásica novela satírica Flatland: A Romance of Many Dimensions o (Planilandia: una novela de muchas dimensiones).[3] Cuatro años antes, Hinton había escrito un artículo sobre espacios alternativos titulado «What Is the Fourth Dimension?» [¿Qué es la cuarta dimensión?], en el que planteaba la idea de que las partículas que se movían en tres dimensiones podían considerarse secciones transversales sucesivas de líneas y curvas que existen en cuatro dimensiones. Nosotros mismos podríamos ser en realidad seres tetradimensionales, «y nuestros estados sucesivos, el paso de estos a través del espacio tridimensional al que nuestra conciencia se halla confinada». No está claro el alcance de la relación entre Abbott y Hinton, pero desde luego ambos conocían mutuamente sus obras (como quedaba patente en sus escritos respectivos), y habrían tenido algún contacto, aunque solo fuera a través de su mutuo amigo y colega. Candler habría discutido sin duda con Abbott, el joven profesor de Uppingham que escribía y hablaba tan abiertamente sobre otras dimensiones.

Cubierta de la primera edición de Flatland, de Edwin Abbott.

Hinton no era nada convencional. En la época en la que daba clases en Inglaterra, se casó con Mary Ellen Boole, hija de los mencionados Mary Everest Boole (sobrina de George Everest, que dio nombre a la montaña más alta del planeta) y George Boole. Desgraciadamente, a los tres años de casados, Hinton contrajo matrimonio en secreto con otra mujer, Maud Florence, a la que había conocido en el Cheltenham College, con la que tuvo hijos gemelos. Probablemente, las actitudes de su padre, James Hinton, cirujano y líder de una secta dedicada a la poligamia y al amor libre, influyeron en el comportamiento de Charles. En cualquier caso, Hinton fue declarado culpable de bigamia por el Tribunal Penal Central y fue encarcelado durante varios días. Con su (primera) familia huyó luego a Japón, donde impartió clases durante varios años, antes de llegar a ser profesor de Matemáticas en la Universidad de Princeton. Allí, en 1897, diseñó una especie de arma de béisbol que, con la ayuda de cargas de pólvora, disparaba pelotas a velocidades de 65 a 110 kilómetros por hora. The New York Times, en su edición del 12 de marzo de ese año, la describía como «un cañón pesado, con un barril de unos 75 centímetros de longitud y con un fusil en la parte trasera». Su truco más ingenioso, el lanzamiento de bolas curvas, se logró con la ayuda de «dos barras curvadas, insertadas en el barril del cañón». Durante unas cuantas temporadas, los Princeton Nine lo utilizaron de vez en cuando, antes de abandonarlo como un peligro para la seguridad. No está claro si las heridas causadas por ese artefacto influyeron en el despido de Hinton del college, pero no le impidieron reintroducirlo en la Universidad de Minnesota, donde, en 1900, ocupó por un tiempo breve una plaza docente, antes de ingresar en el Observatorio Naval de Estados Unidos en Washington D. C.

La fascinación de Hinton por la cuarta dimensión, que se remonta a sus primeros días como profesor en Inglaterra, comenzó en una época en la que otros estaban escribiendo sobre el tema y especulaban con frecuencia sobre sus posibles vínculos con el espiritismo. En 1878, Friedrich Zollner, profesor de Astronomía en la Universidad de

Leipzig, publicó un artículo titulado «On Space of Four Dimensions» [Sobre el espacio de cuatro dimensiones] en The Quarterly Journal of Science (editado por el químico y prominente espiritista William Crookes). Zollner partía de unos sólidos cimientos matemáticos y mencionaba el influyente artículo de Bernhard Riemann «On the Hypotheses which Underlie Geometry» [Sobre las hipótesis subyacentes a la geometría], publicado en 1868, dos años después de la muerte de Riemann y catorce años después de la primera difusión de sus contenidos en una conferencia de Riemann, a la sazón todavía estudiante en la Universidad de Gotinga. Riemann desarrolló la idea, apuntada previamente por su supervisor en Gotinga, el gran Carl Gauss, de que el espacio tridimensional podía ser curvo (como puede serlo una superficie bidimensional como una esfera), y extendió esta noción de la curvatura del espacio a un número arbitrario de dimensiones. El resultado, conocido como geometría elíptica o riemanniana, constituiría más tarde una piedra angular de la teoría general de la relatividad de Albert Einstein. Zollner también tomó prestada la idea, descrita en un artículo de 1874 por el joven geómetra proyectivo Felix Klein, de que podían deshacerse los nudos y soltarse las anillas simplemente elevándolos a una cuarta dimensión y dándoles la vuelta. De esta forma, Zollner preparó el terreno para su explicación de cómo los espíritus, que a su juicio existían en un plano superior, podían llevar a cabo los diversos fenómenos — especialmente, los trucos de desatar nudos— de los que él había sido testigo en sesiones de espiritismo con el famoso médium Henry Slade (que resultó ser totalmente fraudulento). Al igual que Zollner, Hinton se inclinaba a pensar que el mero hábito de la percepción nos limitaba a un punto de vista tridimensional, y que una cuarta dimensión podía existir a nuestro alrededor y podría tornarse visible para nosotros si fuésemos capaces de entrenarnos para verla.

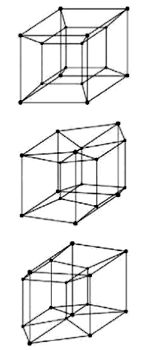

Aunque cuesta imaginar algo tetradimensional, es fácil hacer un bosquejo en 2D. Esto es especialmente cierto en el caso del equivalente tetradimensional del cubo, para el que Hinton acuñó el nombre de teseracto. Empecemos por dibujar dos cuadrados, ligeramente desplazados, y conectamos sus esquinas mediante líneas rectas. Esto puede visualizarse como un dibujo de un cubo en perspectiva, al separarse en nuestra imaginación los cuadrados en la tercera dimensión. A continuación, dibujemos dos cubos unidos por sus esquinas. Con la visión en 4D seríamos capaces de ver esto como dos cubos separados en la cuarta dimensión; de hecho, como una perspectiva de un teseracto. Desgraciadamente, las representaciones planas de objetos en 4D no nos ayudan demasiado a verlos como realmente son. Hinton se percató de que una estrategia más fructífera para adiestrar nuestra mente para ver en cuatro dimensiones podía basarse en modelos tridimensionales, que podrían rotarse para mostrar diferentes aspectos de una forma en 4D: al menos de ese modo solo estaríamos manejando una perspectiva de la cosa real, en lugar de una perspectiva de una perspectiva. Con tal propósito, desarrolló, a modo de como intrincada ayuda visual, un conjunto de cubos de madera de 2,5 centímetros de diferentes colores. Un conjunto completo de cubos de Hinton constaba de 81 cubos pintados de 16 colores diferentes, 27 «bloques» utilizados para representar, por analogía, cómo un objeto en 3D puede construirse en dos dimensiones, y 12 «cubos de catálogo» multicolores. Mediante elaboradas manipulaciones, descritas con detalle en su libro The Fourth Dimension [La cuarta dimensión], publicado por vez primera en 1904, fue capaz de representar las diversas secciones transversales de un teseracto y, luego, memorizando los cubos y sus numerosas orientaciones posibles, conseguir una ventana de acceso a este mundo de dimensión superior.

¿Aprendió realmente Hinton a crear en su cerebro imágenes tetradimensionales? Además de las direcciones familiares arriba y abajo, hacia delante y hacia atrás, y de lado a lado, ¿era capaz de ver kata y ana, sus nombres para las dos direcciones opuestas por la cuarta dimensión? Sin entrar en su cabeza, no podemos saberlo. Ciertamente, no estaba solo en la construcción de representaciones en 3D de formas en 4D. Le presentó sus cubos a su cuñada Alicia Boole Stott, quien llegaría a ser a su vez una intuitiva geómetra de la cuarta dimensión y experta en hacer modelos de cartulina de secciones transversales en 3D de politopos en 4D. La pregunta sigue siendo si por este medio la persona puede desarrollar una auténtica visión tetradimensional o solo la capacidad de comprender y apreciar la geometría de objetos de dimensiones superiores.

Rotación de un teseracto. (Arriba) La visión tradicional de un teseracto como un «cubo dentro de un cubo». (Centro) El teseracto ha rotado ligeramente. El cubo central ha comenzado a moverse y está en proceso de convertirse en el cubo derecho. (Abajo) El teseracto ha seguido rotando y el cubo central está ahora mucho más cerca de donde se hallaba originalmente el cubo derecho. Finalmente, el teseracto rota completamente hacia atrás, hacia su posición de partida. Lo importante es que el teseracto no se ha deformado en modo alguno. Antes bien, los cambios se deben a una variación en la perspectiva.

En cierto sentido, ser capaz de ver una dimensión extra es como ser capaz de ver un nuevo color, fuera de todas nuestras experiencias previas. El pintor impresionista francés Claude Monet sufrió una intervención quirúrgica en 1923, a sus ochenta y dos años, para quitarle el cristalino de su ojo izquierdo, que se había nublado totalmente por las cataratas. Posteriormente, los colores que decidía utilizar en su arte pasaron del predominio de los rojos, los marrones y otros tonos terrosos a los azules y violetas. Incluso volvió a pintar algunas de sus obras anteriores de suerte que, por ejemplo, lo que fueran nenúfares blancos adquirieron una tonalidad azulada; una indicación, según se ha dicho, de que ahora podía captar la región ultravioleta del espectro. Esta idea está respaldada por el hecho de que el cristalino del ojo bloquea las longitudes de onda inferiores a unos 390 nanómetros (milmillonésimas de metro) en el extremo de la gama del violeta, pese a que la retina posee el potencial de detectar longitudes de onda inferiores a unos 290 nanómetros, que corresponden al ultravioleta. Existen asimismo numerosas evidencias, en épocas más recientes, de niños pequeños y de personas mayores a quienes les falta el cristalino que son capaces de ver más allá del extremo violeta del espectro. Uno de los casos mejor documentados es el de un oficial e ingeniero retirado de las fuerzas aéreas de Colorado, Alek Komarnitsky, a quien le sustituyeron un cristalino natural afectado por las cataratas por otro artificial capaz de transmitir algo de luz ultravioleta. En 2011, Komarnitsky fue sometido a una serie de test que empleaban un monocromador en un laboratorio de Hewlett-Packard, en los que declaraba ser capaz de ver longitudes de onda inferiores a 350 nanómetros, como una tonalidad púrpura oscura, y alguna variación en el brillo incluso en el ultravioleta, por debajo de 340 nanómetros.

La mayoría de nosotros tenemos en nuestras retinas tres tipos de células cónicas, responsables de la visión del color. La mayoría de las personas daltónicas y otros muchos tipos de mamíferos, incluidos los perros y los monos del Nuevo Mundo, tienen solo dos, por lo que el número de matices diferentes de color que son capaces de ver está restringido a unos diez mil, comparados con el millón aproximado que podemos discernir el resto de nosotros. No obstante, los investigadores han descubierto casos raros de individuos con cuatro tipos funcionales de células cónicas. Según las estimaciones, estos tetracrómatas pueden distinguir casi cien millones más de matices de color de lo normal, aunque, como es natural que todos asumamos que vemos lo mismo, puede que solo lleguen a percatarse gradualmente de que poseen este superpoder, sin ninguna prueba especial.

El caso es que los humanos poseemos la capacidad, en circunstancias especiales, de ver cosas que exceden las experiencias normales que la mayoría de nosotros tenemos. Si algunos son capaces de ver el ultravioleta, o matices más sutiles de lo habitual, ¿por qué no la cuarta dimensión? Evidentemente, nuestro cerebro puede adaptarse al procesamiento de información sensorial que normalmente no estamos acostumbrados a recibir. Quizá pueda entrenarse para crear imágenes internas en 4D.

Hoy contamos con una enorme ventaja en nuestros esfuerzos por visualizar el mundo de cuatro dimensiones, gracias a que disponemos de los ordenadores y de otras tecnologías avanzadas. En la actualidad resulta fácil crear animaciones de un teseracto con malla de alambre, por ejemplo, para mostrar cómo varía su aspecto al rotarlo, visto en una pantalla plana. Nuestro cerebro sigue interpretando lo que vemos como el comportamiento extraño de un número de cubos interconectados, más que algo en 4D. Sin embargo, recibimos la impresión de que está sucediendo algo muy inusual que no puede explicarse en términos tridimensionales ordinarios. ¿Encierra la tecnología disponible, o la que pronto tendremos, la promesa de permitirnos experimentar directamente la cuarta dimensión?

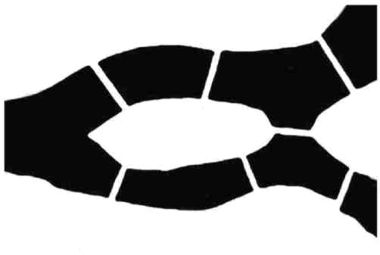

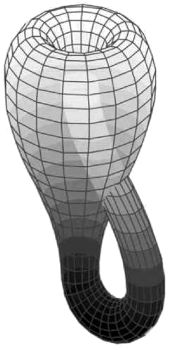

Una escuela de pensamiento sostiene que, pese a las afirmaciones de personas como Hinton, jamás podremos ver realmente en 4D porque el mundo que nos rodea es incesantemente tridimensional, nuestro cerebro es tridimensional y la evolución nos ha equipado para interpretar todas las sensaciones que recibimos como establecidas en un contexto en 3D. Ningún esfuerzo mental nos ayudará a trasladar a un plano de existencia diferente las partículas que constituyen nuestro cuerpo. Tampoco ningún truco de ingeniería nos permitirá construir una cosa en 4D, como un teseracto real. Esto no ha impedido que los escritores de ciencia ficción imaginen alguna combinación extraña de sucesos capaz de causar que un objeto o un sistema en 3D desarrollen espontáneamente una dimensión adicional. «And He Built a Crooked House» [«Y construyó una casa torcida»], de Robert Heinlein, publicado por primera vez por la revista Astounding Science Fiction en febrero de 1941, cuenta la historia de un ingenioso arquitecto que diseña una casa con ocho habitaciones cúbicas dispuestas como la red de un teseracto en 3D. Desgraciadamente, un terremoto sacude el edificio poco después de su finalización, y hace que se pliegue en un hipercubo real, con resultados desconcertantes para aquellos que se aventuran a cruzar su puerta. En «A Subway Named Möbius» [Un metropolitano llamado Möbius], de 1950, la red de metro de Boston se vuelve tan enrevesada que parte de ella salta a otra dimensión junto con un tren lleno de pasajeros, aunque al final todos ellos llegan sanos y salvos a las estaciones deseadas. Escrito por A. J. Deutsch, un astrónomo de Harvard (una de las paradas del sistema), juega con los temas de la banda de Möbius y la botella de Klein (una forma de una sola cara que únicamente puede existir en cuatro dimensiones).

También los artistas han tratado de captar en sus obras la esencia de las 4D. En su Manifiesto dimensionista de 1936, el poeta y teórico del arte húngaro Charles Tamkó Sirató proclamaba que la evolución artística había conducido a que «la literatura deja la línea y entra en el plano [...]. La pintura deja el plano y entra en el espacio [...] [y] la escultura abandona las formas inmóviles y cerradas». A continuación, decía Sirató, se produciría «la conquista artística del espacio tetradimensional, que hasta la fecha ha sido completamente ajeno al arte». La obra de Salvador Dalí Crucifixión (Corpus hypercubus), realizada en 1954, combina una representación clásica de Cristo con un teseracto desplegado. En una conferencia pronunciada en 2012 en el Museo Dalí, el geómetra Thomas Banchoff, que asesoraba a Dalí sobre temas matemáticos conectados con sus pinturas, explicó que el artista estaba tratando de utilizar «algo de un mundo tridimensional y llevarlo más allá [...]. El ejercicio del proyecto en su conjunto consistía en hacer dos perspectivas a la vez, dos cruces superpuestas». Dalí, al igual que los científicos decimonónicos que trataban de racionalizar el espiritismo en términos de existencia en algún espacio superior, empleó la idea de la cuarta dimensión para conectar lo religioso con lo físico.

Los físicos del siglo XXI tienen una nueva razón para interesarse por las dimensiones superiores: las teorías de cuerdas. En estas, las partículas subatómicas, tales como los electrones y los cuarks, no se tratan como puntos, sino como «cuerdas» vibrantes unidimensionales. Uno de los aspectos más extraños de las teorías de cuerdas es que, para que sean matemáticamente consistentes, requieren que el espacio y el tiempo en los que vivimos posean dimensiones adicionales. Una versión llamada teoría de supercuerdas requiere un total de 10 dimensiones, y una extensión de esta, conocida como teoría M, implica 11, en tanto que otro esquema, designado como teoría de cuerdas bosónicas, exige 26. Todas estas dimensiones adicionales se definen como compactificadas, lo cual significa que solo son significativas a una escala extraordinariamente pequeña. Puede que algún día aprendamos a ampliar o a desenroscar estas dimensiones, o bien a observarlas como realmente son. Pero, por ahora y en el futuro próximo, estamos atrapados en nuestras tres dimensiones macroscópicas del espacio. Así pues, persiste la pregunta: ¿existe algún modo de que podamos visualizar en nuestra mente cómo es realmente un objeto tetradimensional?

Nuestra experiencia visual del mundo surge de la entrada de la luz por nuestros ojos hasta alcanzar la retina y crear dos imágenes planas. Las células fotosensibles de la retina generan señales eléctricas, que viajan hasta la corteza visual del cerebro, donde tiene lugar una reconstrucción en 3D basada esencialmente en información en 2D. El hecho de tener dos ojos significa que vemos los objetos desde dos ángulos ligeramente diferentes, y el cerebro aprende, cuando somos pequeños, a interpretar estas diferencias de perspectiva y, a partir de ellas, construir una visión tridimensional. Pero incluso con un ojo cerrado, no pasamos de repente a interpretar las cosas como si fueran en 2D. A través de la visión monocular nos llegan todavía suficientes indicios de la perspectiva, la iluminación y el sombreado, que nos permiten añadir la profundidad en nuestra imaginación. Además, podemos desplazarnos o girar la cabeza para variar el ángulo de visión, y añadir a esta otros datos sensoriales, tales como el oído y el tacto, a fin de desarrollar la impresión en 3D. Somos tan expertos en añadir una dimensión de esta manera que, cuando vemos una película en una pantalla de televisión, incorporamos automáticamente la profundidad, incluso sin la ayuda de la tecnología en 3D.

La cuestión es la siguiente: si tenemos la capacidad de construir imágenes en 3D a partir de información en 2D, ¿podríamos utilizar la información visual en 3D para crear una impresión en nuestra mente de la cuarta dimensión? Nuestras retinas naturales son planas, pero la tecnología electrónica no tiene esta limitación. Empleando suficientes cámaras u otros dispositivos de recopilación de imágenes, colocados en diferentes lugares, podemos recoger información de tantas direcciones y perspectivas como deseemos. Por sí solo, sin embargo, esto no sería suficiente para formar la base de una visión en 4D. Un genuino observador tetradimensional que mirase algo en nuestro mundo sería capaz de ver simultáneamente todo lo que hay dentro de una cosa, además de su superficie tridimensional. Así, por ejemplo, si tuvieras artículos valiosos encerrados en una caja fuerte, un ser de 4D no solo vería todos los lados de la caja fuerte de un solo vistazo, sino también todo cuanto esta guardase en su interior (¡y sería capaz de meter la mano y sacar esas cosas si así lo decidiese!). Esto no se debería a que el ser en cuestión tuviese una especie de visión de rayos X que le permitiese ver a través de las paredes de la caja fuerte, sino simplemente a que tendría acceso a una dimensión adicional. Análogamente, nosotros tendríamos una visión privilegiada de un espacio cerrado en un mundo en 2D. Dibuja un cuadrado en un papel, que represente una caja fuerte bidimensional, con algunos artículos de joyería en su interior. Un planilandés, inserto en la superficie en 2D, solo podría ver una vista del exterior de su caja fuerte, una mera línea. Nosotros, al observar desde arriba la hoja de papel que era su mundo, seríamos capaces de ver las líneas que formaban las paredes de la caja fuerte y todos sus contenidos en un solo vistazo, y podríamos meter la mano y sacar las joyas de 2D. Al planilandés le desconcertaría el hecho de que pudiese observarse el interior de la caja fuerte o pudiesen sacarse sus contenidos, sin huecos en sus paredes. Pero, del mismo modo, un observador desde el punto de vista de una cuarta dimensión sería capaz de ver todas las partes, interiores y exteriores, de algo en 3D, tanto si se tratase de una casa como de una máquina o de un cuerpo humano.

Por consiguiente, una forma de crear la ilusión de la visión en 4D, si no la visión misma en 4D, sería tener una retina en 3D que constase de muchas capas, cada una de las cuales pudiese captar la imagen de una única sección transversal de un objeto en 3D. La información de esta retina artificial se suministraría entonces directamente al cerebro de una persona, de tal manera que esta tendría acceso simultáneo a todas las secciones transversales, exactamente como lo tendría un auténtico observador tetradimensional. El resultado no sería una imagen real en 4D, sino algo semejante a la visión que tendríamos de una cosa en 3D si pudiéramos verla mirando «hacia abajo» desde una cuarta dimensión, lo cual podría tener algunas aplicaciones muy valiosas. La primera parte de la tecnología requerida —la retina en 3D— ya está efectivamente disponible en la forma de los escáneres médicos, que construyen una imagen sólida de parte del cuerpo humano a partir de rodajas en 2D. La segunda parte se halla por el momento fuera de nuestro alcance, pues todavía no disponemos de interfaces cerebro-ordenador suficientemente avanzadas, ni de los conocimientos neurológicos precisos para alimentar la corteza visual, de manera que el cerebro pueda construir una imagen total de todas las perspectivas simultáneas de la cosa observada. No obstante, puede que el nacimiento del «humano 2.0» no se haga esperar más de un par de décadas. El futurista Ray Kurzweil cree que en la década de 2030 estaremos mejorando nuestro cerebro con nanobots, diminutos implantes robóticos que conectan con redes informáticas basadas en la nube. En 2017, el empresario tecnológico Elon Musk lanzó Neuralink, una empresa dedicada a fusionar el cerebro humano con la inteligencia artificial mediante implantes corticales.

Además de poner en marcha la tecnología y establecer las conexiones adecuadas con el cerebro, para poder ver con una retina en 3D, una persona tendría que experimentar presumiblemente un largo proceso de aprender a crear imágenes mentales de esta forma radicalmente novedosa. Ahora bien, semejante capacidad podría revelarse inapreciable para quienes trabajan en áreas tales como el diagnóstico médico, la cirugía, la investigación científica y la educación.

El paso más difícil, consistente en hacer posible que una persona experimente la visión de una cosa en cuatro dimensiones, solo podría darse con simulaciones, ya que los objetos en 4D no existen físicamente en nuestro mundo. Puede que la simulación informática de un teseracto, el objeto utilizado por Hinton, fuese el lugar más simple para comenzar. Cuando observamos un modelo en 3D de un teseracto, vemos únicamente un aspecto o proyección de la auténtica forma tetradimensional. Captar la cosa en todo su esplendor en 4D implicaría combinar múltiples proyecciones, perfecta y simultáneamente, en las zonas del procesamiento visual de nuestro cerebro. Una vez más, incluso con toda la tecnología necesaria y con todas las conexiones neuronales a punto, podría ser preciso un periodo de entrenamiento y práctica para conseguir el efecto deseado: hacer que «salte» la cuarta dimensión, por así decirlo. Pero en principio no hay razón para que esto no funcione. Fusionando mentalmente, con la ayuda de la tecnología informática, un gran número de secciones en 3D de una forma en 4D, podemos confiar en saber cómo es la visión en 4D.

Las matemáticas nos permiten explorar en profundidad lo que nuestra imaginación por sí sola es incapaz de penetrar. Nos conducen más allá de las tres dimensiones que captamos de manera natural, por lo que podemos conocer con gran detalle las propiedades de las cosas en 4D y más allá. Eso nos permite seguir adelante con la ciencia que necesitamos hacer para comprender el universo, tanto en el plano submicroscópico como en el cósmico. Pero también abre la posibilidad de desarrollar los medios para visualizar por nosotros mismos dimensiones más allá de la tercera.

Tengo la impresión de que buena parte de la vida está determinada por la pura aleatoriedad.

SIDNEY POITIER

Muchas cosas que suceden en el mundo parecen totalmente impredecibles. Hablamos de «casos de fuerza mayor», de «estar en el lugar equivocado en el momento equivocado» o de «pura suerte». La casualidad y la buena o mala suerte parecen dictar buena parte de lo que acontece a nuestro alrededor. Gracias a las matemáticas, sin embargo, disponemos de una herramienta para ver a través de esta niebla de aparente confusión y detectar un cierto orden en lo que, por lo demás, se antoja un derroche de aleatoriedad.

Baraja a conciencia las cartas y lo más probable es que hayas hecho algo único. Casi con certeza, nadie en la historia del mundo habrá logrado jamás disponer la baraja en ese orden particular. La razón es simple: 52 cartas diferentes pueden organizarse de 52 × 51 × 50 × 49 × ... × 3 × 2 × 1 formas. Eso arroja un total de aproximadamente 8 × 1067, es decir, 80 millones de billones de billones de billones de billones de billones de disposiciones diferentes de las cartas. Si todas las personas actualmente vivas hubieran mezclado las cartas de una baraja una vez por segundo desde el comienzo del universo, eso equivaldría tan solo a unas 3 × 1027 barajadas, que es un número increíblemente pequeño en comparación.

Sin embargo, se dice que ha habido casos en los que se ha mezclado una baraja y se ha obtenido exactamente el orden de partida. En realidad, esto es mucho más probable que la probabilidad de 1 entre 8 × 1067 de conseguir cualquier otra ordenación. Cuando se saca por primera vez de su envoltorio, una baraja tiene todos los palos, corazones, tréboles, diamantes y picas (aunque no necesariamente en ese orden), organizados en as, dos, tres..., jota, reina y rey. Si el repartidor de cartas es tan experto como para ser capaz de mezclarlas por hojeo sin error —dividiendo en dos la baraja e intercalando exactamente las cartas—, el mazo puede acabar volviendo a la disposición inicial en tan solo ocho barajadas perfectas. Por eso, al estrenar baraja, los casinos utilizan a menudo la técnica de barajada de los niños, consistente en esparcir las cartas sobre la mesa y revolverlas caprichosamente durante algún tiempo. Para lograr un nivel similar de desorden serían precisas al menos siete mezclas por hojeo buenas, pero imperfectas. El resultado sería entonces bastante aleatorio; en otras palabras, al mostrar cualquier carta de la baraja, la probabilidad de ser capaz de predecir la carta siguiente, empleando cualquier medio lícito disponible, sería muy próxima a 1 entre 51. Ahora bien, ¿sería verdaderamente aleatoria la baraja? ¿Qué es la aleatoriedad? Y ¿es posible que algo sea completamente aleatorio?

Falanges de animal, empleadas en juegos como las tabas.

La noción de aleatoriedad o impredecibilidad total es tan antigua como la civilización y probablemente mucho más. Las monedas al aire y los dados lanzados nos vienen enseguida a la mente como formas usadas habitualmente en la actualidad para decidir resultados «de manera aleatoria». En la Grecia antigua lanzaban astrágalos, o tabas de cabras y ovejas, en sus juegos de azar. Más tarde emplearían también dados de forma regular, aunque no se sabe con certeza dónde se inventaron estos. Se cree que los egipcios habrían usado los dados en su juego del senet, hace cinco mil años. El Rigveda, un texto védico en sánscrito que data aproximadamente del año 1500 a. C., también menciona los dados, y se han encontrado auténticos juegos de dados en una tumba mesopotámica que se remonta al siglo XXIV a. C. Las téseras griegas eran cúbicas y tenían número en cada cara del 1 al 6, pero solo en la época romana aparecieron dados como los que utilizamos en la actualidad, en los que los valores en las caras opuestas suman siete.

La aleatoriedad tardó mucho tiempo en atraer la atención de los matemáticos. Hasta entonces tendía a atribuirse al ámbito religioso. Tanto en las filosofías orientales como en las occidentales, se consideraba que el resultado de los acontecimientos estaba en manos de los dioses o de alguna fuerza sobrenatural equivalente. De China vino el I Ching (Clásico de los cambios), un sistema de adivinación enraizado en la interpretación de 64 hexagramas diferentes. Algunos cristianos basaban su toma de decisiones en el método bastante más simple de sacar pajitas del interior de una Biblia. Aunque estas creencias tempranas eran fascinantes, tuvieron el lamentable efecto de retrasar cualquier tentativa racional de afrontar la aleatoriedad. Después de todo, si las eventualidades están determinadas en última instancia en un nivel que excede la comprensión humana, ¿por qué molestarse en intentar analizar lógicamente por qué algo sucede de esta o aquella forma? ¿Por qué tratar de averiguar si existen leyes naturales que gobiernen la probabilidad de los resultados?

Cuesta creer que quienes utilizaban los astrágalos o los dados en la Antigüedad griega o romana no tuvieran al menos alguna idea intuitiva de la probabilidad de ciertos resultados. Habitualmente, allí donde intervienen el dinero u otros beneficios materiales, los jugadores y otras partes interesadas captan hasta los pormenores de los juegos. Por tanto, parece probable que la apreciación intuitiva de las probabilidades se remonte milenios atrás. No obstante, el estudio académico de la aleatoriedad y la probabilidad tuvo que esperar hasta el siglo XVII y el Renacimiento tardío para despegar. Encabezando los avances de la época estaban el matemático y filósofo francés Blaise Pascal, que era asimismo un jansenista devoto, y su compatriota Pierre de Fermat. Estos dos grandes pensadores abordaron un problema que, de forma simplificada, puede enunciarse así: supongamos que dos personas están jugando a lanzar una moneda al aire, y el primero que consiga tres puntos gana un buen puñado de dinero. Pero el juego se interrumpe cuando una persona gana por dos puntos a uno. Si se entrega el dinero en esta fase, ¿cuál es la asignación más justa? Antes de Pascal y Fermat, otros se habían planteado este problema y habían propuesto diversas soluciones posibles. Tal vez el dinero debería dividirse en partes iguales, ya que el juego se había interrumpido a mitad del camino y no podía conocerse el resultado final. Pero esto parecía injusto para la persona que tenía dos puntos, a quien sin duda había que reconocerle de algún modo el mérito de ir por delante. Por otra parte, la sugerencia de entregarle todo el dinero a la persona que iba ganando parecía injusta para el rival que tenía un punto, pues todavía habría tenido la oportunidad de ganar si el juego hubiera proseguido. Una tercera posibilidad podría ser dividir el dinero en función del número de puntos ganados, de modo que el jugador con dos puntos conseguiría dos tercios del premio y el contrincante un tercio. A primera vista, esto parece justo, pero plantea un problema. Supongamos que la puntuación fuese de uno a cero en el momento en que se interrumpió el juego. En ese caso, si se aplicase la misma regla, la persona con un punto recibiría todo el dinero, en tanto que la otra persona, que aún podría haber ganado si el juego llegase a su conclusión, no recibiría nada.

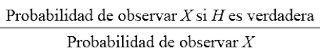

Pascal y Fermat encontraron una solución mejor y, al mismo tiempo, inauguraron una nueva rama de las matemáticas. Calcularon la probabilidad de que ganase cada persona. Para que ganase la persona que tenía un punto, tendría que conseguir otros dos puntos consecutivos, lo cual tiene una probabilidad de veces ½ o ¼. Por consiguiente, debería recibir una cuarta parte del dinero. El resto debería ser para su contrincante. Exactamente el mismo método puede aplicarse a cualquier otro problema de este tipo, aunque, naturalmente, los cálculos pueden complicarse más.

Al estudiar este problema, Pascal y Fermat habían dado con un concepto conocido como valor esperado. En un juego de azar, o en cualquier situación en la que esté implicada la probabilidad, el valor esperado es la media de lo que cabe esperar ganar de manera razonable. Por ejemplo, supongamos que juegas a un juego en el que tiras un dado y ganas 6 euros si sacas un 3. Este juego tiene un valor esperado de 1 euro, porque existe una probabilidad de 1 entre 6 de sacar un 3, y 1/6 parte del dinero del premio es 1 euro. Si jugases muchas veces, ganarías por término medio 1 euro por cada partida jugada. Después de jugar 1.000 veces, por ejemplo, la cantidad media que ganarías sería de 1.000 euros, por lo que, si pagaras 1 euro antes de jugar cada vez, acabarías a la par. Observa que aun cuando 1 euro sea el valor esperado, no siempre es posible ganar exactamente 1 euro en este juego. No siempre es posible ganar el valor esperado exactamente en un juego, pero, si se juega repetidamente, el valor esperado es lo que esperarías ganar por término medio.

Una lotería tiene por lo general un valor esperado negativo, por lo que, desde un punto de vista racional, es una mala idea jugar (con ciertos botes acumulados, dependiendo de la lotería, esta puede tener ocasionalmente un valor esperado positivo).

Lo mismo sucede con los juegos de casino, por una razón evidente: el casino es un negocio que trata de obtener beneficios. Ocasionalmente, sin embargo, las cosas pueden salir mal debido a un ligero error de cálculo. En una ocasión, un casino cambió el premio en un solo resultado en el blackjack, tornando accidentalmente positivo el valor esperado, y perdió una fortuna en unas pocas horas. Para su subsistencia, los casinos dependen del conocimiento matemático profundo de la teoría de la probabilidad.

A veces ocurren coincidencias, que parecen tan improbables que la gente se pregunta si está sucediendo algo raro. Una persona puede ganar dos veces la lotería nacional, o pueden salir los mismos números en diferentes sorteos. Con frecuencia, los medios de comunicación se abalanzan sobre tales historias y magnifican en exceso su aparentemente alta improbabilidad. No obstante, lo cierto es que a la mayoría de nosotros no se nos da muy bien calcular la probabilidad de semejantes acontecimientos, pues partimos de ciertas ideas erróneas. Por considerar el caso de alguien que ha ganado dos veces la misma lotería, es natural personalizar el problema y pensar: «¿Qué posibilidades tengo yo de ganar la lotería dos veces?». Obviamente, la respuesta es fantásticamente pequeña. Sin embargo, las raras personas que ganan dos veces tienden a haber jugado con regularidad a lo largo de varios años, por lo que dos premios durante ese periodo suponen algo menos extraordinario. Y, lo que es más importante, hay que tener presente cuánta gente juega a la lotería. La inmensa mayoría jamás ganará el premio gordo ni una sola vez, ni mucho menos dos. Pero con todos esos jugadores, se vuelve mucho menos asombroso que alguien, en algún lugar, se lleve el premio en dos ocasiones.

Puede parecer contraintuitivo, pero eso se debe a que tendemos a considerarlo desde una perspectiva personal. Por supuesto, es extremadamente improbable que tú ganes el premio gordo dos veces. Ahora bien, al considerar la probabilidad de que alguien lo haga, hemos de multiplicar las posibilidades por el número de personas que juegan a la lotería, lo cual aumenta enormemente esas probabilidades, así como el número de formas en las que pueden ganar dos veces la lotería (aproximadamente la mitad del cuadrado del número de veces que juegan a la lotería). Después de todo esto, parecen mucho más razonables las probabilidades de que alguien, en algún lugar, gane el premio gordo en dos ocasiones.