En busca del gato de Schrödinger

John Gribbin

Mi familiaridad con la teoría cuántica se remonta a mis tiempos de estudiante cuando descubrí la fórmula mágica según la cual el modelo atómico de capas de electrones explicaba la tabla periódica de los elementos y, virtualmente, toda la química con la que me había enfrentado a lo largo de muchas lecciones aburridas. Completando mi propio descubrimiento mediante la ayuda de libros de biblioteca catalogados de «demasiado avanzados» para mi modesto nivel académico, tomé conciencia inmediatamente de la maravillosa simplicidad de la explicación cuántica de los espectros atómicos, y experimenté por vez primera la sensación de que las mejores cosas en ciencia eran a la vez bellas y simples, un hecho que todos los profesores ocultan a sus estudiantes, por casualidad o a propósito. Me sentí como el personaje de The Search, de C. P. Snow, que yo leí mucho más tarde y que descubrió el mismo hecho: Vi una mezcla de hechos fortuitos alinearse ordenadamente… «Sin embargo, es verdad», me dije. «Es hermoso. Y es verdad.» (Edición de Macmillan, 1963, pág. 27.)En parte, como resultado de este descubrimiento, decidí estudiar física en la Universidad de Sussex en Brighton. Pero allí, la simplicidad y belleza de las ideas subyacentes quedaban camufladas entre una gran cantidad de detalles y de recetas matemáticas útiles para resolver problemas concretos con la ayuda de las ecuaciones de la mecánica cuántica. La aplicación de estas ideas al mundo de la física cotidiana parecía aportar tanta relevancia a la verdad y a la belleza subyacentes como la que aporta el pilotar un 747 al vuelo sin motor; y aunque la fuerza del impacto inicial siguió influyendo en mi carrera, durante un largo período de tiempo desprecié el mundo cuántico y me dediqué a explorar otros cotos científicos.

Mi interés inicial se reavivó gracias a una combinación de factores. A finales de los años 1970 y principios de los 1980, comenzaron a aparecer libros y artículos que pretendían, con distinto éxito, introducir a una audiencia no científica en el extraño mundo cuántico. Algunas de estas denominadas «divulgaciones» estaban tan escandalosamente lejos de la realidad que no me podía imaginar a ningún lector descubriendo la verdad y la belleza de la ciencia a través de su lectura, y comencé a sentirme atraído por realizar esa misión de forma adecuada. Por esa época llegaban noticias de continuas series de experimentos que demostraban la realidad de algunas de las más extrañas peculiaridades de la teoría cuántica, y esas noticias me estimulaban para retomar a las bibliotecas y refrescar mis conocimientos sobre aquellas extrañas ideas. Finalmente, unas Navidades fui requerido por la BBC para tomar parte en un programa de radio como una especie de contrapeso científico a Malcolm Muggeridge, que había anunciado recientemente su conversión a la fe católica y era el invitado principal al programa. Después de acabar su discurso, haciendo énfasis en los misterios de la cristiandad, se dirigió a mí y dijo: «Pero aquí está el hombre que conoce todas las respuestas, o que tiene la pretensión de conocer todas las respuestas.» En el limitado tiempo de que disponía me dediqué a responder cortésmente, destacando que la ciencia no pretende estar en posesión de todas las respuestas, y que es la religión, y no la ciencia, la que basa el conocimiento de la verdad en la convicción y en la fe absolutas. «Yo no creo nada», dije, y trataba de desarrollar esta filosofía cuando el Drograma llegó a su fin. Durante la época vacacional fui muy felicitado por amigos y conocidos por el eco de aquellas palabras y pasé horas explicando que mi falta absoluta de fe en cualquier cosa no me impedía llevar una vida normal en la que hacía uso de hipótesis de trabajo tan razonables como lo es la suposición de que el Sol no desaparecerá durante la noche.

El proceso de sedimentación de mis ideas acerca de lo que es la ciencia implicó una profunda revisión de la realidad básica —o irrealidad— del mundo cuántico, lo suficiente como para convencerme de que realmente estaba preparado para escribir este libro. Mientras preparaba el libro, sometí a prueba algunos de los más sutiles argumentos de mi contribución científica regular a un programa de radio dirigido por Tommy Vance y emitido por la British Forces Broadcasting Service; las cuestiones planteadas por Tom pronto descubrieron ciertas deficiencias en mi presentación, lo que supuso una mejor organización de mis ideas. La principal fuente de material de referencia usado en la preparación del libro fue la biblioteca de la Universidad de Sussex, que debe poseer una de las mejores colecciones existentes de libros sobre la teoría cuántica, y varias referencias más oscuras me fueron proporcionadas por Mandy Caplin, del New Scientist, quien posee un importante sistema de mensajes por télex, mientras Christine Sutton corrigió algunos de mis errores sobre la física de las partículas elementales y la teoría de campos. Mi esposa no sólo me proporcionó apoyo esencial en la faceta literaria y de organización del material, sino que limó muchas de las asperezas e incoherencias que quedaban incluso después de que las explicaciones hubieran pasado la criba que suponía la ignorancia inteligente de Tommy Vance.

Cualquier alabanza sobre las buenas cualidades de este libro debe ser dirigida a los textos de química «avanzada» que encontré en la biblioteca del Condado de Kent a los dieciséis años, cuyos títulos ya no recuerdo; a los descaminados «divulgadores» y publicistas de las ideas cuánticas que me convencieron de que yo lo haría mejor; a Malcolm Muggeridge y a la BBC; a la biblioteca de la Universidad de Sussex; a Tommy Vance y a la BFBS; a Mandy Caplin; a Christine Sutton y especialmente a Min. Cualquier queja por las deficiencias que pudieran quedar en el texto debe estar dirigida contra mí, por supuesto. Si todos los libros y artículos escritos sobre la teoría de la relatividad se colocaran uno tras otro, probablemente llegarían de aquí a la Luna. «Todo el mundo» sabe que la teoría de la relatividad de Einstein es la mayor conquista de la ciencia del siglo veinte, y «todo el mundo» está equivocado. Sin embargo, si se reunieran todos los libros y artículos escritos sobre teoría cuántica apenas cubrirían una mesa. Ello no significa que la teoría cuántica sea ignorada fuera de los ambientes académicos. Ciertamente, la mecánica cuántica se ha hecho altamente popular en algunos aspectos, siendo invocada para explicar fenómenos tales como la telepatía y el doblado de cucharas, y ha proporcionado una fructífera fuente de ideas para diferentes historias de ciencia ficción. La mecánica cuántica se identifica en la mitología popular, en la medida que resulta identificada, con el ocultismo y la percepción extrasensorial, como una rama extraña y esotérica de la ciencia que nadie entiende y que nadie utiliza.

Este libro se ha escrito para combatir esa actitud hacia la que es, de hecho, el área más fundamental e importante del estudio científico. El libro debe su génesis a varios factores que concurrieron en el verano de 1982. En primer lugar, yo acababa de escribir un libro sobre la relatividad, Spacewarps, y se me ocurrió que podría ser conveniente acometer la desmitificación de la otra gran rama de la ciencia del siglo veinte. En segundo lugar, me sentía cada vez más irritado por los errores asociados al nombre de la teoría cuántica entre algunos de los no científicos. El excelente libro de Fritjof Capra, The Tao of Physics, había generado multitud de imitadores que no habían entendido ni la física ni el taoísmo pero que sospechaban que podían ganar una buena suma de dinero ligando ciencia occidental con filosofía oriental. Finalmente, en agosto de 1982, noticias provenientes de París informaban que un equipo había llevado a cabo con éxito un test crucial que confirmaba —a los que aún lo dudaban— la precisión de la imagen mecánico-cuántica del mundo.

No se busque aquí ningún misticismo oriental, doblado de cucharas o percepción extrasensorial, sino la verdadera historia de la mecánica cuántica, una verdad más extraña que cualquier ficción. La ciencia es tal que no necesita ataviarse con el pobre ropaje de ninguna filosofía particular, ya que está llena de encantos propios, misterios y sorpresas. La cuestión que este libro plantea es: «¿Qué es la realidad?» La respuesta puede ser sorprendente o incluso increíble, pero pondrá de manifiesto cómo ve el mundo la ciencia contemporánea.Nada es real

El gato que aparece en el título es un animal mítico, pero Schrödinger fue una persona real. Erwin Schrödinger fue un científico alemán que contribuyó al desarrollo, hacia la mitad de la década de los años 20, de las ecuaciones de una rama de la ciencia actualmente conocida como mecánica cuántica. «Rama de la ciencia» puede resultar una expresión incorrecta, ya que la mecánica cuántica proporciona el soporte fundamental de toda la ciencia moderna. Sus ecuaciones describen el comportamiento de objetos minúsculos, del tamaño del átomo o incluso menos, y proporcionan la única explicación del mundo de «lo muy pequeño». Sin estas ecuaciones, los físicos no habrían sido capaces de diseñar centrales o bombas nucleares, construir láseres ni explicar por qué el Sol se mantiene caliente. Sin la mecánica cuántica, la química estaría aún en una época oscura y no existiría la biología molecular, la comprensión del DNA y la ingeniería genética.

La teoría cuántica representa la conquista más grande de la ciencia, mucho más significativa y directa desde el punto de vista práctico que la teoría de la relatividad. Y, además, hace algunas predicciones muy extrañas. El mundo de la mecánica cuántica es, en verdad, tan extraño que incluso Albert Einstein lo encontró incomprensible, y se negó a aceptar todas las implicaciones de la teoría desarrollada por Schrödinger y sus colegas. A Einstein, como a muchos otros científicos, le resultó más cómodo creer que las ecuaciones de la mecánica cuántica simplemente representan una especie de truco matemático que, si bien proporciona una guía de trabajo razonable en el estudio del comportamiento de partículas atómicas y subatómicas, oculta en realidad alguna verdad más profunda que se ajusta mejor a nuestro sentido cotidiano de la realidad. Lo que la mecánica cuántica dice es que nada es real y que no podemos decir nada sobre lo que las cosas están haciendo cuando no las estamos observando. El mítico gato de Schrödinger se utilizó para señalar las diferencias entre el mundo cuántico y el mundo claro de cada día.

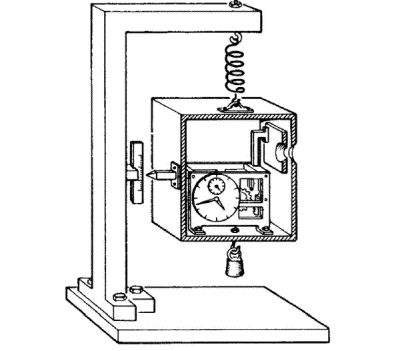

En el mundo de la mecánica cuántica, las leyes habituales de la física dejan de funcionar. En su lugar, los acontecimientos pasan a estar gobernados por probabilidades. Un átomo radiactivo, por ejemplo, puede desintegrarse emitiendo un electrón o puede no hacerlo. Es posible montar un experimento de forma que exista una probabilidad exacta del 50 % de que uno de los átomos de una muestra de material radiactivo se desintegre en un cierto tiempo y que un detector registre la desintegración si se produce. Schrödinger, tan preocupado como Einstein por las implicaciones de la teoría cuántica, trató de poner de manifiesto el carácter absurdo de tales implicaciones imaginando ese dispositivo experimental en una sala cerrada, o en una caja, dentro de la cual hay un gato vivo y un frasco con veneno, preparado todo de tal forma que si ocurre la desintegración radiactiva el recipiente del veneno se rompe y el gato muere. En el mundo actual existe un 50 % de probabilidades de que el gato resulte muerto, y sin mirar dentro de la caja podemos decir, tranquilamente, que el gato estará vivo o muerto. Pero ahora nos topamos con lo extraño del mundo cuántico. Como resultado de la teoría, ninguna de las dos posibilidades abiertas al material radiactivo, y por tanto al gato, tiene realidad salvo que sea observada. La desintegración atómica ni ha ocurrido ni ha dejado de ocurrir; el gato, ni ha muerto ni ha dejado de morir en tanto no miremos dentro de la caja para ver lo que ha pasado. Los teóricos que aceptan la versión ortodoxa de la mecánica cuántica dicen que el gato existe en cierto estado indeterminado, ni vivo ni muerto, hasta que un observador mira dentro de la caja para ver cómo marchan las cosas. Nada es real salvo si se observa.

La idea resultaba un anatema para Einstein, entre otros. «Dios no juega a los dados», dijo refiriéndose a la teoría según la cual el mundo está gobernado por la acumulación de resultados de naturaleza esencialmente aleatoria que se dan al nivel cuántico. En cuanto a la irrealidad del estado del gato de Schrödinger, él la eliminó, suponiendo que debe existir algún mecanismo subyacente que hace posible la genuina y fundamental realidad de las cosas. Einstein pasó muchos años tratando de encontrar pruebas que revelaran esta realidad subyacente, pero murió antes de que fuera realmente posible llevar a cabo un experimento de esta clase. Quizás es mejor que no haya vivido para ver el destino de la línea de pensamiento que él inició.

En el verano de 1982, en la Universidad de París-Sur, en Francia, un equipo encabezado por Alain Aspect completó una serie de experimentos diseñados para detectar la realidad subyacente del mundo irreal del «cuanto». A este mecanismo fundamental se le ha denominado «variables ocultas», y el experimento se refería al comportamiento de dos fotones (partículas de luz) viajando en direcciones opuestas desde una misma fuente. Está descrito con detalle en el capítulo diez, pero esencialmente puede considerarse como una prueba de realidad. Los dos fotones de la misma fuente pueden observarse mediante dos detectores que miden una propiedad llamada polarización. De acuerdo con la teoría cuántica, esta propiedad no existe hasta que se mide. Según el modelo de las variables ocultas, cada fotón tiene una polarización «real» desde el momento de su creación. Como los dos fotones se emiten simultáneamente, sus polarizaciones están correlacionadas. Pero la naturaleza de dicha correlación, que es lo que se mide, resulta diferente según se adopte uno u otro punto de vista.

Los resultados de este crucial experimento no presentan ninguna ambigüedad. El tipo de correlación predicho por el modelo de variables ocultas no ha aparecido; por el contrario, se ha dado la correlación predicha por la teoría cuántica, y aún más, también como preveía la teoría cuántica, las medidas efectuadas en uno de los fotones tienen un efecto instantáneo sobre la naturaleza del otro fotón. Alguna interacción los liga inexorablemente, incluso aunque se separen a la velocidad de la luz (la teoría de la relatividad asegura que ninguna señal puede viajar a más velocidad que la de la luz). Los experimentos demuestran que no existe una realidad subyacente. La palabra realidad, en el sentido usual, no es un concepto utilizable para estudiar el comportamiento de las partículas que integran el universo; al mismo tiempo, dichas partículas parecen formar parte de algún todo indivisible y cada una acusa lo que acontece a las restantes.

La búsqueda del gato de Schrödinger ha sido la búsqueda de la realidad cuántica. De este breve resumen, parece evidente que la búsqueda ha sido fructífera, ya que no existe realidad en el sentido usual de la palabra. Pero éste no es en absoluto el final de la historia, y la búsqueda del gato de Schrödinger puede llevamos a una nueva forma de entender y valorar la realidad que trasciende, y que incluye a la interpretación convencional de la mecánica cuántica. El camino es largo, no obstante, y comienza con un científico que probablemente se habría sentido aún más horrorizado que el propio Einstein si hubiese podido conocer las respuestas que hoy se dan a las cuestiones que él se propuso resolver. Isaac Newton, estudiando la naturaleza de la luz hace tres siglos, puede que no fuera consciente de que ya estaba en el camino que conducía al gato de Schrödinger.

Parte 1

El cuanto

«Todo aquel que no queda fuertemente impresionado por la teoría cuántica es porque no la ha entendido.»

NIELS BOHR

1885-1962

Las ideas de Newton sobre la luz tienen mucho que ver con sus ideas sobre el comportamiento de los cuerpos sólidos y sobre las órbitas de los planetas. Él fue consciente de que nuestras experiencias cotidianas sobre el comportamiento de los objetos pueden ser confusas y que un objeto, una partícula libre de toda influencia exterior, puede comportarse de forma muy diferente a como lo hace sobre la superficie de la Tierra. Aquí, nuestra experiencia cotidiana nos dice que las cosas tienden a permanecer en un sitio concreto, salvo que se actúe sobre ellas, y que, una vez cesa la influencia, pronto acaba el movimiento. Entonces, ¿por qué objetos tales como los planetas o la Luna no cesan de moverse en sus órbitas? ¿Hay algo que los mantiene? Nada de eso. Son los planetas los que permanecen en un estado natural, libres de influencias externas, y son los objetos sobre la superficie de la Tierra los que sufren su influencia. Si hacemos deslizar un bolígrafo sobre la mesa, a esa acción se opone el rozamiento del bolígrafo contra la mesa, y ésa es la causa de que se detenga cuando deja de actuar. Si no hubiera fricción, el bolígrafo se mantendría en movimiento. Ésta es la primera ley de Newton: todo cuerpo permanece en reposo, o se mueve con velocidad constante, salvo que alguna fuerza exterior actúe sobre él. La segunda ley nos dice qué efecto tiene sobre un objeto la actuación de una fuerza externa. Una fuerza de este tipo cambia la velocidad del objeto, y un cambio en la velocidad se llama aceleración; si se divide la fuerza entre la masa del objeto, el resultado es la aceleración producida sobre el cuerpo por aquella fuerza. Usualmente, esta segunda ley se expresa de forma ligeramente distinta: la fuerza es igual a masa por la aceleración. Y la tercera ley de Newton explica cómo reaccionan los objetos ante acciones externas: para cada acción hay una reacción igual y opuesta. Si se golpea una pelota de tenis con una raqueta, la fuerza con que la raqueta impulsa a la pelota es exactamente contrastada por una fuerza igual y contraria que actúa sobre la raqueta; el bolígrafo sobre la mesa sometido a la gravedad sufre una reacción igual pero dirigida hacia arriba por parte del pupitre; la fuerza del proceso explosivo de los gases de la cámara de combustión en un cohete produce una fuerza de reacción igual y contraria sobre el propio cohete, que le impulsa en la dirección opuesta.

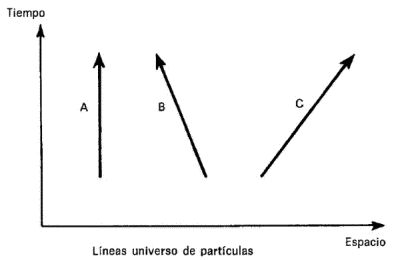

Estas leyes, junto con la ley de Newton sobre la gravedad, sirvieron para explicar las órbitas de los planetas alrededor del Sol y la de la Luna alrededor de la Tierra. Cuando se tuvo en cuenta el rozamiento, estas leyes también permitieron explicar el comportamiento de objetos sobre la superficie terrestre y formaron la base de la mecánica. Pero pusieron de manifiesto implicaciones filosóficas: de acuerdo con las leyes de Newton, el comportamiento de una partícula podía ser predicho exactamente a partir de sus interacciones con otras partículas y de las fuerzas que actúan sobre ella. Si alguna vez fuera posible conocer la posición y la velocidad de cada partícula en el universo, entonces sería posible predecir con absoluta exactitud el futuro de cada partícula y, por tanto, el futuro del universo. ¿Significa esto que el universo funciona como un mecanismo de relojería, construido y mantenido en movimiento por el Creador, y sometido a una evolución completamente predictible? La mecánica clásica de Newton proporciona soporte completo a esta visión determinista del universo, una imagen que deja poco sitio para la libertad humana. ¿Puede ser realmente que todos seamos muñecos que seguimos a lo largo de la vida nuestras propias trazas prefijadas, sin ninguna posibilidad real de opción? La mayoría de los científicos aceptaban de buen grado dejar el debate de la cuestión en manos de los filósofos. Pero el problema volvió a aparecer, y con mucha más fuerza, en el estudio de la nueva física del siglo veinte.

¿Ondas o partículas?

Con tal éxito en su física de partículas, no es extraño que cuando Newton trató de explicar el comportamiento de la luz lo hiciera en términos de partículas. Después de todo, los rayos de luz son observados viajando en líneas rectas, y la forma en que la luz se refleja en un espejo es muy parecida al modo de rebotar una bola en una pared dura. Newton construyó el primer telescopio de reflexión, explicó la luz blanca como una superposición de todos los colores del arco iris y trabajó mucho en óptica, pero basando siempre sus teorías en la hipótesis de que la luz consistía en un haz de partículas diminutas (corpúsculos). Los rayos de luz varían su dirección cuando atraviesan la barrera entre una sustancia más ligera y otra más densa, por ejemplo en el paso de aire a agua o a vidrio (por eso parece que un palo se quiebra en un recipiente con agua). Esta refracción se explica convincentemente sobre la base de una teoría corpuscular suponiendo que los corpúsculos se mueven más rápidamente en la sustancia de mayor «densidad óptica». No obstante, en la época de Newton, había una forma alternativa de explicar todo esto.

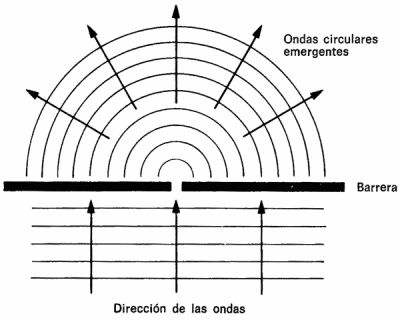

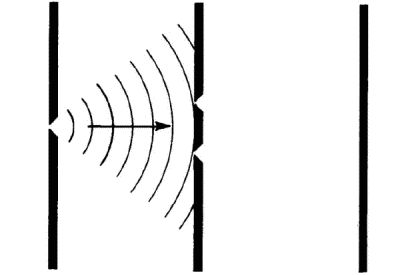

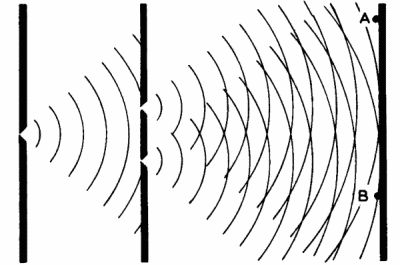

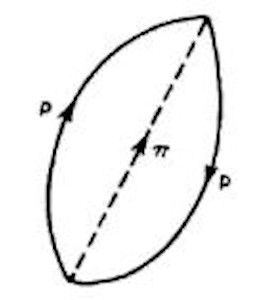

Fig. 1-1. Ondas de agua paralelas que pasan por un pequeño agujero en una barrera y se extienden en círculos a partir del hueco, sin dejar zonas de sombra.

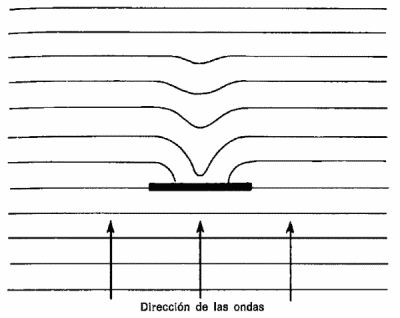

Fig. 1-2. Ondas circulares similares a las producidas al soltar una piedra en un estanque, que se propagan centradas en el hueco al pasar por una estrecha abertura. Las ondas que chocan contra la barrera son reflejadas hacia atrás.

El triunfo de la teoría ondulatoria

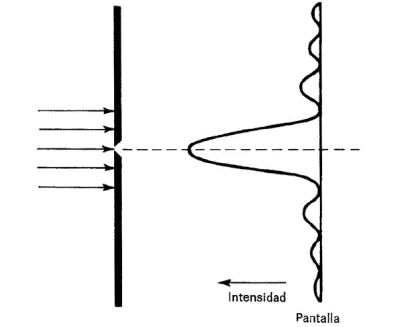

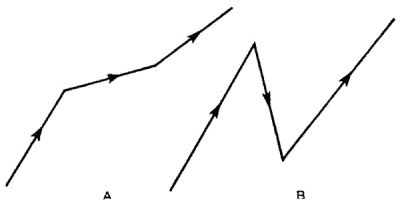

Young utilizó sus conocimientos sobre el movimiento de las ondas en la superficie de un estanque para diseñar un experimento que sirviera de prueba en cuanto a si la luz se propagaba de esa misma forma. Todos conocemos el aspecto de una onda de agua, aunque es importante pensar en una ola pequeña para tener una analogía más precisa. La principal característica de una onda es que eleva el nivel del agua ligeramente y luego causa una depresión cuando la onda pasa; la altura de la cresta de la onda sobre la superficie no perturbada del agua es su amplitud, y para una onda perfecta es igual a la bajada de nivel que experimenta el agua cuando la onda pasa. Una serie de olas, como las producidas por nuestra piedra en el estanque, suelen presentarse con un espacio regular, llamado longitud de onda, que se mide como distancia entre una cresta y la siguiente. Alrededor del punto donde la piedra cayó al agua, las ondas se propagan en círculos, pero las olas en el mar, o las producidas en un lago por el viento, pueden avanzar en series de líneas rectas, de ondas paralelas, una tras otra. En cualquier caso, el número de crestas de onda que pasan por algún punto fijo —como una roca— por segundo proporciona la frecuencia de la onda. La frecuencia es el número de longitudes de onda que pasan por segundo, de modo que la velocidad de la onda, la velocidad de avance de cada cresta, es la longitud de onda multiplicada por la frecuencia.

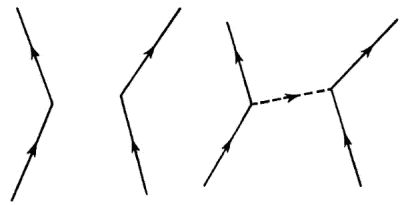

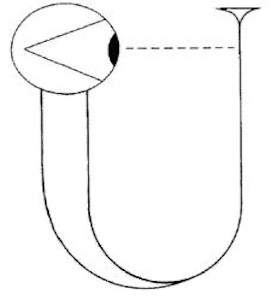

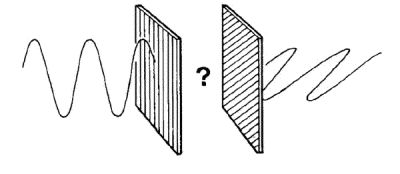

Fig. 1-3. La capacidad de las ondas para doblar esquinas se traduce en que rápidamente pueden invadir la sombra de un obstáculo, suponiendo que el obstáculo no sea mucho mayor que la longitud de onda.

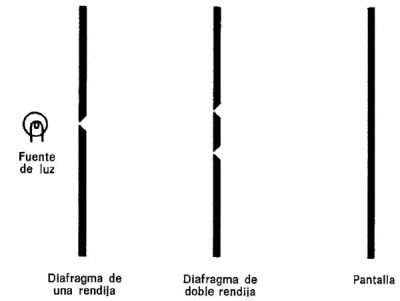

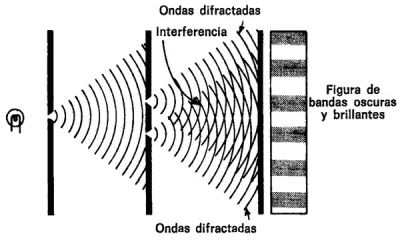

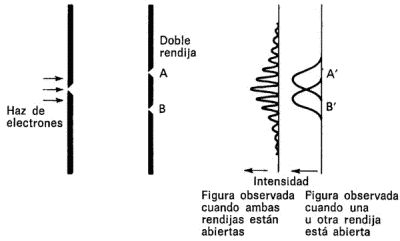

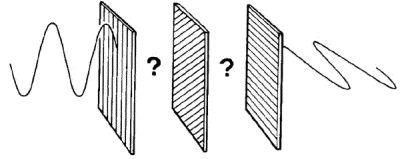

Fig. 1-4. La capacidad de la luz para sufrir difracción por bordes o por pequeños agujeros puede comprobarse utilizando una rendija simple para originar ondas circulares y una rendija doble para producir interferencia.

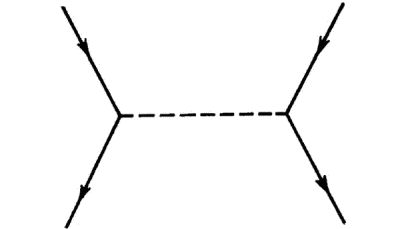

Hasta aquí, todo bien. Pero, finalmente, veamos el experimento de Young. Imagínese el mismo montaje anterior, el depósito de agua con las olas viajando hacia la barrera, pero ahora se trata de una barrera con dos pequeños agujeros. Cada hueco actúa como una nueva fuente de ondas semicirculares en la región del depósito posterior al obstáculo, y como estos dos conjuntos de ondas están producidos por las mismas ondas paralelas del lado anterior de la pared, se mueven exactamente «al paso», o en fase. Ahora hay dos conjuntos de olas desplazándose por el agua y se produce un oleaje final en la superficie de aspecto más complicado. En el lugar en donde las dos olas están haciendo subir el agua aparece una cresta más pronunciada; donde una intentaba crear una cresta y la otra un valle, ambas influencias se compensan y el agua queda como estaba. Estos efectos reciben el nombre de interferencia constructiva y destructiva, respectivamente, y son fáciles de ver, de forma rudimentaria, soltando dos piedras simultáneamente en un estanque. Si la luz es una onda, un experimento equivalente sería capaz de mostrar una interferencia similar entre ondas luminosas, y eso es exactamente lo que Young descubrió.

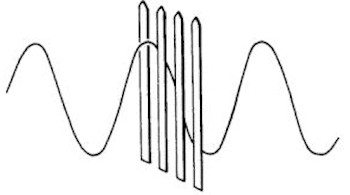

Fig. 1-5. De la misma forma que las ondas de agua pasan a través de un hueco, las ondas de luz se propagan en círculo desde la primera rendija viajando «al paso» unas con otras.

Fig. 1-6. Ondas circulares avanzando desde cada uno de los huecos de una pantalla doblemente agujereada, las cuales interfieren y producen una figura con zonas brillantes y oscuras en la pantalla de observación; es una prueba clara, en el ámbito de este experimento, de que la luz se comporta como una onda.

Léon Foucault, el físico francés famoso por el péndulo que lleva su nombre, estableció a mediados del siglo diecinueve que, contra lo predicho por la teoría corpuscular de Newton, la velocidad de la luz es menor en el agua que en el aire, que no era sino lo que cualquier científico reconocido suponía. Desde entonces «todo el mundo supo» que la luz era una forma de movimiento ondulatorio que se propagaba a través del éter, fuera éste lo que fuera. En las décadas de 1860 y 1870 la teoría de la luz careció quedar definitivamente consolidada al establecer el gran físico escocés James Clerk Maxwell la existencia de ondas que implicaban cambios de campos eléctricos y magnéticos. Esta radiación electromagnética había sido predicha por Maxwell para poder recurrir a modelos de campos eléctricos y magnéticos más fuertes y más débiles en analogía a como las ondas de agua originan crestas y valles en la altura del líquido. En 1887 Heinrich Hertz logró transmitir y recibir radiación electromagnética en forma de ondas de radio, que son similares a las de luz pero con longitudes de onda mucho mayor. Así se completaba la teoría ondulatoria de la luz, justo a tiempo para ser adaptada por la mayor revolución del pensamiento científico desde los tiempos de Newton y Galileo. A finales del siglo diecinueve, sólo un genio o un loco podía haber sugerido que la luz era de naturaleza corpuscular. Su nombre fue Albert Einstein; pero antes de que podamos entender por qué tomó tan audaz dirección necesitamos conocer unos cuantos datos más acerca de las ideas de la física del siglo diecinueve.Muchos relatos populares acerca de la historia de la ciencia dicen que la teoría del átomo se remonta a los antiguos griegos, el nacimiento de la ciencia, y continúan con alabanzas a los mismos por su pronta percepción de la verdadera naturaleza de la materia. Esta afirmación resulta un tanto exagerada. Es verdad que Demócrito de Abdera, que murió hacia el año 370 a. de C., indicó que la naturaleza compleja del mundo podía explicarse si todas las cosas estuvieran compuestas de diferentes clases de átomos inmutables, cada tipo con forma y tamaño propios, en movimiento perpetuo. «Las únicas realidades existentes son los átomos y el espacio vacío; lo demás es mera especulación» escribió[2], y más tarde Epicuro de Samos y el romano Lucrecio Caro adoptaron la idea. Pero en aquellos tiempos no era capital el establecer una teoría de la naturaleza del mundo, y la sugerencia de Aristóteles de que todo en el Universo estaba compuesto a partir de cuatro «elementos» (fuego, tierra, aire y agua) resultó mucho más popular y duradera. En tanto que la idea de átomos quedaba olvidada en el tiempo de Cristo, los cuatro elementos aristotélicos fueron aceptados durante dos mil años.

Aunque el inglés Robert Boyle usó el concepto de átomos en sus trabajos de química en el siglo diecisiete, y Newton lo tuvo en mente en sus descubrimientos en física y en óptica, los átomos realmente no pasaron a formar parte del pensamiento científico hasta la segunda mitad del siglo dieciocho, tras las investigaciones del químico francés Antoine Lavoisier sobre la combustión. Lavoisier identificó muchos elementos reales, sustancias químicas puras que no pueden ser separadas en otras sustancias químicas, y comprobó que la combustión es simplemente un proceso en virtud del cual el oxígeno del aire se combina con otros elementos. A principios del siglo diecinueve John Dalton asignó a los átomos un papel más relevante en química. Estableció que la materia está compuesta por átomos, que a su vez son indivisibles; que todos los átomos de un elemento son idénticos, pero que diferentes elementos tienen átomos distintos (en forma y tamaño); que los átomos no se pueden crear ni destruir, sino que sólo se pueden reorganizar en las reacciones químicas; y que un compuesto químico de dos o más elementos está formado por moléculas, cada una de las cuales tiene un número pequeño y fijo de átomos de cada elemento del compuesto. De modo que la concepción atómica del mundo material realmente se implantó, en la forma que actualmente se explica en los libros de ciencia, hace menos de doscientos años.

Los átomos del siglo diecinueve

Aun así, la idea era lentamente aceptada por los químicos del siglo diecinueve. Joseph Gay-Lussac estableció experimentalmente que cuando dos sustancias gaseosas se combinan, el volumen que se necesita de uno de los gases es siempre simplemente proporcional al volumen necesario del otro. Si el compuesto producido también es un gas, el volumen de este tercer gas también está en proporción simple con los otros dos. Esto encaja con la idea de que cada molécula del compuesto está formada por uno o dos átomos de un gas combinados con unos pocos átomos del otro. El italiano Amadeo Avogadro utilizó esta evidencia, en 1811, para deducir su famosa hipótesis, que establece que para cualquier temperatura y presión fijas hay volúmenes iguales de gas que contienen el mismo número de moléculas, independientemente de la naturaleza química del gas. Experimentos posteriores establecieron la validez de la hipótesis de Avogadro; se puede demostrar que cada litro de gas a la presión de una atmósfera y a la temperatura de 0 °C contiene en números redondos 27.000 millones de billones (27 × 1021) de moléculas. Pero fue hacia 1850 cuando un compatriota de Avogadro, Stanislao Cannizzaro, desarrolló dicha teoría hasta tal punto que dejaron de ser minoría los químicos que se la tomaban en serio. No obstante, hacia 1890, aún había muchos químicos que no aceptaban las ideas de Dalton y Avogadro. Pero habían sido superados por acontecimientos del desarrollo de la física, al explicarse detalladamente el comportamiento de los gases mediante la hipótesis atómica, gracias a los trabajos del escocés James Clerk Maxwell y del austríaco Ludwig Boltzmann.

Durante las décadas de 1860 y 1870, estos pioneros desarrollaron la idea de que un gas está compuesto de muchísimos átomos o moléculas (el número deducido a partir de la hipótesis de Avogadro da idea de su magnitud) que pueden asimilarse a pequeñas esferas macizas en movimiento continuo, y que colisionan entre sí y contra las paredes del recipiente que contiene el gas. A esta consideración hay que añadirle la idea de que el calor no es sino una forma de movimiento (cuando se calienta un gas, las moléculas se mueven con mayor velocidad, lo que hace aumentar la presión sobre las paredes del recipiente, y si las paredes no están fijas en el espacio, el gas se expandirá). La importancia de estas nuevas ideas radicaba en que el comportamiento de un gas podía ser explicado por aplicación de las leyes de la mecánica —las leyes de Newton— en un sentido estadístico, a un elevado número de átomos o de moléculas. Una molécula cualquiera se podía estar moviendo en una dirección arbitraria en el gas en un cierto instante, pero el efecto combinado de muchísimas moléculas chocando contra las paredes del recipiente producía una presión estacionaria. Esto llevó al desarrollo de una descripción matemática del comportamiento de los gases llamada mecánica estadística. Pero todavía no había pruebas directas de que los átomos existían; algunos físicos relevantes de la época atacaban duramente la hipótesis atómica, y aún en la última década del siglo diecinueve Boltzmann se sentía (quizás erróneamente) como un luchador individual contra la corriente científica de la época. En 1898 publicó sus cálculos de manera detallada con la esperanza de «que, cuando la teoría de los gases sea otra vez restablecida, no haya mucho por redescubrir»;[3] en 1906, enfermo y deprimido, desanimado por la continua oposición de muchos científicos importantes a su teoría cinética de los gases, se suicidó, ignorando que unos pocos meses antes un teórico llamado Albert Einstein había publicado un artículo donde establecía la realidad de los átomos más allá de cualquier duda razonable.

Los átomos de Einstein

Ese artículo fue justamente uno de los tres publicados por Einstein en el volumen de Annalen der Physik en 1905, cualquiera de ellos suficiente para haberle asegurado un lugar en los anales de la ciencia. Uno de los trabajos presentaba la especial teoría de la relatividad (que queda fuera del objetivo de este libro); otro se refería a la interacción entre la luz y los electrones y más tarde fue reconocido como el primer trabajo científico relacionado con lo que hoy se llama mecánica cuántica; por este trabajo, Einstein recibió el Premio Nobel de 1921. El tercer artículo consistía en una explicación extrañamente simple de un problema que había preocupado a los científicos desde 1827; una explicación que establecía, más allá de lo que cualquier trabajo teórico podía hacerlo, la realidad de los átomos.

Einstein dijo más tarde que su mayor interés en aquellos días se centraba «en encontrar hechos que garantizaran, tanto como fuera posible, la existencia de átomos de tamaño finito»,[4] un objetivo que indica la importancia atribuida a ese trabajo en los comienzos del presente siglo. Cuando estos artículos se publicaron, Einstein trabajaba como inspector de patentes en Berna; su forma poco convencional de trabajar en el campo de la física no le había convertido en candidato apropiado para un puesto académico tras completar su formación, por lo que se hubo de adaptar al trabajo en la oficina de patentes. Su mente lógica le resultó muy provechosa a la hora de separar el trigo de la paja en el tema de os nuevos inventos, y su destreza en el trabajo le dejaba mucho tiempo libre para pensar en teorías físicas, incluso durante las horas de oficina. Algunas de estas meditaciones las dedicaba a los descubrimientos del botánico inglés Thomas Brown; hacía ya ochenta años, Brown había puesto de manifiesto que al examinar al microscopio un grano de polen flotando sobre una gota de agua se observa un movimiento irregular y aleatorio de aquél, hoy conocido como movimiento browniano. Einstein demostró que este movimiento, aunque aleatorio, obedece una ley estadística precisa y que la trayectoria observada es exactamente la que cabía esperar si el grano de polen fuera continuamente «golpeado» por partículas submicroscópicas desconocidas que evolucionaran de acuerdo a la estadística utilizada por Boltzmann y Maxwell para descubrir el movimiento de los átomos en un gas o en un líquido. Hoy día, la ciencia está tan habituada a la idea de los átomos, que cualquiera puede darse cuenta inmediatamente de que si los granos de polen están siendo impulsados por colisiones no observadas, deben ser átomos móviles los causantes de las mismas. Pero antes de que Einstein lo pusiera de manifiesto, algunos científicos importantes dudaban de la realidad de los átomos; después del trabajo de Einstein, esa duda ya no tenía razón de ser. Resulta fácil de entender después de conocer la explicación, como la de la caída de una manzana de un árbol, pero si era tan obvio, ¿por qué no se había aceptado en las ocho décadas anteriores?

Resulta irónico que dicho trabajo científico se publicara en alemán (en la revista Annalen der Physik) al ser la oposición de científicos relevantes de habla germánica, tales como Ernst Mach y Wilhelm Ostwald, la que parecía haber convencido a Boltzmann de que era una teoría personal sin fundamento. De hecho, a principios del siglo veinte era evidente la realidad de los átomos aunque tal evidencia sólo pudiera admitirse como circunstancial; los físicos ingleses y franceses admitieron la teoría atómica con mucha mayor convicción que sus colegas alemanes, y fue un inglés, J. J. Thomson, el descubridor del electrón —que hoy se conoce como uno de los componentes del átomo— en 1897.

Electrones

A finales del siglo diecinueve surgió una gran controversia en tomo a la naturaleza de la radiación producida por un hilo metálico que transportaba corriente eléctrica a través de un tubo que se había vaciado de aire. Estos rayos catódicos, como se les llamó, podían ser una forma de radiación producida por vibraciones del éter, pero diferentes en su naturaleza de las ondas de luz y de las de por entonces recién descubiertas ondas de radio; o podían ser haces de partículas diminutas. La mayoría de los científicos alemanes admitían la idea de ondas de éter; en cambio, los británicos y franceses pensaban mayoritariamente que los rayos catódicos debían ser partículas. La situación se tomó aún más confusa tras el descubrimiento accidental de los rayos X por Wilhelm Röntgen en 1895 (en 1901, Röntgen recibió el primer Premio Nobel de Física por dicho descubrimiento) que resultó ser una pista falsa. El hallazgo fue importante, aunque quizá se realizó en una época demasiado temprana, al no existir un esquema teórico de la física atómica en el que los rayos X pudieran encajar.

Thomson trabajaba en el laboratorio Cavendish, un centro de investigación en Cambridge fundado por Maxwell, como el primer profesor de física Cavendish en la década de 1870. Diseñó un experimento en el que intervenía el balance entre las propiedades eléctricas y magnéticas de una partícula cargada en movimiento.[5] La trayectoria de la partícula puede ser desviada por campos eléctricos y magnéticos, y el aparato de Thomson estaba diseñado de forma que ambos efectos se compensaran permitiendo que un haz de rayos catódicos pudiera viajar en línea recta desde una lámina metálica cargada negativamente (cátodo) a una pantalla detectora. Este proceso sólo funcionaba con partículas cargadas eléctricamente; de modo que sirvió para que Thomson estableciera que los rayos catódicos son en realidad partículas cargadas negativamente (hoy llamados electrones[6]) y, al mismo tiempo, aprovechó ese balance entre fuerzas eléctricas y magnéticas para calcular la relación entre la carga eléctrica y la masa de un electrón (e/m). Cualquiera que fuera el metal utilizado como cátodo, siempre se obtenía el mismo resultado, por lo que llegó a la conclusión de que los electrones son parte de la estructura de los átomos, y aunque diferentes elementos están compuestos de átomos de distinta naturaleza, todos los átomos contienen electrones idénticos.

Éste no fue un descubrimiento casual, como lo había sido el de los rayos X, sino el resultado de una planificación cuidadosa y de una realización esmerada. Maxwell fundó el laboratorio Cavendish, pero fue gracias a Thomson cuando se convirtió en un centro destacado de física experimental —quizás el más importante del mundo— siempre en la brecha de los descubrimientos que condujeron a los fundamentos de la nueva física del siglo veinte. El Premio Nobel fue concedido, junto a Thomson, a siete científicos de los que trabajaban en el Cavendish en el período anterior a 1914. Hoy en día continúa siendo un centro mundialmente reconocido en cuanto a física se refiere.

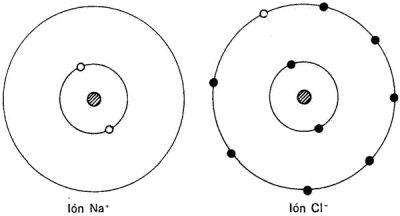

Iones

Los rayos catódicos, producidos por una lámina cargada negativamente en un tubo de vacío, resultan ser partículas con carga eléctrica negativa, es decir, electrones. Los átomos, sin embargo, son eléctricamente neutros, por lo que resulta lógico pensar en una carga positiva que contrarreste a la representada por los átomos que han sido desposeídos de una parte de carga negativa. Wilhelm Wien, de la Universidad de Würzburg, realizó algunos de los primeros estudios acerca de estos rayos positivos en 1898, llegando a la conclusión de que las partículas que los integran son mucho más pesadas que los electrones, como cabría esperar si fueran exactamente átomos desprovistos de un electrón. Como continuación de sus trabajos sobre los rayos catódicos, Thomson aceptó el reto que suponía la investigación de estos rayos positivos realizando una serie de difíciles experimentos que se prolongaron hasta la década de los años 20. Hoy esos rayos reciben el nombre de átomos ionizados, o simplemente «iones»; en la época de Thomson se les denominó «rayos canales» y él los estudió utilizando un tubo de rayos catódicos modificado a base de enrarecer ligeramente el vacío con un poco de gas. Los electrones en movimiento a través del gas colisionaban con los átomos de éste apareciendo, tras el choque, nuevos electrones y también iones con carga eléctrica positiva, los cuales podían manipularse mediante campos eléctricos y magnéticos de la misma forma en que Thomson manipulaba los propios electrones. En 1913 el equipo de Thomson se dedicó a medir desviaciones de iones positivos de hidrógeno, oxígeno y otros gases. Uno de los gases utilizados por Thomson en estas experiencias fue el neón; el rastro que deja el neón en un tubo de vacío por el que discurre una corriente eléctrica adquiere un tono brillante, por lo que el aparato de Thomson fue un precursor del moderno tubo de neón. Lo que él descubrió, sin embargo, fue mucho más importante que una nueva modalidad publicitaria.

A diferencia de los electrones, que todos tienen el mismo valor de e/m, este proceso dio lugar a tres iones diferentes de neón, todos con la misma cantidad de carga eléctrica que el electrón (sólo que con +e en lugar de −e) pero con masas diferentes entre sí. Ésta fue la primera evidencia de que los elementos químicos incluyen a menudo átomos con masas diferentes, es decir, diferentes pesos atómicos aunque con idénticas propiedades químicas. Tales variaciones de un elemento químico reciben el nombre de «isótopos», y tuvo que transcurrir bastante tiempo antes de que se pudiera encontrar una explicación de su existencia. No obstante, Thomson disponía en esa época de información suficiente para intentar describir la composición interior de un átomo, que ya no podía considerarse como una partícula elemental indivisible (como unos cuantos filósofos griegos habían creído), sino como una mezcla de cargas positivas y negativas de la cual podían ser extraídos los electrones.

Thomson concebía el átomo como algo parecido a una sandía, es decir, como una esfera relativamente grande donde se encuentran esparcidas todas las cargas positivas y en cuyo interior, como si de semillas se tratase, aparecen empotrados los pequeños electrones cada uno con su carga negativa particular. La teoría no era la correcta, pero proporcionó a los científicos un modelo con el que trabajar, de forma que su posterior reestructuración condujo a una comprensión más precisa de la estructura atómica.

Rayos X

La clave que desveló el secreto de la estructura de un átomo fue el descubrimiento de la radiactividad en 1896. Al igual que ocurrió con el descubrimiento de los rayos X unos meses antes, también éste resultó ser un afortunado accidente. Cuando los rayos catódicos (con los que estaba experimentando Wilhelm Röntgen en el momento del descubrimiento de los rayos X, también llamados electrones) inciden sobre un objeto material, la colisión produce una radiación secundaria invisible que sólo puede detectarse por sus efectos en placas fotográficas o en pantallas fluorescentes, donde se producen efectos luminosos cuando hay incidencia de radiación. Röntgen disponía de una pantalla fluorescente sobre una mesa próxima a su dispositivo de rayos catódicos, y se dio cuenta de que, cuando el tubo de descarga del experimento de rayos catódicos estaba en funcionamiento, la pantalla fluorescía. Así descubrió la radiación secundaria, que él llamó «X», porque así se designa normalmente la magnitud desconocida en una ecuación matemática. Pronto se demostró que los rayos X se comportaban como ondas (hoy se sabe que son una forma de radiación electromagnética, muy parecida a las ondas luminosas pero de mucha menor longitud de onda), y este descubrimiento, realizado en un laboratorio alemán, reafirmó la suposición de que los rayos catódicos también debían ser ondas.

El descubrimiento de los rayos X se anunció en diciembre de 1895 causando gran sorpresa en la comunidad científica. Diferentes investigadores trataron de encontrar otras formas de producir rayos X o radiaciones parecidas, siendo Henri Becquerel el primero en lograrlo, en París. La característica más particular en la radiación X era la forma en que podía atravesar muchas sustancias opacas, como papel negro, produciendo una imagen en una placa fotográfica sin que ésta hubiera estado expuesta a la luz. Becquerel era especialista en fosforescencia, que consiste en la emisión de luz por una sustancia que previamente había absorbido dicha emisión. Una pantalla fluorescente, como la utilizada en el descubrimiento de los rayos X, emite luz sólo cuando está siendo «excitada» por una radiación incidente; una sustancia fosforescente es capaz de almacenar la radiación que le llega y liberarla en forma de luz lentamente durante horas después de haber sido colocada en la oscuridad. Lo que se buscaba era una relación entre fosforescencia y radiación X, pero el descubrimiento de Becquerel fue tan inesperado como lo había sido el de los rayos X.

Radiactividad

En febrero de 1896, Becquerel envolvió una placa fotográfica con papel negro de doble espesor recubierto con bisulfato de uranio y potasio, y lo expuso al sol durante varias horas. Al desenvolver la placa apareció impresionado el contorno correspondiente a la cubierta química. Becquerel pensó que se había producido radiación X en las sales de uranio por efecto de la luz solar, como ocurría en la fosforescencia; pero dos días más tarde, al intentar repetir el experimento, el tiempo apareció muy nuboso y, por lo tanto, guardó el dispositivo en una habitación. El 1 de marzo, Becquerel desenvolvió la placa, y encontró de nuevo impresionado en ella el contorno correspondiente a la sal de uranio. Independientemente de lo que hubiera excitado a las dos placas, no tenía nada que ver con los rayos solares ni con la fosforescencia, sino que debía ser una forma de radiación desconocida proveniente, como se supo después, del propio uranio y sin ninguna influencia externa. Esta capacidad de emitir radiación de manera espontánea se llama radiactividad.

A raíz del descubrimiento de Becquerel, otros científicos se sumaron a la investigación de la radiactividad, entre ellos Marie y Pierre Curie que, trabajando en la Sorbona, se convirtieron pronto en los expertos en esta nueva rama de la ciencia. Por sus trabajos sobre radiactividad y por el descubrimiento de nuevos elementos radiactivos recibieron el Premio Nobel de Física en 1903; en 1911 Marie recibió un segundo Premio Nobel, esta vez en química, por su trabajo con materiales radiactivos (Irene, la hija de Marie y Pierre Curie, también recibió un Premio Nobel por su trabajo sobre radiactividad en 1935). A principios de siglo los descubrimientos prácticos en radiactividad iban muy por delante de la teoría, con una serie de experimentos que sólo con el paso del tiempo pudieron ser encajados en el marco teórico. Durante este período el científico Ernest Rutherford sobresalió en la investigación de la radiactividad.

Rutherford, neozelandés, había trabajado con Thomson en el Cavendish en la última década del siglo diecinueve. En 1898 fue nombrado profesor de física de la Universidad McGill, en Montreal, donde él y Frederick Soddy demostraron en 1902 que la radiactividad supone la transformación del elemento radiactivo en otro elemento. Fue Rutherford el que descubrió que existían dos tipos de radiación producida en esta «desintegración radiactiva» y les impuso los nombres de radiación «alfa» y «beta». El tercer tipo de radiación descubierto más tarde, se llamó «gamma». Tanto la radiación alfa como la beta resultaron ser partículas con gran velocidad; se demostró que los rayos beta eran electrones, el equivalente radiactivo de los rayos catódicos, y más tarde se confirmó que los rayos gamma eran otra forma de radiación electromagnética, como los rayos X, pero con menores longitudes de onda. Las partículas alfa se diferenciaban de las otras dos por poseer una masa aproximadamente cuatro veces mayor que la de un átomo de hidrógeno y una carga eléctrica doble que la del electrón, pero positiva en lugar de negativa.

El interior del átomo

Antes de que se supiera con exactitud la naturaleza de las partículas alfa, y cómo podían emerger a tan enormes velocidades de un átomo que en el proceso se transformaba en otro átomo de distinto elemento, investigadores como Rutherford eran capaces de utilizarlas provechosamente. Tales partículas de alta energía, producto ellas mismas de reacciones atómicas, se usaron como sondas para el estudio de la estructura de los átomos y para descubrir en última instancia de dónde provenían las partículas alfa.

En 1907, Rutherford abandonó Montreal para convertirse en profesor de la Universidad de Manchester, en Inglaterra; en 1908 recibió el Premio Nobel de Química por su trabajo en radiactividad. Aunque el estudio de los elementos fue considerado por el Comité Nobel como química, Rutherford se consideraba a sí mismo físico y consideraba la química como una rama muy inferior de la ciencia. En 1909, Hans Geiger y Ernest Marsden, que trabajaban en el departamento de Rutherford en Manchester, llevaron a cabo experimentos en los que un haz de partículas alfa se dirigía contra una delgada hoja metálica. Las partículas alfa provenían de átomos radiactivos naturales, ya que no existían aceleradores de partículas por aquellos días. El proceso de las partículas dirigidas contra la hoja metálica quedaba determinado mediante contadores de centelleo, pantallas fluorescentes que brillan cuando incide sobre ellas una partícula de éstas. Algunas de las partículas atravesaban el metal; otras eran desviadas y emergían formando un cierto ángulo con el haz original; finalmente, y para sorpresa de los experimentadores, algunas rebotaban en la hoja metálica y volvían en la misma dirección de incidencia. ¿Cómo podía suceder esto?

El mismo Rutherford dio con la solución. Cada partícula alfa tiene una masa superior a 7.000 veces la del electrón (de hecho, una partícula alfa es idéntica a un átomo de helio del que se han liberado dos electrones) y puede moverse a velocidades próximas a la de la luz. Si una de estas partículas choca contra un electrón, le aparta de su camino y continúa imperturbada. Las desviaciones se producen por las cargas positivas que poseen los átomos del metal (cargas iguales, como sucede con polos magnéticos iguales, se repelen mutuamente); pero si el modelo «sandía» de Thomson fuera correcto no se produciría el rebote de las partículas incidentes. Si la esfera de carga positiva rellenara el átomo, las partículas alfa deberían atravesarlo puesto que el experimento mostraba que la mayoría de las partículas atravesaban la hoja metálica. Pero si la «sandía» permitía el paso a una partícula debería permitir el paso a todas; salvo que toda la carga positiva estuviera concentrada en un estrecho volumen mucho menor que el de todo el átomo, en cuyo caso una partícula alfa podía incidir ocasionalmente sobre esta densa concentración de carga y de materia saliendo rebotada; mientras tanto la gran mayoría de partículas alfa incidentes pasarían por el espacio vacío intermedio entre las zonas positivamente cargadas de los átomos. Sólo con esta disposición la carga positiva del átomo podía hacer retroceder en su camino, a veces, a las partículas alfa, podía desviar ligeramente a otras en su trayectoria y también era posible que en otras ocasiones las dejara prácticamente sin perturbar.

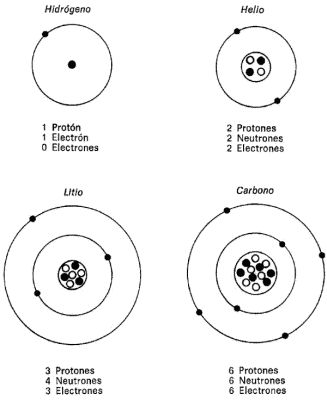

Así, en 1911, Rutherford propuso un nuevo modelo del átomo que resultó ser la base del conocimiento actual de la estructura atómica. En el centro del átomo situó una pequeña región a la que llamó el núcleo; éste contiene toda la carga positiva del átomo, que es igual y de signo opuesto al total de la carga negativa de la nube de electrones que rodea al núcleo, de forma que el núcleo y los electrones integran un átomo eléctricamente neutro. Experimentos posteriores demostraron que el tamaño del núcleo es tan sólo la cienmilésima parte del átomo aproximadamente. (Un núcleo típico de unos 10−13 cm está inmerso en una nube electrónica de 10−8 cm aproximadamente.) Para hacerse una idea de tales proporciones, imagínese una cabeza de alfiler de un milímetro, en el centro de la catedral de San Pablo, rodeada de una nube de motas microscópicas de polvo que se extienden hasta la bóveda, a lo largo de unos 100 metros. La cabeza de alfiler representa el núcleo atómico; las motas de polvo son los electrones que lo rodean, y todo el espacio vacío que resta es el correspondiente al átomo; además todos los objetos aparentemente sólidos del mundo material están compuestos de tales espacios vacíos, salpicados de cargas eléctricas. Rutherford ya había ganado un Premio Nobel cuando presentó este nuevo modelo para el átomo (un modelo basado en experimentos ideados por él mismo). No obstante, continuó su carrera ascendente, pues en 1919 comunicó la obtención de la primera transmutación artificial de un elemento, y en el mismo año sucedió a J. J. Thomson como director del laboratorio Cavendish. En 1914 fue investido caballero y después, en 1931, nombrado barón Rutherford de Nelson. Sin embargo, su mayor contribución a la ciencia radicó en el modelo nuclear del átomo, que sirvió para dilucidar un problema: puesto que cargas de igual signo se repelen y las de distinto signo se atraen, ¿cómo es que las cargas negativas no se precipitan sobre el núcleo positivo? La respuesta la proporcionó el análisis del modo en que los átomos interaccionan con la luz, hecho que caracterizó la primera versión de la teoría cuántica.Según el modelo atómico de Rutherford, si una carga eléctrica en movimiento y acelerada irradia energía en forma de radiación electromagnética (luz, ondas de radio, o alguna otra variante), un electrón ligado al núcleo de un átomo debería precipitarse sobre el núcleo, de manera que el átomo no sería estable y produciría un choque atómico que generaría energía. La teoría más implantada sobre la manera de contrarrestar esta tendencia del átomo al colapso era suponer que los electrones giran en órbitas alrededor del núcleo, como lo hacen los planetas alrededor del Sol en nuestro Sistema Solar. Pero los movimientos orbitales suponen una aceleración continua y esa celeridad de la partícula en órbita puede no cambiar, aunque sí cambia la dirección del movimiento, y ambos, celeridad y dirección juntos definen la velocidad, que es el factor más importante. Como la velocidad de los electrones en órbita cambiaba, éstos deberían irradiar energía y, al perderla, precipitarse en espiral sobre el núcleo. De modo que, aun acudiendo a movimientos orbitales, los científicos debían aceptar la idea del colapso del átomo de Rutherford.

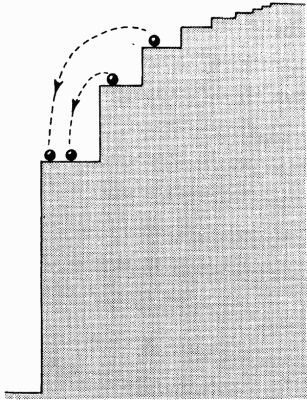

Conforme este modelo se iba mejorando, los científicos se apartaban de la primitiva imagen de los electrones en órbita alrededor del núcleo, tratando de encontrar la manera de mantenerlos en sus órbitas pero sin que ello implicara pérdida de energía y precipitación en espiral sobre el núcleo. La obvia analogía con el Sistema Solar fue un punto de partida que resultó erróneo, ya que se puede imaginar a los electrones en el espacio a cierta distancia del núcleo, pero no en órbitas alrededor de él. Así, el problema continúa siendo el mismo: cómo evitar la caída de los electrones. Las teoría utilizada por los científicos para explicar por qué los electrones no caen no adopta la similitud orbital como base y, en cambio, dicha comparación resulta redundante y equívoca a la vez. La imagen que la mayor parte de la gente posee del átomo es parecida a la de un sistema solar, con un núcleo central estrecho alrededor del cual los electrones giran en órbitas circulares. Esa imagen debe abandonarse para introducirse en el complejo mundo del átomo: el mundo de la mecánica cuántica.

En la segunda década del siglo veinte los teóricos empezaron a preocuparse por este problema, e incluso ya se habían hecho descubrimientos cruciales que conducirían a la realización de un nuevo modelo del átomo. Se basaban en estudios de la forma en que la materia (átomos) interacciona con la radiación (luz).

A principios del siglo veinte, la comprensión del mundo natural requería una filosofía dual: los objetos materiales habían de ser descritos en términos de partículas o átomos, pero la radiación electromagnética, incluida la luz, había de entenderse en términos de ondas. De modo que el estudio de la forma en que interacciona la luz con la materia parecía poder proporcionar la mejor oportunidad de unificación de la física en tomo al año 1900. Pero fue exactamente al intentar explicar cómo interacciona la radiación con la materia cuando la física clásica, de tanto éxito en muchos otros problemas, se vino abajo.

La forma más sencilla de entender cómo interaccionan materia y radiación consiste en observar un objeto caliente, ya que éste irradia energía electromagnética, y cuanto más caliente está, más energía irradia a longitudes de onda más cortas (frecuencias más altas). Así, un atizador «al rojo» está más frío que uno «al blanco», y un atizador que esté demasiado frío para irradiar luz visible puede estar caliente e irradiar radiación infrarroja de baja frecuencia. Incluso a finales del siglo diecinueve se tenía en cuenta que esta radiación electromagnética debía estar asociada con el movimiento de cargas eléctricas diminutas. Gracias al descubrimiento del electrón como parte integrante del átomo se puede observar cómo éste puede producir por vibración un haz de ondas electromagnéticas, de forma no demasiado distinta a como se pueden producir olas en la bañera con un movimiento de vaivén del dedo. Sin embargo, la mecánica estadística y el electromagnetismo postulaban una forma de radiación muy diferente de la realmente emitida por los objetos calientes.

La pista del cuerpo negro

Para realizar las predicciones anteriormente indicadas, los teóricos utilizaron un ejemplo ideal imaginario; en este caso se trataba de un «perfecto» absorbente o emisor de radiación. Un objeto de estas características se llama usualmente un «cuerpo negro», porque absorbe toda la radiación que le llega. Sin embargo, la denominación no es del todo adecuada porque un «cuerpo negro» es capaz de convertir energía calorífica en radiación electromagnética (un «cuerpo negro» puede muy bien presentarse «al rojo» o «al blanco» y, en cierta forma, la superficie misma del Sol actúa como un «cuerpo negro»). Es fácil construir un «cuerpo negro» en el laboratorio; basta tomar una esfera hueca, o un tubo con los extremos cerrados, y practicar un pequeño hueco en su superficie. Cualquier radiación, como la luz, que penetre por el agujero quedará atrapada en el interior, rebotando en las paredes hasta ser absorbida; es muy improbable que pueda salir a través del hueco debido a ese rebote, por lo que este agujero es un «cuerpo negro». El nombre germánico equivalente es el de cavidad de radiación.

Es interesante observar qué le sucede a un «cuerpo negro» cuando se calienta. El espectro de la radiación emitida —la cantidad radiada de cada longitud de onda— se puede estudiar en el laboratorio observando la que proviene de un recipiente caliente, y ello demuestra que depende únicamente de la temperatura del «cuerpo negro». Existe muy poca radiación de longitud de onda muy corta (alta frecuencia), y muy poca de longitud de onda muy larga, correspondiendo la mayor parte de la energía radiada a bandas de frecuencias intermedias. El máximo del espectro se desplaza hacia longitudes de ondas más cortas conforme el cuerpo se va calentando (del infrarrojo, al rojo, al azul, al ultravioleta), pero siempre aparece un corte para longitudes de onda muy cortas. Aquí es donde las medidas de la radiación del «cuerpo negro» efectuadas en el siglo diecinueve entraban en conflicto con la teoría.

Por extraño que parezca, las predicciones de la teoría clásica aseguraban que una cavidad llena de radiación siempre posee una cantidad infinita de energía, por unidad de volumen, correspondiente a pequeñas longitudes de ondas que no quedaban registradas en la escala, en lugar de un máximo en el espectro y de una caída a cero a longitud de onda nula. Los cálculos se basaban en el supuesto de que las ondas electromagnéticas de la radiación de la cavidad deberían tener las mismas características que las ondas en una cuerda, de violín por ejemplo, y que allí podían aparecer ondas de cualquier tamaño (es decir, de cualquier longitud de onda y de cualquier frecuencia). Como hay demasiadas longitudes de ondas (demasiados «modos de vibración») que considerar, se deben adoptar las leyes de la mecánica estadística del mundo de las partículas y aplicarlas al mundo de las ondas para poder predecir el aspecto global de la radiación de la cavidad; esto lleva directamente a la conclusión de que la energía radiada de cada frecuencia es proporcional a dicha frecuencia. La frecuencia es prácticamente la inversa de la longitud de onda y longitudes de onda muy cortas corresponden a frecuencias muy altas. De modo que la radiación de un «cuerpo negro» debería producir enormes cantidades de energía de alta frecuencia en una zona del ultravioleta. A más frecuencia, más energía. Esta predicción se conoce con el nombre de «catástrofe ultravioleta», y puso de manifiesto algunos errores en los supuestos de partida.

En la zona de baja frecuencia de la curva del «cuerpo negro», las observaciones se ajustaban muy bien a las predicciones basadas en la teoría clásica, conocidas bajo el nombre genérico de Ley de Rayleigh-Jeans. La dificultad radicaba en encontrar la razón por la cual la energía de las oscilaciones de alta frecuencia no sólo no es muy grande, sino que tiende a anularse conforme la frecuencia de la radiación aumenta.

El problema atrajo la atención de un buen número de físicos durante la última década del siglo diecinueve. Uno de ellos fue Max Planck, un científico alemán de la vieja escuela que estaba especialmente interesado en la termodinámica, y su gran preocupación por esa época consistía en resolver la «catástrofe ultravioleta» por aplicación de reglas termodinámicas. En los últimos años del siglo se conocían dos ecuaciones que, unidas, proporcionaban una basta explicación del espectro del «cuerpo negro». Una versión inicial de la Ley de Rayleigh-Jeans daba buenos resultados para grandes longitudes de onda, mientras que Wilhelm Wien había calculado una fórmula que se ajustaba bastante a las observaciones efectuadas a baja longitud de onda y, además, predecía la longitud de onda a la que aparece el máximo para cualquier temperatura. Planck partió del estudio de la absorción y emisión de ondas electromagnéticas por pequeños osciladores eléctricos, un procedimiento distinto del utilizado por Rayleigh en 1900 y por Jeans unos años más tarde, pero que proporcionaba exactamente la curva típica completa, con la «catástrofe ultravioleta» incluida. Desde 1895 hasta 1900, Planck se ocupó del problema y publicó varios artículos claves que establecieron la conexión existente entre la termodinámica y el electromagnetismo, pero no consiguió resolver el enigma del espectro del «cuerpo negro». En 1900 cambió radicalmente su teoría, no como resultado de consideraciones científicas frías, serenas y lógicas, sino como un acto de desesperación en el que se mezclaron el azar, la intuición y un afortunado error en las matemáticas utilizadas.

Hoy en día nadie puede estar absolutamente seguro del pensamiento de Planck cuando tomó el revolucionario camino que condujo a la mecánica cuántica, pero su trabajo ha sido estudiado detalladamente por Martin Klein de la Universidad de Yale, un historiador especializado en la historia de la física en relación con el nacimiento de la teoría cuántica. La reconstrucción efectuada por Klein del papel jugado por Planck y Einstein en el desarrollo de la teoría cuántica representa un documento muy importante que sitúa los descubrimientos en un convincente contexto histórico. El primer paso se debe a la intuición de un físico matemático preparado. Planck se dio cuenta de que las dos descripciones del espectro del «cuerpo negro» podían combinarse en una fórmula matemática simple que proporcionaba la forma completa de la curva y para ello utilizó la Ley de Wien y la Ley de Rayleigh-Jeans. Esta fórmula constituyó un gran éxito, ya que la ecuación de Planck concordaba perfectamente con las observaciones de la radiación emitida por la cavidad, aunque carecía de soporte físico. Wien y Rayleigh —también Planck en los cuatro años anteriores— habían tratado de construir una teoría partiendo de hipótesis físicas plausibles que condujera a la curva del espectro del «cuerpo negro». Y, sin embargo, fue Planck el que descubrió la curva correcta sin que nadie supiera los supuestos físicos implicados en la obtención de dicha curva.

Una revolución molesta

La fórmula de Planck fue hecha pública en una reunión de la Sociedad de Física de Berlín en octubre de 1900; durante los dos meses siguientes, el propio Planck estuvo inmerso en el problema de encontrar una base física para su ley, y para ello ensayó diferentes combinaciones de hipótesis físicas para ver cuál encajaba mejor con las ecuaciones matemáticas. Más tarde manifestó que éste había sido el periodo de más intenso trabajo a lo largo de su vida. Muchos intentos fracasaron, hasta que finalmente sólo quedaba una alternativa, molesta para Planck.

En sus primeros trabajos, Planck no aceptaba la hipótesis molecular, y particularmente desechaba la idea de una interpretación estadística de la propiedad llamada entropía, interpretación introducida por Boltzmann en la termodinámica. La entropía es un concepto clave en física, relacionado en un sentido fundamental con el flujo del tiempo. Aunque las leyes simples de la mecánica —las leyes de Newton— son completamente reversibles en lo que al tiempo se refiere, se sabe que el mundo real no es así. Por ejemplo, si una piedra que cae llega al suelo, la energía de su movimiento se convierte en calor; pero si se coloca una piedra idéntica en el suelo y se calienta en el mismo porcentaje, no sube por el aire. ¿Por qué no? En el caso de la piedra que cae, una forma ordenada de movimiento (todos los átomos y moléculas cayendo en la misma dirección) se convierte en una forma desordenada de movimiento (todos los átomos y moléculas colisionando al azar entre sí). Este hecho está de acuerdo con una ley de la naturaleza que parece requerir el crecimiento permanente del desorden, y el desorden se identifica, en este sentido, con la entropía. Dicha ley es la segunda ley de la termodinámica, y establece que los procesos naturales siempre se dirigen hacia un crecimiento del desorden, o que la entropía siempre crece. Si se comunica energía calorífica desordenada a una piedra, ésta no puede utilizar dicha energía para crear un movimiento ordenado de las moléculas de la piedra de forma que todas ellas puedan elevarse al unísono.

Boltzmann introdujo una variedad en el tema. Pensaba que tan singular acontecimiento podría suceder, pero es extremadamente improbable. Planck atacaba duramente esta interpretación estadística de la segunda ley de la termodinámica, tanto públicamente como en correspondencia personal con Boltzmann. Para él la segunda ley representaba un absoluto; la entropía debía crecer siempre, y la probabilidad nada tenía que ver. De modo que es fácil comprender cómo se debía sentir Planck a finales de 1900, cuando, habiendo agotado todas las posibles opciones y tratando de incorporar la versión estadística de Boltzmann de la termodinámica a sus cálculos del espectro del «cuerpo negro», se encontró con que el resultado era el correcto. La ironía de la situación es aún más aguda, pues a causa de su poca familiaridad con las ecuaciones de Boltzmann, Planck las aplicó incoherentemente. Obtuvo la solución correcta, pero con razonamientos equivocados, y por eso el significado real del trabajo de Planck no quedó claro hasta que Einstein asumió la idea.

Hay que destacar que el hecho de que Planck estableciera la interpretación estadística de Boltzmann en el crecimiento de la entropía representa la mejor descripción de la realidad. Siguiendo el trabajo de Planck, no puede ponerse en duda que el crecimiento de la entropía, aunque muy probable, no es de una certeza absoluta. Esto tiene implicaciones interesantes en cosmología (la ciencia que estudia el Universo), ya que cuanto mayor es la región con que se opera, más grande es el abanico de posibilidades para que estos hechos que parecen inverosímiles ocurran en algún lugar y en algún tiempo. Incluso es posible (aunque muy poco probable) que el Universo completo, que es un lugar ordenado en general, represente cierta clase de fluctuación estadística termodinámica; como una gran concentración que ha originado una región de baja entropía evolucionando hacia su desaparición como tal. El error de Planck, sin embargo, reveló algo más fundamental sobre la naturaleza del Universo.

La concepción estadística de Boltzmann de la termodinámica implicaba, como procedimiento matemático, la división de la energía en porciones y el tratamiento de cada una de éstas como magnitudes reales que podían ser descritas por leyes de tipo probabilístico. La energía, dividida en partes para efectuar los cálculos, había de ser reagrupada (integrada) en una etapa posterior para proporcionar la energía total; caso que se puede aplicar a la energía correspondiente a la radiación del «cuerpo negro». A mitad del experimento, sin embargo, Planck se encontró con la fórmula matemática que estaba buscando. Antes de proceder a la integración para pasar de las porciones de energía al continuo, la ecuación del «cuerpo negro» aparecía entre los resultados matemáticos obtenidos. La deducción fue, por tanto, producto de un procedimiento muy drástico, y totalmente injustificado dentro del contexto de la física clásica.

Cualquier buen físico que sostuviera la teoría clásica y que hubiera partido de las ecuaciones de Boltzmann para obtener una fórmula de la radiación del «cuerpo negro» debería haber completado la integración. Entonces, como Einstein demostró más tarde, la yuxtaposición de las porciones de energía habría restaurado la «catástrofe ultravioleta»; en realidad, Einstein puso de manifiesto que cualquier tratamiento clásico del problema conduce a dicha catástrofe. Únicamente por conocer la solución que buscaba, Planck se detuvo antes de obtener la solución final aparentemente correcta y, por ello, se vio obligado a explicar el significado de dichas porciones de energía. Él interpretó esta división aparente de la energía electromagnética en porciones individuales como una manifestación de que los osciladores eléctricos del interior del átomo sólo podían emitir o absorber energía en «paquetes» de un cierto tamaño, recibiendo cada uno el nombre de cuanto. En lugar de dividir el total de energía disponible en un infinito número de partes, sólo podía ser dividida en un número finito de porciones, cada una de ellas asociada a un oscilador, y la energía de dicha porción de radiación (E) debía estar relacionada con la frecuencia correspondiente (designada por la letra griega nu, ν) de acuerdo a una nueva fórmula,

E = hν

donde h es una nueva constante, hoy conocida como la constante de Planck.¿Qué es h?

Para frecuencias muy altas, la energía necesaria para emitir un cuanto de radiación es muy grande, y sólo unos pocos osciladores dispondrán de dicha energía (de acuerdo con las ecuaciones estadísticas), de modo que sólo unos pocos cuantos de alta energía son emitidos. A muy bajas frecuencias (grandes longitudes de onda), se emiten muchos cuantos de baja energía, pero cada uno de ellos con tan escasa energía que incluso todos juntos no suman cantidades apreciables. Sólo en la zona intermedia del rango de frecuencias existen multitud de osciladores con energía suficiente para emitir radiación en porciones de cuantía moderada, las cuales se suman y originan el máximo de la curva del «cuerpo negro».

Sin embargo el descubrimiento de Planck, anunciado en diciembre de 1900, planteó más preguntas que las que resolvió, y no sirvió para acabar con las teorías de la física clásica. Los propios artículos primeros de Planck sobre la teoría cuántica no son del todo claros (quizá reflejan la forma confusa en la que se vio obligado a introducir la idea en su termodinámica), y durante un tiempo muchos —incluso la mayoría— de los físicos que conocieron su trabajo lo consideraron simplemente un truco matemático, un artificio destinado a dar cuenta de la catástrofe ultravioleta, pero con poco o nulo significado físico. El mismo Planck se halaba confuso. En una carta a Robert William Wood, escrita en 1931, recordaba su trabajo de 1900 y decía: «Puedo caracterizar el procedimiento entero como un acto de desesperación… tenía que encontrarse una interpretación teórica a cualquier precio, por alto que éste fuera.[7]» Según Heisenberg, el hijo de Planck comentó después cómo su padre describía su trabajo por aquel tiempo, durante un largo paseo por los alrededores de Berlín, explicando que su descubrimiento podía compararse con los de Newton.[8]

Durante los primeros años del siglo, los físicos seguían estudiando los recientes descubrimientos en tomo a la radiación atómica, y el nuevo truco matemático de Planck para explicar la curva del «cuerpo negro» no les parecía de extraordinaria importancia al lado de aquellos descubrimientos. Planck no recibió hasta 1958 el Premio Nobel por su trabajo, demasiado tiempo si se compara con el que tardó en reconocerse la importancia del trabajo de los Curies o de Rutherford. (En parte porque siempre cuesta más reconocer nuevas rupturas teóricas dramáticas; una nueva teoría no es tan tangible como una nueva partícula, o como un rayo X; y tiene que enfrentarse a la prueba del tiempo y a la confirmación experimental antes de alcanzar reconocimiento universal.) Además existía un dato que no encajaba adecuadamente en la nueva constante de Planck, h. Ésta es muy pequeña, 6,55 × 10−27 ergios × segundos, pero esto no era sorprendente puesto que si hubiera resultado mucho mayor, su presencia habría sido obvia mucho antes de que los físicos se ocuparan del problema de la radiación del «cuerpo negro». Lo extraño sobre h son las unidades en las que se mide: energía (ergios) multiplicada por tiempo (segundos). Estas unidades corresponden a una magnitud llamada «acción», que no es muy usual en la mecánica clásica; no existe una ley de conservación de la acción análoga a la ley de conservación de la masa o de la energía; pero la acción tiene una propiedad particularmente interesante que comparte, entre otras cosas, con la entropía: una acción constante es siempre absolutamente constante y tiene el mismo valor, para cualquier observador, en el espacio y en el tiempo. Es una constante tetradimensional, y lo que esto significa sólo quedó claro cuando Einstein desveló su teoría de la relatividad.

Dado que Einstein es el próximo personaje a tratar en el desarrollo del tema de la mecánica cuántica, puede ser interesante hacer un pequeño apartado para ver lo que esto significa. La teoría de la relatividad estudia el espacio de tres dimensiones y el tiempo como un todo tetradimensional, el continuo espacio-tiempo. Observadores que se muevan por el espacio a diferentes velocidades obtienen diferentes visiones de las cosas y. por ejemplo, estarán en desacuerdo en la longitud de un bastón que midan al pasar. Pero el bastón puede concebirse como un ente tetradimensional, y en su movimiento a través del tiempo dibuja una superficie tetradimensional, un hiperrectángulo cuya altura es la longitud del bastón y su anchura es igual al tiempo transcurrido. El área de dicho rectángulo se mide en unidades de longitud × tiempo, y esta área resulta ser la misma para todos los observadores que la midan, incluso aunque ellos discrepen en cuanto a la longitud y al tiempo que están midiendo. De la misma forma, la acción (energía × tiempo) es un equivalente tetradimensional de la energía, y resulta ser la misma para todos los observadores, aun cuando éstos no estén de acuerdo en las cantidades de energía y tiempo que componen la acción. En relatividad especial, existe una ley de conservación de la acción de igual importancia que la ley de la conservación de la energía. Por lo tanto, la constante de Planck resultó extraña porque fue descubierta antes que la teoría de la relatividad.

Esto pone de manifiesto quizá lo peculiar de la naturaleza y de la evolución de la física. De las tres grandes contribuciones de Einstein a la ciencia publicadas en 1905, una, la relatividad especial, parece ser muy diferente de las otras dos, el movimiento browniano y el efecto fotoeléctrico. Estas tres teorías forman parte esencial del cuerpo de la física teórica y, a pesar de la publicidad dada a la teoría de la relatividad, la mayor de las contribuciones de Einstein fue su aportación a la teoría cuántica, donde consiguió remontarse sobre el trabajo de Planck por medio del efecto fotoeléctrico.

El aspecto revolucionario del trabajo de Planck, en 1900, radicaba en que ponía de manifiesto una limitación a la física clásica. No importaba el alcance exacto de tal limitación, sino que el hecho de que existieran fenómenos que no podían ser explicados únicamente con las ideas clásicas elaboradas a partir de la obra de Newton, era suficiente para anunciar la proximidad de una nueva era en la historia de la física. Hay una forma habitual de escribir sobre aventuras en la que el héroe escapa milagrosamente de situaciones del máximo «suspense» al final de cada episodio; con una pirueta nuestro héroe se ve libre. Muchos escritos de divulgación acerca del nacimiento de la mecánica cuántica recuerdan el estilo de las novelas de suspense: «A finales del siglo diecinueve, la física clásica se había dirigido hacia un callejón sin salida. Mediante una pirueta, Planck inventó el cuanto, y la física quedó libre.» Planck se limitó a sugerir que los osciladores eléctricos interiores de los átomos debían estar cuantizados y con ello quería indicar que sólo podían emitir paquetes de energía de ciertos tamaños, en virtud de algún mecanismo interno que hacía inviable la absorción o emisión de radiación en fracciones arbitrarias de dichos paquetes.