En busca de SUSY

John Gribbin

Mi agradecimiento a Benjamin Gribbin por su asistencia editorial

Cuando revisé mi libro En busca del Big Bang para ponerlo al día y explicar la historia completa de la vida y eventual muerte del Universo, algo tenía que salir para hacer sitio al nuevo material. Ese «algo» fue, sobre todo, la discusión detallada del mundo de las partículas subatómicas, que era un tanto tangencial a la historia del Big Bang. Sin embargo, tan pronto realicé la mutilación, varios de los amigos y colegas con quienes había discutido el proyecto comenzaron a quejarse, aduciendo que la visión histórica de conjunto que aquel material proporcionaba era difícil de hallar en textos de divulgación sobre física de partículas, e incluso en libros dirigidos a estudiantes de cursos de física.Lo reconsideré y convine en que quizá tuvieran razón. Así que aquí está, actualizada para finales de los noventa, la historia del mundo de las partículas, desde el descubrimiento del electrón hasta la búsqueda de una teoría de la supersimetría que explique todas las fuerzas y partículas de la naturaleza en un único embalaje matemático. Aunque he aprovechado material de la versión original de mi libro sobre el Big Bang, no se superpone con la versión revisada de En busca del Big Bang. La historia no es completa porque los físicos matemáticos todavía no han encontrado la teoría definitiva de todas las cosas. Pero confío en que arrojará algo de luz sobre por qué buscan la teoría definitiva allí donde la buscan.

John Gribbin

Durante el siglo XIX, los químicos desarrollaron la idea, que se remontaba a los tiempos de Demócrito, en el siglo IV a. C., de que todas las cosas del mundo material están compuestas de partículas diminutas e indivisibles llamadas átomos. Se concebía los átomos como si se tratara de minúsculas bolas de billar, tan diminutas que haría falta un centenar de millones, colocadas una tras otra, para trazar una línea de 1 cm de longitud. Todos los átomos de un elemento dado tenían la misma masa, pero los átomos de elementos diferentes, como el carbono, el oxígeno o el hierro, tenían masas características y pronto se comprendió que las propiedades de los átomos determinaban las propiedades macroscópicas de cantidades mayores del elemento. Cuando los elementos se combinan (por ejemplo, cuando el carbono se quema en el aire), es porque los átomos individuales de cada elemento se combinan para formar moléculas (en el ejemplo, cada átomo de carbono se combina con dos átomos de oxígeno para formar dióxido de carbono).Pero mientras la idea de los átomos acababa de establecerse firmemente, en 1897 el físico inglés J. J. Thomson, que entonces trabajaba en el Laboratorio Cavendish en Cambridge, halló un modo de estudiar fragmentos desprendidos de los átomos. Estos fragmentos eran mucho más pequeños y ligeros que los átomos y tenían carga eléctrica negativa; se les dio el nombre de electrones. Tras de sí dejaban «átomos» con una carga residual positiva, que hoy conocemos como iones. Los experimentos de Thomson en la década de 1890 demostraron que, si bien los átomos de elementos diferentes son diferentes entre sí, todos contienen electrones, y que los electrones desprendidos de un átomo son idénticos a los desprendidos de cualquier otro átomo.

Mientras los físicos todavía luchaban por aceptar la idea de que pueden desprenderse fragmentos de los átomos «indivisibles», el descubrimiento de la radiactividad no sólo les dio una herramienta nueva con la que examinar la estructura de los átomos, sino que demostró (aunque al principio no se viera así) que era posible arrancar de los átomos partículas mucho mayores que los electrones. A principios del siglo XX, el neozelandés Ernest Rutherford, que por aquel entonces trabajaba en la Universidad McGill de Montreal con Frederick Soddy, demostró que la radiactividad consiste en la transformación de átomos de un elemento en átomos de otro elemento. Durante este proceso, los átomos emiten uno o dos tipos de radiación, que Rutherford denominó rayos alfa y rayos beta. Los rayos beta resultaron ser simplemente electrones que se movían a gran velocidad. Los «rayos» alfa también resultaron ser partículas que se movían a gran velocidad, pero mucho mayores: cada una tenía una masa unas cuatro veces mayor que la de un átomo de hidrógeno (el elemento más ligero) y llevaba dos unidades de carga positiva. De hecho, eran idénticas (aparte de la velocidad a la que se desplazaban) a átomos de helio (el segundo elemento más ligero) de los que se hubiera arrancado dos electrones, es decir, iones de helio. Su combinación de masa relativamente grande (comparada con la de un electrón) y alta velocidad ofreció a Rutherford la herramienta que necesitaba para examinar la estructura de los átomos.

Rutherford (quien para entonces trabajaba en la Universidad de Manchester, en Inglaterra) y sus colegas no tardaron en utilizar partículas alfa, producidas por átomos con radiactividad natural, a modo de minúsculas balas con las que disparar a un cristal o a una fina lámina de metal. Encontraron que aunque la mayoría de las veces las partículas alfa atravesaban sin desviarse la lámina de metal que servía de diana, en ocasiones algunas partículas rebotaban casi en la misma dirección de la que provenían. Rutherford encontró una explicación para este comportamiento en 1911, y con ella nos dio el modelo fundamental del átomo que todavía hoy se explica en los colegios.

Rutherford se dio cuenta de que la mayor parte de la materia de un átomo debe estar concentrada en el centro, en lo que llamó núcleo, a cuyo alrededor se halla una nube de electrones. Las partículas alfa, que provienen de átomos radiactivos, son en realidad fragmentos del núcleo atómico que las emite (y son, en efecto, núcleos de helio). Cuando una partícula alfa da en la nube de electrones de un átomo la atraviesa sin verse apenas afectada. Pero los electrones tienen carga negativa, mientras que los átomos son, en su totalidad, eléctricamente neutros. Por tanto, la carga positiva de los átomos debe hallarse concentrada, al igual que la masa, en el núcleo. Las partículas alfa también están cargadas positivamente. Y cuando una partícula alfa da de lleno contra el núcleo de un átomo, la repulsión entre cargas eléctricas iguales las hace parar en seco y luego las empuja de vuelta en la dirección de donde venían.

Experimentos posteriores demostraron la amplia validez del modelo del átomo de Rutherford. La mayor parte de la masa y toda la carga positiva están concentradas en un núcleo que mide una cien millonésima parte del tamaño del átomo. El resto del espacio está ocupado por una tenue nube de ligerísimos electrones con carga negativa. En números redondos, un núcleo mide unos 10-13 cm de diámetro, [1] mientras que un átomo mide unos 10-8 cm de diámetro. Muy aproximadamente, esta proporción es equivalente a la que se da entre un grano de arena colocado en el centro de Carnegie Hall: la gran sala sería el «átomo», mientras que el grano de arena correspondería al «núcleo».

La partícula del núcleo que tiene carga positiva se llama protón. Su carga es exactamente la misma que la del electrón, pero de signo opuesto. Cada protón tiene una masa unas 2.000 veces mayor que la de un electrón. En la versión más simple del modelo del átomo de Rutherford no había más que protones y electrones, en igual número, pero con todos los protones confinados en el núcleo a pesar de tener la misma carga eléctrica, lo cual debiera hacer que se repelieran entre sí. (Las cargas iguales se comportan a este respecto igual que los polos magnéticos). Por consiguiente, tal como veremos, debe existir otra fuerza que sólo opere a distancias muy cortas y que supere la fuerza eléctrica y mantenga el núcleo unido. Pero durante los veinte años que siguieron a la propuesta de este modelo del átomo de Rutherford creció entre los físicos la sospecha de que debía existir otra partícula: una contrapartida del protón con aproximadamente la misma masa pero eléctricamente neutra. Entre otras cosas, la presencia de una partícula como ésta en el núcleo proporcionaría a los protones positivos algo a lo que agarrarse sin ser repelidos eléctricamente. Y la presencia de neutrones, como pronto se les llamó, explicaría por qué algunos átomos podían tener propiedades químicas idénticas a otros, pero una masa ligeramente diferente.

Las propiedades químicas dependen de la nube de electrones de un átomo, la «cara» visible que muestra a otros átomos. Los átomos con química idéntica deben tener idéntico número de electrones y, por consiguiente, idéntico número de protones. Pero pueden tener un número diferente de neutrones y, por tanto, masa diferente. Estos primos cercanos entre los átomos reciben el nombre de isótopos.

Hoy sabemos que la gran variedad de elementos del mundo se basa en este simple esquema. El hidrógeno, con un núcleo que consiste en un solo protón, con un solo electrón a su alrededor, es el más sencillo. La forma más común de carbono, el átomo que está en la base de todo lo vivo, tiene seis protones y seis neutrones en el núcleo, y seis electrones en la nube que lo rodea. Pero existen núcleos que contienen muchas más partículas (más nucleones). El hierro tiene 26 protones en el núcleo y, en el isótopo más común, 30 neutrones, lo que suma un total de 56 nucleones; mientras que el uranio es uno de los elementos naturales más pesados, con 92 protones y nada menos que 143 neutrones en cada núcleo de uranio-235, el isótopo radioactivo que se usa como fuente de energía nuclear.

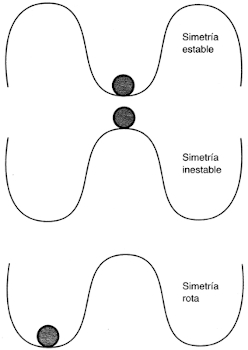

Es posible obtener energía de la fisión de núcleos muy pesados porque el estado más estable en que se puede encontrar un núcleo, con la mínima energía, es el de hierro-56. En términos de energía, el hierro-56 está en el fondo de un valle; los núcleos más ligeros, como los del oxígeno, el carbono, el helio y el hidrógeno, se disponen sobre una de las laderas, y los núcleos más pesados, como el cobalto, el níquel, el uranio y el plutonio, sobre la otra ladera. De igual modo que es más fácil darle una patada a una

pelota para que baje de la ladera al fondo del valle que para que suba desde el valle por la ladera, si se puede persuadir a un elemento pesado para que se fisione, en las circunstancias adecuadas puede formar núcleos más estables situados «más abajo en la ladera», liberando energía en el proceso. El proceso de fisión es el que impulsa las bombas nucleares. El proceso de fusión proporciona la energía de las bombas de hidrógeno (o bombas de fusión) y de las estrellas, como el Sol; en ambos casos, los núcleos de hidrógeno se convierten en núcleos de helio. Pero en los años veinte, todo esto estaba todavía reservado para el futuro. Aunque en aquella década se disponía de evidencia circunstancial de la existencia de neutrones, no fue hasta 1932 cuando James Chadwick, un antiguo estudiante de Rutherford que trabajaba en el Laboratorio Cavendish (del que entonces Rutherford era director), realizó los experimentos que demostraron la existencia de los neutrones.

Así pues, la imagen que la mayoría de las personas cultas tienen de la estructura de los átomos en tanto que compuestos de tres tipos de partículas (protones, neutrones y electrones) se remonta a hace poco más de sesenta y cinco años, menos que la vida media de una persona. En ese periodo, las cosas se tornaron primero mucho más complejas para los físicos de partículas, y luego empezaron a simplificarse. Aquellas complicaciones, y la búsqueda de un principio simplificador que pusiera orden al mundo de las partículas, es de lo que trata este libro. Muchos físicos creen hoy en día que están a punto de explicar todas las fuerzas y partículas de la naturaleza mediante un único conjunto de ecuaciones, una «teoría de todas las cosas» en la que participaría un fenómeno conocido como supersimetría, o SUSY. La historia de la búsqueda de SUSY comienza con la comprensión, a principios del siglo XX, de que las partículas subatómicas como los electrones no obedecen las leyes de la física que se aplican, como Isaac Newton descubriera tres siglos antes, al mundo de objetos como las bolas de billar, las manzanas o la Luna. Aquéllas, en cambio, obedecen las leyes del mundo de la física cuántica, en el que las partículas se mezclan con las ondas, nada es cierto y reina la probabilidad.

Capítulo 1

Física cuántica para principiantes

Pero los físicos apenas habían comenzado a reconocer esta atractiva posibilidad cuando el castillo de naipes que habían construido tan arduamente se vino al suelo. Resultó que el comportamiento de la luz sólo se podía explicar, en algunas ocasiones, en términos de partículas (fotones), en tanto que la explicación o modelo ondulatorio seguía siendo el único válido en otras circunstancias. Y por si fuera poco haber de preocuparse de ondas que a veces se comportan como partículas, los físicos no tardaron en darse cuenta de que las partículas a veces también se pueden comportar como ondas. Entre tanto, Albert Einstein estaba echando abajo el conocimiento establecido acerca del espacio, el tiempo y la gravedad con sus teorías sobre la relatividad. Para cuando la tormenta comenzó a amainar, a finales de los años veinte, los físicos disponían de una nueva visión del mundo radicalmente diferente de la antigua. Esta nueva visión todavía es el fundamento de la que tenemos en la actualidad. Nos dice que no existen ondas o partículas puras sino, al nivel más fundamental, entidades que se describen adecuadamente como mezclas de onda y partícula, a las que ocasionalmente se designa «ondículas». Nos dice que es imposible predecir con absoluta certeza el resultado de ningún experimento atómico o, en realidad, de ningún evento del Universo, y que nuestro mundo está gobernado por probabilidades. Y nos dice que es imposible conocer simultáneamente tanto la posición exacta de un objeto como su momento (hacia dónde va) exacto.

Cómo y por qué llegaron los físicos a estas sorprendentes conclusiones es algo que he explicado con todo detalle en mi libro En busca del gato de Schrödinger. Aquí sólo pretendo bosquejar esta nueva visión del mundo sin entrar en los detalles históricos y experimentales sobre los que se fundamenta. Pero los cimientos son seguros; la física cuántica tiene una base tan sólida, y tan meticulosamente establecida mediante experimentos y observaciones, como la teoría general de la relatividad de Einstein. En conjunción, estas dos teorías proporcionan la mejor descripción del Universo y todo lo que contiene de que disponemos hoy, y se tiene la esperanza, bien fundamentada, de que estos dos pilares de la física del siglo XX puedan combinarse en una única teoría unificada.

§. Fotones

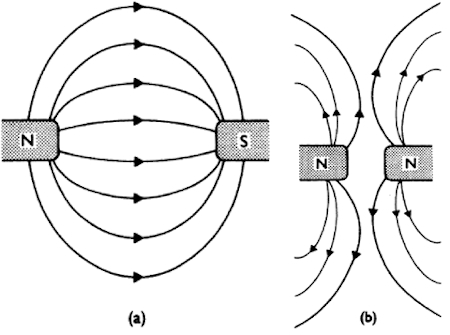

El mejor punto donde comenzar la historia de la física cuántica es con el trabajo del gran físico escocés James Clerk Maxwell, en el tercer cuarto del siglo XIX. Maxwell, que nació en Edimburgo en 1831, hizo numerosas contribuciones a la física, pero la más notable fue, sin duda, su teoría del electromagnetismo. Como muchos de sus contemporáneos y antecesores inmediatos, Maxwell estaba fascinado por la observación de que cuando una corriente eléctrica circula por un alambre crea un campo magnético que, en sus propiedades más fundamentales, es idéntico al creado por un imán. Por ejemplo, el campo así creado alrededor de un alambre por el que circule una corriente desviará la aguja de una brújula colocada cerca del alambre. Pero, además, si se mueve un imán a lo largo de un alambre, se produce una corriente eléctrica. Mover electricidad, una corriente, produce magnetismo, y mover un imán produce una corriente eléctrica. Las fuerzas eléctricas y las fuerzas magnéticas, que en otro tiempo parecieran fenómenos totalmente separados, ahora parecían facetas de un todo mayor, el campo electromagnético.

Maxwell intentó escribir un conjunto de ecuaciones que enlazaran y explicaran todos los fenómenos eléctricos y magnéticos que los físicos habían observado y medido. Escribió cuatro ecuaciones: una para describir el campo magnético producido por una corriente eléctrica, una segunda ecuación para describir el campo eléctrico producido por un campo magnético cambiante, una tercera para describir el campo eléctrico producido por la propia carga eléctrica, y la cuarta para describir el propio campo magnético, incluyendo la observación de que los polos magnéticos siempre se dan en pares (los equivalentes de un norte y un sur). Pero cuando Maxwell examinó las ecuaciones, halló que eran matemáticamente incorrectas. Para corregir la matemática, hubo de introducir un nuevo término en la primera ecuación, un término que equivale a la descripción de cómo un campo magnético puede producir un campo eléctrico cambiante sin que fluya corriente.

Por aquel entonces, nadie había observado nunca tal fenómeno. Pero una vez Maxwell reconstruyó las ecuaciones en la forma matemática más elegante, la razón para este término adicional se vio con claridad. Los físicos conocían los condensadores (ahora llamados capacitadores), que consisten en dos placas planas de metal distanciadas por una pequeña separación a través de la cual puede establecerse un potencial. Una de las placas puede conectarse al polo positivo de una batería y la otra al polo negativo. En este caso, una de las placas acumula una carga eléctrica positiva, y la otra, una carga negativa. La separación entre las placas está sometida a un intenso campo eléctrico, pero no fluye corriente eléctrica y no hay campo magnético. El nuevo término matemático de Maxwell describía, entre otras cosas, lo que ocurre entre las placas de un capacitador como el descrito justo en el momento de conectar las placas a la batería. A medida que se acumula una carga eléctrica sobre las placas, en la separación se establece un campo eléctrico que cambia rápidamente y, de acuerdo con las ecuaciones, éste debiera producir un campo magnético. Maxwell no tardó en confirmar que las ecuaciones eran correctas: le bastó con colocar una brújula en la separación entre las dos placas y observar cómo la aguja se desviaba en el momento en que las placas se conectaban a la batería. Como en la mejores teorías científicas, la nueva teoría del electromagnetismo había predicho con éxito el resultado de un experimento.

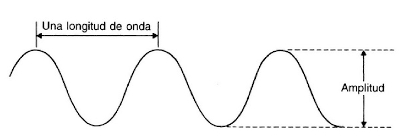

Figura 1.1. Una onda se define por su amplitud y su longitud de onda.

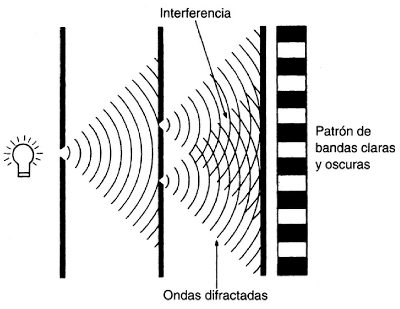

Figura 1.2. Cuando dos ondas se encuentran, interfieren. Esto se ve muy claramente cuando se hace pasar luz de color puro de un emisor puntual a través de dos agujeros diminutos en una pantalla. Los dos grupos de ondas que se extienden a partir de cada agujero interfieren para formar en la segunda pantalla un patrón característico de bandas claras y oscuras.

Thomas Young, un físico y médico británico nacido en Somerset en 1773, realizó el experimento crucial a principios del siglo XIX, cuando proyectó un haz de luz pura de un solo color (luz monocromática) a través de un par de rendijas estrechas en una pantalla para así producir un par de grupos de «ondas» y hacer un patrón clásico de interferencia en una segunda pantalla. Este trabajo puso fin a la idea, que se remontaba a Newton, de que la luz estaba compuesta de pequeñas partículas o corpúsculos.

Las investigaciones de Maxwell y de Young proporcionaron conjuntamente lo que parecía una comprensión cabal de la naturaleza de la luz. Los experimentos de interferencia permitieron medir la longitud de onda de la luz —la distancia de cresta a cresta—, que resultó ser de aproximadamente una diezmillonésima (10-7) de metro. La diferencia entre los distintos colores del espectro corresponde a diferentes longitudes de onda (la luz roja tiene una longitud de onda varias veces más larga que la luz azul), y Maxwell infirió que debía existir radiación electromagnética en un rango más amplio de longitudes de onda, que se extendiera mucho más allá de los límites del espectro visible, tanto de longitudes de onda más corta como de longitudes de onda más larga. Antes de que acabara el siglo XIX, el pionero alemán Heinrich Hertz consiguió producir ondas de radio, con una longitud de onda de varios metros, y confirmar de este modo la predicción de Maxwell.

Todo el espectro electromagnético, desde las ondas de radio hasta la luz visible y, con una longitud de onda aún más corta, los rayos X, obedece las leyes de Maxwell. Estas ecuaciones, que describen cómo se propaga la radiación electromagnética en forma de ondas, son el fundamento del diseño de objetos cotidianos como los televisores y las radios. También son el fundamento de la interpretación cosmológica de la desviación al rojo. La concepción de la luz como una onda es, pues, un concepto firme y familiar. Y, sin embargo, desde principios del siglo XX ha estado claro que Newton siempre había tenido razón. La luz y todas las formas de radiación electromagnética pueden describirse en términos de partículas, que ahora se llaman fotones. Bajo ciertas circunstancias, el comportamiento de la luz puede explicarse mejor en términos de fotones, como Einstein demostró en 1905.

Las primeras indicaciones de la naturaleza corpuscular de la luz aparecieron en 1900, cuando Max Planck, un físico alemán nacido en Kiel en 1858, se vio forzado a introducir la idea de paquetes discretos de luz en las ecuaciones que describen la emisión de luz, o de cualquier otra radiación electromagnética, por un cuerpo caliente. Este problema había llevado de cabeza a los físicos desde la última década del siglo XIX. Conjeturaban que la luz se generaba por la vibración de partículas cargadas eléctricamente dentro de un objeto, unas vibraciones en las que participaban los propios átomos y que proporcionaban el empuje necesario para poner en marcha las ondas descritas por las ecuaciones de Maxwell. Y sabían, gracias a observaciones y experimentos, que el tipo de radiación producida por un objeto depende de su temperatura. Muchas observaciones cotidianas lo confirman: una pieza de metal calentada hasta el blanco (por ejemplo, un atizador) está mucho más caliente que una pieza de metal al rojo vivo, y una pieza demasiado fría para emitir ningún tipo de radiación puede estar todavía demasiado caliente para agarrarla con las manos. Cualquiera de estos objetos emite ondas electromagnéticas de un amplio rango de longitudes de onda, pero la intensidad máxima de la radiación se presenta siempre a una longitud de onda, característica de la temperatura del objeto, que es más corta para objetos más calientes. La naturaleza del espectro general de radiación es siempre la misma, pero la posición del pico es una indicación muy precisa de la temperatura de la radiación: para un emisor «perfecto», Se trata del famoso espectro del «cuerpo negro». Pero hasta la entrada en escena de Planck, nadie había conseguido manipular las ecuaciones electromagnéticas de manera que predijeran la naturaleza del espectro del cuerpo negro.

Planck encontró que la única manera de explicar la naturaleza del espectro del cuerpo negro tal como se observa era aceptando que la luz (y con esto nos referimos ahora a cualquier tipo de radiación electromagnética) sólo se puede emitir a través de la vibración de cargas dentro de los átomos en pequeños paquetes de energía. [2] Esto implica que los átomos sólo pueden absorber luz en paquetes de ciertas medidas. Planck expresó éstos en términos de la frecuencia de la radiación, denotada mediante la letra griega nu, ν. La frecuencia puede concebirse como el número de crestas de onda que pasan por un punto fijo cada segundo; para luz de una longitud de onda de 10-7 metros y una velocidad de 300.000 kilómetros por segundo, la frecuencia es de 3×1015 Hertz, una unidad nombrada en honor del pionero de la radio. Planck halló que podía explicarse el espectro observado de un cuerpo negro si para cada frecuencia de luz existiera una cantidad de energía característica igual a la frecuencia multiplicada por una constante fundamental, a la que denominó h. Esta energía, E = hv, es la cantidad de energía más pequeña que un átomo puede emitir o absorber, y sólo puede emitir o absorber cantidades que sean múltiplos exactos (1, 2, 3, 4.. .n...) de esta energía fundamental.

Planck no sugirió que la energía de la luz existiese solamente en pequeños paquetes con energía hv; creía que esta restricción sobre la emisión o absorción tenía algo que ver con la naturaleza de los osciladores cargados del interior de los objetos calientes. Sin embargo, consiguió calcular el valor de h, que es el mismo para cualquier tipo de radiación. Este valor, que hoy se denomina constante de Planck, toma el minúsculo valor de -6,6×10-34 julios × segundo. Aun para la luz de una frecuencia de 1015 Hz, la unidad de energía fundamental no es más que 10-18 julios, y se requiere 6.000 julios para mantener encendida durante un minuto una bombilla normal. La energía radiada por una bombilla parece continua sólo porque h es extremadamente pequeña; en realidad, la luz visible está constituida por millones de diminutos paquetes de energía.

La propuesta de Planck fue recibida al principio con reservas. Explicaba el espectro del cuerpo negro, pero sólo gracias a un juego de manos matemático, un truco. Einstein, que por entonces era un físico casi desconocido que todavía trabajaba en la oficina de patentes de Suiza, le dio al truco matemático una realidad física respetable al mostrar que otro de los grandes rompecabezas de la época podía explicarse si los pequeños paquetes de energía tenían una existencia real, y que la luz sólo existía en piezas con energía hv. La solución propuesta por Einstein al rompecabezas de la naturaleza de la luz ofrece una explicación física mucho más clara de por qué ha de ser así.

El efecto fotoeléctrico ocurre cuando se irradia una superficie metálica en el vacío. La luz literalmente golpea y arranca electrones de la superficie del metal, y es posible detectar los electrones y medir la energía que llevan. Este efecto lo había descubierto en 1899 el húngaro Phillip Lenard. Que la luz pudiera arrancar electrones de la superficie del metal no constituía ninguna sorpresa; lo que sí fue una sorpresa fue descubrir la relación que existía entre la energía de la luz y la energía de los electrones. Lenard utilizó luz monocromática, de modo que todas las ondas tenían la misma frecuencia. Una luz brillante obviamente tiene más energía que una luz tenue, así que sería de esperar que si se irradiara la superficie de un metal con una luz brillante los electrones arrancados llevaran más energía que si la luz proyectada fuera tenue. Pero lo que observó Lenard es que, en tanto que no se modificara la frecuencia de la luz, no importaba para nada la intensidad de la luz: los electrones arrancados de la superficie del metal llevaban siempre la misma cantidad de energía.

Cuando Lenard acercaba la lámpara al metal, de modo que proyectara sobre éste una luz más brillante, el efecto fotoeléctrico efectivamente producía más electrones, en correspondencia con la mayor cantidad de energía procedente de la luz más brillante. Pero cada uno de los electrones tenía la misma cantidad de energía, la misma que portaban cuando la luz era más tenue, aunque entonces el número de electrones arrancados fuera menor. Por otro lado, si utilizaba luz de mayor frecuencia (es decir, de longitud de onda más corta), los electrones producidos tenían más energía aun cuando la luz fuera tenue. Una vez más, todos tenían la misma energía, pero esta energía era mayor que la energía de los electrones producidos al utilizar luz de menor frecuencia. La razón de todas estas observaciones parece simple desde la perspectiva que nos da nuestro conocimiento actual, pero cuando Einstein la propuso, la explicación era revolucionaria. Simplemente sugirió (y proporcionó los cálculos matemáticos necesarios para respaldar su sugerencia) que un rayo de luz de frecuencia v está compuesto por una corriente de partículas, que hoy conocemos como fotones, cada una de las cuales tiene energía hv. Se arranca un electrón de un metal cuando un fotón golpea de lleno un electrón. De este modo, cada electrón lleva la cantidad de energía hv proporcionada por un fotón, menos la energía necesaria para arrancar el electrón. Cuanto más intensa sea la luz, más fotones habrá y, por consiguiente, se producirán más electrones. Pero la energía de cada fotón seguirá siendo la misma. La única manera de aumentar la energía de cada fotoelectrón individual es aumentando la energía de los fotones que los arrancan del metal, y la única manera de conseguir esto es aumentando v.

Esta sugerencia no fue universalmente aclamada por los físicos en el momento. Todos sabían, y el experimento de Young de la doble rendija y las ecuaciones de Maxwell lo establecieron fuera de toda duda razonable, que la luz era una onda electromagnética. A lo que parecía, sólo un insensato recién llegado sin una auténtica comprensión de la física podía osar reavivar la absurda idea newtoniana de los corpúsculos de luz. De hecho, un físico experimental, el americano Robert Millikan, se enfureció tanto con la idea que dedicó diez años a realizar experimentos con el objeto de demostrar que Einstein se equivocaba. Sólo consiguió demostrar que tenía razón, y de paso obtener una medida muy precisa del valor de h y ayudar a asegurar el Premio Nobel de Física para Planck en 1918, para Einstein en 1921 por su explicación del efecto fotoeléctrico, y para el propio Millikan en 1923. No hay duda que todos estos premios fueron merecidos; lo sorprendente es que Einstein nunca recibiera un segundo Premio Nobel por su teoría general de la relatividad. [3]

Para cuando los pioneros de la física cuántica recibían estos honores, la introducción por Planck del cuanto, hv, en la física atómica ya había ayudado a otros físicos, dirigidos por el danés Niels Bohr, a desarrollar el primer modelo satisfactorio del átomo, un modelo basado en la concepción, procedente del trabajo de Rutherford, de un pequeño núcleo cargado positivamente alrededor del cual orbitaban electrones todavía más pequeños, cargados negativamente, más o menos de la misma manera que los planetas describen órbitas alrededor del Sol. El nuevo modelo postulaba que estas órbitas estaban separadas por intervalos que correspondían al cuanto básico de energía y que un electrón podía saltar de una órbita a otra, pero no podía existir en un estado intermedio. Para saltar de una órbita de mayor energía a otra de menor energía, había de emitir un fotón con energía hv, mientras que para saltar de una órbita de menor energía a otra de mayor energía necesitaba absorber un fotón, hv. Pero como no existen medios fotones, no podía saltar hasta un estado intermedio entre las dos órbitas permitidas.

Este modelo estaba lejos de ser completo, pero proporcionó a los físicos una idea acerca de cómo se comportan los electrones en los átomos, y les ayudó a comenzar a explicar las líneas brillantes y oscuras de los espectros atómicos. Las líneas brillantes simplemente corresponden a la emisión de fotones cuando un electrón baja varios escalones de la escala de energía; las líneas oscuras son los «vacíos» que quedan en el espectro cuando los electrones absorben fotones con una cantidad precisa de energía y suben varios escalones de la escala de energía. Pero quedaban muchas preguntas por resolver a principios de los años veinte. Para empezar, la teoría de la radiación electromagnética no era una sola teoría, sino dos. En ocasiones la luz y los rayos X tenían que describirse mediante las ecuaciones ondulatorias de Maxwell; otras veces era necesario recurrir a los fotones de Einstein; otras veces no quedaba más remedio que usar una mezcla de las dos teorías, como en el cálculo de Planck del espectro de un cuerpo negro. Y, la cuestión más apremiante, ¿qué es exactamente lo que determina qué niveles de energía pueden ser ocupados por los electrones? O, en otras palabras, ¿cómo se explica el número de escalones de la escala de energía y la distancia entre ellos? Las respuestas no surgieron de una racionalización de la teoría de la luz y un retorno a la tranquila lógica de la física «clásica» del siglo XIX, sino que fueron el resultado de extender al mundo de las partículas la revolución que afectaba a las ondas. En particular, como Louis de Broglie sugirió ante una asombrada comunidad de físicos en 1924, si las ondas de luz se comportan como partículas, ¿por qué no pueden los electrones, a los que solía considerarse partículas, comportarse como ondas?

§. Electrones

De Broglie, nacido en 1892, fue el hijo menor de un noble francés, y llegó a heredar el título nobiliario de su hermano, convirtiéndose en el duque de Broglie. Su hermano, Maurice, fue un pionero del desarrollo de la espectroscopia de rayos X, y fue a través de Maurice que Louis tuvo su primer contacto con la revolución cuántica, con la que quedó fascinado. La idea que desarrolló en su tesis doctoral, defendida en la Sorbona en 1924, era brillante en su simplicidad y estaba respaldada por un meticuloso análisis matemático. Me limitaré a describir el modelo físico simple de la naturaleza de la materia que propuso De Broglie. Quien esté interesado en los detalles matemáticos habrá de buscar en otro lugar.

Einstein había desarrollado la ecuación de la energía para las partículas materiales, E = mc2; Planck, con un poco de ayuda de Einstein, obtuvo una ecuación semejante para los fotones, E =hv. Aunque los fotones no tienen masa, sí tienen momento, de lo contrario no podrían arrancar electrones de la superficie de un metal. Para una partícula cualquiera, el momento es igual a su masa (m) multiplicada por su velocidad (v). Un objeto ligero que se desplace muy rápidamente lleva tanta energía como un objeto pesado que se desplace lentamente, y puede golpear con la misma fuerza. Piénsese en el impacto de una bala comparado con una pelota. Pero los golpes más fuertes provienen, por supuesto, de objetos pesados que se muevan rápidamente. La velocidad de un fotón es c. Y si aislamos el factor (mc) de la ecuación de Einstein y lo reemplazamos por la letra p para representar el momento, obtenemos una nueva ecuación, E = pc, que se puede aplicar igualmente a la materia normal y a los fotones.

Así que De Broglie combinó esta ecuación con la de Planck. E = pe = hv. Reordenando los términos un poco se obtiene, para un fotón, p = hv/e. Pero la velocidad de una onda (c) dividida por su frecuencia (v) no es sino la longitud de onda. De modo que la versión de De Broglie de esta ecuación nos dice que, para un fotón, el momento es igual a la constante de Planck dividida por la longitud de onda. Esto relaciona directamente la naturaleza corpuscular de los fotones (momento) con su naturaleza ondulatoria (longitud de onda) a través de la constante de Planck. Pero, ¿para qué parar aquí?, se preguntó De Broglie. Los electrones tienen momento, y conocemos el valor de la constante de Planck. Si reordenamos de nuevo la ecuación, obtenemos una relación que nos dice que la longitud de onda es igual a h dividido por el momento. En otras palabras, cualquier partícula, por ejemplo un electrón, es también una onda, y su longitud de onda depende únicamente de su momento y de la constante de Planck. En el caso de las partículas macroscópicas de nuestra experiencia diaria, la masa y, por consiguiente, el momento, es tan grande comparado con h que podemos desatender completamente la naturaleza ondulatoria de la luz. Para estos objetos, h dividido por el momento es prácticamente igual a cero. Pero en el caso de los electrones, cuya masa es tan sólo 9 x 10-28 gramos, las cifras son más comparables y el aspecto ondulatorio no puede desdeñarse.

De Broglie sugirió a su tribunal de tesis que esta extraña ecuación correspondía a una realidad física, y que era posible diseñar experimentos para medir la longitud de onda de los electrones. Los miembros de su tribunal no sabían si tomarse esta idea en serio o no, y vieron esta parte de su tesis más como un truco matemático astuto que como una idea de valor práctico. Su director, Paul Langevin, le envió una copia de la tesis a Einstein, quien advirtió inmediatamente el valor del trabajo y sus implicaciones, y no sólo reafirmó ante Langevin su corrección (de manera que De Broglie fue investido doctor), sino que pasó la noticia a otros investigadores. En el plazo de unos años, grupos de investigación tanto en Estados Unidos como en Gran Bretaña habían conseguido medir la longitud de onda de haces de electrones. Lo consiguieron mediante el análisis de la dispersión de electrones por átomos de una red cristalina regular que, para los electrones, es el equivalente del experimento de la doble rendija de Young, e igualmente concluyente. [4] Sólo las ondas pueden interactuar entre sí para formar patrones de interferencia y, en las condiciones adecuadas, los electrones hacen lo propio. Entretanto, el austríaco Erwin Schrodinger había desarrollado una ecuación de onda para el electrón, equivalente a las ecuaciones de Maxwell para la luz, que resultó ser una de las claves para desarrollar un modelo coherente del átomo. De Broglie recibió un merecido Premio Nobel de Física en 1929. Para entonces, estaba claro que todas las «ondas» deben tratarse como «partículas», y que todas las «partículas» deben tratarse como «ondas». La confusión no se nos presenta en la vida cotidiana, para los objetos lo bastante grandes para poder verlos o para las olas del mar o las ondas de un estanque. Pero es crucial para comprender los átomos y los fenómenos subatómicos. Los físicos de finales de los años veinte estaban contentos de disponer por fin de una teoría coherente del átomo, aunque para conseguirlo hubieran tenido que aceptar algunas ideas extrañas sobre la dualidad onda-partícula. Sin embargo, este aspecto extraño de la realidad atómica resultó ser la menor de las extrañezas del mundo cuántico que se estaba abriendo ante su asombrada mirada.

§. El misterio fundamental

Hay un experimento que contiene la esencia de la física cuántica y desvela su misterio fundamental. Se trata de la versión moderna del experimento de la rendija doble que Young utilizó para demostrar que la luz es una forma de onda. En la práctica, este experimento puede realizarse con luz o electrones o cualquier otro objeto, como los protones; no precisa literalmente dos rendijas, sino quizá el equivalente de una red de rendijas, una rejilla de difracción, o los átomos regularmente dispuestos en un cristal, donde puedan rebotar los rayos X o los electrones. Pero para describir el misterio fundamental en su forma más pura me limitaré a hablar de electrones y de exactamente dos rendijas. Todo lo que explicaré acerca del comportamiento de los electrones en estas circunstancias ha sido contrastado y verificado mediante experimentos de este tipo con electrones y fotones y otras «partículas». Nada de esto es una simple extrañeza matemática hipotética de las ecuaciones; todo está probado y contrastado y es cierto.

La forma idealizada del experimento es fácil de describir. Consiste en una fuente de electrones (un «cañón» de electrones como el que hay en el tubo de los televisores), una pantalla con dos agujeros (agujeros minúsculos, pues han de ser pequeños en comparación con la longitud de onda de un electrón, y por esta razón los átomos de un cristal parecen hechos a medida) y un detector. El detector puede ser una pantalla, como la pantalla de un televisor, que emite un destello de luz cuando un electrón choca contra ella. Lo que importa es que dispongamos de alguna manera de registrar cuándo y dónde chocan los electrones con el detector, y de sumar el número de electrones que chocan con la pantalla de detección en cada punto. Cuando las ondas atraviesan un sistema como el descrito, cada uno de los agujeros de la primera pantalla se convierte en una fuente de ondas que se extienden en un semicírculo y se desplazan al unísono con las ondas procedentes del otro agujero. Allí donde las ondas se suman, producen vibraciones amplias; allí donde se cancelan, no se observa ninguna vibración. Ésta es la razón por la cual al realizar este experimento con luz se obtiene una serie de bandas claras y oscuras en la pantalla de detección.

Si la primera pantalla tiene un solo agujero, entonces se produce una simple mancha (o banda) brillante de luz en el detector, más brillante en el centro, y progresivamente menos brillante hacia afuera.

Lo mismo ocurre cuando se dispara un haz de electrones a través de una pantalla con un solo agujero (una rendija). La pantalla de detección registra la mayoría de destellos en línea con el agujero, y unos pocos a lado y lado de la región donde el haz de electrones es más intenso. Para probar que ocurre así en nuestro experimento de la rendija doble, podemos tapar primero uno de los agujeros y luego el otro. En ambos casos se obtiene una mancha brillante en la pantalla que se difumina suavemente a los lados. Pero cuando ambos agujeros están abiertos, se produce un claro patrón de difracción en la pantalla. Los destellos que marcan la llegada de cada uno de los electrones forman bandas brillantes separadas por regiones oscuras. La naturaleza ondulatoria de los electrones explica este comportamiento. Las ondas de electrones que atraviesan cada uno de los dos agujeros interfieren entre sí, cancelándose en algunos lugares y reforzándose en otros tal como hacen las ondas.

Hasta aquí, todo bien. Es más que extraño que los electrones puedan comportarse como ondas mientras atraviesan este dispositivo experimental, para luego, de golpe, fundirse en forma de corpúsculos duros que producen destellos al chocar contra la pantalla de detección, pero al combinar las ideas de onda y partícula podemos comenzar a convencernos de que hasta cierto punto lo comprendemos. Después de todo, una ola del mar está compuesta por infinidad de partículas diminutas (las moléculas de agua) en movimiento. Si disparamos cientos de miles de electrones en un haz a través de los dos agujeros, quizá no sea tan sorprendente que de alguna manera puedan comportarse como ondas al tiempo que retienen su identidad como pequeñas partículas. Si en el experimento disparáramos un solo electrón, esperaríamos que lógicamente pasara por uno u otro de los agujeros. El patrón de difracción que observamos es simplemente, de acuerdo con la lógica mundana, el resultado de observar muchos electrones al mismo tiempo.

Así pues, ¿qué ocurre cuando se realiza el experimento disparando un solo electrón? Obviamente, cuando se observa un solo destello en la pantalla del otro lado no se puede inferir mucho sobre el comportamiento del electrón. Pero se puede repetir el experimento del único disparo una y otra vez, observando todos los destellos y apuntando sus posiciones en la pantalla. Cuando se hace esto, se halla que los destellos poco a poco construyen el familiar patrón de difracción. Cada uno de los electrones, al atravesar el aparato, de alguna manera se comporta como una onda e interfiere consigo mismo dirigiendo su propia trayectoria hacia la región brillante correspondiente del patrón de difracción. La única explicación alternativa sería que todos los electrones que atraviesan el aparato en momentos diferentes interfiriesen entre sí, o con la «memoria» de los otros, para producir el patrón de difracción.

Diríase que cada uno de los electrones atraviesa ambas rendijas. Una locura. Pero podemos diseñar un grupo adicional de detectores que registren el agujero que atraviesa cada uno de los electrones, y repetir entonces el experimento para ver qué es lo que pasa realmente. Cuando se hace esto, no se observa que cada uno de los detectores en cada uno de los agujeros indique el paso de un electrón (o de medio electrón). El electrón pasa a veces por una de las rendijas y a veces por la otra. ¿Pero qué ocurre si disparamos miles de electrones por el aparato, uno tras otro? Nuevamente, se observa un patrón en la pantalla de detección. ¡Pero no es el patrón de difracción! Es simplemente la combinación de las dos manchas brillantes que se obtienen cuando sólo está abierto uno u otro de los agujeros, sin que se dé indicación alguna de un patrón de interferencia.

Esto es muy extraño. Cada vez que intentamos detectar un electrón, se comporta como una partícula. Pero si no lo estamos observando, se comporta como una onda. Cuando miramos cuál de los agujeros atraviesa, lo hace por uno solo de ellos, como si el otro no existiera. Pero cuando no observamos el paso del electrón, de algún modo «sabe» de la existencia de dos agujeros, y actúa como si atravesara los dos a la vez.

Los físicos cuánticos han encontrado maneras de poner todo esto en palabras. Dicen que cada electrón lleva asociado un cierto tipo de onda. Es la llamada «función de onda» que, en principio, se extiende hasta llenar el Universo entero. La ecuación de Schrödinger describe estas funciones de onda y cómo interaccionan entre sí. La función de onda es más fuerte en una región, la que en nuestro lenguaje mundano corresponde a la posición del electrón, y aunque se debilita con la distancia, sigue existiendo lejos de la «posición» del electrón. Las ecuaciones predicen correctamente el comportamiento de los electrones en diferentes circunstancias, incluido el caso de interferencia entre electrones al atravesar dos rendijas. Cuando observamos un electrón, o lo medimos con un detector de partículas, la función de onda se «colapsa». En ese instante, la posición del electrón se conoce con la precisión que permiten las leyes fundamentales. Pero en cuanto dejamos de observarlo, la función de onda se expande de nuevo e interfiere con las funciones de onda de otros electrones, e incluso, bajo determinadas condiciones, con la suya propia. [5]

Todo esto se puede cuantificar matemáticamente con mucha precisión, y hace posible calcular cómo se disponen los electrones en los átomos, cómo se combinan los átomos para formar moléculas, y muchas otras cosas. El término del argot científico «colapso de la función de onda» (que tiene un significado matemático preciso en la teoría cuántica) equivale a decir que sólo podemos saber dónde está algo mientras lo observamos. Basta un parpadeo para que lo perdamos de vista.

Y el comportamiento de las partículas depende de si las estarnos observando. Cuando observamos el paso de electrones por los dos agujeros, los electrones se comportan de modo diferente a cuando no estamos observando. El observador es, en la física cuántica, una parte integral del experimento: lo que el observador decida mirar desempeña un papel fundamental en lo que ocurrirá.

Las implicaciones de todo esto son realmente profundas.

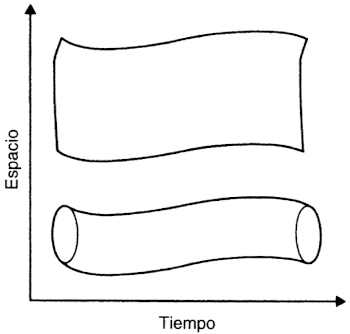

Para empezar, ya no podemos decir que un electrón, en principio identificable como un objeto único, comienza en un lugar de nuestro experimento y se desplaza siguiendo un único camino (una trayectoria) hasta llegar al otro lado. El propio concepto de «trayectoria» continua es un vestigio de las ideas newtonianas clásicas, y debe ser abandonado. En su lugar, los físicos cuánticos hablan de «eventos». Los eventos pueden ocurrir en un cierto orden en el tiempo, pero no nos dicen nada acerca de lo que ocurre con las partículas involucradas cuando no las observamos. Todo lo que podemos decir es que observamos un electrón en el inicio (evento 1), y que observamos un electrón en el final (evento 2). No podemos decir absolutamente nada sobre lo que hace en medio; ni siquiera podemos asegurar que en ambos eventos se esté detectando el mismo electrón. Si disparamos dos electrones a la vez, aunque los dos llegarán a la pantalla de detección algo más tarde, no existe manera de saber cuál es cuál.

Los electrones son indistinguibles entre sí en un sentido mucho más profundo que cualquiera de los objetos de producción en masa del mundo corriente, como cuando decimos, por ejemplo, que los sujetapapeles son indistinguibles unos de otros. Los electrones de un átomo no son entidades físicas individuales, cada uno asociado a una órbita particular. Todo lo que podemos decir es que un tipo particular de átomo se comporta como si estuviera asociado a una combinación de ocho, diez, o el número que sea de funciones de onda de electrones. Si realizamos un experimento diseñado para examinar un átomo (quizás bombardeándolo con fotones, como en el experimento fotoeléctrico), una o más de las funciones de onda de electrones puede modificarse de tal modo que exista una probabilidad elevada de que detectemos un electrón fuera del átomo, como si hubiera expulsado una pequeña partícula. Pero las únicas realidades son las que observamos; todo lo demás es conjetura, modelos hipotéticos que construimos en nuestras mentes y con nuestras ecuaciones, y que nos permiten elaborar una imagen de lo que está ocurriendo.

¿Qué es más real, la onda o la partícula? Depende de lo que se le pregunte. Y no importa lo hábil y capaz que sea el físico que hace la pregunta: nunca se sabe con absoluta certeza qué respuesta se obtendrá.

§. Azar e incertidumbre

Una partícula es algo bien definido. Existe en un punto en el espacio, ocupa un pequeño volumen y tiene algún tipo de realidad tangible en nuestra experiencia cotidiana del mundo. Una onda es casi lo opuesto. Una onda pura se extiende sin límites, por lo que no tiene sentido decir que existe en un punto. Puede tener una dirección bien definida, pues tiene momento. Pero no es posible, ni siquiera con la imaginación, ponerle el dedo y aguantarla mientras se la observa. Entonces, ¿cómo se pueden reconciliar estos dos aspectos del mundo subatómico?

Para que una onda pueda expresarse como partícula (un fotón o un electrón), es preciso confinarla de algún modo. Los matemáticos saben cómo hacerlo: para confinar una partícula hay que reducir su pureza. En lugar de una única onda con una frecuencia única y bien definida, piénsese en un haz de ondas, con un rango de frecuencias, que se desplacen juntas. En algunos lugares, los picos de una onda se combinarán con los picos de otras ondas para producir una onda más fuerte; en otros lugares, los picos de una onda coincidirán con los valles de otras ondas y se cancelarán. Mediante una técnica denominada análisis de Fourier, los matemáticos pueden producir combinaciones de ondas que se cancelan casi completamente en todos los lugares excepto en una pequeña región del espacio. Estas combinaciones reciben el nombre de paquetes de ondas. En principio, un paquete puede hacerse tan pequeño como se desee, en tanto se incluya un número suficiente de ondas diferentes.

Figura 1.3. Un paquete de ondas es un grupo de ondas que cubre una región limitada del espacio.

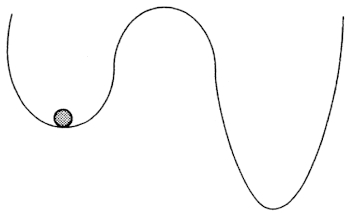

Pero hemos pagado un precio. El momento de una onda, como De Broglie mostró, es h dividido por la longitud de onda. Una onda pura tiene una longitud de onda única, y por tanto un momento único. Al introducir una mezcla de longitudes de onda, o de frecuencias, hemos introducido una mezcla de momentos. Cuantas más ondas introduzcamos (cuanto más pequeño sea el paquete de ondas), menos preciso será el significado del término «momento» para ese paquete de ondas. Sólo podremos decir que posee un rango de momentos dentro del intervalo Δp. Δx es la cantidad de indeterminación de la posición del paquete de ondas; sólo sabemos que está en algún lugar dentro de un volumen con sección Δx. Δp es la indeterminación del momento del paquete de ondas. Tenemos una cierta idea de hacia dónde se dirige el paquete, pero sólo con una precisión Δp. Es muy fácil demostrar matemáticamente que no es posible reducir Δx o Δp a cero y que, en realidad, el producto de las dos indeterminaciones, AxAp, es siempre mayor que la constante de Planck, h, dividida por el doble de pi (2π). Esta constante ligeramente diferente de h se designa mediante el símbolo h, y nos referimos a ella como «hache cruzada» o, con menos rigor, como «constante de Planck», aunque en realidad sea h /2π. La relación entre la posición y el momento es la relación de indeterminación de Heisenberg, denominada así en honor del Premio Nobel de Física alemán Werner Heisenberg, uno de los pioneros que dieron forma cabal a la mecánica cuántica en los años veinte, y se escribe:

Δx × Δp > h

Es necesario hacer hincapié en que esta relación, esta ecuación, no es simplemente un extraño truco matemático. La evidencia empírica de la dualidad onda-partícula implica que es imposible, en principio, medir con absoluta precisión tanto la posición como el momento de una partícula. Si pudiéramos medir la posición exacta de un electrón, de manera que Δx fuera cero, entonces Δp valdría infinito, y sería imposible saber dónde, en todo el Universo, aparecerá el electrón. Y esta indeterminación no se limita únicamente a nuestro conocimiento del electrón. Está ahí siempre, es inherente a la naturaleza de los electrones y de otras partículas y ondas. La propia partícula no «sabe», con absoluta precisión, dónde está ahora y adonde se dirige. El concepto de indeterminación está estrechamente ligado al concepto de azar en la física cuántica. No podemos saber con certeza dónde se encuentra una partícula, ni adonde se dirige, de manera que no debe sorprendernos que aparezca donde no la esperamos.La posición y el momento no son las únicas propiedades de una partícula que se hallan relacionadas de este modo. Los pares de las denominadas «variables conjugadas» están ligados de modo semejante por las ecuaciones de onda; el más importante es el par constituido por la energía (E) y el tiempo (t). De un análisis matemático riguroso se desprende que existe una indeterminación inherente en la cantidad de energía que interviene en un proceso subatómico. Si la energía se transfiere de una partícula a otra, y si esta transferencia ocurre en un cierto intervalo de tiempo (y así debe ser, pues nada se desplaza más rápido que la luz), entonces la indeterminación en la energía (ΔE) multiplicada por la indeterminación en el tiempo (Δt) es también mayor que h cruzada:

ΔE × Δt > h

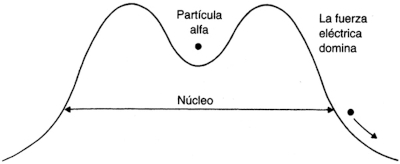

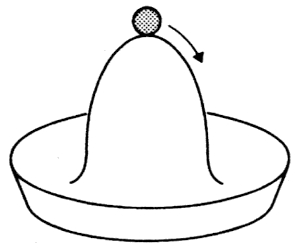

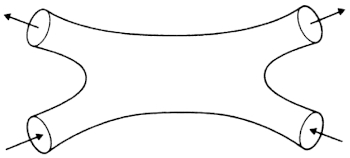

Por consiguiente, durante un corto periodo de tiempo el indeterminada la cantidad de energía que posee una partícula, y eso tanto para una partícula, como para sus alrededores inmediatos (o, en realidad, para todo el Universo). El extraño «efecto túnel», por el cual las partículas alfa escapan del núcleo atómico, ilustra gráficamente el poder de la indeterminación en el mundo subatómico. En los años veinte, George Gamow explicó «cabalmente» la emisión alfa mediante las ecuaciones completas de la física cuántica. Pero es fácil ver en términos generales qué ocurre durante este proceso.La partícula alfa reside en el núcleo, y podemos imaginarla como si estuviera dentro del cráter de un volcán. Si la partícula se encontrara del lado de fuera del cráter, «rodaría» ladera abajo: sería expulsada por la fuerza de repulsión eléctrica. La «distancia» desde el interior del núcleo hasta el exterior es Δx. Una partícula alfa asociada al núcleo posee un momento bien definido, al igual que el propio núcleo. Pero esa implica que su posición debe estar indeterminada. Si bien una partícula alfa individual no dispone de la energía necesaria para ascender hasta el borde del cráter del volcán y escapar, no se encuentra dentro del núcleo, en el sentido mundano de «dentro». La indeterminación implica que existe una probabilidad finita, y calculable con precisión, de que la partícula se encuentre de hecho fuera del núcleo. ¡Bingo! Algunas partículas se encontrarán fuera del núcleo, se darán cuenta y se escaparán, como si hubieran construido un «túnel» a través de la barrera. Es como si cogiéramos unos dados y los sacudiéramos dentro del cubilete hasta que, de repente, uno de ellos apareciera fuera del cubilete, rodando por la mesa. Si la constante de Planck fuera lo bastante grande, eso es precisad mente lo que ocurriría en nuestro mundo macroscópico.

Lo mismo puede argumentarse respecto a la energía. La partícula necesita más energía para ascender por el cráter de la barrera potencial. La energía adicional que precisa es ΔE. Pero de acuerdo con todas las leyes de física que conocemos y que importan, durante un breve instante, Δt, puede poseer esa energía adicional. Y si la posee, ascenderá por el cráter y rodará por la ladera exterior. No importa que tenga que «devolver» la energía que tomó prestada de la indeterminación pasado el intervalo de tiempo Δt, porque para entonces ya habrá escapado ladera abajo del otro lado de la barrera.

Por si todo esto no atentara bastante contra nuestra manera de pensar convencional, la teoría cuántica se guarda aún algunos trucos más en la manga.

Hasta el momento, nos hemos centrado en las implicaciones de una mezcla de características de ondas para las partículas.

Figura 1.4. La indeterminación de la mecánica cuántica explica cómo puede escapar una partícula alfa de un núcleo atómico. Puede «tomar prestada» una pequeña cantidad de energía de la indeterminación para escalar hasta el borde del cráter y deslizarse por la ladera externa, liberando la energía durante el escape; o, visto de otro modo, la indeterminación de su posición implica que puede aparecer al otro lado de la barrera, como si hubiera hecho un túnel a través de la colina y luego bajara a niveles de menor energía.

Las ecuaciones de Maxwell pueden explicar todo esto. Un polarizador dispuesto a 45º elimina la mitad de la energía de la onda; un polarizador dispuesto en un ángulo recto elimina toda la energía. Pero ¿qué les ocurre a cada uno de los fotones cuando alcanzan el polarizador? No se puede partir un fotón en dos mitades. Es la unidad básica, fundamental, de energía. Por consiguiente, cuando un haz de luz atraviesa un polarizador, la mitad de los fotones lo atraviesan y la mitad no. Pero ¿cómo son seleccionados? Al azar, según las leyes estadísticas de la probabilidad. En este ejemplo, cuando un fotón alcanza el polarizador, existe una probabilidad de exactamente el 50 por 100 de que lo atraviese o quede retenido. Este valor cambia con el ángulo del polarizador, pero el principio no. El polarizador selecciona fotones por puro azar. Y este ejemplo no es más que una demostración de lo que ocurre en el mundo cuántico. Cada vez que las partículas subatómicas participan en interacciones, el resultado depende del azar. Puede ser que un resultado en particular sea muy probable, o puede que la probabilidad sea tan solo del 50 por 100, como cuando se tira una moneda. En cualquier caso, por bien que las probabilidades vengan clara y precisamente determinadas por las leyes de la física cuántica, no existe certidumbre en el mundo cuántico.

Es precisamente esta característica de la física cuántica la que motivó el rechazo de Albert Einstein, que expresó con su famoso comentario sobre Dios: «que Él hubiera elegido jugar a los dados con el mundo... es algo que no puedo creer ni por un momento» (que a menudo se parafrasea como «no puedo creer que Dios juegue a los dados»), Pero toda evidencia indica que Dios realmente juega a los dados. Cada nuevo experimento confirma que la interpretación cuántica es correcta. Cuando realizamos un experimento en el que, por ejemplo, se necesite medir la posición de un electrón, es imposible saber con precisión qué ocurrirá a continuación. En este simple caso podremos decir, quizás, que existe una cierta probabilidad de que, cuando volvamos a observarlo, el electrón se haya desplazado del punto A al punto B, una probabilidad diferente de que se encuentre en el punto C, etcétera. En principio, podemos calcular todas estas probabilidades, y puede ser que la probabilidad de que el electrón vaya del punto A al B sea mucho más que 99 por 100. Pero nunca tenemos la certeza absoluta de que vaya a ocurrir así. Un día cualquiera, al volver a realizar el familiar experimento en el que el electrón se desplaza de A a B, puede ser que, por azar, aparezca en el punto C, D o Z.

En nuestro mundo cotidiano, estamos a salvo de las posibilidades más extrañas gracias al ingente número de partículas que intervienen en cualquier proceso. Para que funcione mi procesador de texto es necesario que circulen por el circuito billones de electrones. Puede ser que algún que otro inconformista ande saltando alegremente del punto A al D, en lugar de ir al punto B, pero la gran mayoría hacen lo que deben, por lo que a mí respecta. Salvo que uno tenga inclinación por la filosofía, no hay razón para preocuparse por los aspectos de azar e indeterminación de la física cuántica en el curso de nuestros quehaceres. Aun cuando a uno le interese la metafísica, como es mi caso, es posible usar un ordenador sin miedo real a que, de repente, todos los electrones dejen de obedecer órdenes. Pero los aspectos más extraños de la física cuántica cobran una tremenda importancia cuando se trata del mundo subatómico. Ya sólo nos resta familiarizarnos con un concepto fundamental más, y con unos pocos manjares extravagantes de la gastronomía cuántica, antes de poder, por fin, abordar aquellos rompecabezas.

§. Integrales de trayectoria y una pluralidad de mundos

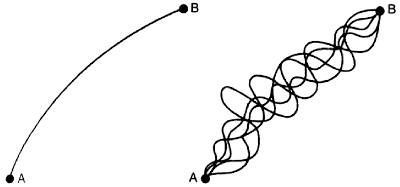

La diferencia fundamental entre la mecánica cuántica y la mecánica clásica (newtoniana) se ve muy claramente cuando se examina con atención cómo pasa realmente una partícula, por ejemplo un electrón, de un punto (A) a otro (B). En la interpretación clásica, una partícula en el punto A posee una velocidad y se desplaza en un sentido bien definido. En tanto actúen sobre ella fuerzas externas, se desplazará siguiendo una trayectoria perfectamente determinada que, en nuestro ejemplo, pasa por o acaba en el punto B. La interpretación mecánico-cuántica es diferente. No podemos conocer simultáneamente, ni siquiera en principio, tanto la posición como el momento de una partícula. Existe una indeterminación inherente acerca del sentido del desplazamiento de la partícula, de modo que si la partícula sale del punto A y luego la detectamos en el punto B no hay manera de conocer exactamente cómo fue de A a B, salvo que se observe durante todo el camino.

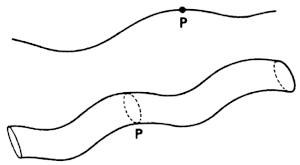

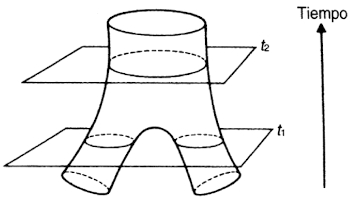

Richard Feynman, Premio Nobel de Física del Instituto de Tecnología de California, aplicó esta interpretación mecánico-cuántica a la historia de las partículas tal como se presenta en los diagramas de espacio-tiempo que utilizan los relativistas. Estos diagramas son gráficos en los que uno de los ejes representa el tiempo, y el otro, el espacio. Las curvas del diagrama (líneas de mundo) representan las trayectorias o historias de una partícula; muchas de éstas deben descartarse, porque implicarían desplazarse a una velocidad superior a la de la luz, pero muchas representan trayectorias válidas para el desplazamiento de una partícula desde el punto A al B. Por ejemplo, si volvemos a examinar el experimento de los dos agujeros, podemos concebir un mapa de todas las trayectorias posibles que puede seguir un electrón para desplazarse de un lado de la pantalla a un punto en concreto de la pantalla de detección, pasando por cualquiera de los dos agujeros. Algunas de las trayectorias son simples y directas; otras zigzaguean por el camino. Los mapas de Feynman también incluyen el tiempo, y algunas de las trayectorias corresponden a desplazamientos rápidos, y otras, a desplazamientos lentos. Pero cada una de las trayectorias, directa o tortuosa, rápida o lenta, lleva asociada una probabilidad definida (o, en rigor, una «amplitud de probabilidad»), que puede calcularse. Estas amplitudes se miden en términos de una cantidad llamada «acción», que es energía x tiempo, y que resulta ser la unidad en que se mide la constante de Planck, h.

Figura 1.5. La física clásica (newtoniana) postula que una partícula sigue una trayectoria determinada del punto A al B. Pero de acuerdo con la versión de la mecánica cuántica de Richard Feynman, el «sumatorio de historias», es preciso calcular la aportación de todas y cada una de las trayectorias posibles y luego sumarlas. Conocida también como técnica de la «integral de trayectorias», explica, entre otras cosas, que un único electrón (o un único fotón) pueda atravesar a la vez los dos agujeros del experimento de la doble rendija (véase la figura 1.2) e interferir consigo mismo.

En realidad, esta técnica sólo se ha aplicado en todo su detalle en unos pocos casos especiales, muy sencillos. Imagínese la complejidad de calcular las probabilidades de cada trayectoria posible desde el cañón de electrones hasta cada punto de la pantalla de detección. El número de trayectorias implicado es tan grande en la mayoría de los casos, que es poco o nada práctico aplicar la técnica de Feynman en su forma pura. Pero el concepto que subyace a esta técnica, y el hecho de que pueda mostrarse matemáticamente que las predicciones resultantes son idénticas a las que se obtienen mediante la versión de la mecánica cuántica de Schrödinger, es fundamentalmente importante. [7] Lo que Feynman nos dice es que, en el experimento de la doble rendija, no sólo debemos pensar que el electrón atraviesa ambos agujeros a la vez, sino que, además, sigue cada uno de los caminos posibles por los dos agujeros a la vez. La versión convencional de la mecánica cuántica postula que no existe ninguna trayectoria; en la interpretación de Feynman, es necesario tomar en cuenta todas las trayectorias.

Esta manera de describir las trayectorias de las partículas recibe la denominación de técnica de la «integral de trayectorias» (o «de caminos»), porque implica sumar todas las trayectorias posibles, o a veces, con más grandilocuencia, técnica del «sumatorio de historias». La denominación alternativa se hace eco de una concepción de las reglas de la mecánica cuántica que está lejos de ser mayoritaria en la actualidad, pero que a mí me atrae, y que discutí con detalle en mi libro En busca del gato de Schrödinger. Me refiero a la concepción de la «pluralidad de mundos», una descripción de la realidad originalmente desarrollada por Hugh Everett de la Universidad de Princeton en 1957, y que recientemente ha recibido el apoyo entusiasta de David Deutsch en Oxford. [8]

Lo que descubrió Everett es que se puede interpretar las ecuaciones, con completa validez, como si implicaran que cada vez que el Universo se confronta a una «decisión» a nivel cuántico, se divide en dos, y ambas opciones son elegidas. En un experimento en el que un electrón se desplace del punto A al B a través de una pantalla con dos agujeros, la teoría cuántica dice que, a no ser que lo observemos constantemente, es imposible saber cuál de los dos agujeros atraviesa, y que, en realidad, carece de sentido decir que lo haya hecho por alguno de ellos en concreto. Su trayectoria «real» viene dada por la suma de las dos trayectorias posibles. Pero la teoría clásica dice que existe una trayectoria definida y que debe haber atravesado solamente uno de los dos agujeros, aunque nadie estuviera observándolo.

Cada vez que observamos el electrón para ver por cuál de los dos agujeros pasa, esa indeterminación en particular se desvanece: se trata ya de un experimento diferente, uno en el que conocemos la trayectoria tomada por la partícula. Sin embargo, según nos dice Everett (o más bien sus ecuaciones), por cada observador que mira y ve cómo el electrón atraviesa uno de los agujeros, existe otro observador (en otro mundo) que mira y ve cómo atraviesa el otro agujero. Ambos son igualmente reales. O, en el caso del fotón que atraviesa el polarizador, cada vez que un fotón se confronta a una elección con la probabilidad del 50 por 10 descrita anteriormente, el Universo se divide en dos. En uno de los universos, el fotón atraviesa el filtro; en el otro universo, no lo atraviesa. Lo más extraño de esta versión de la realidad cuántica es que hace exactamente las mismas predicciones que la interpretación probabilística para los resultados observables de todos los experimentos que pueden realizarse. Esto es tanto un punto fuerte del modelo (después de todo, para que un modelo sea bueno debe concordar con todos los experimentos realizados hasta el momento) como un punto débil, pues la mayoría de teóricos argumentan con alivio que si no hace ninguna nueva predicción contrastable experimentalmente que ayude a distinguirla de la interpretación convencional, entonces no la necesitamos para nada, y podemos quedarnos con las probabilidades. Al fin y al cabo, la probabilidad nos permite retener la imagen del electrón como un punto en el espacio y el tiempo, si es que uno realmente quiere retener esta imagen.

§. ¿De la sartén al fuego?

El físico inglés Paul Davies, que trabaja en la Universidad de Adelaida, en Australia, insiste sobre este punto de vista en el libro de texto de física cuántica del que es autor. [9] «Resistid a toda costa», dice en el texto, «la tentación de concebir el electrón desmenuzado y disgregado en el espacio en ondas diminutas. El electrón en sí no es una onda: su movimiento está controlado por principios ondulatorios. Los físicos todavía conciben el electrón como un punto, por bien que la posición de ese punto en el espacio no esté bien definida». Y pasa a describir las ondas de probabilidad que determinan dónde es probable que aparezca un electrón en el instante siguiente mediante una analogía con las olas de crímenes. «Las olas de crímenes no son ondas de ninguna materia ondulatoria, sino ondas de probabilidad... las olas de crímenes, como las modas o el desempleo, pueden desplazarse (son dinámicas), pero, por supuesto, cada crimen particular sigue sucediendo en un lugar específico. Lo que se desplaza es la probabilidad abstracta».

En muchos casos, y en particular a efectos de la enseñanza física a nivel universitario, los físicos efectivamente tratan a los electrones como si fueran partículas «reales», y a las ondas asociadas a ellos, como «ondas de probabilidad» que pueden interferir entre sí, ser difractadas al atravesar pequeños agujeros y hacer todos los trucos que hacen las ondas. «Sólo la probabilidad tiene comportamiento ondulatorio», advierte Davies a sus estudiantes, «en tanto que las partículas en sí mismas siguen siendo pequeños corpúsculos, por mucho que esquivas y ocultas en la onda de probabilidad que guía su avance, qué faceta de esta dualidad onda-partícula se nos presente dependerá de la pregunta planteada». No es ésta una buena enseñanza. Uno pudiera preguntarle a Maxwell (si todavía viviera) qué pensaba acerca de la sugerencia de que las ondas de luz no son sino ondas de probabilidad que guían el movimiento de unos corpúsculos diminutos que llamamos fotones. A no dudar, su respuesta sería interesante. Por mucho que uno se esfuerce por retener la imagen de un electrón, o un protón, o la entidad que sea, como partícula, el concepto insiste en resquebrajarse.

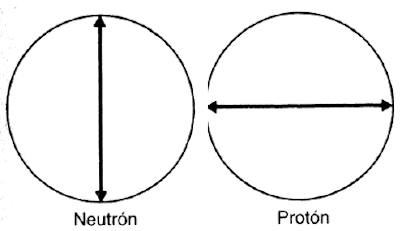

Fijémonos, a modo de ejemplo, en el espín. Los electrones y otras partículas subatómicas poseen una propiedad que los físicos denominan espín. Es una de las propiedades fundamentales que determinan la disposición de los electrones en los átomos, entre otras cosas, y se mide en las mismas unidades que el espín (momento angular) de una peonza, o de la tierra en rotación en el espacio. Pero la analogía termina aquí. El espín de un electrón sólo puede apuntar en dos direcciones, o «arriba» o «abajo», pero nunca «hacia un lado» o en cualquier dirección intermedia. Como la energía, el espín está cuantizado. El espín de una partícula fundamental se expresa en unidades de h cruzada. En estas unidades, el espín de un electrón es 1/2, ya +1/2, ya -1/2, pero ningún otro valor. Todas las partículas que gustamos de concebir como si se tratase de partículas «reales», como los protones, los neutrones y los electrones, tienen espín fraccionario, múltiplo de -1/ 2, 3/2, 5/2, y así sucesivamente.

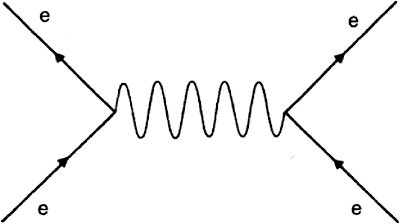

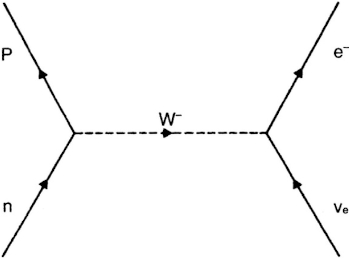

Todas estas partículas obedecen un conjunto de reglas estadísticas que se reúnen bajo la denominación de estadística de Fermi-Dirac, y reciben el nombre de fermiones. El fotón, que tiene espín de uno, y todas las partículas con espín entero (1, 2, 3, etcétera) obedecen un conjunto de reglas diferente, la estadística de Bose-Einstein, y se denominan bosones; por tanto, fotones y electrones son fundamentalmente diferentes.

La distinción más importante es que las partículas con espín fraccionario, como los electrones (es decir, los fermiones), son excluyentes. Siguiendo la analogía de la «escalera» de niveles de energías, esto quiere decir que en cada escalón sólo pueden hallarse dos electrones, uno con espín hacia arriba, el otro con espín hacia abajo. [10] Un tercer electrón queda excluido porque ocuparía un estado idéntico al de uno de los dos electrones ya presentes. Los fotones y el resto de partículas de espín entero (es decir, los bosones) son menos remirados. Pueden relacionarse de cualquier modo y en cualquier lugar. Además, aunque los fermiones se conservan (en conjunto, el número de fermiones del Universo se mantiene constante), los bosones son más efímeros. Podemos fabricarlos con sólo encender la luz, y se desvanecen al ser absorbidos por átomos y ceder energía.

Todo esto es bastante difícil de reconciliar con la existencia de diminutos corpúsculos «reales» guiados por ondas de probabilidad. Y se hace aún más difícil cuando los físicos nos informan de otras propiedades peculiares del espín de las partículas fundamentales. Por ejemplo, si imaginamos el electrón como una partícula en rotación, tiene que hacer no uno, sino dos giros de 360º para retornar al punto de inicio. Y aunque acabo de decir que, en conjunto, el número de fermiones del Universo se mantiene constante, esa limitación no obsta para que puedan constituirse pares de partículas y antipartículas, siempre que se disponga de la energía necesaria para conseguirlo. Un par electrón-positrón, por ejemplo, cuenta cero en el inventario total de fermiones del Universo. La partícula y la antipartícula se cancelan mutuamente. Si se dispone de la energía, es posible fabricar pares de electrones y positrones, tal como ocurrió durante el Big Bang. ¿Dónde puede conseguirse la energía necesaria en la actualidad? La respuesta mundana es haciendo chocar partículas en aceleradores gigantes, como el del CERN. Pero podemos ser más imaginativos. Los límites impuestos por el principio de indeterminación permiten, si se hace con rapidez, «tomar prestada» la energía suficiente de la relación de indeterminación entre partículas, siempre y cuando éstas se desvanezcan cuando se acabe su tiempo.

Tomemos el caso de los electrones. Si la masa de un electrón es m, entonces la energía necesaria para hacer un par electrón-positrón será 2me2. Esto equivale a un millón de electronvolts (1 MeV), en las unidades que suelen usar los físicos de partículas. Las leyes de la física permiten que un par de partículas como éste aparezca de la nada del vacío durante una diminuta fracción de segundo (la constante de Planck dividida por 1 MeV), y luego se aniquilen entre sí y desaparezcan. Estos pares de partículas se llaman partículas «virtuales». Un par puede existir únicamente durante un periodo de tiempo extremadamente corto, pero el vacío es un hervidero de pares de partículas virtuales que constantemente se forman, se destruyen, y otros pares vienen a reemplazarlas. Al menos, así conciben el vacío los físicos de partículas. Además, la existencia de partículas virtuales tiene un efecto directo sobre las ecuaciones de la física de partículas. Si no se incluyen las partículas virtuales, las ecuaciones no predicen correctamente las interacciones entre las partículas cargadas. Si se incluyen los efectos debidos a las partículas virtuales, las predicciones son correctas.

Entonces, ¿hasta qué punto son «reales» las partículas del Universo? Cuando Paul Davies se dirige a sus colegas de investigación, y no a los estudiantes universitarios, toma una posición diferente. En su aportación a un libro publicado para conmemorar el sexagésimo cumpleaños del físico Bryce DeWitt (uno de los defensores, por cierto, de la interpretación de múltiples mundos de la física cuántica), Davies presentó un ensayo con un título provocativo: «Las partículas no existen». [11] El meollo del argumento que expuso, y que concuerda con el punto de vista de muchos teóricos, emana del hecho de que no podemos ver, tocar o sentir las partículas fundamentales como los electrones. Nos vemos limitados a; realizar experimentos, registrar observaciones y establecer conclusiones sobre lo que ocurre de acuerdo con lo que, observamos y nuestras experiencias cotidianas. Es natural que intentemos imponer conceptos de nuestro mundo cotidiano, como «onda» o «partícula», al mundo subatómico; pero en realidad todo lo que conocemos acerca del mundo subatómico es que si lo estimulamos de un cierto modo, obtenemos una cierta respuesta. «Lo que pretendo poner en tela a de juicio», dice Davies al principio de su ensayo, «es lo que pudiéramos calificar de realismo ingenuo». Y concluye: «El concepto de partícula no es más que un modelo idealizado de una cierta utilidad en el espacio plano de la teoría cuántica de campos».

El problema es que, por el momento, no disponemos de nada mejor para reemplazarlo. Pero me parece que es con esta nota de cautela desde la vanguardia de la investigación actual, y no arropados por una manta de reconfortantes ideas sobre pequeñas partículas guiadas por ondas de probabilidad, que debemos adentrarnos en el mundo de las partículas. Durante los últimos cincuenta años, los físicos han revelado un fascinante mundo subatómico poblado por toda suerte de extraños objetos que, por falta de mejor nombre, llamamos partículas. Qué son en realidad, lo desconocemos. Las mejores teorías que poseemos explican los resultados de experimentos pasados mediante interacciones entre estas bestias míticas, y predicen los resultados de nuevos experimentos a través de las interacciones postuladas entre estas «partículas». Mediante la observación del mundo de las interacciones de alta energía, los físicos elaboran reglas para predecir el resultado del siguiente experimento. Las buenas teorías permiten que nos «salga» el cálculo de cómo se originó el Universo y luego explotó hasta llegar a su forma actual. Pero eso no implica que lleven la verdad última, o que «realmente existan» pequeños corpúsculos que se mueven agitadamente en el interior del átomo. Cualesquiera verdades que existan en estas teorías se encuentran en su expresión matemática; el concepto de partícula no es más que una muleta en la que pueden apoyarse los simples mortales en su esfuerzo por comprender las leyes matemáticas. Y lo que esas leyes matemáticas describen son campos de fuerza, o espacio- tiempo curvado y vuelto a curvar sobre sí mismo con fabulosa complejidad, y una «realidad» que se desvanece en una niebla de partículas virtuales e indeterminaciones cuánticas cada vez que se intenta examinar de cerca.