La belleza de la física queda resumida en un simple hecho: un niño puede plantear preguntas que ningún profesor puede contestar.

De hecho, descubrir las «grandes cuestiones» de la física es algo así como buscar paja en un pajar.

Cuando se trata de la física, parece que no existen preguntas pequeñas.

Una cuestión o experimento aparentemente insignificantes conducen a menudo a profundos descubrimientos.

Por ejemplo, sólo hay un paso desde preguntar si las leyes de la física pueden cambiar alguna vez, o pueden violarse, hasta plantearse si acaso queda espacio para un creador.

Y tampoco se detiene ahí la cosa.

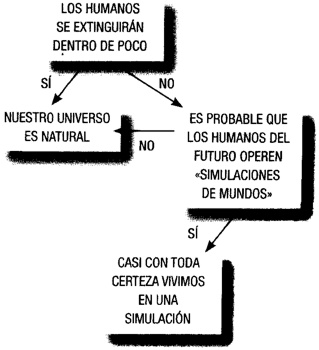

La física nos dice que un creador no tiene por qué ser divino; podría ser que viviéramos anidados dentro de un número infinito de universos, cada uno de ellos creado por una especie sólo ligeramente más inteligente que su mayor creación.

Incluso podemos estar destinados a convertirnos en creadores de un universo.

Con temas tan grandes a mano, no sorprende que los científicos más icónicos de nuestra generación se hayan enfrascado en la física.

Albert Einstein se convirtió en una celebridad casi de la noche a la mañana cuando su teoría de la relatividad cambió nuestra concepción del universo.

Cosmos, el programa de Carl Sagan para la televisión, sigue siendo la serie de mayor audiencia en la televisión pública.

La fría valoración que hizo Richard Feynman de la física subyacente al desastre del transbordador Challenger reveló cuán poderoso puede ser un buen conocimiento del tema.

El trabajo de Stephen Hawking, expuesto en su éxito de ventas Breve historia del tiempo, generó un ansia de conocimientos científicos en personas que nunca habían pensado en la ciencia.

Sólo los descubridores del ADN, quizá, pueden situarse junto a estos gigantes.

Y aún así, hay que decirlo, la gente tiende también a espantarse ante la física.

Si en una conversación casual menciono que soy físico de profesión, dicha declaración se encuentra con una extraña mezcla de admiración y de desconcierto.

Al tiempo que expresan admiración hacia alguien que intenta comprender el universo, muchos parecen considerar también que el tema se halla por completo más allá de sus posibilidades.

«¡Oh! —dicen—, nunca entendí la física.» Si el lector se reconoce en esa afirmación, entonces espero que este libro cambie su perspectiva.

Quizá el secreto mejor guardado de la física es que hay demasiadas cosas para que alguien las comprenda.

Sin embargo, esto no es un problema: ésta es la raíz de su fascinación.

La física tiene tanto que explorar que, una vez ha captado nuestra imaginación, es difícil apartarnos de ella.

El reloj de pared se convierte en un fastidioso recordatorio de la esquiva naturaleza del tiempo.

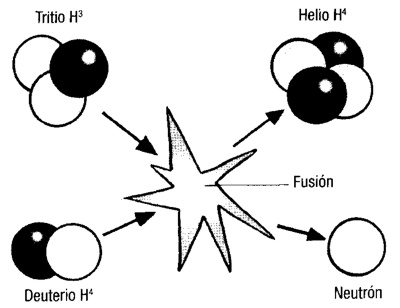

La luz solar es el resultado de una hermosa e intrincada danza de partículas conocida como fusión nuclear.

Cuando sobre el suelo caen gotas de lluvia, podemos preguntarnos un simple «¿por qué?».

Explorar la respuesta nos tendrá ocupados durante la tormenta más larga.

La manera en que un girasol crece habla de la conservación de la energía y de cómo la naturaleza de la luz ha modelado la vida en la Tierra.

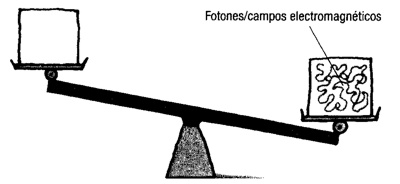

Si vamos un paso más allá y preguntamos qué es la luz, estaremos escudriñando algo que generalmente se considera que es el misterio más profundo de la naturaleza.

Este libro pretende mostrar que preguntas sencillas conducen a algunos de los descubrimientos más profundos que ha hecho la humanidad.

Comprende la física que seguramente el lector no aprendió en clase: el meollo real del asunto; sus implicaciones; lo que comprendemos del universo...

y lo que no.

Carl Sagan dijo una vez: «En algún lugar hay algo increíble a la espera de ser descubierto».

Tengo la esperanza de que dicho proceso pueda empezar aquí.

Capítulo 1

¿Cuál es el sentido de la física?

Preguntas imposibles, recompensas inesperadas y la búsqueda inacabable para comprender

La pregunta ha estado rebotando durante décadas por las aulas de las escuelas. La respuesta que generalmente se proporciona suele empezar con un cuento apócrifo en el que intervienen el legendario filósofo griego Arquímedes y la corona del rey Hierón.

Hierón había accedido al trono de la ciudad siciliana de Siracusa. Dio a un artesano una determinada cantidad de oro para que le moldeara una corona; cuando la corona llegó, también lo hizo un rumor de que el artesano había sustituido algo del oro por plata. Hierón encargó a Arquímedes, que entonces tenía poco más de veinte años, que descubriera la verdad.

La historia, tal como la relata el escritor romano Marco Vitruvio Folión, dice que Arquímedes se dio cuenta de cómo resolver el problema cuando advirtió el volumen de agua que su cuerpo desplazaba en una bañera. La plata, al ser menos densa que el oro, desplazaría menos agua. Arquímedes realizó una serie de experimentos que implicaban sumergir fragmentos de plata y oro que pesaban lo mismo que la corona para ver cuánta agua desplazaba cada uno. Esto le permitió decir si había plata en la corona. En su alegría, Arquímedes salió desnudo a la calle, gritando: «¡Eureka!» («¡Lo encontré!»).

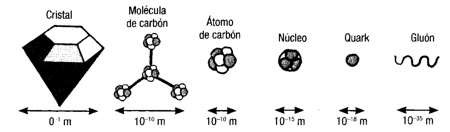

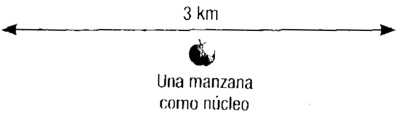

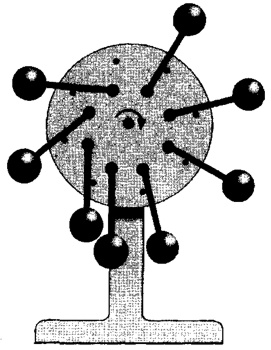

¿Es éste el sentido de la física, dar respuesta a preguntas que aparentemente no la tienen? Ahora podemos observar nuestro entorno a través de una extraordinaria gama de escalas. Allí donde antaño pensábamos que la materia era indivisible, nos hemos hecho cada vez más pequeños, hasta el nivel del átomo, y más allá todavía, hasta las partículas más fundamentales, y en último término hasta una concepción en la que la materia se halla realmente compuesta por fluctuaciones en la energía del espacio vacío (véase ¿Son los sólidos realmente sólidos?). El cielo fue antaño el límite de nuestra visión; ahora sabemos que el universo es tan vasto que a la luz le tomaría cerca de 28.000 millones de años atravesarlo (véase ¿Soy único?). Y, no debe olvidarse, comprender que la luz tiene una velocidad definida y constante es asimismo un triunfo de la física logrado a costa de mucho esfuerzo (véase ¿Podemos viajar a través del tiempo?).

Sabemos mucho de la historia del universo, la naturaleza de la materia y la estructura de nuestro planeta, pero quizá la mayor lección que hemos aprendido es que, cada vez que pensamos que hemos explicado la naturaleza, nos sorprende de nuevo, revelando lo poco que realmente sabemos. Probablemente, Isaac Newton fue quien mejor lo dijo en sus memorias: «No sé qué le puedo parecer al mundo —escribió—, pero a mí me parece que sólo he sido como un niño jugando en la playa y divirtiéndome al encontrar de vez en cuando un guijarro más liso o una concha más bonita de lo normal, mientras que el gran océano de la verdad se hallaba ante mí, sin descubrir».

Una alternativa a la superstición

Si hay un aspecto de los logros de la física que Newton apreciaba quizá menos que la mayoría, era la capacidad de la materia de cortar a través del misticismo y la superstición. Newton era un gran alquimista y un erudito de la Biblia; consideraba que sus escritos sobre el libro de Daniel del Viejo Testamento constituían la mayor de sus obras. Siempre que la física amenazaba con poner en duda asuntos espirituales, Newton reculaba. «Yo he estudiado estas cosas; vosotros no», era su réplica constante a las críticas que los astrónomos hacían a la religión. Newton dejó margen para la obra de Dios en el funcionamiento de su «universo como gran mecanismo de relojería», pero el desarrollo de la física pronto desplazó a la mano divina. Cuando el emperador Napoleón le preguntó a Pierre-Simon Laplace acerca de su tratado sobre la mecánica celeste, que acababa de publicar, le hizo notar la ausencia de Dios en el mecanismo. Laplace replicó: «No tengo necesidad de tal hipótesis». El objetivo de la física, en muchos aspectos, es encontrar qué hay en el universo que sea explicable por un conjunto de leyes, y cuanto más simples sean dichas leyes, mejor.

Hasta aproximadamente el año 600 a.C., las civilizaciones desarrollaron tecnologías pero pensaron poco acerca de cómo explicarse el mundo: esto se dejaba para los profetas y los sabios. Y entonces aparecieron los milesios. La ciudad de Mileto, en la costa occidental de la actual Turquía, era la sede de un modo de pensar que los científicos de hoy en día reconocerían como un ansia de comprensión real y de primera mano. En lugar de tener los secretos del universo enmascarados por preocupaciones religiosas y místicas, los milesios buscaban leyes que explicaran los fenómenos de la naturaleza, y produjeron teorías sobre las causas de los terremotos, de los rayos y de la estructura del universo, entre otras cosas.

Los milesios debatían abiertamente dichas teorías, consideraban cómo podían comprobarse y aceptaban los resultados de los experimentos como árbitro de la verdad. Se atribuye a Anaxímenes de Mileto el haber realizado el primer experimento científico del mundo. Sus observaciones acerca de como la temperatura del aliento exhalado parece variar en función de si los labios se hallan fruncidos o completamente abiertos, le llevaron a la conclusión de que la compresión causa el enfriamiento y la expansión el caldeamiento.

El hecho de que Anaxímenes estuviera exactamente equivocado aquí es otra lección en el sentido de la física. Nos enseña que no podemos estar nunca seguros de nada que sea «sabiduría o creencia popular»; a menudo se comprueba que las teorías aceptadas, e incluso los «hechos» acerca de cómo funcionan las cosas en el universo, son erróneos y son suplantados por nuevas ideas. También éstas se hallan abiertas a la falsación. La física es un proceso de comprobarlo todo... especialmente aquellas cosas que más deseamos que sean ciertas.

Proporcionar las leyes por las que funciona la sociedad

James Wilson, que desempeñó un papel importante en la elaboración de la Constitución estadounidense y se convirtió en uno de los seis jueces originales del tribunal supremo de George Washington, se tomó a pecho las ideas de la física. Cuando definía el papel del gobierno en sus Lecciones de Derecho dijo: «Cada parte influye y es influida, sostiene y es sostenida, regula y es regulada por el resto... Hay una necesidad de movimiento en los asuntos humanos; y estos poderes se ven obligados a moverse, aunque sea conjuntamente».La declaración de Wilson es digna de Isaac Newton: invoca las mismas leyes de la interacción que permitieron a Newton deducir cómo funcionaba el sistema solar. Lo que es más, la conexión entre Newton y la teoría política no es difícil de reseguir. Newton estuvo inspirado por Copérnico, quien reconoció la obra de Aristarco de Samos, que vivió en Grecia entre 310 y 230 a.C. Aristarco estuvo inspirado, a su vez, por Platón, el filósofo, aristócrata y político griego. Se considera que la mayor contribución de Platón a la civilización es su República, un examen de la mejor manera de gobernar una sociedad. Pero Platón también era un astrónomo distinguido: por ejemplo, fue la primera persona que reconoció que las anomalías en el movimiento de los planetas podían resolverse encontrando alguna combinación de movimientos circulares.

Platón pensaba que la física era un adiestramiento excelente para un político. Los caudillos han de aprender ciencias físicas tales como la astronomía, declaró una vez Platón; no porque ayuden en la observación de las estrellas o la navegación, sino porque proporcionan una educación en las técnicas de pensamiento abstracto que son esenciales para el liderazgo. Las mismas habilidades son muy valoradas hoy en día: los físicos de profesión tienen mucha demanda fuera de las paredes del laboratorio: en las finanzas, en los negocios y en el gobierno.

Es por esta razón que la física se halla relativamente desprovista de «santos científicos». No es tanto una disciplina de ideas como una disciplina de consensos a los que se ha llegado mediante el acopio de pruebas experimentales. A quienes no aceptan los resultados de los experimentos (y no aportan buenas razones de por qué otros debieran unírseles en el lado «equivocado» de la valla) se tiende a despacharlos sumariamente.

Más que la suma de las partes

Los físicos Albert Einstein y Richard Feynman proporcionan una ilustración adecuada de la manera en que la física es mayor que cualquier físico. Aunque en la actualidad es venerado como un ídolo público, Einstein no murió siendo un héroe para otros físicos. Por el contrario, se recuerdan los últimos años de su vida con un regusto de pesadumbre por su última investigación. La obra mejor conocida de Einstein la realizó al principio de su carrera. Hizo una contribución fundamental a la teoría cuántica con el descubrimiento experimental del fotón, el cuanto de energía (véase ¿Qué es la luz?).

Esto echó por tierra la teoría, de varios siglos de antigüedad, de que la luz tenía que ser una onda. Después, su teoría de la relatividad especial cambió nuestra idea del tiempo. Su dilucidación de la idea de que masa y energía son intercambiables (véase ¿Por qué E = mc2?) fue una revelación sobre las características fundamentales de la materia. La teoría de la relatividad general reescribió la obra gravitatoria de Newton después de casi cuatro siglos de aceptación (véase ¿Por qué cae una manzana?).

Pero, después de esto, las ideas de Einstein fueron cada vez más irrelevantes para los físicos. La revolución cuántica cambió la faz del asunto, pero Einstein se resistió a aceptar la teoría cuántica como una manera útil de describir el universo. Pasó sus últimos años trabajando, en vano, en una teoría que tenía que unir el electromagnetismo y la relatividad y hacer de la teoría cuántica una innovación innecesaria. El número de físicos que trabajaban con él y lo apoyaban fue disminuyendo a lo largo de su vida.

Richard Feynman es quizá el segundo físico más famoso después de Einstein. Fue un gran divulgador de la física, un pensador grande e innovador y (lo más importante de todo) sigue siendo un gran héroe para los que trabajan en el campo. Feynman no alcanzó nunca las vertiginosas alturas de los logros de Einstein, pero hizo más que muchos, contribuyendo a la creación de la electrodinámica cuántica, o QED, una teoría que describe las interacciones de la luz y la materia (véase ¿Qué es la luz?). Generalmente se la considera como la más exitosa de las teorías de la física.

Una de las mayores virtudes de Feynman como físico fue su capacidad de escuchar las convicciones de sus iguales, inclinarse ante la ley de la evidencia y admitir que siempre estaba trabajando desde una posición de ignorancia. Es famosa su frase: «El primer principio es que no has de engañarte a ti mismo... y uno es la persona más fácil de engañarse».

Su renuencia a engañarse se resume en su evaluación de la teoría que se convirtió en la ruina de Einstein. «Pienso que puedo decir con seguridad que nadie entiende la mecánica cuántica —escribió en El carácter de la ley física—. No sigáis diciéndoos, si podéis evitarlo, "Pero ¿cómo puede ser así?", porque os meteréis... en un callejón sin salida del que todavía nadie ha escapado. Nadie sabe cómo puede ser así.»

Esta es la razón por la que el Einstein mayor no es reverenciado por los físicos, y Feynman lo es.

Mientras que Einstein se metió en un callejón sin salida, Feynman admitió su comprensión limitada y siguió a otros cuando éstos hacían incursiones en nuevos territorios. Éste es otro componente del sentido de la física: progreso al construir sobre los logros de otros. Tal como Newton lo planteó: «Si he podido ver más lejos es sólo porque iba a hombros de gigantes».

Una disciplina humilde

Cuando examinamos las ecuaciones que rigen el movimiento de un electrón, pongamos por caso, podemos ver cómo nos dicen su momento o su velocidad. Sin embargo, no hay manera alguna en que nos puedan decir, con precisión, a la vez el momento y la velocidad. Ambos sólo pueden encontrarse con una precisión finita.

Werner Heisenberg vio el lado práctico de ello: existen límites a lo que nuestros experimentos pueden revelar. Si hacemos saltar un fotón de luz de un electrón, podremos inferir su posición, pero el fotón también habrá comunicado un cierto momento al electrón. Así, el acto de determinar la posición del electrón crea una incertidumbre en el valor de su momento. Y al revés, una medición del momento creará siempre una incertidumbre en la posición de una partícula. Y consideremos la teoría o el experimento, hay limitaciones estrictas a lo que podemos descubrir. La física, en muchos aspectos, es una disciplina humilde. Pero hay mucho ante lo que mostrarse humilde, como atestiguarán los físicos que hubo detrás de la bomba atómica.

Si hubiéramos planteado la pregunta «¿Cuál es el sentido de la física?» a los gobiernos occidentales después de la segunda guerra mundial, nos hubiéramos encontrado con la incredulidad de que siquiera hubiéramos tenido que preguntar. La física lo era todo, como la guerra había demostrado. La física nos había dado fantásticas innovaciones tecnológicas: el radar, los ordenadores, la bomba atómica y, desde luego, los televisores y los hornos de microondas. La física se afanaba en ser la impulsora de las economías y la protectora de las naciones. Sin embargo, si hubiéramos planteado la misma pregunta a los físicos, podríamos haber obtenido una respuesta algo más mitigada.

Inmediatamente después de la primera prueba de la bomba atómica en Nuevo México, Kenneth Bainbridge, un físico de Harvard, se volvió hacia Robert Oppenheimer, el jefe del proyecto. «Ahora todos somos hijos de puta», le dijo. Oppenheimer se las había con sus propias emociones en conflicto: décadas más tarde reconoció que todos sabían en aquel momento que el mundo nunca volvería a ser el mismo. Y, sin embargo, dijo Oppenheimer, si se encontrara en la misma situación volvería a hacerlo. «Si eres un científico, no puedes detener una cosa de este tipo dijo en su discurso de jubilación, en 1945. Si eres un científico, crees que es bueno descubrir cómo funciona el mundo... que es bueno traspasar a la humanidad en general el mayor poder posible para controlar el mundo.»

El mundo en el bolsillo

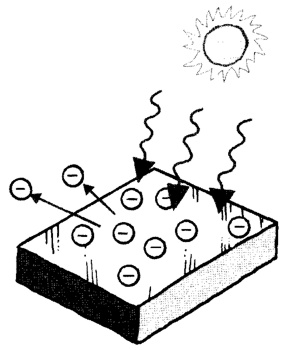

¿Es éste el objetivo de la física, obtener el control sobre el mundo? Es cierto que la física (o, al menos, las aplicaciones industriales de la física) ha creado el mundo moderno. Si nuestra época puede definirse por una cosa, probablemente es la revolución de la microelectrónica: televisión, informática, internet y comunicaciones móviles, para no mencionar más que algunos aspectos. Iodo ello se construyó sobre las espaldas de la física. Para ser más específico, se construyó sobre las espaldas de la tecnología del silicio. Durante la segunda guerra mundial, los que desarrollaron el radar trabajaron para crear cristales cada vez más puros de silicio y germanio para el equipo. Los físicos (por encima de todo los que trabajaban para los Laboratorios Bell, en los Estados Unidos) continuaron dicho desarrollo después de la guerra aprendiendo cómo convertirlos en «semiconductores» e incorporándolos a tecnologías que previamente habían necesitado amplificadores de válvulas ineficientes y voluminosas. Hacia 1952, los primeros productos electrónicos basados en el silicio llegaron al mercado: dispositivos de baja potencia y muy portátiles, como audífonos y radios de bolsillo. Un año después apareció el primer ordenador que funcionaba mediante transistores. Poco tiempo después, la gente empezó a referirse a la concentración de compañías de electrónica en una pequeña área de California del norte como Silicon Valley.

No es difícil ver el impacto de la física en nuestra vida. Los láseres proporcionan un ejemplo específico. Los láseres surgieron asimismo de los Laboratorios Bell y derivaron de la investigación en la tecnología del radar durante la época de la guerra. Desde su invención en 1957, se han hecho omnipresentes en nuestra vida cotidiana. Reproductores de CD y DVD, sistemas de comunicaciones mediante fibra óptica como la red telefónica, escáneres de comprobación de los supermercados, cirugía ocular e impresoras láser son sólo algunas de las aplicaciones.

Así pues, ¿es acaso el desarrollo de la tecnología el objetivo de la física? En absoluto. Las revoluciones tecnológicas del siglo XX se produjeron como un resultado, en último término, del descubrimiento (o la invención, si el lector lo prefiere) de la teoría cuántica. Esta fue el resultado de intentar desenmarañar cosas que nadie comprendía, como por qué el espectro de la radiación emitido por un horno a 100 grados Celsius era el mismo que el espectro de radiación emitido por cualquier otra cosa a 100 grados Celsius, y no de intentar inventar específicamente nuevos dispositivos.

En esencia, nuestras tecnologías electrónicas modernas proceden de la teoría cuántica, que procedía de la termodinámica, el estudio del calor. Éste surgió del estudio de los gases, y así sucesivamente. La física es una reacción en cadena que se automantiene: cada descubrimiento provoca otro conjunto de preguntas, que provocan nuevos descubrimientos. Tal como dijo una vez George Bernard Shaw, «la ciencia nunca resuelve un problema sin crear otros diez».

Una historia de nunca acabar

No se ve un final a las preguntas. A los físicos les gustaba decir que su trabajo ya estaba hecho. En 1894, el físico americano Albert Michelson anunciaba que «Las leyes fundamentales y los hechos más importantes de la ciencia física se han descubierto ya, y éstos están en la actualidad establecidos de manera tan firme que la posibilidad de que alguna vez se vean suplantados como consecuencia de nuevos descubrimientos es enormemente remota». Durante la década siguiente, tuvimos las revoluciones gemelas de la relatividad y de la teoría cuántica.

En 1888, el astrónomo Simón Newcomb había anunciado el fin de la astronomía: en los cielos quedaban pocas cosas por descubrir, sugirió. Newcomb también estaba equivocado. Probablemente, nuestra concepción del cosmos ha cambiado de manera más radical desde la época de Newcomb que lo que hizo a lo largo de los miles de años de descubrimiento científico que tuvieron lugar antes de su nacimiento. Aunque los principales descubrimientos del último siglo nos demostraron de dónde venimos, subrayando toda la historia del universo, de nuestra concepción del mundo ha desaparecido la arrogancia; con el descubrimiento de que la mayor parte del universo se encuentra en una forma desconocida para la ciencia, los físicos aprecian ahora que han de habérselas con sólo un minúsculo porcentaje del universo.

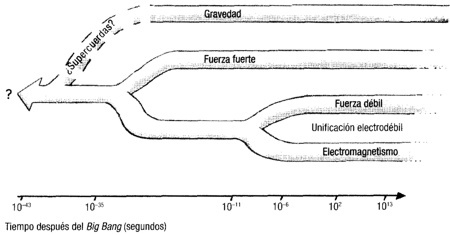

Existe, hay que decirlo, un final a la vista: la teoría del todo. Si la física se inició con la búsqueda por parte de los milesios de las leyes que rigen los fenómenos naturales, llegará (teóricamente) a su final con el descubrimiento de una sola ley: la descripción última del universo. Dicha «teoría del todo» reducirá todas las partículas, las fuerzas que rigen sus interacciones y el espacio y el tiempo en el que su existencia se desarrolla, a una única descripción unificada (véase ¿Trata realmente de cuerdas la teoría de cuerdas?).

Por el momento, estamos lejos de conseguir ese objetivo, pero aquí, quizá, hemos encontrado la verdadera finalidad y la esencia de la física: descubrir la magnitud de nuestra ignorancia, y hacer lo que podamos para reducirla. A veces, como ocurrió con la bomba atómica, hay que pagar un precio por este viaje de descubrimiento. A veces, como con el desarrollo de la mecánica cuántica, obtenemos unas enormes recompensas prácticas de ello. Pero la mayor parte del tiempo, nos dirán los físicos, la física trata simplemente de la emoción del descubrimiento; y después, de descubrir que nuestros descubrimientos han hecho que el mundo sea más interesante, no menos. Tal como dijo el poeta John Dryden, «La alegría de observar y comprender es el más bello regalo de la naturaleza».

Capítulo 2

¿Qué es el tiempo?

Progreso, desorden y los relojes elásticos de Einstein

En lo profundo de nuestro cerebro hay un grumo de tejido denominado striatum. Este surtido de neuronas es, hasta donde sabemos, el único lugar en el que reside el tiempo. Acumula el primer registro de los momentos de nuestra vida y provoca la sensación de que nuestra infancia fue un variado y confuso conjunto de momentos importantes y fascinantes, mientras que la vida adulta se mueve con demasiada precipitación para poder apreciarla adecuadamente.

Pero no deberíamos conceder demasiada importancia a estos sentimientos. El don del striatum es en realidad crear una impresión (quizá incluso una ilusión) del paso del tiempo. El problema es que su medida del tiempo depende de lo que ocurre en nuestra mente consciente. Cada vez que realizamos una tarea consciente, como poner la tetera en el fuego, los diversos circuitos eléctricos en nuestro cerebro se activan al unísono. El núcleo estriado registra esta emisión simultánea de señales y empieza a anotar los patrones subsiguientes de señales eléctricas procedentes de áreas tales como la corteza frontal. Nuestra noción de cuánto tiempo ha pasado antes de que el agua de la tetera rompa a hervir no es otra cosa que una medida de las señales eléctricas acumuladas.

Esto no es tan malo en casa, donde podemos calibrarlo con una mirada al reloj de la cocina. Pero tan pronto como se nos niega el acceso a relojes, las cosas se ponen feas. Cuando, en los primeros años de la década de los sesenta, el geólogo francés Michel Siffre se quitó el reloj y descendió a una cueva oscura durante sesenta días, su percepción del paso del tiempo se deshilachó. Al final del experimento, lo que Siffre pensaba que era una hora eran a menudo cuatro o cinco. Drogas tales como el valium, la cafeína o el LSD desbaratarán de manera parecida nuestro sentido del tiempo. Y lo mismo hará nuestra memoria.

Solemos pensar que las épocas atareadas hacen que la vida pase volando, pero los experimentos demuestran que esto sólo es cierto mientras estamos ocupados. Después, cuando reflexionamos sobre nuestra existencia, nuestros períodos atareados parecerán mucho más extensos. Esta es la razón por la que nuestra infancia parece ahora que haya sido una serie de veranos largos y dorados; la vida era emocionante cuando teníamos tanto que experimentar, y nuestro cerebro piensa que estos niveles elevados de emisión de señales deben corresponder a períodos enormes de tiempo. Así pues, nuestra comprensión del paso del tiempo es tan precaria ionio siempre podemos haber sospechado. Pero resulta que nuestros problemas con la percepción del tiempo no son nada en comparación con nuestros problemas con la noción del propio tiempo.

Tiempo universal

El lector podría pensar que, a estas alturas, ya deberíamos tener una idea de lo que es el tiempo. Después de todo, el tiempo es un concepto que se entiende de manera universal: todas las culturas humanas lo conocen, hablan de él, lo sienten. Y hemos estado pensando en lo que significa durante milenios. En 350 a.C, Aristóteles, por ejemplo, escribió una obra llamada Física que incluía uno de los primeros intentos de tratar de resolver la noción del tiempo.

La obra de Aristóteles sobre el tiempo empieza con una pregunta: «En primer lugar —dice—, ¿pertenece a la clase de cosas que existen o a la de cosas que no existen?». Hoy en día, en el segundo milenio d.C., ésta sigue siendo una cuestión abierta. Si nuestra mente se engaña por el paso del tiempo, ello puede ser porque el propio tiempo es una ilusión. Desde los griegos a la física moderna actual, la principal conclusión acerca del tiempo ha permanecido constante: trata, por lo menos, del cambio. A lo largo del tiempo, una cosa cambia en otra.

Pero mientras que los compañeros griegos de Aristóteles estaban obsesionados con el círculo como concepto más fundamental del universo, lo que significaba que el tiempo tenía que fluir en ciclos, la física moderna se centra en procesos lineales: desde un principio hasta un final, del Big Bang al cierre cósmico. Con el tiempo, esto se traduce en un sentido abrumador de la flecha del tiempo: en nuestra concepción moderna del universo, el tiempo se mueve irreversiblemente hacia delante. Los huevos se cascan y no pueden recomponerse. Los relojes avanzan y no marchan espontáneamente en sentido contrario.

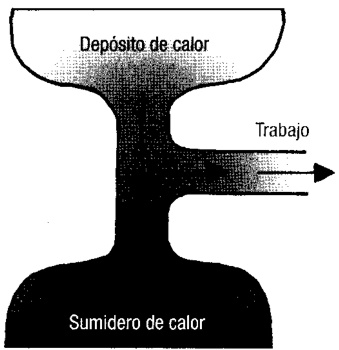

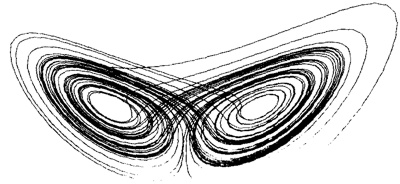

Este proceso de cambio, en el que los sistemas se mueven irresistiblemente hacia el desorden, se conoce como la flecha termodinámica del tiempo. Surge de una de las leyes más fundamentales de la física: la segunda ley de la termodinámica. Esta afirma que, en su conjunto, el universo se halla atrapado en un proceso de desenredar el orden. La entropía, una medida del desorden de un sistema, siempre va en aumento.

Orden y desorden

La flecha del tiempo podría surgir de varios orígenes diferentes. Por ejemplo, la «flecha cosmológica del tiempo» cita la creación del universo como un movimiento que se aleja de un estado especial de baja entropía en lo que todo estaba pulcramente ordenado. Es algo así como dar un cubo de Rubik completamente resuelto a un niño curioso; a medida que pasa el tiempo, el universo se desplaza a un estado cada vez más desordenado, de la misma manera que el orden perfecto de las caras del cubo de Rubik darán paso a una mezcolanza desordenada de colores. Mientras que algunas cosas, como las galaxias, aparecen ordenadas, con estructuras que a menudo son intrincadamente hermosas, el orden del universo en su conjunto se reduce. El final llegará cuando ya no haya más desorden que crear; o, como dijo lord Kelvin, cuando el universo haya alcanzado «un estado de reposo y muerte universales».

Nuestra flecha del tiempo familiar podría resultar igualmente de la teoría cuántica. En una escuela de pensamiento (probablemente la más popular), los sistemas cuánticos experimentan un «colapso» irreversible cuando son medidos. Esto proviene de la notable capacidad de un objeto cuántico como un átomo de existir en dos estados completamente diferentes a la vez. Por ejemplo, podría estar girando al mismo tiempo en el sentido de las agujas del reloj y en el sentido contrario a las agujas del reloj. Sin embargo, cuando se efectúa la medición, dicho doble estado se ve obligado a convertirse en uno u otro: se encontrará que el átomo medido gira en el sentido de las agujas del reloj o en el sentido contrario, y no retornará espontáneamente al estado en que giraba en ambos sentidos.

Sin embargo, hay un problema con estas descripciones de la flecha del tiempo. No nos conducen a ninguna parte porque requieren el concepto de cambio. Y el cambio, tal como señaló Aristóteles, es un marcador del paso del tiempo. Mediante consideraciones de la flecha del tiempo no hemos avanzado nada en la definición del tiempo. Todo lo que tenemos es una supuesta explicación para la dirección que parece que toma. E incluso esto ha sido socavado. La flecha del tiempo podría ser parte de nuestra experiencia individual, pero no tenemos razones para creer que esto la hace real. Peor todavía, tenemos buenas razones para creer que no lo es.

Un alargamiento del tiempo

Hemos de agradecer a Albert Einstein esta intuición turbadora: reside en el núcleo mismo de su teoría especial de la relatividad. Einstein era comparativamente poco conocido cuando publicó sus ideas en 1905. La relatividad especial fue una obra revolucionaria, que de un solo plumazo despachó el concepto popular, y duradero, del éter, una especie de fluido fantasmagórico que llena todo el espacio y proporciona un fondo a través del cual los campos electromagnéticos, como la luz, pueden desplazarse.

Llegados a este punto, vale la pena mencionar que, tal como dijo una vez el malogrado Carl Sagan, mientras que las teorías extraordinarias requieren pruebas extraordinarias, la relatividad especial es una de las pocas de dichas teorías en las que se han encontrado pruebas extraordinarias que la respaldan. Lo que el lector va a leer ahora puede parecer absurdo, pero tenemos todas las razones para tomárnoslo en serio.

El punto central de la relatividad especial es que las leyes de la física funcionan igual para todos, con independencia de cómo se estén desplazando por el universo. La consecuencia más importante de ello es que la velocidad de la luz es una constante, conocida universalmente como c.

Si el lector fuera a medir la velocidad de la luz emitida por los faros de un vehículo que se desplazara hacia él a 100 kilómetros por hora, la velocidad de la luz sería c, no c más 100 kilómetros por hora.

La velocidad de la luz no cambia en función del movimiento relativo del emisor y el observador. La conclusión extraordinaria de la constancia de c es que, cuando las condiciones lo requieren, todo lo demás cambia... incluido el tiempo.

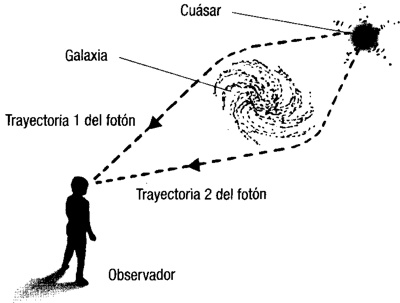

La velocidad constante de la luz. La velocidad de la luz c, es constante con independencia de si la fuente de luz se mueve o permanece estacionaria

El paso del tiempo es un asunto tan flexible en el mundo físico real como lo es dentro de nuestra mente.

Imaginemos una escena en la que el lector se halla situado a 100 metros de un cruce controlado por semáforos. El lector está equipado con un cronómetro asombrosamente preciso, una regla y reflejos rapidísimos. El semáforo rojo se enciende y el lector puede medir el tiempo que tarda el primer pulso de luz roja en viajar a lo largo de la regla del lector. En este momento, un coche pasa junto a éste, desplazándose hacia el cruce a 100 kilómetros por hora. El pasajero del asiento delantero tiene las mismas habilidades y equipo que el lector, y realiza la misma medición: el tiempo que tarda la luz en desplazarse a lo largo de la regla.

Ambos, el pasajero y el lector, han medido la velocidad de la luz, y Einstein insiste en que ambos han de obtener el mismo resultado.

Pero, cuando el coche pasó junto al lector en dirección al semáforo, la regla que se hallaba en su interior también se movió en relación al lector. Para cuando la luz alcanzó el extremo de la regla en el coche, el extremo posterior de ésta se hallaba más cerca del semáforo, de modo que la luz tuvo que viajar una menor distancia en comparación con la regla del lector. El pasajero del coche tuvo que medir la luz como algo más rápido, que recorrió un metro en menos tiempo. ¿Cómo puede ser, entonces, que ambos obtuvieran el mismo resultado? La respuesta tiene que ver con el paso del tiempo en situaciones distintas. En comparación con el reloj del lector, el reloj en el coche que se desplaza se mueve más lentamente. Así, aunque la luz tenía aparentemente menos distancia que recorrer, la medición del tiempo en el coche fue más extensa que la del lector, lo que compensó el efecto.

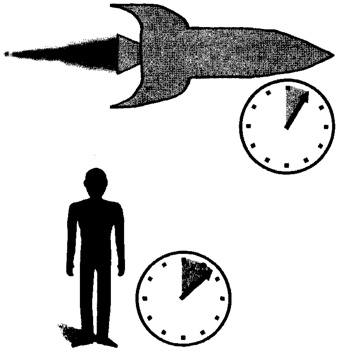

Dilatación del tiempo

Esto no es un juego de manos en el que una combinación de ilusiones hace que obtengamos el resultado correcto. El efecto, conocido como dilatación del tiempo, sólo se torna claramente perceptible cuando el reloj se mueve a velocidades cercanas a la de la luz, pero sigue siendo cierto que un reloj que se desplaza en relación con nosotros irá realmente más lento que un reloj que tengamos en la mano. Y la palabra «reloj» se refiere a cualquier cosa que pueda marcar el paso del tiempo. Si esta afirmación se diseca, se verá que surgen todo tipo de implicaciones inquietantes.

Parientes que envejecen

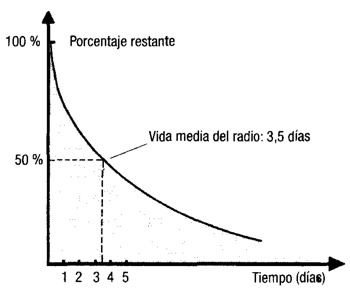

Empecemos con algo que es casi tan concebible. Tomemos un borujo de polonio, un material radiactivo descubierto por Pierre y Marie Curie hace unos 100 años. Una forma de polonio, el polonio-209, tiene una media de vida de unos 100 años; es decir, al cabo de un siglo, la mitad de sus átomos habrán emitido una explosión de radiación y se habrán transmutado en átomos más estables.

Si los Curie hubieran tomado dos borujos idénticos de este material cuando lo descubrieron, y hubieran dejado uno en su laboratorio de París mientras enviaban al otro en un viaje de ida y vuelta al espacio a 0,99 de la velocidad de la luz, y que hubiera retornado a la Tierra en la actualidad, observaríamos algo notable sobre la cantidad de radiación que ambos fragmentos emitían. El fragmento que permaneció en París habría perdido la mitad de sus átomos de polonio radiactivo durante dicho siglo. Lo sorprendente es que su gemelo, el borujo que fue enviado en un cohete al espacio mientras en la Tierra pasaban 100 años, sólo habría perdido el 10 %.

Ello se debe a que el movimiento con relación a la Tierra a 0,99 de la velocidad de la luz (dejando de lado aspectos prácticos tales como la aceleración, la deceleración y el dar la vuelta) hace que el tiempo sea más lento para este pedazo. Su «reloj», medido por la tasa a la que sus átomos experimentan la desintegración radiactiva, se mueve sólo al 14 % de la velocidad de su gemelo, que nunca abandonó el planeta. Esta es la razón por la que tantos de sus átomos radiactivos permanecen intactos. Quizá esto sea muy difícil de creer; pero veamos ahora algo realmente inconcebible.

Hagamos que Pierre y Marie Curie guarden los dos pedazos de polonio. Pierre acompañará a un fragmento en aquel viaje de ida y vuelta por el espacio, mientras que Marie se quedará en París con su fragmento. El cuerpo de los científicos también tiene un reloj interno: al igual que pasa con el polonio, sus átomos cambian con el paso del tiempo, creando un latido del corazón, por ejemplo, y células que se detienen después de realizar un determinado número de divisiones (fenómeno que los biólogos creen que está en la base del envejecimiento y la muerte).

Mientras no tenemos en cuenta los efectos seguramente catastróficos de la radiación, los átomos (y por lo tanto las células y los latidos) del cuerpo de Pierre irán más lentos en comparación con los de Marie, del mismo modo que la desintegración radiactiva del polonio va más lenta que en la Tierra. Cuando Pierre retorne, 100 años terrestres más tarde, Marie ya hará tiempo que habrá muerto, pero el cuerpo de Pierre sólo ha envejecido 14 años. Una conclusión inmediatamente obvia de esto es que, si se tienen los recursos adecuados, el viaje en el tiempo hacia el futuro es completamente posible. Pero sólo hay un paso desde este punto hasta la asombrosa revelación de que la teoría de la relatividad especial de Einstein elimina en todo caso la idea de algún futuro común. Y tampoco hay un presente ni un pasado comunes.

En busca del tiempo perdido

El lector puede afirmar, mientras se halla mirando el semáforo, que vio dos acontecimientos que tenían lugar simultáneamente. Pero, como hemos visto, el pasajero del coche tiene un reloj que marcha a una velocidad diferente. La información que lector y pasajero obtienen a propósito de la temporización de estos dos acontecimientos bien pudiera ser muy distinta. Peor aún, el lector podría ver dos acontecimientos, A y B, que ocurrieran en momentos distintos, B después de A. Sin embargo, en función de cómo se desplazara el amigo relativo del lector, éste podría ver que A sigue a B. Esto es potencialmente catastrófico: si el lector piensa que A causó B, ¿cómo puede explicarse esto a alguien que vio que B ocurría primero?

Pasado, presente, futuro, simultaneidad, causa y efecto... nada es universal. Cuando se trata del tiempo y de los procesos que gobierna, el lector y su núcleo estriado no pueden contar con nadie. Sin embargo, existe una respuesta sencilla a toda esta confusión, y es una respuesta que resulta atractiva a muchos físicos y filósofos. Podríamos eliminar la idea misma de que el tiempo existe.

Es una argumentación que se remonta al siglo XVII. Newton, cuya fe cristiana requería que espacio y tiempo reflejaran el carácter de Dios, consideraba que el tiempo era una entidad real, un absoluto que se mueve con independencia de todo lo que hay en el universo. Pero Gottfried Leibniz, su gran rival, creía que el tiempo era un artefacto humano. Todo lo que podemos hacer, decía Leibniz, es describir la manera en que las posiciones de los objetos en el espacio se relacionan entre sí, y cómo evoluciona dicha relación. Es útil que el péndulo de un reloj oscile a uno y otro lado y que las agujas del reloj circulen alrededor del dial en respuesta, por ejemplo, pero esto no significa que el reloj esté midiendo algo que existe realmente. El tiempo, según su concepción, procede de nuestro deseo de hacer que el mundo tenga sentido, pero no es otra cosa que un medio de orientación útil. Es una abreviación, como el concepto espacial de «arriba». «Arriba» significa una cierta dirección cuando estoy de pie en Londres, pero la misma dirección es en realidad «abajo» en Sidney.

Esta conexión es poco más que una ilustración conveniente. Cuando Einstein publicó su teoría de la relatividad general (lo de «especial» en «teoría especial» se refiere a un caso especial, es decir, particular, no a una importancia especial), postuló una relación entre tiempo y espacio. El tiempo, dijo, no es más que una de las cuatro dimensiones del universo. Las otras tres son las familiares en las que movemos nuestro cuerpo físico: arriba y abajo, a un lado y a otro, adelante y atrás. La única diferencia es que, mientras que nosotros, criaturas conscientes, podemos elegir cómo movernos a través de las dimensiones espaciales, no tenemos control sobre nuestro movimiento a través del tiempo.

Expandiendo el espacio y el tiempo

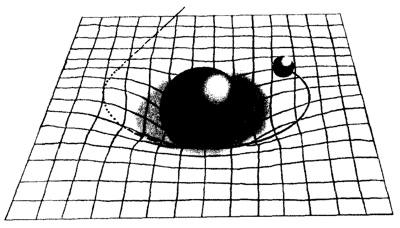

Se puede pensar en las cuatro dimensiones de Einstein de espacio y tiempo (que conjuntamente se conocen como espacio-tiempo) como un retazo de tejido que puede distorsionarse, doblarse, plegarse, retorcerse e incluso desgarrarse por cualquier cosa en su interior que tenga masa o energía. A partir de estos cimientos, la relatividad general nos ha dotado de ecuaciones que describen las características del cosmos con una precisión sin precedentes, lo que nos ha permitido descubrir cómo funciona el universo, enviar naves espaciales a destinos distantes y crear el dispositivo de satélites de posicionamiento global que nos dicen en qué lugar de la Tierra nos encontramos. Pero quizá lo que es más intrigante de todo, la naturaleza flexible del tejido tetradimensional de Einstein nos proporciona pistas sobre el origen del tiempo.

Nuestra masa distorsiona muy poco el espacio-tiempo. La masa del Sol lo distorsiona mucho más; según la relatividad general, esta distorsión es la base de la atracción gravitatoria que mantiene a nuestro planeta en órbita. Más potente todavía es la distorsión provocada por una estrella gigante desintegrada: un agujero negro. Y es aquí donde atisbamos la verdadera potencia del trabajo de Einstein.

El campo gravitatorio enormemente fuerte de un agujero negro significa que existe una región esférica cerca de su centro en que la velocidad necesaria para alejarse del agujero negro es mayor que la velocidad de la luz: una velocidad que es imposible alcanzar. Nada, ni siquiera la luz, puede escapar de esta región, de manera que no podemos obtener ninguna información acerca de nada de lo que pueda ocurrir más allá de su límite. De ahí su nombre: el horizonte de eventos (también llamado horizonte de sucesos).

En el horizonte de eventos, la dilatación del tiempo es infinita. Alguien que estuviera observando desde una distancia segura mientras caemos hacia el horizonte de eventos vería que nuestros movimientos se hacen más lentos y después se detienen al pasar el tiempo de manera infinitamente lenta para nosotros en comparación con el observador. Sólo en el futuro infinito del observador alcanzaríamos el horizonte de eventos, de modo que realmente nunca desapareceríamos de la vista. Nuestra experiencia, por otra parte, sería sumamente dramática. Es muy improbable que nuestro cuerpo sobreviviera a las enormes fuerzas gravitatorias, pero si sobreviviéramos, terminaríamos por encontrar lo que, según la relatividad, es una interrupción en la urdimbre misma del espacio-tiempo. Dicha «singularidad» en el centro de un agujero negro tiene lugar cuando la distorsión se hace infinita. Aquí alcanzamos el límite de las leyes conocidas de la física; más allá de este punto, dichas leyes no son de aplicación.

El momento en el que empezaron los momentos.

Aunque por lo general se asocia con la destrucción, se piensa también que la singularidad es la clave de la creación. A principios de la década de los setenta, Roger Penrose y Stephen Hawking adaptaron la idea matemática de la singularidad del agujero negro para explicar el origen del universo. En un agujero negro, todo desaparece dentro de la singularidad. Sin embargo, si se invierte la matemática del proceso, la singularidad podría dar nacimiento a la trama misma del espacio-tiempo. Durante más de tres décadas, esto se ha considerado nuestra mejor descripción del Big Bang, el origen del propio tiempo.

Si la relatividad general arroja alguna luz acerca de dónde procede el tiempo, sigue sin decirnos demasiado acerca de lo que es el tiempo. Y, lo que es más, por impresionantes que sean las formulaciones de Einstein del carácter del espacio y el tiempo, sabemos que la relatividad especial y la general no son la respuesta final.

Si la singularidad nos enseña algo, es que, mientras que la relatividad general funciona notablemente bien en muchos escenarios, no ofrece una explicación satisfactoria para los fenómenos más extremos de nuestro universo. Una descripción más completa del cosmos y de cómo se comporta todo su contenido (incluidos los centros de los agujeros negros), teoría a la que a menudo se denomina de la «gravedad cuántica», todavía se nos escapa. Y resulta que la naturaleza del tiempo se halla en el meollo mismo del problema.

La gravedad cuántica ha de introducir las ideas relativistas del tiempo en la teoría cuántica, nuestra mejor descripción de cómo se comporta el micromundo de las moléculas, átomos y partículas subatómicas. Pero la teoría cuántica no presta apenas atención al tiempo. Por ejemplo, en la formulación estándar de la teoría no se pueden plantear preguntas acerca de cuánto tarda un proceso. Después está el problema de que la teoría cuántica nos dice que la mayor parte de las partículas subatómicas existen con independencia de la dirección del tiempo. De la misma manera que pueden girar al mismo tiempo en el sentido horario y en el antihorario, sus estados cuánticos pueden desarrollarse hacia delante y hacia atrás en el tiempo. Los investigadores están incluso aprendiendo a realizar experimentos cuánticos en los que la información parece proceder de los futuros de las partículas. Más aún: la relatividad especial nos dice que las partículas sin masa, como los fotones y gluones que mantienen los núcleos unidos, se desplazan a la velocidad de la luz y ni siquiera experimentan el paso del tiempo.

El gran físico John Wheeler dijo una vez: «El tiempo es la manera que tiene la naturaleza de evitar que todo ocurra al mismo tiempo». Debió decirlo mientras guiñaba un ojo, pues sabía perfectamente bien que la aparente simplicidad del tiempo contradice su verdadera naturaleza. San Agustín fue más honesto cuando dijo: «Entonces, ¿qué es el tiempo? Si nadie me lo pregunta, sé lo que es. Si quiero explicárselo a quien me lo pregunta, no lo sé».

A pesar de todos nuestros logros científicos desde san Agustín, el tiempo sigue siendo un enigma, posiblemente la mayor de las cuestiones a las que se enfrentan los físicos en la actualidad. Pero si el tiempo es una ilusión, al menos es una ilusión útil. Nuestra interpretación de sus consecuencias (nuestros recuerdos del pasado, nuestra existencia en el presente y nuestras esperanzas para el futuro) reside en el meollo de la experiencia humana. O esto es lo que nuestro núcleo estriado quiere que creamos.

Capítulo 3

¿Qué le pasó al gato de Schrödinger?

La física cuántica y la naturaleza de la realidad

Corría el año 1925, la mejor época de Buster Keaton y Charlie Chaplin. El mundo estaba ansioso por ver La fiebre del oro, que se anunciaba que iba ti ser la mejor película de Chaplin hasta la fecha, y que iba a estrenarse al mes siguiente. Y el pobre Wolfgang Pauli, un estudiante de física radicado en Hamburgo, Alemania, estaba deprimido. «En la actualidad la física está de nuevo muy embrollada; en cualquier caso, para mí es demasiado complicada - escribía a un colega-. Me gustaría ser un actor de cine o algo por el estilo y no haber oído hablar nunca de física.»

Pauli tenía razón: la física estaba embrollada. Nadie entendía de qué iba la teoría cuántica, acabada de formular. Los experimentos dictaban que la energía tenía que estar fraccionada en paquetes indivisibles o cuantos, pero nadie podía decir por qué. Entonces, justo algunos meses más tarde, el físico austríaco Erwin Schrödinger aclaró la confusión. Ocurrió durante una excursión a las montañas suizas con una mujer que no era su esposa, y terminó cuando él se planteó el destino de un gato imaginario. El minino se convirtió rápidamente en el animal más famoso de la ciencia. El relato del gato de Schrödinger posee el misterio de la teoría cuántica que lo atraviesa de lleno, y su naturaleza adecuadamente enigmática permanece intacta hasta el día de hoy.

El origen del descubrimiento de Schrödinger reside en el trabajo de un físico francés llamado Louis de Broglie. En 1923, De Broglie unió la relatividad, que generalmente es la física de las escalas de distancia y velocidad muy grandes, y la naciente teoría cuántica, la física de lo muy pequeño. El resultado fue una ecuación simple. Toda partícula en movimiento, decía De Broglie, podría describirse igualmente bien como una onda. Toda onda podría describirse como una partícula en movimiento. Einstein, cuando se le presentó el trabajo, proclamó que era «bastante interesante». Sin embargo, dos años después Schrödinger demostró que era muchísimo más que esto.

Erwin Schrödinger dedujo las implicaciones matemáticas de la fórmula de De Broglie durante unas vacaciones de Navidad en 1925. Después de dejar a su mujer en Zúrich, Schrödinger se llevó a su amante a un chalet en las montañas suizas. Este no era un comportamiento insólito en él: parece que Schrödinger y su mujer llegaron a diversos «arreglos» a lo largo de su matrimonio. Sea como fuere, es claro que el viaje fue inspirador. Schrödinger volvió de las montañas con lo que ahora se conoce como la ecuación de onda de Schrödinger. Ésta describe cómo se comporta una partícula cuántica cuando es considerada como una onda.

La ecuación de Schrödinger proporciona una manera de comprender de dónde proceden los estados cuánticos. Tómese, por ejemplo, el modelo del átomo de Bohr, en el que un electrón que gira alrededor del núcleo sólo puede tener determinados estados energéticos. La ecuación de Schrödinger proporciona una manera de deducir cuáles son estas energías «cuantizadas»: el electrón sólo es estable cuando su onda completa un número entero de oscilaciones durante su órbita.

Esto fue una revelación para los físicos, que no tenían una justificación adecuada de las energías cuantizadas. Pero la ecuación también proporciona una manera de deducir de qué manera la energía de un electrón, pongamos por caso, evolucionará a lo largo del tiempo en una determinada situación. Puede proporcionarnos asimismo la posición de la partícula, o su momento, o cómo terminarán los estados cuánticos de dos partículas que interaccionan. Fue considerada como un golpe maestro. Sólo había un problema.

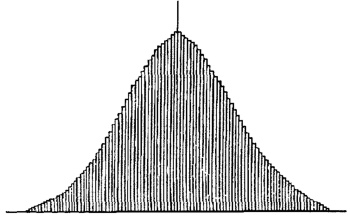

Nadie podía ponerse de acuerdo acerca de qué significaba realmente la ecuación de onda. ¿Significaba que las partículas eran realmente ondas? Schrödinger así lo creía (o más bien lo esperaba). Einstein se puso de su lado. Pero otros no estaban de acuerdo. Max Born, físico de la Universidad de Gotinga, por ejemplo, demostró que las soluciones de la ecuación de onda no podían dar otra cosa que probabilidades. La probabilidad de encontrar una partícula en un espacio determinado, por ejemplo, o la probabilidad de que una partícula posea un determinado momento.

Según esta aproximación, la ecuación era una guía a lo que podríamos descubrir acerca del sistema cuántico que se inspeccionaba, pero no tenía nada que decir acerca de cuál era realmente la naturaleza del sistema. En otras palabras, no nos proporcionaba una descripción de lo que podíamos saber sobre éste. Desde el punto de vista filosófico, esto era una pesadilla. Einstein la odiaba, al igual que Schrödinger.

Pensar en positivo

A Niels Bohr, en cambio, le gustaba. Bohr vivía en Copenhague, donde dirigía un instituto financiado por la cervecera Carlsberg. Era un «positivista»; su filosofía decía que no tenía sentido hablar sobre las propiedades objetivas de algo porque sólo se podía obtener conocimiento acerca de ello mediante medidas subjetivas. Dichas medidas siempre impondrán restricciones a lo que podemos conocer.

La realidad última detrás de la ecuación de onda de Schrödinger no era ni una onda ni una partícula, creía Bohr, de modo que no podía describirse mediante ningún término con el que podamos tratar. Su respuesta fue suponer que nada existe hasta que es medido. Pero, una vez se ha efectuado la medición, el tipo de medida determinará qué es lo que vemos. Por ejemplo, si utilizamos un instrumento que detecta la posición de algo en el espacio, veremos algo que tiene una posición definida en el espacio, la entidad que denominamos una partícula.

Einstein no quería saber nada de esta «interpretación de Copenhague» de la teoría cuántica. Su gran obra, la relatividad, había sido construida específicamente para crear una teoría que fuera independiente del observador. El tema fundamental de la relatividad era que las leyes de la física tenían que ser las mismas, quienquiera que fuera que las dedujera. La idea de que la naturaleza física del universo dependa de cómo lo observemos ofendía profundamente su sensibilidad.

El problema de Einstein residía en el hecho de que describir objetos cuánticos utilizando una ecuación de onda significaba que, como las ondas, éstos podían interferir entre sí. Cuando dos ondas interaccionan, producen una «superposición», que es la suma de las ondas en cualquier punto. Allí donde coinciden dos crestas, la superposición es mayor que ambas. Cuando coinciden dos valles, el valle de la onda se hace más profundo. Si coinciden una cresta y un valle, el resultado es plano.

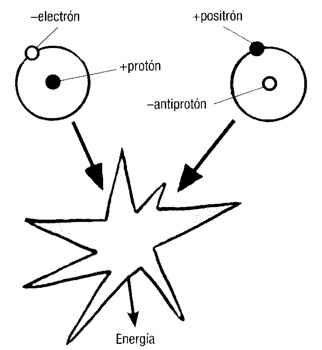

¿Cómo se aplica esto a las partículas cuánticas? La ecuación de onda de Schrödinger dice que, en las circunstancias adecuadas, existen en una superposición de estados diferentes. Así, un electrón que circula por un anillo de metal puede estar circulando al mismo tiempo en el sentido de las agujas del reloj y en sentido contrario. Un fotón de luz puede estar polarizado (es decir, tener su campo eléctrico orientado) en cualquier número de direcciones al mismo tiempo. Un átomo radiactivo, que se desintegra mediante un proceso cuántico, puede hallarse en un estado de superposición de «desintegrado» y «no desintegrado». Aunque parezca disparatado, esto es lo que dice la teoría.

Que es la razón por la que Einstein y Schrödinger dijeron que tendría que haber algo que faltaba en la teoría. Y, para llevar el agua a su molino, Schrödinger dio con el gato.

Schrödinger seguía describiendo este caso «ridículo» con un cierto detalle, creando sin proponérselo la piedra de toque para interpretaciones futuras de la teoría cuántica.

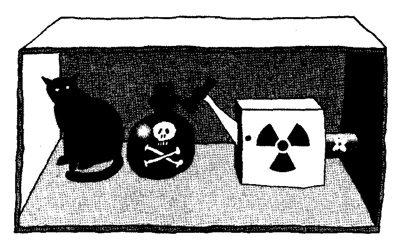

El gato en la caja

En la caja de acero cerrada con el gato de Schrödinger hay un pequeño fragmento de material radiactivo y un contador Geiger. En cualquier momento hay cierta probabilidad de que el material radiactivo emita una partícula, desencadenando así una corriente eléctrica en el contador Geiger. Pero Schrödinger tenía el contador Geiger dispuesto de tal manera que liberaba un martillo que, al notar una emisión radiactiva, rompería un frasco de ácido cianhídrico que liberaría vapores que matarían al gato.

Según Schrödinger, la descripción cuántica de todo el sistema, incluyendo todos los átomos que constituyen el gato, «expresaría esto al tener el gato vivo y muerto (perdón por la expresión) mezclado o embadurnado a partes iguales». La lógica es robusta. La naturaleza indeterminada del átomo radiactivo, en una superposición de «desintegrado» y «no desintegrado», también puede poner al gato en una superposición de muerto y vivo.

El final sorprendente llega cuando se trae a colación el tema de la medición. Bohr había dicho que no hay una realidad definida hasta que no se efectúa una medición, porque la elección del instrumento de medida determina qué faceta del sistema (onda o partícula, por ejemplo) verá el observador.

El experimento imaginario del gato de Schrödinger

Así, en opinión de Bohr, el acto de abrir la caja y observar el estado del gato lo obligaría a estar vivo o muerto.

Esto era lo que Schrödinger encontraba tan ridículo: ¿cómo puede el acto de observación cambiar una propiedad tan fundamental de un gato? Tiene que ser una cosa o la otra; Bohr se engañaba de la misma manera que una fotografía borrosa puede dar una impresión de niebla, decía. «Hay una diferencia entre una fotografía movida o desenfocada y una instantánea de nubes y bancos de niebla».

Pero para aquel entonces, la interpretación de la teoría cuántica ya era un asunto de debate público: Einstein y Bohr tuvieron una famosa discusión en 1927, en la quinta conferencia Solvay en Bruselas. Einstein retó a Bohr con una serie de experimentos imaginarios. Imagine tal y cual situación, le decía; ¿cómo puede la observación, o la interacción con el aparato, causar que una superposición se resuelva en un estado o en otro?

Ondas y balas

El resultado final de esta discusión fue una nueva versión de un experimento antiguo: el famoso experimento «de la doble rendija». En 1801, Thomas Young desbarató la teoría de Newton de la luz como partículas haciendo que una luz iluminara una pantalla marcada con dos hendiduras. Young observó un patrón de «interferencia», que sólo puede explicarse mediante la superposición de ondas.

La versión cuántica pregunta qué ocurre cuando se reduce la intensidad de la luz hasta el extremo en que hace su aparición la teoría cuántica. Cuando sólo hay una bala, o «fotón» de luz en el experimento en un momento dado, es claro que no puede haber interferencia, ¿verdad?

En la interpretación de Bohr puede haberla... mientras nadie observe para ver a través de qué rendija se desplazó el fotón. Para Bohr, la luz no es una onda ni una partícula; éstos son nombres que damos a algo cuyas propiedades hemos medido. Según la ecuación de onda de Schrödinger, los fotones de luz atraviesan ambas rendijas. A pesar de ser una partícula única, cada fotón es «embadurnado» en forma de onda, y posee efectivamente dos existencias independientes cuando atraviesa las rendijas. Mientras nadie mida el camino que la luz toma, toma todos los caminos disponibles.

El lector puede pensar que todo esto es un juego de palabras: experimentos imaginarios abstractos cuya naturaleza misteriosa desaparecerá cuando los experimentos se realicen en el mundo natural. El lector se equivocaría, para deleite de Bohr. No lo descubrimos con seguridad hasta hace relativamente poco tiempo. El primer experimento de doble rendija con sólo una partícula en el aparato en un momento dado no se realizó hasta la década de los setenta. Pero funcionó: a pesar de encontrarse ante dos rendijas, una sucesión de electrones formó gradualmente un patrón de interferencia sobre la pantalla situada más allá de las rendijas.

Y, de manera fantasmagórica, cuando en el experimento se situó un instrumento para medir qué rendija atravesaba el electrón, el patrón de interferencia desapareció. En otras palabras, la medición hizo que el electrón se manifestara como una partícula, no como una onda. Esto podría parecer muy alejado del gato de Schrödinger; después de todo, un gato es una bestia muy distinta de un electrón. Pero experimentos subsiguientes han aumentado la partícula cuántica a tamaños cada vez mayores.

Hemos realizado el experimento de doble rendija cuántica con fotones, electrones, átomos e incluso con moléculas de fulereno, de 60 átomos. El misterioso efecto de interferencia nunca ha desaparecido... a menos que intentemos observar a través de qué rendija pasó la partícula. Hay planes en preparación para hacerlo con partículas mucho mayores: un virus, y quizá algo un millón de veces mayor que la molécula de fulereno. Aparte de las dificultades de construir el experimento, no hay ninguna razón fundamental para detenerse aquí: no hay ninguna causa que sugiera que un gato real no tenga que comportarse de la misma manera que un electrón, dadas las circunstancias adecuadas y una doble rendija del tamaño de una trampilla para gatos.

Excepto, desde luego, que es fácil ver un gato real y de este modo determinar a través de qué trampilla pasó. En el experimento imaginario de Schrödinger, la caja ha de permanecer cerrada de manera que nadie pueda ver el gato, no se realiza ninguna medición y la superposición permanece intacta. Esto nos lleva a una pregunta difícil, que Bohr siempre eludió. ¿Qué es lo que constituye una medición? En el gato de Schrödinger, ¿lo es cuando se abre la caja? ¿Cuando los fotones de luz rebotan en el gato y nos transmiten información que nos permite decir si el gato está vivo o muerto? ¿O lo es cuando esos fotones penetran en nuestros ojos? ¿O cuando nuestra mente consciente registra el estado del gato? La respuesta de Bohr a este galimatías era, esencialmente, que los físicos ya saben cuándo han hecho una medición. Sin embargo, versiones modernas del experimento del gato de Schrödinger están arrojando mucha más luz sobre el proceso... y explican por qué un gato no puede estar a la vez vivo y muerto.

No mires ahora

El límite entre el mundo «clásico» en el que habitamos y el mundo cuántico de los átomos desciende hasta las ondas de De Broglie que fueron el origen de toda esta historia. La longitud de onda de De Broglie de un cuerpo, que depende de su momento, da una medida de la escala a la que se manifestará como una onda cuántica.

En el experimento de doble rendija, la molécula de fulereno tiene una longitud de onda de De Broglie de alrededor de 10-12 metros, o una billonésima de metro. La separación entre las rendijas es aproximadamente medio millón de veces mayor que esto; mayor, pero no muy diferente en escala. Ello significa que el sistema es adecuado para exhibir el comportamiento ondulatorio. Esto sigue estando de conformidad con la afirmación de Bohr de que la elección del aparato de medida decide qué características se manifestarán, pero descarta dos explicaciones de por qué no puede parecer que un gato o una persona (a diferencia de la molécula de fulereno) se hallan en dos lugares al mismo tiempo.

La primera razón es práctica. Por ejemplo, si caminara a lo largo de una pared a unos tres kilómetros por hora, el gato de Schrödinger tendría una longitud de onda de alrededor de 10-28 metros. Su comportamiento cuántico, ondulatorio, sólo quedaría descubierto por un dispositivo de medición de una escala similar. Puesto que nunca hemos creado tal dispositivo, no podemos percibir el comportamiento cuántico. La vida cotidiana es, según el modelo de Bohr, una situación experimental que siempre manifestará la naturaleza de tipo particulado de todo lo que nos rodea.

La segunda razón por la que somos «clásicos» es que emitimos radiación. Cualquier cosa que tenga una temperatura por encima del cero absoluto, -273 grados Celsius, emite fotones, paquetes de energía que se llevan calor. Mediante experimentos se ha demostrado que dicha radiación puede usarse para encontrar la localización del objeto, revelando así efectivamente a través de qué rendija pasó. En otras palabras, a una temperatura por encima del cero absoluto no se puede cerrar la caja del gato de Schrödinger, lo que invalida la premisa del experimento imaginario cuando se lo quiere trasladar al mundo real.

Dichos experimentos se realizaron disparando moléculas de fulereno a una rendija doble. Cuanto más caliente estaba la molécula de fulereno a medida que se acercaba a las rendijas, más borroso era el patrón de interferencia. La molécula caliente emite fotones y la energía de los fotones emitidos viene determinada por la temperatura. Una temperatura más elevada confiere esencialmente más energía, lo que se traduce, en los términos de De Broglie, en una radiación de onda más corta. Y cuanto más corta es la radiación de onda de la radiación emitida, más fácil es inferir la posición de la molécula emisora. En otras palabras, un cuerpo caliente parece revelar más información acerca de qué rendija puede atravesar.

Lo mismo ocurre si las moléculas de fulereno colisionan con moléculas de aire en el camino hacia las rendijas. Normalmente los experimentos se realizan en un vacío elevado, pero si el vacío no es muy bueno y la posición del fulereno puede inferirse al observar qué hace a las moléculas de aire, el patrón de interferencia desaparece. Aquí, de nuevo, puesto que es posible inferir qué rendija atraviesa la molécula, su capacidad para atravesar ambas a la vez empieza a desvanecerse. En un vacío parcial, el fulereno se comporta como si alguien hubiera dejado la caja del gato de Schrödinger medio abierta, obligándolo así a estar vivo o muerto, pero no ambas cosas a la vez.

Si se utiliza otro fenómeno cuántico llamado «enmarañamiento» para conectar juntas series de átomos en superposición, se permite a los investigadores de los ordenadores cuánticos crear una ristra de números indeterminados que, cuando se disponen a través de una serie de pasos, realizan cómputos en todos los números posibles a la vez. La computación cuántica es una manera de realizar cómputos «paralelos» a una escala sin precedentes. En teoría, una ristra enmarañada de sólo 250 átomos, cada uno de ellos en un estado de superposición de gato de Schrödinger, puede codificar más números que átomos hay en el universo. El potencial es enorme. No es extraño que los gobiernos Intenten proteger sus códigos de la seguridad nacional de los que desarrollan el primer ordenador cuántico,

Sólo hay un problema. La naturaleza del enmarañamiento y la superposición hacen a los átomos especialmente vulnerables a perder información, y cuando lo hacen, el cómputo se malogra. Si los investigadores pudieran conseguir un mayor dominio de la decoherencia y descubrir por qué no vemos nunca gatos a la vez vivos y muertos, podrían abrir el camino a una revolución en el cómputo.

Así pues, la información no ha de entrar en una mente consciente para constituir una medición: sólo tiene que escaparse del sistema bajo escrutinio. Parece que un flujo de información acerca de la salud del gato de Schrödinger es suficiente para obligarlo a adoptar uno de los dos estados posibles. En lo que concierne a humanos y gatos, dicha información se escapa porque nuestro cuerpo interacciona con nuestro entorno de muchísimas maneras, radiando calor y desplazando moléculas de aire. La información acerca de la posición de nuestro cuerpo está disponible, lo que significa que no podemos hallarnos en dos lugares a la vez. Los científicos denominan «decoherencia» a este derramamiento de información. La decoherencia no es un asunto trivial: podría mostrarnos la naturaleza misma del universo.

Información y realidad

Los físicos que estudian el enigma del gato de Schrödinger se preguntan ahora si acaso éste indica la idea de que la información es el elemento más fundamental de la realidad. La teoría cuántica, en la forma del desdichado gato de Schrödinger, sugiere que el universo (Hiede describirse como una gigantesca máquina procesadora de información. Y esto también conduce a aplicaciones potenciales.

Por potente que resulte ser, es improbable que el ordenador cuántico pueda ayudarnos a comprender de qué manera puede un gato estar vivo y muerto al mismo tiempo. La idea de que esto forma parte de la naturaleza de la realidad física sigue siendo realmente extravagante para la mente humana. Wolfgang Pauli, que no abandonó la física y se convirtió en uno de los físicos más brillantes de la historia de la ciencia, tenía razón. Es demasiado complicada para entenderla. Tal como una vez dijo Niels Bohr: «Quien no se sienta sorprendido por la teoría cuántica es que no la ha comprendido».

Capítulo 4

¿Por qué cae una manzana?

Gravedad, masa y el enigma de la relatividad

Debido a la gravedad, desde luego. Todo el mundo lo sabe. Sin embargo, ¿cuál es la naturaleza fundamental de la gravedad? Esta es una pregunta mucho más difícil de contestar, a pesar de que la gravedad es la primera de las fuerzas fundamentales de la naturaleza que penetra en nuestra consciencia.

He aquí un experimento que el lector puede probar en casa. Necesitará un bebé de seis meses de edad (puede pedir uno prestado). Ate el lector un fragmento de hilo de pescar a uno de los juguetes del bebé (un sonajero, pongamos por caso). A continuación, suspéndalo del techo a una altura tal que descanse ligeramente sobre una silla, con el hilo tensado e invisible. Haga que el bebé mire el juguete mientras el lector retira la silla. Mantenga la mirada en el bebé: cuando, por ninguna razón obvia, el sonajero no caiga al suelo, el bebé lo mirará durante mucho más tiempo de lo normal.

Esto, según los psicólogos, es la manera que tienen los bebés de expresar asombro. Parece que, desde una edad sorprendentemente temprana, sabemos que las cosas están hechas para que caigan cuando no se las sostiene, y quedamos perplejos cuando no lo hacen. No es extraño que los trucos de levitación de los ilusionistas Victorianos fascinaran a toda una generación. Cuando las cosas burlan la gravedad, nuestra esencia misma se ofende.

La gravedad, amigo lector, es un tirano. No se la puede engañar. No la podemos bloquear, como podemos hacer con un campo eléctrico o uno magnético. Tampoco la podemos contrarrestar con una fuerza opuesta; no parece haber nada en física que nos proporcione antigravedad. El dominio de la gravedad es tan fundamental en la experiencia humana que, esencialmente, nos hemos olvidado de la presencia de la gravedad. Es sólo en su ausencia (o, más bien, en su ausencia aparente) que recordamos que siempre está allí.

Quizá ésta sea la razón por la que las primeras incursiones en ciencia ignoraron en gran medida la gravedad. Tal como ahora la entendemos, un tipo de acción rige la caída de un humano que da un traspié, el arco del vuelo de una flecha y el movimiento de los planetas, pero el manual de física de Aristóteles no hace mención de ninguna fuerza universal que orqueste el universo. Sí que sugirió que los objetos no caen de la Tierra debido a la «pesadez» de la misma, pero su razonamiento era secundario. Sugirió que la fuerza de la atracción que ejercía la Tierra dependía de lo grande que fuese un objeto y de lo que estuviera hecho.

Según la idea de Aristóteles, los objetos pesados caen más rápidamente que los ligeros. Esto se debe a la obsesión de los griegos con los elementos: Tierra, Aire, Fuego y Agua; la mayoría de los objetos pesados que Aristóteles conocía estaban hechos de materiales que se encuentran en la Tierra, y la fuerte atracción, decía, se debe a que se ven obligados a retornar a ella. Nuestro conocimiento no se apartó realmente de esta idea equivocada durante al menos 2.000 años. Pero, finalmente, el científico italiano Galileo Galilei estableció que Aristóteles estaba equivocado: los objetos pesados no son atraídos más fuertemente por la Tierra. Mientras la resistencia del aire no sea un factor, un objeto pesado y uno ligero caerá a la misma velocidad.

Tan fácil como caerse

Lamentablemente, los relatos románticos acerca de la prueba de ello que Galileo realizó (haciendo caer balas de cañón de la torre inclinada de Pisa) no son ciertos (el mito lo inició Vincenzo Viviani, estudiante de Galileo), pero no obstante se ha comprobado de una manera incluso más espectacular. En 1971, David Scott, astronauta del Apollo 15, rindió tributo a las profundas consecuencias del descubrimiento dejando caer un martillo y una pluma de halcón sobre la superficie de la Luna. «Una de las razones por las que hoy hemos llegado aquí es debido a un caballero llamado Galileo», dijo Scott mientras los dejaba caer. Desde luego, martillo y pluma llegaron al suelo al mismo tiempo.

La valoración de Scott era casi correcta: por asombroso que parezca, realmente hizo falta muy poca cosa más que las intuiciones de Galileo en el siglo XVII para que alcanzáramos la Luna. Las lagunas las llenó un hombre nacido exactamente un año después de la muerte de Galileo: Isaac Newton. Aunque al nacer no era nada impresionante (su madre dijo que «cabía en una jarra de un cuarto de galón»), a Newton le tomó poco más de una docena de años acopiar toda la información necesaria para, cuatro siglos después, poder trazar un rumbo para los astronautas del Apollo. Y, desde luego, aquí es donde aparece la manzana.

A diferencia de los cuentos sobre los experimentos de Galileo en la torre inclinada de Pisa, los relatos de la epifanía gravitatoria de Newton cuando vio caer una manzana son casi con toda seguridad ciertos. Era a finales del verano de 1666 y Newton se hallaba sentado en su jardín de Woolsthorpe Manor, en Lincolnshire. El manzano está todavía allí y sigue dando frutos cada otoño.

Una manzana cae porque posee una propiedad llamada masa, y lo mismo le ocurre a la Tierra. El gran salto adelante que dio Newton fue explicar de forma clara cómo todo lo que tiene masa atrae a todo lo demás que también la tiene. Su ley de la gravitación universal, que elaboró a la tierna edad de 23 años, decía que la fuerza de atracción depende de dichas dos masas, la distancia entre ellas y una constante, denominada G.

En realidad, los físicos suelen estar muy familiarizados con la constante gravitatoria, y la llaman «G grande», para distinguirla de la g (pequeña), la aceleración debida a la atracción gravitatoria de la Tierra. Sin embargo, a pesar de la familiaridad, G es en realidad la constante fundamental menos bien definida de todas.

La magnitud de G, al igual que la de todas las demás constantes fundamentales, se conoce no mediante algún razonamiento teórico, sino mediante medición. El físico inglés Henry Cavendish fue el primero que la midió, en 1798, al analizar la atracción gravitatoria entre dos masas conocidas que se hallaban separadas por una distancia conocida. Su respuesta al valor de G fue de 6,754 x 10-11 metros cúbicos por kilogramo y por segundo al cuadrado. Hoy en día, G es oficialmente 6,67428 x 10-11 m3/kg/s2. La incertidumbre de esta medida es de alrededor de una parte en 10.000. Compárese dicha incertidumbre con la precisión con la que conocemos los otros números fundamentales, como la constante de Planck, que se usa en teoría cuántica: aquella se conoce con la precisión de hasta 2,5 partes en 100 millones.

Hay dos razones por las que G es tan difícil de medir con exactitud. La primera es que es imposible separar los campos gravitatorios utilizando cualquier física conocida. Esto significa que cualquier medición ha de tener en cuenta la influencia de todos y cada uno de los objetos de las inmediaciones. Esto hace que las mediciones sean irrazonablemente sensibles a la influencia externa; hay relatos de investigadores que han tenido que volver a calibrar su aparato después que alguien, dos laboratorios más allá, introdujera en su despacho un gran montón de libros. Por esta razón, las mediciones de gravedad deben realizarse en laboratorios aislados y utilizando instrumentos extraordinariamente sensibles.

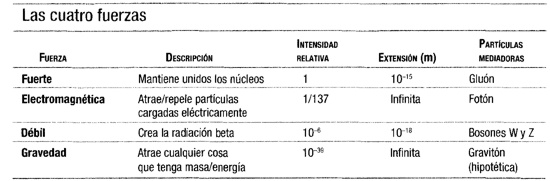

La segunda dificultad a la hora de medir la constante gravitatoria es el hecho de que la gravedad es la más débil de las fuerzas fundamentales. Cuando aquella manzana cae al suelo, lo hace con una aceleración relativamente pequeña, a pesar del hecho de que la masa de todo el planeta está tirando hacia abajo.

Si el lector no está convencido de que la gravedad es débil (quizá haya saltado en paracaídas o haya montado en una montaña rusa y ha experimentado una aceleración terrorífica), piense en los imanes que están felizmente pegados a la puerta de su frigorífico. La masa de todo el planeta también está operando para tirar de ellos hacia el suelo, y sin embargo, un pedacito de hierro imantado del tamaño de un botón puede resistir la atracción del planeta. El magnetismo es el resultado de la interacción electromagnética entre partículas cargadas dentro de un imán. Y dicha fuerza es de alrededor de 1042 veces (es decir, alrededor de un septillón) mayor que la fuerza gravitatoria entre ellas. De modo que la gravedad es débil: G es asombrosamente pequeña. Pero ¿por qué? Aunque la debilidad de la gravedad es uno de los misterios básicos de la física, sí que tenemos algunas ideas que podrían explicarla. La mejor es que la gravedad «se escapa» hacia nuestro universo o fuera de él.

Escapes de otro mundo

Varias ramas de la física moderna sugieren que existen muchas más dimensiones del espacio que las tres (arriba y abajo, a un lado y a otro y adelante y atrás) con las que estamos familiarizados. Una de las consecuencias de ello es que algunas fuerzas pueden «diluirse» al extenderse en estas dimensiones adicionales. Si la fuerza gravitatoria es débil, ello puede deberse a que se extiende más tenuemente que las demás.

Se cree que las dimensiones «adicionales» están compactadas (esencialmente, acumuladas) en cúmulos tan pequeños que en la vida cotidiana no las notamos. Es sólo una teoría del momento, pero unos pocos investigadores intentan encontrar pruebas de ello. Un camino es mediante el examen de la manera en que la atracción gravitatoria entre dos objetos cambia con la distancia entre ellos.

Newton demostró que la gravedad sigue una «ley cuadrática inversa». Esto significa que la fuerza gravitatoria que un objeto ejerce sobre otro disminuye en proporción al cuadrado de la distancia entre ambos. Sepárense dos objetos un metro, y mídase la fuerza gravitatoria. Después, sepárense otros dos metros y mídase de nuevo la atracción. Será nueve veces más débil porque ahora se hallan tres veces más alejados.

Las dimensiones ocultas penetran en nuestro mundo a escalas submilimétricas. Si la gravedad se comporta de manera distinta a lo normal a esas escalas pequeñísimas (si la ley cuadrática inversa no se cumple cuando las masas se hallan separadas por sólo unas pocas milésimas de milímetro), ello puede deberse a que estas dimensiones interfieren con las cosas. Por lo tanto, si aquí se descubre alguna perturbación podremos empezar a disponer de pruebas que respalden nuestras teorías más audaces.

Esta es la razón por la que los físicos están realizando los experimentos más primorosos para escudriñar la gravedad a escalas microscópicas. Sin embargo, hasta ahora no han encontrado pruebas de violaciones de la ley cuadrática inversa. Esto es una lástima, porque uno de los papeles de estas teorías multidimensionales avanzadas es mejorar nuestra mejor teoría de la gravedad, la relatividad de Einstein.

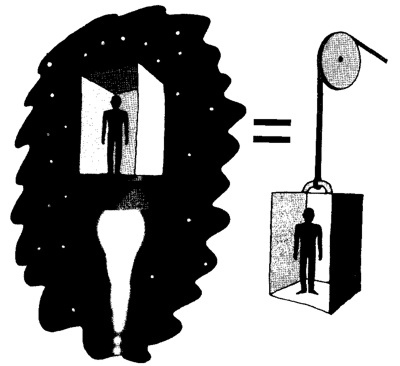

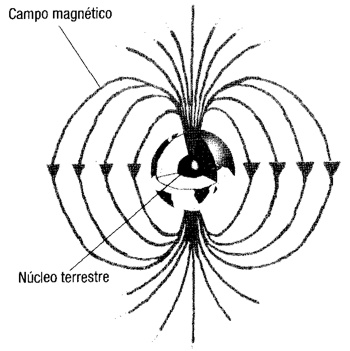

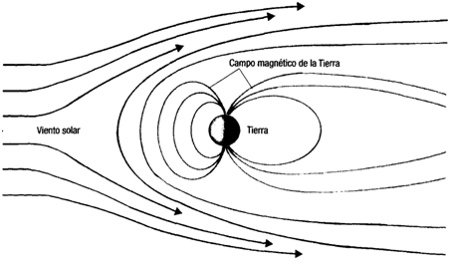

La gravedad es relativa