A la memoria de mis padres.

Capítulo 1

La física en la antigüedad

1. Conocimientos de los pueblos en el antiguo Oriente

2. Los griegos antes de Aristóteles

3. La física de Aristóteles

4. Arquímedes: El museo de Alejandría

5. Mecánica práctica y óptica en Alejandría

1. Conocimientos de los pueblos en el antiguo oriente

La prehistoria; Mesopotámicos y egipcios

Más de dos mil quinientos años antes de nuestra era, los babilonios habían adoptado un sistema de unidades para medir la longitud, el volumen, la masa y la duración. Las unidades patrones de peso y capacidad eran —desde tan remota fecha— impuestas por decretos reales. Gracias a su extraordinario interés por la astrología, los mesopotámicos adquirieron una sorprendente habilidad en la determinación de la duración y de las magnitudes angulares. A ellos debemos la división del día en veinticuatro horas y la del círculo en 360 grados. Sus relojes de agua, las clepsidras, transmitidos por los griegos y romanos al Medievo, eran todavía de empleo corriente en tiempo de Galileo. Según nuestros conocimientos actuales, algunos elementos de la cinemática, indispensables para el estudio de los movimientos celestes, eran familiares a los babilonios: conocían la diferencia entre movimiento uniforme y movimiento discontinuo, concebían la velocidad como relación entre el espacio recorrido y el tiempo, distinguían entre velocidad lineal y velocidad angular.

Mientras que la asidua observación del firmamento, cuyo objeto era obtener pronósticos, permitió adquirir a los astrólogos súmenos y babilónicos rudimentarias nociones de la cinemática, faltaba esta actividad a los sacerdotes del valle del Nilo, menos dados al culto y al estudio de los astros. Pero, en cambio, los egipcios superaron la cultura mesopotámica en cuanto a técnica y arte. Admirables arquitectos, cuyas monumentales construcciones habían de perdurar por milenios, los ingenieros de Egipto se servían ya dos mil años antes de nuestra era de máquinas simples, del plano inclinado, de la palanca, de la cuña y del tornillo. Como atestiguan los relieves sepulcrales y otras representaciones artísticas, el empleo de la balanza con brazos iguales, del soplete y del fuelle les era familiar. Los diques que elevaron, los canales que construyeron, la habilidad con que sabían asegurar el riego de los campos, tan importante en el país, sugieren que no les faltaban conocimientos elementales de hidromecánica. Mas la pretendida ciencia secreta en el dominio de la óptica o aun de la electricidad, que durante algún tiempo fue atribuida a los taciturnos hierofantes de Menfis, Heliópolis y Denderah.es solamente una leyenda de la que ningún documento da fe.

Derivados de las exigencias de la vida cotidiana, los conocimientos logrados por las dos grandes culturas orientales, que el Occidente pudo aprovechar gracias a los mediadores griegos, no habían alcanzado en ninguna rama del saber la jerarquía de ciencia.

Inventores de herramientas prácticas, pacientes observadores y calculadores, y sobre todo recopiladores de conocimientos útiles, ni los babilonios ni los egipcios se esforzaron por hacer una síntesis de sus descubrimientos y no tuvieron la curiosidad de preguntarse si detrás del montón de hechos que con tanto esfuerzo habían reunido no se escondía la idea unificadora de un sistema.

A su incapacidad para penetrar más allá de los datos proporcionados por un grosero empirismo, se agrega otra limitación, más grave todavía: el hermetismo de sus investigaciones científicas, estrictamente ligadas a sus creencias religiosas.

Todo cambia cuando los griegos salen al escenario de la historia. Con ellos surge la osadía de liberar de las ataduras de la mitología el estudio de los fenómenos y la noble pasión de buscar su comprensión desinteresada. Su predilección por las hipótesis amplias y las deducciones lógicas los lleva a reunir los hechos en grandes sistemas. Con ellos comienza la historia de la física.

2. Los griegos antes de Aristóteles

Tales y los jónicos; Los descubrimientos de los pitagóricos; El atomismo de Demócrito

Tales y sus discípulos intentaron reducir la complejidad del mundo físico a la metamorfosis de una sustancia única. Sobre la naturaleza de esta materia primordial el maestro y sus discípulos no estaban de acuerdo. Pero poco importa que dicha materia sea el agua, como en la hipótesis de Tales, o una sustancia ilimitada que escapa a nuestros sentidos, como enseñaba Anaximandro (610-547 antes de J. C.), o el aire, como quería Anaxímenes (floreció hacia 540 antes de J. C.), o el fuego etéreo, según afirmaba Heráclito (576- 480 a. de J. C.), lo esencial es que estos pensadores tuvieron la osadía de abstraer el mundo físico, de sustraer la sustancia al juego de las fuerzas naturales y buscar para los fenómenos una explicación accesible a la razón.

Tal vez parezcan hoy infantiles las especulaciones de los jónicos sobre la materia. Sin embargo, el fuego etéreo de Heráclito de Éfeso no era una llama material, sino una fuerza motriz universal, un concepto afín a la energía de nuestra física. Este profundo pensador concibe al universo bajo su aspecto dinámico, como una eterna serie de cambios, anticipando una idea lo suficiente amplia como para incluir a la vez la teoría cinética de los gases y la evolución darwiniana de las especies vivientes. Hasta donde los escasos fragmentos que subsisten de sus escritos permiten afirmar, Heráclito era un espíritu sorprendentemente moderno: ponía en guardia a los filósofos aconsejándoles no entregarse demasiado a los datos de los sentidos, puesto que éstos son testigos falaces (χαχοι μαρτνροι). Esta opinión fue también la de Parménides de Elea (nacido hacia 540 a. de J. C.), en otros aspectos antagonista del pensamiento de Éfeso.

Aristóteles

Los cambios que creemos observar en la naturaleza, enseñaba Parménides, sólo son impresiones ilusorias de nuestros sentidos. La diversidad y multiplicidad de los fenómenos es irreal, y detrás de ellos se esconde una realidad eterna e inmutable. En tanto que Heráclito procura explicar el mundo físico en base de perpetuos cambios, Parménides trata de reducir el universo a una esencia constante. La dualidad de estas antítesis se resuelve en unidad en la física de nuestros días. El físico busca y encuentra magnitudes constantes en medio de las características variables de los fenómenos.

Aún no se había eclipsado la nombradía de los filósofos jónicos cuando otra escuela, la de Crotona, en Italia, acababa de adquirir gran reputación. Su fundador, Pitágoras de Samos (569-470 antes de J. C.), era jónico. Para escapar del tirano Polícrates, dejó su ciudad natal y se estableció en la Italia meridional, donde rodeado por un núcleo de entusiastas alumnos, hizo de Crotona un centro de la sabiduría griega.

En oposición al positivismo de los jónicos, Pitágoras enseñó la inmaterialidad del alma y la metempsicosis; sus adeptos, entregados incondicionalmente a las palabras del maestro, formaron una especie de cofradía religiosa sujeta a severas reglas. La escuela subsistió durante varios siglos en Italia meridional y en Sicilia, y los alumnos terminaron por convertir a Pitágoras en un iluminado y aun en un semidiós. «Hay tres especies de seres razonables —declaraban—: los hombres, los dioses y aquellos que se asemejan a Pitágoras.»

Los descubrimientos que la tradición atribuye a Pitágoras son en realidad los de su escuela, sin que podamos atribuir el mérito a un hombre particular.

«Los pitagóricos —escribe Aristóteles— consideran el número como el principio, como la sustancia de que se compone la existencia.» En efecto, el sabio de Samos y sus adeptos reconocían que las diferencias cuantitativas de las cosas pueden ser traducidas en diferencias cuantitativas; este descubrimiento es de capital importancia, puesto que está en la base de todas las descripciones que la física matemática puede dar de los fenómenos.

Un hallazgo en el dominio de la acústica contribuyó probablemente a convencer a los pitagóricos de la exactitud de su idea maestra. Con ayuda del monocordio encontraron que cuerdas igualmente tensas dan la nota fundamental, la cuarta, la quinta y la octava, si sus longitudes se relacionan como los números 1, 3/2, 4/3, 2.

Su axioma apriorístico que simples relaciones numéricas rigen el universo, los condujo a sobrestimar enormemente el alcance de su descubrimiento acústico y hacer del firmamento una especie de caja de música, asimilando los intervalos planetarios a los intervalos musicales. Se conoce el extraordinario éxito de la cosmología, cuyo eco puede ser seguido, a través de veintiún siglos, hasta Kepler y aun más acá.

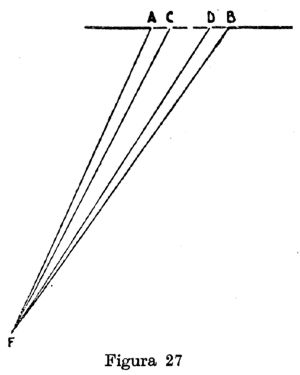

Los pitagóricos reflexionaron también acerca de los problemas ópticos e intentaron dar una teoría de la visión. El ojo envía en línea recta sus rayos visuales, los cuales alcanzan el cuerpo percibido y, a consecuencia del choque que reciben de éste, excitan la sensibilidad del ojo ¿Por qué los objetos pequeños, colocados a cierta distancia, son invisibles? Porque los rayos visuales son divergentes, y cuanto más se alejan del ojo, tanto más espacio dejan entre ellos, responden los pitagóricos.

Los pitagóricos, aunque fuesen los primeros en reconocer la cardinal verdad de que vivimos en un mundo susceptible de expresión matemática, sólo enriquecieron modestamente el acervo de nuestros conocimientos positivos en física. El centro de gravedad de su contribución a la ciencia se asienta en sus descubrimientos geométricos y en el alcance de su doctrina básica, cuya influencia es una fuerza viva y sensible incluso en nuestros días.

No menos profunda y perdurable que la influencia de la tesis pitagórica ha sido la de la escuela atomística, fundada por Leucipo y su discípulo Demócrito. Nada sabemos del maestro, cuya misma existencia ponen en duda algunos historiadores, pero estamos mejor informados sobre su ilustre adepto Demócrito de Abdera (aproximadamente 460-400 a. de J. C.). Igual que Tales, realizaba largos viajes que le pusieron en contacto con los sabios de Egipto, Persia y la India. Como gastó su patrimonio en costosos viajes de estudio, al retornar a su ciudad natal se vio obligado a vivir de la modesta pensión que le acordaron sus compatriotas. Espíritu universal y uno de los pensadores más agudos de la antigüedad, trató en sus escritos, de los cuales sólo nos han llegado algunos fragmentos, los problemas más diversos, desde la física y la cosmología hasta la zoología y la medicina. «Reflexionó sobre cuanto se puede saber» dice Aristóteles hablando del sabio de Abdera.

En oposición a los eleáticos, los protagonistas de la escuela de Abdera afirmaron, según el testimonio del estagirita, la realidad del vacío. Dividir la materia —afirmaban— equivale a eliminar los intersticios vacíos existentes entre sus partículas; si fuera posible poner al descubierto todos esos intersticios, los fragmentos dejarían de ser divisibles. Estas partículas últimas, indivisibles, de la materia, son los átomos. En continuo movimiento, infinitos en número, empujados por un destino ciego, los átomos constituyen —enseña Demócrito— toda la sustancia del universo.

Las propiedades de los cuerpos se explican por la forma geométrica, posición y tamaño de sus invisibles átomos. Las transformaciones de la materia no son otra cosa que cambios de disposición, un reajuste de los átomos, cuyos perpetuos movimientos están en la base de todos los fenómenos del mundo físico y aun psíquico.

Los átomos son duros, homogéneos, incompresibles e indestructibles; no poseen color ni sabor, dado que esas propiedades sólo son accidentales, subjetivas. Los movimientos de los átomos son incausados: existen desde la eternidad; en el hierro o en la piedra, los átomos sólo pueden vibrar, mientras que en el fuego o en el aire recorren grandes distancias. No sabemos si Demócrito atribuyó peso a los átomos, pero los epicúreos, adeptos a la escuela encabezada por Epicuro de Samos (342-270 a. de J. C.), así lo hicieron.

La doctrina de la escuela de Abdera es la cuña filosófica tanto del atomismo como del cinetismo de la materia. Su repercusión fue profunda y su eco en la historia de la química, y de la física ha sido más perdurable que el de cualquier otra doctrina de la antigüedad. Combatidas por Aristóteles y los peripatéticos, defendidas por los epicúreos grecolatinos, entre ellos por el genial poeta Lucrecio, las ideas de Demócrito jamás dejaron de actuar como fermento y nunca fueron completamente olvidadas, ni siquiera en la Edad Media. En los siglos XVII y XVIII el atomismo contó con numerosos adeptos entre los físicos y químicos, y cuando en los albores del siglo XIX Dalton dio base experimental a la doctrina meramente intuitiva de Demócrito, no hizo más que iniciar una nueva fase de una evolución continua, cuyos principios se remontan al gran abderense.

La obra de Demócrito constituye una enciclopedia tan vasta y sistemática como la de Aristóteles. Por desgracia, solamente poseemos algunos fragmentos conservados merced a las críticas de sus adversarios. «Actualmente —dice con razón Partington— son muchas las personas que cambiarían con placer casi todos los diálogos de Platón por una parte de la obra del abderense.»

3. La física de Aristóteles

Vida y personalidad de Aristóteles; Las dos categorías de la materia; Doctrina del lugar natural; Descubrimientos cinemáticos; El problema del vacío; Aristóteles y la óptica.

A los dieciocho años de edad fue admitido en la Academia de Platón, donde permaneció dos decenios como discípulo dilecto del maestro. Después de la muerte de Platón, pasó algunos años en la corte de Hernias, personaje interesante que de esclavo en su juventud terminó su carrera como tirano de la ciudad de Atarne, en Asia Menor.

En el año 342 le confió Filipo de Macedonia la educación de su hijo Alejandro, cuyas conquistas debían cambiar con el tiempo la faz del mundo.

Cuando Alejandro sucedió a su padre en el trono, su preceptor volvió a Atenas.

En este momento tenia Aristóteles casi cincuenta años y la mayor parte de su obra estaba todavía por hacer. En los jardines de Lykaios estableció su célebre escuela, llamada más tarde peripatética, por la costumbre que tenía el maestro de enseñar paseando. Mal visto por muchos atenienses y prácticamente extraño en la ciudad-estado, Aristóteles no gozó en Atenas de la veneración y la tranquilidad que habían rodeado a Platón. A la muerte imprevista de Alejandro Magno, Aristóteles, amenazado por la venganza de sus adversarios políticos, hubo de abandonar Atenas y refugiarse en Calcis, donde murió a la edad de sesenta y tres años.

Como hombre de ciencia, Aristóteles es en primer término, un naturalista: el primer gran biólogo de la historia. «Linneo y Cuvier —decía Darwin— los dos ídolos de mi juventud, sólo son, en realidad, escolares si los comparamos con el viejo Aristóteles.» ¡Sin embargo, su método de investigación y sus concepciones, que le permitieron lograr en la embriología notables descubrimientos y crear una clasificación de los seres vivientes que no fue sobrepasada hasta el siglo XVIII, le guió con mucho menos seguridad en sus investigaciones sobre problemas de la mecánica y de la física, las observaciones meramente cualitativas le bastaron para darle una base empírica en zoología, pero no pudieron prestarle los mismos servicios en física; por otra parte, sus convicciones vitalistas y finalistas, que a menudo trasladaba de la naturaleza orgánica a la inorgánica, lo llevaron forzosamente a inferir conclusiones erróneas.

A pesar de que hacía abundante uso del método inductivo —contra lo que a veces pretenden algunos autores de manuales—, Aristóteles, padre de la lógica formal, tenía inclinación a sobrestimar el alcance de las deducciones lógicas, a partir de premisas preconcebidas y a olvidar un poco que la lógica, privada del apoyo de la experiencia, queda reducida a una dialéctica de la prueba, sin poder conducir a verdaderos hallazgos. No obstante estas deficiencias, la mecánica de Aristóteles no es por completo estéril y contiene algunos conocimientos nuevos y positivos.

Los objetos del universo, según Aristóteles, se dividen en dos categorías: En el cielo, en la naturaleza supralunar, los cuerpos son indestructibles, eternos, inmutables; si cambian, pasan por fases que se repiten indefinidamente con perfecta regularidad; a estos cuerpos invariables les concede Aristóteles un movimiento cuyos elementos serían invariables: el movimiento uniforme y circular.

En la Tierra y en sus vecindades coloca Aristóteles la materia propiamente dicha, sujeta a verdaderos cambios. Profundizando una idea de los eleáticos, el estagirita admite que cada cuerpo tiene su lugar natural: los cuerpos livianos, fuego y aire, tienden por su naturaleza inmanente a ir hacia arriba; los cuerpos pesados, agua, piedras, metales, hacia abajo. La ascensión de los cuerpos livianos y el descenso de los graves son movimientos naturales, en oposición a los movimientos forzados (el de una piedra arrojada) que se efectúan contrariando la tendencia de buscar el lugar predeterminado.

Por diferentes que sean el movimiento natural y el forzado, ambos necesitan un agente motor, que siempre debe estar, sin intermediario, con lo movido. Sin el contacto con su motor, ningún cuerpo podría moverse. En el caso del movimiento natural, el motor es eterno (está en el cuerpo); en el movimiento forzado, el motor es perecedero, casual. Aristóteles aplica esta hipótesis al análisis del tiro oblicuo, compuesto por tres clases de movimientos: forzado, mixto y natural.

La parte ascendente de la trayectoria es una curva, la parte mixta recta, la parte descendente nuevamente una curva. Si el tiro es vertical, la parte mixta se reduce a cero. ¿Cómo conciliar el fenómeno del tiro con el postulado según el cual el motor debe estar en contacto con el móvil? Desde el momento en que cesa el contacto del proyectil con el instrumento que lo lanzó, el aire se cierra detrás del proyectil y los transporta, explica el estagirita. Igualmente, es el aire el que actúa, según Aristóteles, en la caída libre, como factor de aceleración.

Por cierto, las leyes fundamentales de la cinemática aristotélica — mezcla de ideas metafísicas y de toscas observaciones— no resistieron la crítica de los innovadores renacentistas, y ninguna pasó a la mecánica de Galileo.

Empero, los errores básicos de su mecánica no impidieron al estagirita realizar algunos descubrimientos verdaderos. En el análisis del tiro vertical, reconoce la uniformidad de la aceleración, negativa cuando el cuerpo asciende, positiva cuando cae.

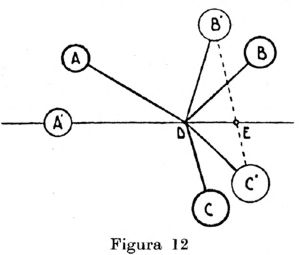

El estudio de la palanca le permite observar que de dos fuerzas iguales que elevan por medio de ese instrumento una carga, la mayor exige un desplazamiento menor; de este modo entrevé el principio de las velocidades virtuales. Estudiando el problema de la sensibilidad de balanzas con brazo largo y brazo corto, llega al principio del paralelogramo de movimientos, que enuncia de la siguiente manera:

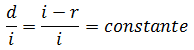

«Un cuerpo que se mueve según una determinada razón, lo hace a lo largo de una recta representada por la diagonal del paralelogramo formado por dos rectas que están en dicha razón.»Aristóteles hace uso, aunque solamente en un caso especial, del momento estático. Del mismo modo, es él quien enuncia que «haciendo actuar una misma fuerza, la velocidad del cuerpo liviano es a la del cuerpo pesado, como el pesado es al liviano», teorema que contiene el núcleo del futuro principio cartesiano de la constancia del producto de la masa y de la velocidad.

Una cuestión que se plantea Aristóteles, sin poder resolverla, revela que barajaba pensamientos sobre la energía cinética, sin llegar, por supuesto, a ese primordial concepto. ¿Cómo ocurre, se pregunta Aristóteles, que un hacha en reposo no puede hendir la madera, mientras la misma hacha lo hace si se le imprime una velocidad, aunque sea moderada?

En oposición a la escuela de Demócrito, Aristóteles enseña la estructura continua de la materia y no admite la realidad del vacío. La velocidad de los móviles, razona Aristóteles, es inversamente proporcional a la resistencia del medio en que se mueven. El vacío, donde la resistencia es nula, permitiría, pues, movimientos con velocidad infinita; conclusión absurda que lleva al lógico a rechazar como premisa la existencia del vacío.

La doctrina de la irrealidad del vacío, apoyada por los escolásticos de la Edad Media, continuó hasta mediados del siglo XVII, es decir, hasta Torricelli y Guericke, y llegó a perturbar a Galileo. Adversario del atomismo, Aristóteles adoptó la teoría de los cuatro elementos formulada por Empédocles (siglo V a. de J. C.).

Aire, fuego, tierra y agua —los elementos empedoclianos— no son, sin embargo, los últimos constituyentes, sino más bien cualidades que confieren, en la naturaleza sublunar, a la materia primaria, que es la única realidad física, apariencia sensible. Además, Aristóteles agrega al cuarto elemento de Empédocles un quinto elemento: el éter, constituyente primordial de la sustancia eterna e inmutable de la naturaleza celeste. La teoría aristotélica de los elementos —ligeramente modificada por los alquimistas medievales— fue indiscutida en lo sustancial hasta Boyle, en el siglo XVII, y no desapareció antes de la «revolución química» de Lavoisier, en el siglo XVIII.

Aristóteles sabía que el aire es pesado y vio su opinión corroborada por la experiencia con un odre inflado; sin embargo, no podía explicar por qué el odre, inflado y más pesado, flota sobre el agua, mientras que el odre desinflado y, por consiguiente, más liviano, se hunde.

Como los pitagóricos, se interesó vivamente por los problemas de la acústica, y es el primero en reconocer que los instrumentos musicales (cuerdas, silbatos) producen sonidos poniendo el aire en movimiento. Conocía el fenómeno de la reflexión de los sonidos. Su tentativa para explicar la altura de los sonidos no fue, sin embargo, feliz: creía que los agudos se propagan más rápidamente que los graves.

Las opiniones de Aristóteles sobre la naturaleza de la luz y el fenómeno de la visión originaron fantásticas interpretaciones. Dos historiadores alemanes intentaron convertir al estagirita en padre de la teoría ondulatoria, otorgándole el mérito de haber asimilado la luz a ondulaciones del éter. En realidad, Aristóteles, al rechazar la teoría pitagórica de la visión, admite que la intervención del medio entre el ojo y el objeto percibido es esencial en el fenómeno de la visión. En tanto que ese medio que Aristóteles llama διαφανής (transparente) está en estado potencial —en estado de reposo—, hay oscuridad y el objeto no puede ser percibido. Excitado por el fuego o por el éter, el διαφανής pasa al estado activo —al estado de movimiento— y el objeto se vuelve visible.

Ningún pensador de la antigüedad tuvo influencia tan decisiva como Aristóteles sobre la evolución del pensamiento científico. Endiosado por las centurias que siguieron al eclipse del genio griego, y adoptado en el siglo XIII por la Iglesia católica como «el filósofo» por antonomasia, su prestigio terminó por convertirse en autoridad inflexible, que no fue eliminada hasta la revolución renacentista.

A pesar de algunos descubrimientos que hemos indicado, la física es la parte más débil de la inmensa obra de Aristóteles, y su enseñanza, erigida en dogma por el Medievo, pesó hasta la época galileana como un lastre sobre el progreso de la física. Mas si los acólitos de Aristóteles se sirvieron de éste como de un arma contra la libertad de investigación, sería injusto endosar la responsabilidad de olio al gran pensador de Estagira.

4. Arquímedes

El museo de Alejandría; Vida y personalidad de Arquímedes; La ley de la palanca; La hidrostática de Arquímedes; La influencia de Arquímedes.

Bajo la sabia dominación de los Tolomeos, Alejandría, con su célebre museo y su rica biblioteca, se convierte en el cerebro del mundo.

Acogidos en el museo y mantenidos con fondos del Estado, los sabios podían entregarse, libres de toda preocupación material, a la investigación, desinteresada. Fue en el museo de Alejandría, en los comienzos del período alejandrino (siglo III a. de J. C.), donde enseñaron Euclides, el primer sistematizador de la geometría, Aristarco, el genial precursor de Copérnico, y Eratóstenes, matemático y eminente geógrafo.

En Alejandría realizaron sus obras los grandes ingenieros Ctesibio, Filón y Herón. Es también allí donde encontramos en la última etapa de la historia de la gloriosa escuela en el siglo II antes de Jesucristo a Claudio Tolomeo, justamente célebre como astrónomo, físico y geógrafo. Todas estas personalidades son hombres de ciencia, en el sentido moderno de la palabra, en oposición a los que les precedieron, que eran más bien filósofos. Sobre el suelo alejandrino la ciencia se separa de la filosofía para convertirse en un conjunto de disciplinas particulares. La física, y sobre todo la mecánica, dejan de ser dominio de especulación metafísica. Comienza la época de los especialistas.

La figura más eminente del período alejandrino es Arquímedes de Siracusa (287-212 a. de J. C.), el mayor matemático y mecanista de la antigüedad. Vástago de una familia noble, probablemente emparentado con el rey Herón de Siracusa, Arquímedes pasó la mayor parte de su vida en su ciudad natal, lo cual no le impidió mantener estrechas relaciones con la escuela de Alejandría. Algunos de sus más importantes escritos, redactados en forma de cartas, están dirigidos a sus amigos alejandrinos, al geógrafo Eratóstenes, al geómetra Conón y al astrónomo Dositeo.

¡Qué diferencia entre los pesados tratados de Aristóteles y las memorias maravillosamente lúcidas de Arquímedes, sorprendentemente modernas, tanto por su método como por su fondo! En efecto, el siracusano se nos aparece hoy lejos del estagirita y más cerca de los grandes hombres del Renacimiento, como Leonardo y Galileo.

Muchas anécdotas que nos han legado Plutarco, Tito Livio y algunos otros historiadores, anécdotas bien conocidas, ponen de relieve su extraordinaria personalidad. Pensador distraído, absorto por completo en sus problemas [1], investigador entregado apasionadamente a los estudios teóricos, ingeniero desdeñoso de sus admirables invenciones, tal es el cuadro que los escasos datos que nos han llegado permiten formarnos del más grande teórico y técnico de la antigüedad. Pero si estamos poco informados de su vida, conocemos mejor, gracias a Plutarco, las circunstancias de su muerte.

Cuando las tropas del general romano Marcelo atacaron a la ciudad de Siracusa, asediándola por mar y tierra, las máquinas de guerra ideadas por Arquímedes desempeñaron la parte principal en la defensa de la plaza. Después de tomada la fortaleza, el sabio, absorto en sus problemas geométricos, fue muerto por un soldado Se sabe que pidió al soldado que se disponía a herirlo que no borrara los círculos que había trazado en la arena. Así murió: geómetra hasta el último momento. Sus compatriotas, según parece, no tardaron en olvidarlo; a Cicerón, siglo y medio después, siendo cuestor en Sicilia, lo fue muy difícil encontrar la tumba del sabio siracusano, oculta bajo las malezas. El orador romano la había encontrado coronada, conforme a los deseos de Arquímedes, por un cilindro circunscrito a una esfera, a fin de esquematizar a los ojos de los profanos el descubrimiento arquimédico de las relaciones respectivas (3:2) entre los volúmenes y superficies de ambos sólidos.

Uno de los más lúcidos genios matemáticos de todos los tiempos, Arquímedes se adelantó en dos mil años a su época con sus trabajos geométricos, que tratan acerca de superficies de figuras limitadas por contornos curvilíneos y volúmenes de sólidos forma dos por superficies curvas; empleó integraciones y pasos a límite, anticipando principios esenciales del cálculo infinitesimal, cuya invención hizo en el siglo XVII la gloria de Newton y Leibniz.

Como en sus descubrimientos matemáticos, cuya apreciación no entra en el cuadro de nuestro tema, también en la mecánica es precursor de tiempos nuevos; es el primer investigador que combina, con rigor metódico, deducciones matemáticas con resultados experimentales. Esta fértil unión lo llevó a encontrar leyes fundamentales de la estática, de la cual es el verdadero fundador.

En su monografía Sobre el equilibrio de los planos, Arquímedes formula principios de la estática en términos matemáticos y enuncia el principio de la palanca. Sin duda, ya era conocido por Aristóteles, y antes de él por Platón, que la fuerza que actúa a mayor distancia del fulcro mueve el sistema más fácilmente. Sin embargo, media un abismo entre esta regla tosca y la exposición formal, susceptible de análisis riguroso, dada por Arquímedes a la ley de la palanca.

El siracusano infiere esta importante ley del principio del centro de gravedad, base axiomática de su estática de los postulados empleados en su estática surgen inmediatamente las proposiciones de que dos pesos iguales colocados a igual distancia del centro de rotación (punto de apoyo de la palanca) están en equilibrio, mientras los mismos pesos colocados a distancia desiguales no se equilibran, y el peso que está a mayor distancia desciende. De estas proposiciones deduce Arquímedes que el centro de gravedad de un sistema formado por dos pesos desiguales se encuentra sobre la línea que reúne los centros de gravedad de ambos y que esos pesos desiguales están en equilibrio cuando sus distancias del punto de rotación son inversamente proporcionales a los pesos. Esta última afirmación es precisamente el principio de la palanca en todo rigor.

Agreguemos que algunos historiadores, entre ellos Ernesto Mach, no han encontrado impecable el pasaje de la proposición inicial a la proposición final y reprocharon a Arquímedes haber utilizado implícitamente el hecho conocido de que el efecto de un peso (P) a la distancia (L) del eje está medido por el producto, hecho no contenido en su postulado. Es probable que Edmundo Hoppe tenga razón cuando sugiere que la deducción de este teorema estaba incluida en la obra perdida de Arquímedes, Sobre la balanza, que contenía la definición del centro de gravedad, definición que se buscaría en vano en las obras actualmente existentes del gran siracusano.

La ley de la palanca es enunciada en la forma de un teorema geométrico, pero no cabe duda de que Arquímedes, constructor de máquinas, verificó su certeza por medio de la experiencia. El entusiasmo que lo conmovió al descubrir que una pequeña fuerza aplicada a un brazo de palanca muy largo puede equilibrar una gran fuerza que actúa sobre un brazo muy corto, se refleja en su célebre frase: «Dadme un punto de apoyo y levantaré el globo terráqueo» [2].

Íntimamente ligado a sus estudios sobre los principios de la estática es su proceder mecánico expuesto en su tratado Sobre el método, para encontrar áreas y respectivamente volúmenes de configuraciones curvas. El método consiste en descomponer, por ejemplo, en una infinidad de planos, dos sólidos cuyo volumen se desea comparar y en determinar las relaciones de equilibrio de esos planos; considerando cada uno de los cuerpos como la suma de estos planos, la relación de sus equilibrios permite obtener la relación de sus volúmenes.

Mientras que en estática Arquímedes tiene precursores, no cuenta con ninguno en hidrostática. Su tratado Sobre los cuerpos flotantes bastaría por sí sólo para hacer del autor el más eminente de los físicos de la antigüedad. Parte de un postulado que define al líquido y muestra en seguida que cada líquido en reposo debe tener una superficie esférica cuyo centro coincide con el centro de la Tierra. Las proposiciones que siguen establecen las condiciones de equilibrio de cuerpos sumergidos en un líquido, examinando el caso de un sólido del mismo peso —a igual volumen— del líquido, y luego el caso de cuerpos más livianos y respectivamente más pesados — a igual volumen— que el líquido.

Estas proposiciones contienen el enunciado del célebre principio de Arquímedes que exige la igualdad de la pérdida de peso con el peso del líquido desalojado. El establecimiento de este principio básico de la hidromecánica equivale en realidad a la aplicación, a los cuerpos flotantes, de la futura segunda ley newtoniana del movimiento y resuelve por completo la cuestión de hasta qué nivel un barco se sumerge en el agua.

La tradición atribuye a un problema práctico el origen de la investigación que condujo a Arquímedes a formular su fundamental ley hidromecánica. El rey Hierón se creyó defraudado por un artesano al cual había remitido, para que fabricara una corona, un peso determinado de oro, y sospechaba que había reemplazado parte del precioso metal por plata. La cuestión fue planteada a la sagacidad del gran geómetra. Preocupado por tal problema, Arquímedes se encontraba en el baño cuando se dio cuenta de que su cuerpo, sumergido, desalojaba cierta cantidad de agua y perdía cierto peso, lo cual le dio la clave del problema. Todo el mundo conoce la anécdota transmitida por Plutarco y el arquitecto romano Vitruvio a la posteridad: Transportado de alegría, Arquímedes corrió desnudo por la calle gritando: ¡ Ευρηχα, Ευρηχα!, es decir: ¡Lo encontré! ¡Lo encontré!

Las aplicaciones prácticas de sus descubrimientos no eran ajenas al espíritu del gran teórico. Varias de sus invenciones, la polea compuesta, el tornillo hidráulico, espejos ustorios [3], máquinas de guerra— prueban que fue un ingeniero de méritos extraordinarios. Empero, esto genio, tal vez el mayor de la antigüedad incluso en mecánica práctica, no nos dejó ningún escrito acerca de sus inventos técnicos, considerados por él como indignos de un geómetra [4].

La posteridad no reservó a la obra de Arquímedes el mismo destino que a la de Aristóteles. Éste comenzó a imponerse a los espíritus a principio de nuestra era, para dominar después en las largas centurias del Medievo.

Al contrario, la repercusión de los escritos de Arquímedes, si bien poderosa hasta la decadencia de la escuela de Alejandría, desapareció después de la extinción del genio griego, y su influencia fue mínima, a pesar de la veneración que por él tuvieron los árabes y algunos cristianos de la Edad Media. Solamente con el Renacimiento surgen genios afines a Arquímedes, como Stevin y Galileo, capaces de prolongar la trayectoria que él había trazado. La luz de las ideas del siracusano comienza a brillar, cuando se eclipsa el relumbrón del estagirita.

5. Mecánica práctica y óptica en Alejandría

Clepsidra de Ctesibio; Termoscopio de Filón; Herón: su Mecánica y su Neumática; La ley de la reflexión de la luz; Tolomeo y sus investigaciones ópticas.

Enamorados de teorías y desdeñosos de las ciencias prácticas, los griegos sufrieron en Egipto la influencia de esa inclinación hacia la técnica, y en ninguna parte la alianza entre la investigación desinteresada y el saber aplicado fue más fecunda que en el Egipto helenizado.

En Alejandría, la importancia acordada a los estudios mecánicos, a las aplicaciones de toda categoría, no dejó de aumentar desde el siglo de Arquímedes y hacia el crepúsculo de la época alejandrina (los dos primeros siglos de nuestra era) se volvió preponderante.

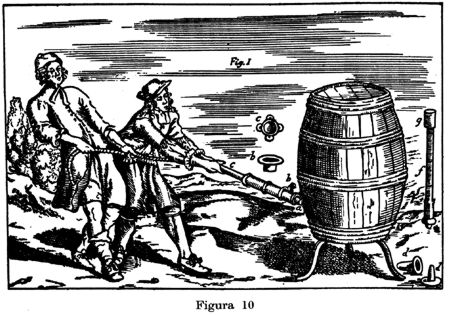

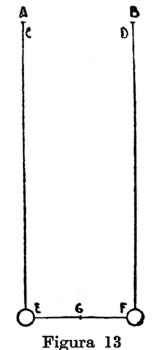

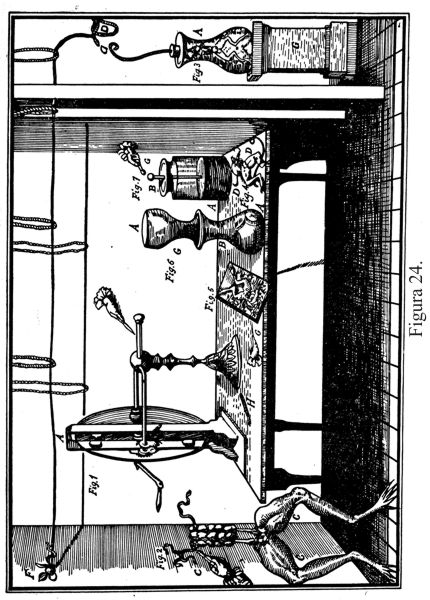

Ctesibio, contemporáneo de Arquímedes, inicia la serie de grandes representantes con que contó la floreciente escuela de ingenieros en Alejandría. Construyó un órgano hidráulico, bombas contra incendio, varios autómatas y perfeccionó el reloj de agua: en m clepsidra el agua salía de un recipiente para caer en otro, y a medida que en éste aumentaba el nivel, subía un flotador que movía el índice de las horas. Filón, probablemente discípulo de Ctesibio, inventó el termoscopio, el primer termómetro que registra la historia. Una gran esfera de metal estaba unida por un tubo con un vaso de vidrio, lleno de agua. Expuesto a los rayos del Sol, el aire se dilataba en la esfera, pasaba al vaso y producía burbujas en el agua. Los termómetros abiertos al aire, construidos por Galileo y otros italianos a comienzos del siglo XVII, tienen su origen en el termoscopio de Filón. Las obras de este sabio, de la principal de las cuales sólo nos han llegado fragmentos, son citadas a menudo por Herón.

El más eminente de los ingenieros de Alejandría, Herón, jefe de una famosa escuela técnica, fue un escritor casi enciclopédico sobre temas mecánicos, físicos y matemáticos. Quizá haya florecido en torno de 100 antes de nuestra era; debemos, sin embargo, agregar que los historiadores no están de acuerdo sobre la época en que floreció. Su legendaria nombradía y el excepcional éxito de sus obras tuvieron la consecuencia de que la posteridad le atribuyera un gran número de trabajos apócrifos. Mas no cabe duda de que es autor de tres libros de Mecánica, de dos de Neumática y de uno de Catóptrica, obras que justifican plenamente su gran renombre como investigador e inventor.

La Mecánica de Herón es un libro de texto escrito para ingenieros más interesados por los problemas prácticos de su profesión que por las investigaciones teóricas. El autor describe máquinas simples y máquinas compuestas. En sus dispositivos emplea combinaciones de ruedas dentadas, engranajes a cremallera, la transmisión de fuerza mediante un tomillo a un eje perpendicular al suyo, y hace el uso más amplio y variado de la palanca. Resolvió el problema planteado por Arquímedes de levantar mil talentos con la ayuda de cinco talentos y dio respuesta a la pregunta de Aristóteles de cómo repartir las cargas sobre varios puntos de apoyo.

Sabía que sus máquinas no realizaban un ahorro de trabajo y reconoció con claridad la validez del principio que se llamaría posteriormente « de los desplazamientos virtuales». Cuanto más débil —afirma Herón— es la fuerza motriz en proporción al peso que debe moverse, tanto más largo es el tiempo empleado, de manera que tiempo y fuerza están en relación inversa.

Todavía más interesante que la Mecánica, resulta, gracias a sus excursiones teóricas, la Neumática de Herón, donde el ingenioso alejandrino sigue a veces las huellas de Estratón de Lampsaco. Herón es el primer investigador que tuvo noción de la elasticidad y de la presión del aire, fenómenos que no fueron claramente explicados hasta el siglo XVII.

El aire comprimido por una presión exterior se dilata si la presión deja de actuar. El calentamiento produce también dilatación del aire. Herón aplica esta propiedad en su máquina a aire caliente, destinada a elevar agua. Niega, como Aristóteles, la existencia del vacío continuo, pero concede que éste existe entre las moléculas de las sustancias sólidas, líquidas o aeriformes. Por otra parte, Herón enseña que se puede realizar artificialmente el vacío, y lo prueba prácticamente con sus aparatos de succión y su botella con derrame constante de agua. Otros aparatos de Herón utilizan el vapor como fuente de fuerza motriz: en su «eolípila», la reacción provocada por los chorros de vapor que salen de una esfera producen la rotación de la misma. La primitiva turbina del alejandrino es la primera aplicación que conocemos del vapor para obtener movimiento. Su genial iniciativa no tuvo, sin embargo, consecuencias prácticas.

«Un mundo de esclavos —dice con razón Sherwood— no requería el poder del vapor, y durante dieciséis siglos la idea del alejandrino permaneció en el olvido.»Herón utiliza, también la presión hidrostática, y es el primero en emplear mercurio en lugar de agua para transmitir la presión.

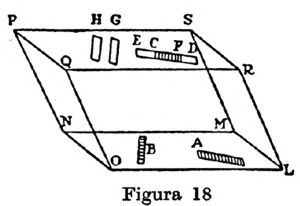

Muchos de los mecanismos descritos por Herón, comprendida la turbina de vapor, no son más que juguetes. Como la mano de obra, la de los esclavos, no costaba casi nada, la rudimentaria industria de la época no requería verdaderas máquinas. Numerosos aparatos de Herón, como los que describe en su obra Sobre los autómatas, sirvieron de distracción o permitieron a los sacerdotes producir aparentes milagros. Una invención eminentemente útil es, por el contrario, su odómetro: un sistema de engranajes que permite leer sobre un cuadrante el número de vueltas que da la rueda de un carro y medir la longitud del camino recorrido. Su dioptra, el teodolito de la antigüedad, da una admirable muestra del arte mecánico de Herón: instrumento universal de medida, que puede prestar servicios a los geodestas y a los astrónomos, permitía, gracias a tornillos micrométricos, una precisión de enfoque y de lectura que no fue sobrepasada hasta mediados del siglo XVI [5].

Sin duda, Herón debió muchas felices ideas a sus precursores, especialmente a Arquímedes, Ctesibio y Filón, pero además de ser un compilador, enriqueció y completó los hallazgos de sus maestros. Esto es lo que hizo también en el dominio de la óptica. La propagación rectilínea de los rayos luminosos, la igualdad de los ángulos de incidencia y de reflexión, pertenecían desde mucho tiempo al acervo de los conocimientos y se encuentran consignados en los escritos sobre óptica atribuidos a Euclides. Herón estudió espejos planos, convexos, cóncavos, y logró refundir sus dos leyes en una sola.

El rayo —escribe en su Catóptrica— sigue siempre el camino más corto. Sea o no reflejado, el rayo siempre satisface esta condición.El fenómeno del rayo refractado, cuyo conocimiento, según algunos autores, está documentado desde el siglo V antes de nuestra era, no dejó de atraer la atención de los investigadores. Colocad un anillo en un vaso de modo que lo oculto el borde del vaso; llenando éste con un líquido, el anillo aparece gracias a la reflexión de la luz. Esta experiencia, ideada probablemente por Arquímedes, está relatada como cosa familiar a todos por Cleomedes (floreció hacia el año 50 a. de J. C.).

Sin embargo, un progreso real en el conocimiento del fenómeno no fue realizado antes de Claudio Tolomeo (floreció hacia el año 130 d. de J. C.). Sistematizador de la astronomía, eminente geógrafo, este último gran alejandrino, se destacó también en la física. Fue el primero en realizar en el libro quinto de su Óptica — un estudio detenido sobre la refracción de la luz. Su aparato de medida consistía en un disco graduado provisto de dos reglas que giraban en torno del centro del disco. Colocaba las dos reglas, de las cuales una estaba sumergida en agua, de modo que parecían formar una línea recta; al sacar el disco que lleva los reglas, de adentro del líquido, podía leer sobre la graduación el ángulo de refracción correspondiente a un ángulo dado de incidencia, los valores que así obtuvo, para el agua y para el vidrio, son de notable exactitud. Si bien no logró descubrir la ley de la refracción, que incluso Kepler buscaría en vano, reconoció en cambio que el rayo, al pasar a un medio más denso, se acerca a la vertical que en el punto de incidencia cae sobre la superficie refringente. Tampoco escapó a su atención que para el paso del rayo al medio menos denso debía existir un ángulo límite. Por otra parte, conocía el fenómeno de la refracción atmosférica y advirtió que el valor de ésta, cero en el cénit, crece con la distancia cenital de los astros.

La obra de Herón y Tolomeo señala la última fase de la física griega, ésta no encuentra ya ningún representante digno de los grandes investigadores que le dieron lustre en épocas pasadas. Sin duda, la escuela de Alejandría, aunque no podría evitar finalmente la decadencia, perduró largo tiempo después de la desaparición de Tolomeo, mas sus fuerzas creadoras se agotaron gradualmente y terminó por nutrirse de las fuentes del pasado.

Loa dos primeros siglos de nuestra era asisten a la espléndida ascensión de Roma y ven a las águilas imperiales señorearse del Mundo.

En oposición a los griegos, los romanos, eminentes legisladores, elocuentes oradores, no poseían la noble pasión de las búsquedas desinteresadas, ignoraban el encanto de las construcciones abstractas del espíritu.

Se contentaron con bordear por medio de especulaciones poéticas o filosóficas algunos problemas de la ciencia griega, como Lucrecio Caro (95-55 a. de J. C.), portavoz de las ideas democríteas, como Plinio el Viejo (23-79 d. de J. C.), hábil recopilador y vulgarizador de hallazgos griegos.

Sus ingenieros siguieron las huellas de los mecanicistas alejandrinos sin aumentar el patrimonio científico que la Hélade les había dejado como herencia. La historia de los romanos transcurre sin dejar huellas en la historia de la física.

Capítulo 2

La física en la Edad Media

1. Los árabes y la transmisión de la ciencia griega al Occidente

2. La ciencia occidental

1. Los árabes y la transmisión de la ciencia griega al occidente

Al-Hazen y Al-Khazirii

Desinunt ista, non pereunt ; las palabras de Séneca tienen aquí su verdadero lugar: la sabiduría antigua dejó de existir, sin haber desaparecido. Su recuerdo no se había extinguido entre los pueblos orientales de habla griega que formaban el imperio bizantino. En efecto: la cultura bizantina no merecería tal nombre si no hubiera conservado preciosos manuscritos de la edad de oro de la sabiduría griega, si no hubiera mantenido vivo el conocimiento de la lengua clásica y si no hubiera servido como lazo de unión entre la ciencia griega y la de loe árabes, cuyo papel había de ser salvar del olvido el tesoro de los conocimientos helénicos y transmitirlos a Europa.

La intervención de las árabes en los destinos de las ciencias es uno de los milagros de la historia. En el siglo VII sus tribus semi-nómadas —pastores o agricultores—, animadas por un espíritu belicoso, no tenían ningún contacto con la cultura griega y no representaron ningún papel digno de mención en la historia.

Más todo cambia de pronto con la aparición de Mahoma. Las tribus árabes estaban entregadas, más o menos, a la anarquía moral y social, cuando surgió ese visionario, que supo encender el fuego de una nueva fe (hégira 622), forjando un estado teocrático, llamado a lanzar sobre el mundo un brillante resplandor, momentáneo pero de extraordinaria potencia.

Con sorprendente rapidez el primitivo núcleo árabe de fieles asimiló diferentes razas semíticas y no semíticas, reunidas desde entonces, en la gran confraternidad del Islam. Los sucesores del Profeta conquistaron Siria, Persia y Egipto, extendieron la guerra santa a España y franquearon los Pirineos, amenazando el corazón del Occidente, cuando Carlos Martel, en la sangrienta batalla de Poitiers logra contener, justamente cien años después de la muerte del Profeta (732), su marcha triunfal.

«La tinta del sabio es tan preciosa como la sangre del mártir», declaró el Profeta y enseña el Corán. El culto que esos conquistadores rendían a la espada no era exclusivo, pues estimaban también la pluma, y sus ansias de dominación se completaban con mi sed de saber. Desde el siglo XIII los árabes hicieron un admirable esfuerzo para asimilar la ciencia griega y más aún para enriquecer ese patrimonio. Los príncipes abasíes, inspirándose en el ejemplo de los tolomeidos, aceleraron, por la eficaz protección acordada a los sabios, el importante proceso de traducción y asimilación del saber griego.

Ellos aprovecharon los servidos de los cristianos nestorianos, que expulsados hacía mucho de Bizancio y establecidos en Mesopotamia se convirtieron, gracias a su conocimiento del griego y de las lenguas semíticas a la vez, en los principales mediadores entre la vieja cultura helénica y los jóvenes pueblos del Islam. El séptimo califa abasí, Al-Mamún, que reinó entre los años 813 y 833, reunió en su capital, Bagdad, «ciudad de las maravillas», una rica colección de obras griegas y fundó una floreciente escuela de traductores. De una protección no menos generosa que la de Bagdad gozaron los sabios e investigadores en la corte de Córdoba, admirable centro de cultura intelectual de los califas occidentales Abderramán III (912-961) y Al-Hakim II (912-926). Tres siglos después de la muerte del Profeta, la lengua árabe había llegado a ser la de las ciencias, y la ciudad de Córdoba, el «Bagdad occidental», asiento de ochenta escuelas y una biblioteca que con sus centenares de miles de manuscritos era comparable a la de Alejandría.

Si los árabes sólo hubieran llenado el hiato de siglos que separa el crepúsculo del saber antiguo y la aurora del nuevo, su mérito ya sería notable. Sin embargo, no se contentaron con ser meros agentes de transmisión de la ciencia griega, sino que añadieron a este bagaje la contribución debida a sus propios esfuerzos. Por cierto, en sus filas no surgió un genio creador como Arquímedes o Hiparco, ni siquiera un sistematizador como Euclides y Tolomeo, pero su éxito en el álgebra, en las observaciones astronómicas son innegables y sus descubrimientos en la química son copiosos. Aunque la mecánica los atrajera menos, lograron, gracias a los trabajos de Al-Biruni (floreció hacia el año 1000) y de Al-Kliazini (principios del siglo XII), ampliar los resultados de Arquímedes sobre los pesos específicos. En la persona de Al-Hazen dieron un gran físico al mundo.

La figura más descollante de la ciencia árabe es Al-Hazan ibn al-Haitam de Basora, el Al-Hazen (965-1038) de los latinos. Sobre su vida casi nada sabemos. Nació en Irak, entró al servicio del califa fatimí Al-Hakim y murió en El Cairo. Fue, sin duda, un hábil ingeniero y un astrónomo de renombre, cuya obra sobre los planetas encontró amplia difusión. Mas su título de inmortalidad, lo constituyen los estudios sobre problemas ópticos reunidos en su obra Kitab al-manazir, que muestra su independencia de espíritu y de habilidad experimental superior a la de sus maestros griegos. Al- Hazen rechaza la opinión de Euclides, de Tolomeo y de otros eruditos de la antigüedad, los cuales admitían que el ojo envía rayos visuales al objeto visto; éste y no el ojo, enseña Al-Hazen, es el foco luminoso. Cada punto del objeto iluminado envía a todas direcciones rayos rectilíneos que forman un cono cuyo vértice es el punto aclarado y la pupila es la base. Estos rayos producen en el ojo la imagen. ¿En qué parte del ojo? En el cristalino (la lente del ojo), afirma el físico árabe, desconociendo el papel de la retina, que no será explicado antes de Kepler. En cambio, da una descripción exacta del ojo, en el cual distingue tres medios refringentes y cuatro membranas.

En una serie de experiencias, Al-Hazen verifica, con espejos planos, convexos, cóncavos, cilíndricos, cónicos y esféricos, la ley de la reflexión. Es el primero en enunciarla en su forma completa:

«La normal a la superficie reflectora en el punto de incidencia se encuentra siempre en el mismo plano que el rayo incidente y reflejado»,establece el físico árabe. Su sagacidad de matemático está demostrada en la solución de problemas de óptica geométrica, y no es inferior a su arte de experimentador. Uno de dichos problemas se enuncia así: «Dada la posición del punto luminoso, hallar sobre la superficie de espejos esféricos, cónicos y cilíndricos, el punto de reflexión que permita para una posición dada el ojo ver la imagen del punto luminoso.» Este es el famoso «problema de Al-Hazen», que lleva analíticamente a una ecuación de cuarto grado; Al-Hazen lo resuelve mediante la intersección de un círculo con una parábola.

Los fenómenos revelados por espejos esféricos y parabólicos cautivaron particularmente su interés. Encontró la aberración esférica y estableció la concurrencia en un punto de los rayos paralelos en espejos parabólicos cóncavos.

Al-Hazen dedica cuidadosos estudios a la verificación de las experiencias de Tolomeo sobre la refracción de la luz. Sin duda, permanece ignota también al sabio árabe la ley que el precursor alejandrino había buscado en vano, pero reconoce que los planos de incidencia y de refracción coinciden y encuentra el lugar de la imagen engendrada por los rayos refractados en el punto de intersección del rayo refractado (o su prolongación) y de la perpendicular desde el objeto hasta la superficie refractora. Sus experiencias de refracción con segmentos esféricos le permiten reconocer el poder amplificador de los lentes, sin pensar —que sepamos — en una aplicación práctica.

Varios problemas de la óptica atmosférica atrajeron su atención; parte de la hipótesis según la cual la luz crepuscular persiste mientras haya un rayo de Sol que se refleje en un estrato de la atmósfera, y concluye de la duración del crepúsculo, la altura de la atmósfera, que considera de 15 kilómetros.

De sus otras contribuciones a la óptica nos limitaremos a indicar algunas: es el primero en estudiar la cámara oscura, así como el primero en distinguir entre sombra y penumbra. En oposición a los pensadores de la antigüedad, Al-Hazen es el primero en enseñar que la velocidad de la luz es finita, anticipando así un descubrimiento reservado a un lejano porvenir.

Las investigaciones de Al-Hazen encontraron gran repercusión. Su obra maestra, enriquecida con un comentario de Al-Farisi (1300) y traducida al latín y otros idiomas, ejerció profunda influencia, cuyas huellas se pueden seguir hasta los estudios ópticos de Kepler.

Sin alcanzar la importancia de Al-Hazen, Al-Khazini (primera mitad del siglo XII) merece ser incluido entre los grandes físicos, por sus admirables determinaciones de pesos específicos. Es el único representante de la «ciencia árabe», al cual la mecánica es deudora de algunos progresos. Sin duda, Al-Khazini debe mucho al sabio universal —matemático, geógrafo y astrónomo— Al-Biruni (973-1048), cuyos métodos y resultados mejoró, sin embargo, considerablemente.

Esclavo griego, Al-Khazini tuvo la suerte de encontrar un amo bondadoso que le permitió instruirse. Su obra, un tratado de mecánica y de hidrostática que lleva el poético título de Balanza de la sabiduría (Mizan al-Hihna) se cuenta, con razón, entre los más notables escritos del Medievo.

No cabe negar que Al-Biruni y Al-Khazini son discípulos de Arquímedes y de los alejandrinos, mas ellos elaboraron con más claridad el fundamental concepto del peso específico, que definieron como la relación del peso absoluto con el peso del agua desalojada. No ignoraban que la densidad del agua decrece con temperatura creciente, y su observación de que la diferencia de densidad entre el agua caliente y el agua fría alcanza 0,04167 muestra el cuidado con que procedieron en sus mediciones.

Para determinar los pesos específicos, Al-Khazini construyó varias balanzas, una de las cuales, particularmente sensible —con un brazo de 2 metros de longitud y con cinco platillos— era la «balanza de la sabiduría». Los resultados obtenidos para metales, los líquidos y piedras preciosas, son muy satisfactorios, como muestra la tabla siguiente:

| Peso especifico | ||

| Sustancia | Al-Khazini | Valor actual |

| Oro | 19,06 | 19,26 |

| Mercurio | 13,58 | 13,59 |

| Cobre | 8,60 | 8,85 |

| Hierro | 7,74 | 7,79 |

| Estaño | 7,32 | 7,29 |

| Plomo | 11,32 | 11,35 |

| Zafiro | 3,96 | 3,90 |

| Esmeralda | 2,00 | 2,73 |

Agreguemos que Al-Khazini sabía que el peso de los objetos cambia con su distancia del centro de la Tierra: resultado notable, aunque las premisas que le sirvieron de base eran falsas.

2. La ciencia occidental

Rogelio Bacon y Pedro Peregrino

Ignoran por completo la embriagante aventura del espíritu que conocería el Renacimiento cuando lanzara audazmente el navío de sus experimentos sobre el inmenso océano de las verdades inexploradas.

La infiltración de los clásicos griegos y de las obras árabes en el pensamiento de la cristiandad occidental se hizo gradualmente más sensible desde principios del siglo XIII. Las universidades de Bolonia, de París, de Montpellier, de Oxford y algunas otras están definitivamente constituidas y dan impulso a las investigaciones. La filosofía, y con ella la ciencia, comienza a separarse de la teología. Es el momento en que surgen dos personalidades que aportan nuevas ideas a la ciencia en general y algunos progresos a la física en particular.

Rogelio Bacon (1214-1294), hijo de gentes pudientes, nació en Ilchester (Inglaterra) y fue contemporáneo del mayor filósofo de la escolástica, Tomás de Aquino. Bacon se formó en Oxford bajo la influencia del matemático Adam Marsh y del físico Roberto Grossetête, conocedor del griego y del árabe. Después de haberse doctorado en París, volvió a Inglaterra e ingresó en la orden de los franciscanos. Católico iluminista, se acercó a las ciencias en búsqueda del camino que lleva a Dios. Sus ideas, que se adelantaban a la época, no tardaron en despertar las sospechas de sus superiores eclesiásticos. Obligado a regresar a París, fue vigilado severamente por sus hermanos de orden y castigado con la prohibición de enseñar sus doctrinas. Sin embargo, cuando Clemente IV, papa de amplia visión, ascendió a la silla de San Pedro, autorizó a Bacon a publicar sus trabajos. De acuerdo con la anuencia del pontífice, Bacon le envió en 1267 la exposición de sus doctrinas, su Opus majus, que contiene sus investigaciones en física, seguido bien pronto por otros dos libros, Opus minus y Opus tertium.

Por desgracia, la muerte prematura del papa privó a Bacon de su protector. Fue encarcelado una vez más (1278), y sólo recuperó la libertad en el año 1292, poco antes de su muerte.

Conocedor del tratado de Al-Hazen, Bacon se dedicó particularmente a la óptica. El poder de aumento de los lentes atrajo su atención y recomendó su uso a los ancianos y a los personas de vista débil. Su descripción de la trayectoria del rayo luminoso en los lentes, aunque defectuosa, puede ser considerada como una grosera aproximación a la realidad [6]. Efectuó experimentos con la cámara oscura y notó que la imagen del Sol es siempre redonda, sin importar que sus rayos entren en el aparato por un agujero redondo o anguloso. La inversión de la imagen no escapó a su atención. Su teoría del arco iris —cuya altura (42°) conocía—, que explica por la refracción de la luz al atravesar las gotas de agua, señala un paso adelante en el conocimiento de este fenómeno [7].

Agreguemos que Bacon es el primero en concebir, en su Opus majus y la gravedad como atracción hacia el centro del globo terráqueo, y es igualmente el primero en explicar el calor como un movimiento que tiene por asiento el interior de los cuerpos.

A pesar de estas contribuciones, Bacon no es, en realidad, un hábil experimentador, y menos aún un gran teórico. Sin embargo, no son los descubrimientos que aportó a la física o a la química los que le aseguran fama duradera, sino su actitud general frente a la ciencia, sus opiniones sobre los métodos de investigación, opiniones por otra parte sorprendentemente modernas, en relación al medio que lo rodeaba. La erudición del Doctor Mirabilis —sobrenombre que sus contemporáneos le dieron— era grande, pero en vez de aceptar ciegamente las aseveraciones de Aristóteles o de otros, sostuvo la necesidad de experimentar, para verificar las antiguas afirmaciones y adquirir nuevos conocimientos. Insiste sobre la necesidad de comprobar experimentalmente las conclusiones alcanzadas a priori.

La lógica sirve de seguro andamio para la prueba argumental, pero únicamente la experiencia es juez competente de la certeza de los hechos. Su intuición reconoce la importancia de las matemáticas en la investigación de las ciencias. Sed sola mathematica manet nobis certa et verificata in fine certitudinis et veri tatis (Sólo la matemática es y permanece cierta y verificada para nosotros hasta el límite de la certeza y de la verdad), dice el fraile franciscano, en la época de Tomás de Aquino.

La obra de Bacon es la expresión de las dudas y certezas de una época de transición. Con todo su amor por la ciencia, este pensador del siglo XIII estima que la teología es la cúspide y la última finalidad de todo conocimiento, convencido de que una investigación bien llevada sólo podía confirmar los dogmas de la Iglesia. Por otra parte, es el anunciador de tiempos futuros, gracias a su independencia respecto de Aristóteles y merced a la importancia que en el proceder de la investigación asignó a la experiencia. Su visión sobrepasó a su tiempo en siglos. Previó —aunque muy vagamente— conquistas venideras: carros con propulsión mecánica, máquinas voladoras, el empleo de los explosivos y varias otras cosas. Este último aspecto de su labor, contribuyó sin duda a convertirlo ante los ojos de la posteridad en un venerable mago.

Entre los investigadores de su época, Bacon concede los mayores elogios a Pedro Peregrino de Maricourt.

«Lo que otros —dice Bacon— ven oscura y penosamente, cual murciélagos en el crepúsculo, él, maestro del experimento, mira a la luz del día. Merced al experimento adquiere conocimientos de las cosas de la naturaleza, tanto en la medicina como en la química; conoce, en verdad, todos los fenómenos del cielo y de la tierra.»Su estancia en París había puesto a Bacon en contacto con el sabio picardo, al que glorifica con tanto entusiasmo en su Opus tertium. Pedro Peregrino había participado en la primera cruzada de San Luis, pasó más tarde, como ingeniero militar, al servicio de Carlos de Anjou, y terminó por establecerse en París.

Era un misántropo, nos dice su brillante alumno Bacon, temía la multitud y desdeñaba la gloria. Mientras los demás sabios discutían sobre problemas metafísicos, Pedro Peregrino pasaba su vida en el laboratorio. De sus trabajos —que parece fueron numerosos— sólo nos ha llegado uno: su célebre carta dirigida, en 1269, a un amigo: Epístola De magnete, el primer tratado científico sobre las propiedades del imán.

El elocuente elogio de Bacon no permite dudar de que Pedro Peregrino de Maricourt enriqueció con sus experiencias los conocimientos de su época sobre este tema capital. ¿Cuáles son, sin embargo, los hechos que tomó de sus predecesores, y cuáles son sus propios descubrimientos? Cuestión difícil, por no decir imposible de resolver.

El conocimiento de la piedra imán se remonta a la antigüedad; la propiedad que tiene el hierro magnetizado de atraer a otros trozos de hierro no escapó a la atención de los observadores griegos, como prueba un pasaje del diálogo Ion, atribuido —con razón o sin ella— a Platón. ¿Cuándo se suma a este modesto fondo de conocimientos el uso de la brújula bajo su forma más primitiva? Parece que los navegantes chinos empleaban ya en el siglo II de nuestra era la aguja imantada artificial —flotando sobre agua o suspendida por un hilo— como indicador de dirección [8].

Pasaron, poco más o menos, mil años hasta que el conocimiento de este dispositivo, transmitido quizá primero a los hindúes y después a los árabes, fue introducido en los países occidentales, donde el uso de la brújula es certificado hacia el año 1200 por numerosos autores.

Veamos, en tanto, la aportación de la epístola de Pedro Peregrino. Reduce a una esfera una piedra imán y coloca sobre su superficie agujas de hierro; la dirección de cada una de éstas define una línea. Los dos puntos de intersección de todas estas líneas son los polos del imán. Coloca su imán sobre un platillo que flota en agua y, aproximando otra piedra imán, reconoce la repulsión de los polos del mismo signo y la atracción de los de signo distinto. Verifica la inducción magnética.

Al romper una aguja imantada, descubre que los dos trozos forman igualmente agujas imantadas, cada una con la misma polaridad que la aguja original. Da instrucciones para la construcción de brújulas; una de ellas es apoyada sobre un gorrón y lleva un círculo graduado y una alidada.

¿Por qué su piedra imán se orienta en una dirección determinada? Los polos celestes la atraen, admite Pedro Peregrino; pero en otro pasaje de su instructiva epístola afirma que los imanes deben sus propiedades al magnetismo terrestre, cuya existencia es el primero en entrever [9].

Capítulo 3

Precursores de la ciencia moderna

Leonardo de Vinci: Sus investigaciones mecánicas y físicas; Simón Stevin: La imposibilidad del perpetuum mobile; Guillermo Gilbert; Comienzos de la magnetología y electrología,

La primera gran figura que encontramos en los albores de los tiempos nuevos pertenece a la segunda mitad del siglo XV: es Leonardo de Vinci (1452-1519), tal vez el genio más universal que la historia conoce. Pintor, escultor, arquitecto, ingeniero, físico, biólogo, se adelantó a su centuria con admirables descubrimientos en las más distintas ramas del saber. Para él, como después para Galileo, la ciencia está por hacerse, la verdad por encontrarse. Había asimilado, poco más o menos, toda la ciencia conocida en su tiempo. La clarividencia de sus intuiciones, la asombrosa agudeza de su inteligencia y sobre todo la universidad sin precedentes de su genio, lo hacen aparecer para la posteridad como un ser casi sobrehumano. Si su labor científica queda eclipsada, incluso hoy, por su labor artística, sólo es porque hace poco tiempo que fueron arrancadas al olvido sus notas manuscritas, dejadas a su discípulo Francisco Melzi.

Hijo natural de un jurista y de una campesina, alumno predilecto del gran pintor Andrés Verrocchio, entró sucesivamente al servicio de las cortes de Florencia, Milán y Roma. A invitación de Francisco I, que lo llenó de favores, se trasladó a Francia, donde murió, en el castillo de Saint-Cloux.

Dar un resumen, aun muy sintético, de la amplia variedad de las investigaciones de Leonardo excede los límites de nuestro tema. Nos limitaremos a señalar algunos de los resultados de sus investigaciones en la mecánica y en la física, el único aspecto de su polifacética actividad que nos interesa aquí.

Como arquitecto e ingeniero, Leonardo de Vinci fue llevado, en razón de los problemas prácticos que debió resolver, al estudio de la mecánica. El teorema central de su estática es el principio de las velocidades virtuales, cuyo contenido, en los razonamientos de Leonardo, equivale a afirmar que las fuerzas que actúan en una máquina en equilibrio son indirectamente proporcionales a sus velocidades virtuales. Posee el concepto del momento estático [11], del cual deduce el equilibrio de las fuerzas que actúan sobre la palanca. A ésta la considera como la máquina primaria y las demás sólo son modificaciones y formas complejas de la misma. Al utilizar la ley de la palanca logró determinar, mejor que sus predecesores, la condición de equilibrio de dos pesos iguales colocados sobre dos planos con desigual inclinación. Su demostración implica, una vez más, el principio de las velocidades virtuales. Agreguemos que Leonardo conoce los diferentes tipos de equilibrio (estable, neutro, inestable); sabe determinar la componente de una fuerza según una dirección dada; posee clara noción del trabajo y entrevé, anticipando investigaciones de Stevin, la imposibilidad del perpetuo móvil, a pesar de que durante algún tiempo procuró realizarlo.

A través de una serie de experimentos, buscó las leyes de la caída de los cuerpos; compartió el error peripatético de que la velocidad de la caída depende del volumen y del peso de los cuerpos. Si bien no llegó al objetivo propuesto, tiene el mérito de haber reconocido que las leyes de la caída libre debían verificarse también en el descenso frenado sobro un plano inclinado, lo cual constituye un importante preludio a las investigaciones de Galileo [12].

Las tareas prácticas de Leonardo exigían un conocimiento de los fenómenos de elasticidad y rozamiento. Descubrió, en cuanto al primero, que la elasticidad de tracción es igual a la elasticidad de compresión; en cuanto al segundo, encontró que el rozamiento de deslizamiento es independiente de la magnitud del área de contacto. Estas leyes, escondidas en los manuscritos inéditos de Leonardo, cayeron en el olvido y sólo fueron establecidas hacia fines del siglo XVII, la primera por el inglés Hooke, la segunda por el francés Amontons, doscientos años después de su descubrimiento por el gran italiano.

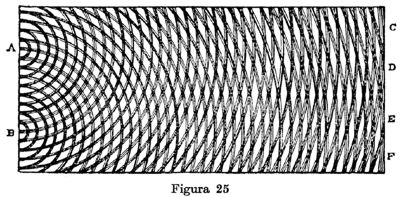

Constructor de canales, Leonardo se dedicó también a investigaciones hidromecánicas. Estudió el derrame del agua a través de orificios de distintas características y la propagación de las ondas sobre superficies líquidas. Probablemente fue el primero en llamar la atención acerca del fenómeno de la interferencia de ondas líquidas. Le debemos la primera descripción de la ascensión de líquidos en tubos delgados y la extensión de la ley de los vasos comunicantes a dos líquidos con pesos desiguales; puso de manifiesto que las alturas son inversamente proporcionales a las densidades de los líquidos.

De las ondas líquidas pasa Leonardo a las ondas sonoras; reconoce que el eco se explica por la reflexión del sonido. De la observación del eco concluye una velocidad determinada de las ondas acústicas, cuya propagación en el agua estudia igualmente. Compara la reflexión del sonido a la de la luz, pues en ambos fenómenos el ángulo de incidencia es igual al de reflexión. En su teoría de la visión, Leonardo asimila el ojo a una cámara oscura.

Más numerosos todavía que los descubrimientos de Leonardo en mecánica y en física son sus planos y proyectos de índole técnica. Ideó máquinas elevadoras, distintas clases de cañones de tiro rápido y de retrocarga, instrumentos de música mecánicos, trajes y escafandras para buzos, odómetros, un compás proporcional y parabólico, un dinamómetro, un higrómetro y otros aparatos. Sin duda, la mayoría de sus invenciones quedaron en estado de proyecto. Pero en sus manuscritos, ilustrados con admirables dibujos, nada se describe que no sea técnicamente construible. Algunas de sus ideas técnicas se adelantan en siglos a su época. Sabía que la densidad del aire caliente es menor que la del aire frío y propuso utilizar el primero para llenar un globo capaz de ascender en la atmósfera, anticipando así en casi trescientos años la idea llevada a la práctica por los hermanos Montgolfier.

Diseñó distintos tipos de máquinas voladoras e inventó un paracaídas, que se ha desarrollado según el mismo principio por él concebido. Sus estudios sobre la resistencia del aire, la estabilidad de las máquinas voladoras y la posición del centro de gravedad en las mismas preludian el nacimiento de la aeronáutica como ciencia. El conjunto de su obra técnica agrega a sus otros títulos de gloria el del ingeniero más sobresaliente de su época y aun de su siglo.

Mas por admirables que sean sus descubrimientos, inventos e intuiciones, Leonardo de Vinci no ocupa en el desarrollo de la física —y en general de la historia de las ciencias— el lugar que se podría pretender. Este superhombre, que habría podido abrir el camino de tantas resonantes conquistas, no publicó ningún tratado científico y prefirió dejar a la posteridad sus lúcidas intuiciones y magníficos hallazgos en notas escritas con la mano izquierda y difícilmente descifrables. La repercusión de sus ideas, que hubieran podido producir una profunda modificación en la evolución de la ciencia, no fue profunda, confinada al reducido círculo de sus discípulos y de algunos sabios que pudieron consultar sus manuscritos [13].

Los años en que vivió Leonardo de Vinci coinciden con acontecimientos trascendentales, que debían repercutir profundamente en la historia intelectual de la humanidad. Algunos meses después del nacimiento de Leonardo los turcos se apoderaron de Constantinopla, capital del último resto del que fue imperio romano. Conocedores del griego y portadores de preciosos manuscritos, los sabios helenos, que huían de la patria esclavizada, se establecieron en Italia y otros países occidentales, dando poderoso impulso al estudio de la antigua sabiduría. Al resucitado pensamiento de la antigüedad da alas el arte de imprimir, que comienza a difundirse cuando Leonardo tenía unos diez años. Cuando Colón descubrió América, Leonardo entraba en la quinta década de su vida, y Magallanes emprendía la primera circunnavegación del globo terráqueo justamente el año de la muerte de Leonardo. Al mismo tiempo comienza Copérnico a reunir los elementos de su gran obra, que arrebatará a la Tierra sus supuestas inmovilidad y posición central del universo.

Estos acontecimientos configuran un importante aspecto de la aurora del Renacimiento o introducen la liberación del espíritu de las limitaciones que lo impuso la Edad Media. La autoridad de Aristóteles y Tolomeo, ídolos de las centurias pasadas, cede poco a poco ante la de Arquímedes y Aristarco, primeros guías de una nueva y milagrosa exploración del mundo.

Como Leonardo, también Simón Stevin (1548-1620) sigue las huellas de Arquímedes. Su obra señala la cúspide de la mecánica, limitada exclusivamente a la estática. En este aspecto, el agudo flamenco es el último gran representante de la escuela del genial siracusano.

Nació en Brujas, dieciséis años antes de que viera la luz Galileo; en su juventud fue tenedor de libros, empleo que abandonó para realizar largos viajes que lo llevaron hasta Suecia. Se estableció luego en La Haya, donde sus éxitos como constructor de fortificaciones y diques le valieron gran reputación y la amistad del príncipe Mauricio de Nassau, gobernador de los Países Bajos. Ardiente patriota flamenco tuvo la poco feliz ocurrencia de publicar en su lengua vernácula sus principales obras, que permanecieron veinte años —hasta su traducción al latín (1605-1608)— como escritos herméticos para la mayoría de los investigadores contemporáneos.

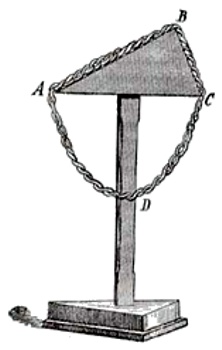

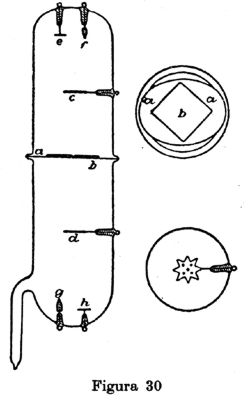

Para construir diques, tarea profesional de Stevin, eran indispensables máquinas que elevaran pesadas cargas. ¿Qué máquina podría prestar mejores servicios que un móvil perpetuo, capaz de trabajar ilimitadamente y sin gastos? En efecto, el ingeniero Stevin, como antes de él, Leonardo y muchos otros, procuró inventar una máquina engendradora de movimiento eterno o continuo. La época del gran flamenco no conocía ninguna ley de la física que excluyera la posibilidad del móvil perpetuo o movimiento continuo: ni utópico ni irracional era querer realizarlo. Ignoramos cuántos modelos construyó Stevin antes que su paciencia se hubiera agotado. Más, en oposición a sus predecesores, supo sacar del fracaso de sus ensayos una conclusión preñada de útiles consecuencias. Aceptó como principio la imposibilidad del móvil perpetuo —la imposibilidad del trabajo nacido de la nada— y se propuso deducir leyes del nuevo axioma.

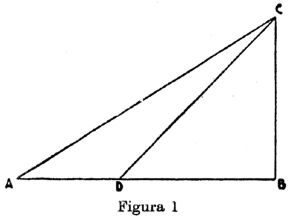

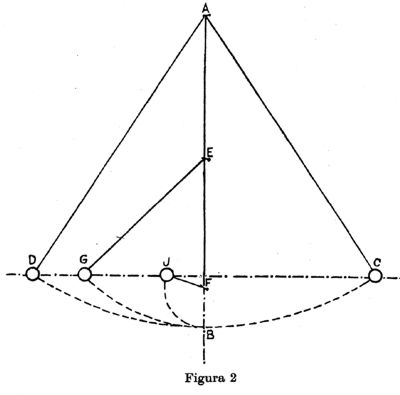

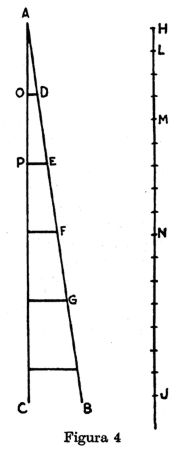

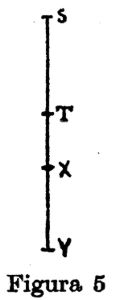

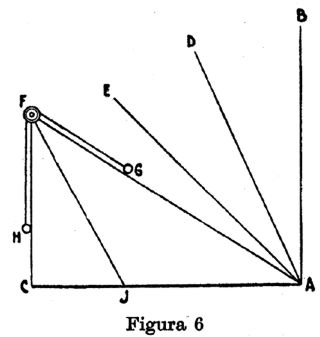

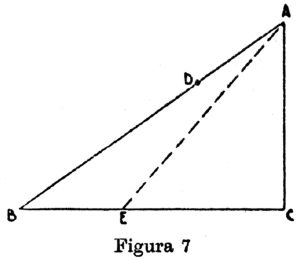

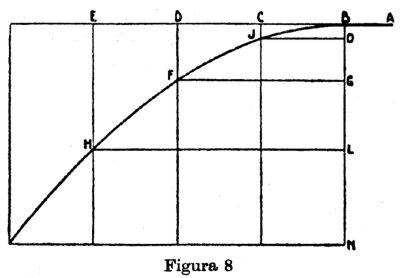

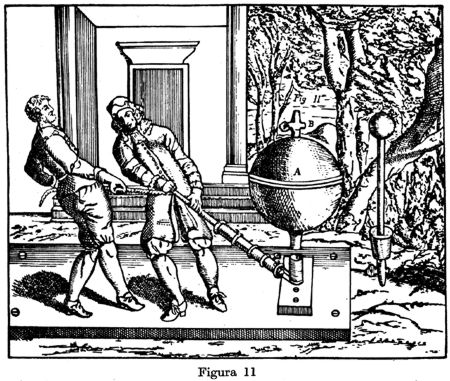

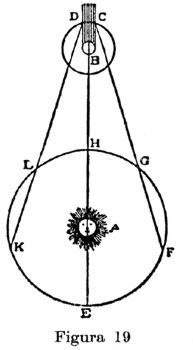

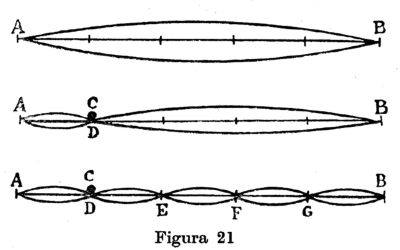

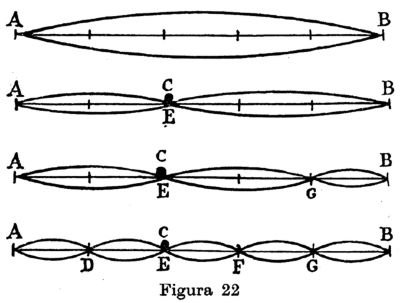

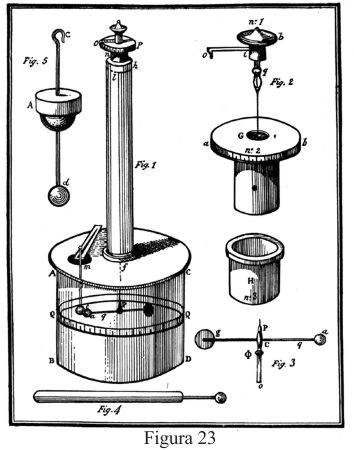

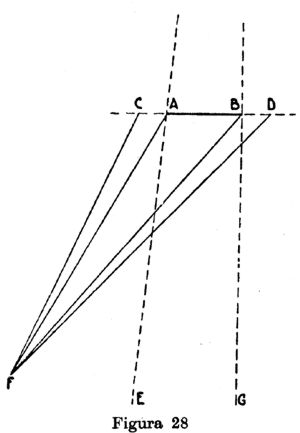

Stevin eligió dos planos inclinados que reposan sobre una base horizontal y que, unidos por su arista superior, forman un prisma triangular. Rodeó el sistema con una cadena cerrada, compuesta de eslabones pesados que pueden deslizarse sin rozamiento a lo largo de los planos inclinados. Una mirada sobre la figura nos muestra que sobre el plano izquierdo actúa una fuerza doble de la que obra sobre el plano derecho. Puesto que hay exceso de peso de un lado, parece que la cadena debiera ponerse en movimiento. Si esto ocurriera, habríamos logrado realizar el móvil perpetuo, pues por mucho que dure el movimiento, siempre habrá doble número de eslabones sobre el plano izquierdo que sobre el plano derecho. De la imposibilidad del movimiento continuo resulta que nuestra cadena quedará en reposo, pues n eslabones sobre un lado equilibran 2n sobre otro.

Wonder en is gheen wonder (Una maravilla, y sin embargo no es ninguna maravilla), escribió Stevin sobre su teorema.

Figura 1

La imagen de los dos planos inclinados rodeados por la cadena sin fin figura en la portada del libro de Stevin, quien la hizo poner allí deseoso, sin duda, de subrayar los alcances del camino seguido en sus búsquedas. Tenía razón de estar orgulloso de su método: implica, en efecto, el primer ejemplo de un experimento pensado, bien ideado y llevado con rigor — more geométrico— a importantes conclusiones.

La historia de la física clásica y nueva ofrece más de un ejemplo del éxito de este procedimiento. Irrealizables en verdad, más o menos vinculados con hechos empíricos, los experimentos pensados están justificados si llevan, como el de Stevin, el sello de la certeza intuitiva.

La imposibilidad axiomática del móvil perpetuo guió a Stevin también en sus investigaciones de las condiciones de equilibrio en los líquidos. Supongamos, dice Stevin, que en un recipiente lleno de agua una cierta cantidad de líquido descendiera; su lugar sería inmediatamente ocupado por otra cantidad de agua que descendería a su vez. Un movimiento perpetuo sería la consecuencia; consecuencia evidentemente absurda. Stevin admite, por otra parte, que el equilibrio no sería perturbado si una parte del líquido se solidificara. De este modo, logra deducir el principio de Arquímedes y descubrir la importante «paradoja hidrostática»: el hecho capital de que la presión sobre el fondo del recipiente es independiente de la forma de éste y sólo depende del área del fondo y de la altura de la columna líquida, siendo medida por el peso del prisma líquido que descansa sobre el fondo [14].

Agreguemos que Stevin determina también la condición de equilibrio estable e inestable de los cuerpos flotantes.

Otros felices hallazgos de Stevin podríamos mencionar. Nos bastará indicar que se aproximó más que sus predecesores al principio de los desplazamientos virtuales, y que se adelantó a Galileo, enseñando (1580) que los cuerpos livianos y los posados caen con la misma velocidad. Aunque el nombre de Stevin no resplandece con el halo que la historia convencional rodea a algunos investigadores renacentistas, no cabe duda que en la larga sucesión de siglos que media entre Arquímedes y Galileo, el sagaz holandés aportó una comprensión más profunda de los problemas de la mecánica que cualquiera de sus rivales.

Mientras Stevin en Holanda convertía un axioma negativo en eficaz instrumento para buscar hechos nuevos y positivos, en Inglaterra Guillermo Gilbert (1544-1603) abría a la investigación experimental los campos hasta entonces casi inexplorados del magnetismo y de la electricidad. Médico de la reina Isabel, amigo del canciller filósofo Francisco Bacon, Gilbert fue en las postrimerías del siglo XVI uno de los sabios más respetados de su país. Su Tratado sobre magnetismo (De muguete, 1600) — libro que por la claridad de su método y por la riqueza de su contenido mereció la admiración de Galileo y Descartes— permaneció durante más de un siglo como la obra fundamental acerca de esa doble fuerza de la naturaleza.

Como hizo Pedro Peregrino más de trescientos años antes, Gilbert reunió los conocimientos que su época poseía sobre los fenómenos magnéticos, y agregó a los mismos el valioso caudal de sus propios experimentos. Es el primero en proveer de armaduras a imanes para reforzar su acción, así como el primero en reconocer que la inducción confiere al acero magnetismo permanente. Muestra que el magnetismo se pierde por incandescencia, y comprueba que una barra de acero no aumenta de peso al ser imantada [15]. El magnetismo —concluye— es, por consiguiente, imponderable. Confirma el descubrimiento de Pedro Peregrino, y reconoce que los trozos de un imán son asimismo imanes, cada uno de los cuales posee dos polos. Estudia la inclinación y declinación de la aguja magnética y trata de explicar por qué su valor varía con la posición geográfica del lugar.