Historia de las matemáticas

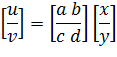

Ian Stewart

Las matemáticas no nacieron plenamente formadas. Fueron haciéndose gracias a los esfuerzos acumulativos de muchas personas que procedían de muchas culturas y hablaban diferentes lenguas. Ideas matemáticas que se siguen utilizando hoy datan de hace más de 4.000 años.

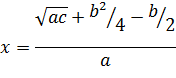

Muchos descubrimientos humanos son efímeros; el diseño de las ruedas de carro fue muy importante para el Reino Nuevo Egipcio, pero hoy día no es exactamente tecnología de vanguardia. Las matemáticas, por el contrario, suelen ser permanentes. Una vez que se ha hecho un descubrimiento matemático está a disposición de cualquiera, y con ello adquiere una vida propia. Las buenas ideas matemáticas difícilmente pasan de moda, aunque la forma de implementarlas puede sufrir cambios espectaculares. Hoy seguimos utilizando métodos para resolver ecuaciones que fueron descubiertas por los antiguos babilonios. Ya no utilizamos su notación, pero el vínculo histórico es innegable.

De hecho, la mayoría de las matemáticas que se enseñan hoy en la escuela tienen más de 200 años.

La inclusión de las matemáticas modernas en los programas de estudio en los años sesenta del siglo pasado llevó la asignatura al siglo XIX. Pero, contra lo que pueda parecer, las matemáticas no se han quedado quietas. Hoy día, se crean más matemáticas nuevas cada semana que las que los babilonios pudieron manejar en dos mil años.

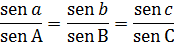

El progreso de la civilización humana y el progreso de las matemáticas han ido de la mano. Sin los descubrimientos griegos, árabes e hindúes en trigonometría, la navegación en océanos abiertos hubiera sido una tarea aún más aventurada de lo que fue cuando los grandes marinos abrieron los seis continentes. Las rutas comerciales de China a Europa, o de Indonesia a las Américas, se mantenían unidas por un invisible hilo matemático.

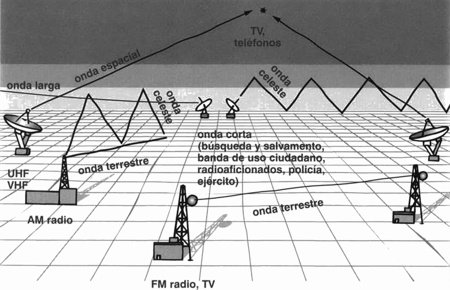

La sociedad de hoy no podría funcionar sin matemáticas. Prácticamente todo lo que hoy nos parece natural, desde la televisión hasta los teléfonos móviles, desde los grandes aviones de pasajeros hasta los sistemas de navegación por satélite en los automóviles, desde los programas de los trenes hasta los escáneres médicos, se basa en ideas y métodos matemáticos. A veces son matemáticas de mil años de edad; otras veces son matemáticas descubiertas la semana pasada. La mayoría de nosotros nunca nos damos cuenta de que están presentes, trabajando entre bastidores para facilitar esos milagros de la tecnología moderna.

Esto no es bueno: nos hace creer que la tecnología funciona por magia, y nos lleva a esperar nuevos milagros cada día. Por otra parte, es también completamente natural: queremos utilizar estos milagros con tanta facilidad y tan poco esfuerzo mental como sea posible. El usuario no debería cargarse con información innecesaria sobre la maquinaria subyacente que hace posible los milagros. Si todos los pasajeros de un avión tuvieran que superar un examen de trigonometría antes de embarcar en el avión, pocos de nosotros dejaríamos la tierra alguna vez. Y aunque eso podría reducir nuestra pisada de carbono, también haría nuestro mundo muy pequeño y provinciano.

Escribir una historia de las matemáticas verdaderamente completa es virtualmente imposible. La disciplina es ahora tan amplia, tan compleja y tan técnica, que ni siquiera un experto podría entender por completo un libro semejante; dejando aparte el hecho de que nadie podría escribirlo. Morris Kline se acercó con su épico Pensamiento matemático desde la antigüedad hasta los tiempos modernos. Tiene más de 1.200 páginas de letra pequeña, y deja fuera casi todo lo que ha sucedido en los últimos cien años.

Este libro es mucho más corto, lo que quiere decir que he tenido que ser selectivo, especialmente en lo que se refiere a los siglos XX y XXI. Soy plenamente consciente de todos los temas importantes que he tenido que omitir. No hay geometría algebraica, ni teoría de cohomología, ni análisis de elementos finitos, ni ondeletes.

La lista de lo que falta es mucho más larga que la lista de lo que se ha incluido.

Mis elecciones se han guiado por lo que probablemente es la formación básica de los lectores y por la concisión con que pueden explicarse las nuevas ideas.

La historia sigue aproximadamente un orden cronológico dentro de cada capítulo, pero los capítulos están ordenados por temas. Esto es necesario para darle una coherencia narrativa, si lo pusiera todo en orden cronológico, la discusión saltaría de forma aleatoria de un tema a otro, sin ningún sentido de dirección.

Esto podría estar más cerca de la historia real, pero haría el libro ilegible. Por eso, cada nuevo capítulo empieza con una vuelta al pasado, y luego toca algunos de los hitos históricos por los que pasó la disciplina en su desarrollo. Los primeros capítulos se detienen a mucha distancia en el pasado; los últimos capítulos recorren a veces todo el camino hasta el presente.

He tratado de dar una idea de las matemáticas modernas, por lo que entiendo cualquier cosa hecha en los últimos 100 años más o menos, seleccionando temas de los que los lectores pueden haber oído hablar y relacionándolos con las tendencias históricas generales. La omisión de un tema no implica que carezca de importancia, pero creo que tiene más sentido dedicar algunas páginas a hablar de la demostración de Andrew Wiles del Último Teorema de Fermat -de lo que la mayoría de los lectores han oído hablar- que, por ejemplo, a la geometría no-conmutativa, de la que tan sólo el fundamento ocuparía varios capítulos.

En definitiva, ésta es una historia, no la historia. Y es historia en el sentido en que cuenta un relato sobre el pasado. No se dirige a historiadores profesionales, no hace las finas distinciones que ellos creen necesarias, y a veces describe ideas del pasado a través de los ojos del presente. Esto último es el pecado capital para un historiador, porque hace que parezca que los antiguos estaban luchando por llegar a nuestro modo de pensamiento actual. Pero creo que es defendible y esencial si el objetivo principal es partir de lo que ahora sabemos y preguntar de dónde proceden dichas ideas. Los griegos no estudiaron la elipse para hacer posible la teoría de las órbitas planetarias de Kepler, ni Kepler formuló sus tres leyes del movimiento planetario para que Newton las convirtiera en su ley de la gravedad. Sin embargo, la historia de la ley de Newton se basa firmemente en el trabajo griego sobre la elipse y el análisis de Kepler de los datos observacionales.

Un subtema del libro son los usos prácticos de las matemáticas. Aquí he ofrecido una muestra muy ecléctica de aplicaciones, pasadas y presentes. Una vez más, la omisión de un tema no indica que carezca de importancia.

Las matemáticas tienen una historia larga y gloriosa aunque algo olvidada, y la influencia de la disciplina sobre el desarrollo de la cultura humana ha sido inmensa. Si este libro transmite una minúscula parte de la historia, habrá alcanzado lo que yo me propuse.

Coventry

Mayo de 2007

Capítulo 1

Fichas, cuentas y tablillas

El nacimiento de los números

Las matemáticas empezaron con los números, y los números siguen siendo fundamentales, incluso si la disciplina ya no se limita a los cálculos numéricos. Sobre la base de los números, las matemáticas han construido conceptos más sofisticados y se han desarrollado hasta constituir un área muy amplia y variada del pensamiento humano, que va mucho más allá de lo que encontramos en un típico temario escolar. Las matemáticas de hoy tratan más de estructuras, pautas y formas que de los propios números. Sus métodos son muy generales, y a menudo muy abstractos. Tienen aplicaciones en la ciencia, la industria, el comercio..., incluso las artes. Las matemáticas son universales y ubicuas.

§. Empezó con números

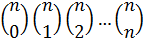

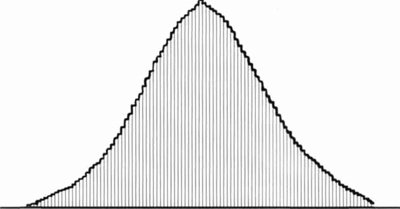

Durante muchos miles de años, matemáticos de muchas y diferentes culturas han creado una enorme superestructura cimentada en los números: geometría, cálculo infinitesimal, dinámica, probabilidad, topología, caos, complejidad, etc. La revista Mathematical Reviews, que registra cada nueva publicación matemática, clasifica la disciplina en casi un centenar de áreas mayores, subdivididas en varios miles de especialidades.

Hay más de 50.000 matemáticos investigadores en el mundo, que publican más de un millón de páginas de matemáticas nuevas cada año. Matemáticas genuinamente nuevas, no sólo pequeñas variaciones sobre resultados ya existentes.

“Los números parecen muy simples y directos, pero las apariencias engañan.”

Los matemáticos también han investigado en los fundamentos lógicos de su disciplina, y han descubierto conceptos aún más fundamentales que los números: lógica matemática, teoría de conjuntos. Pero, una vez más, la motivación principal, el punto de partida del que fluye todo lo demás, es el concepto de número.

Los cálculos con números pueden ser duros; obtener el número correcto puede ser difícil. Incluso así, es mucho más fácil utilizar números que especificar qué son realmente. Los números cuentan cosas, pero no son cosas: podemos coger dos tazas, pero no podemos coger el número «dos».

Los números se denotan por símbolos, pero no son símbolos: diferentes culturas utilizan diferentes símbolos para el mismo número. Los números son abstractos, y sin embargo nuestra sociedad se basa en ellos y no funcionaría sin ellos. Los números son una construcción mental, y sin embargo tenemos la sensación de que seguirían teniendo significado incluso si la humanidad fuera barrida por una catástrofe mundial y no quedara ninguna mente para contemplarlos.

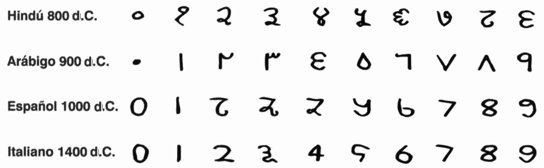

§. Las primeras marcas

La historia de las matemáticas empieza con la invención de símbolos escritos para denotar números. Nuestro familiar sistema de «dígitos» 0, 1, 2, 3, 4, 5, 6, 7, 8, 9, para representar todos los números imaginables, por grandes que sean, es una invención relativamente reciente; nació hace unos 1.500 años, y su extensión a los «decimales», que nos permite representar números con alta precisión, no tiene más de 450 años. Los computadores, que han introducido los cálculos matemáticos en nuestra cultura de forma tan profunda que ya no notamos su presencia, llevan con nosotros tan sólo unos 50 años.

Y sólo hace 20 años que disponemos de computadores suficientemente potentes y rápidos para servirnos en nuestros hogares.

Sin números, la civilización tal como ahora la conocemos no podría existir. Los números están por todas partes, como sirvientes ocultos que corren de un lado a otro entre bastidores: llevan mensajes, corrigen nuestra ortografía cuando escribimos a máquina, programan nuestros vuelos de vacaciones al Caribe, llevan el registro de nuestros bienes, garantizan que nuestros medicamentos sean seguros y efectivos. Y, en contrapartida, hacen posibles las armas nucleares y guían bombas y misiles hacia sus objetivos.

No todas las aplicaciones de las matemáticas han mejorado la condición humana.

¿Cómo surgió esta industria numérica verdaderamente enorme?

Incluso entonces, los contables ya estaban registrando quién era el propietario de qué, y de cuánto; incluso si todavía no se había inventado la escritura y no había símbolos para los números.

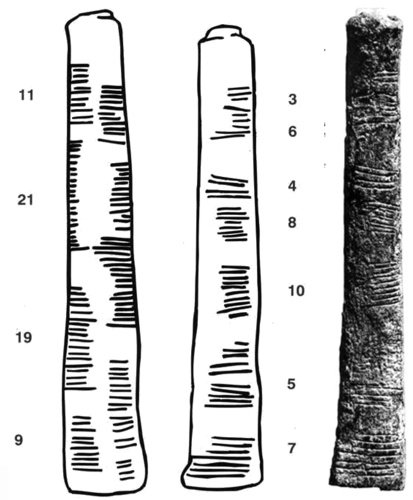

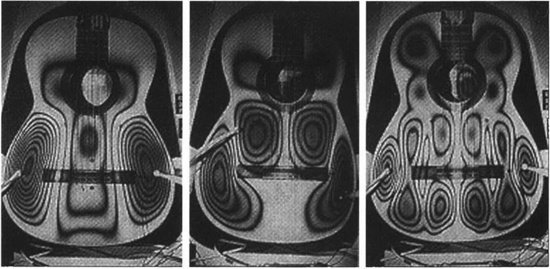

El hueso de Ishango, con las pautas de marcas y los números que pueden representar

En lugar de símbolos numerales, aquellos contables antiguos utilizaban pequeñas fichas de arcilla. Unas eran conos, otras eran esferas y otras tenían forma de huevos.

“Todo empezó con pequeñas fichas de arcilla, hace 10.000 años en el Próximo Oriente.”

Había cilindros, discos y pirámides. La arqueóloga Denise Schhmandt-Besserat dedujo que estas fichas representaban productos básicos de la época. Las esferas de arcilla representaban fanegas de grano, los cilindros representaban animales, los huevos jarras de aceite. Las fichas más antiguas datan del 8.000 a.C. y fueron de uso común durante 5.000 años.

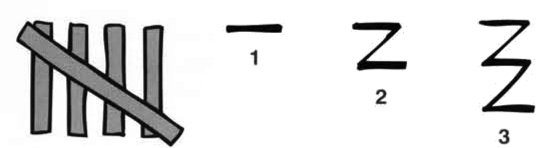

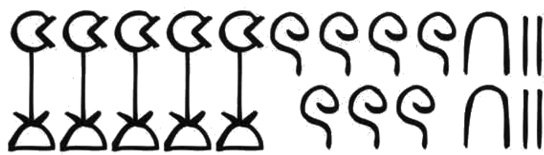

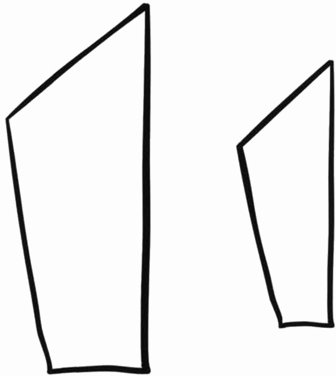

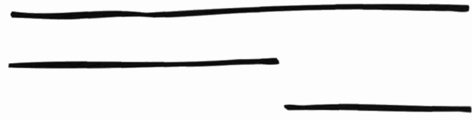

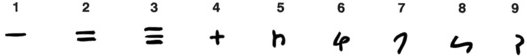

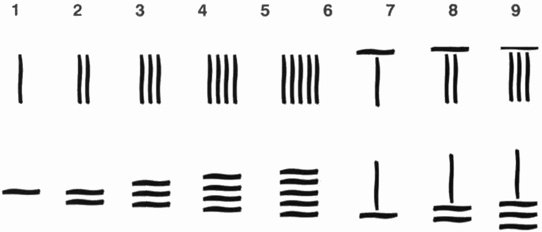

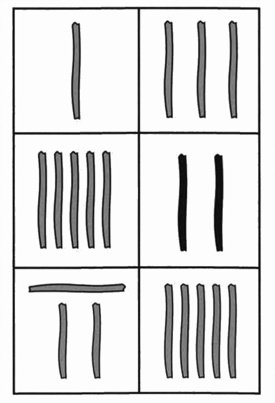

Izquierda. Las marcas de cuenta tienen la ventaja de que pueden ir añadiéndose de una en una, durante largos periodos, sin alterar o borrar marcas anteriores. Se siguen utilizando hoy, a menudo en grupos de cinco con el quinto trazo cruzando diagonalmente los cuatro anteriores. Derecha. La presencia de marcas de cuenta aún puede verse en los numerales modernos. Nuestros símbolos 1,2, 3 se derivan, respectivamente, de un solo trazo, dos trazos horizontales unidos por una línea inclinada, y tres trazos horizontales unidos por una línea inclinada

Con el paso del tiempo, las fichas se hicieron más elaboradas y más especializadas. Había conos decorados para representar barras de pan, y tabletas en forma de diamante para representar cerveza. Schmandt-Besserat se dio cuenta de que estas fichas eran mucho más que un artificio de contabilidad.

Eran un primer paso vital en el camino hacia los símbolos numerales, la aritmética y las matemáticas. Pero ese paso inicial fue bastante extraño, y parece dado por accidente.

Se dio porque las fichas se utilizaban para llevar registros, quizá con fines impositivos o financieros, o como prueba legal de propiedad. Las fichas tenían la ventaja de que los contables podían ordenarlas rápidamente para calcular cuántos animales o cuánto grano poseía o debía alguien. El inconveniente era que las fichas podían ser falsificadas. Así que para asegurar que nadie interfería en las cuentas, los contables guardaban las fichas en recipientes de arcilla, como si estuvieran precintadas. Podían descubrir rápidamente cuántas fichas, y de qué tipo, había dentro de un recipiente dado rompiéndolo. Siempre podían hacer un nuevo recipiente para un almacenamiento posterior.

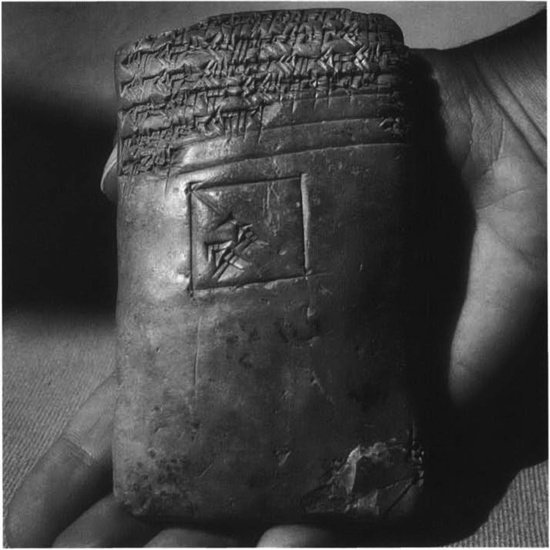

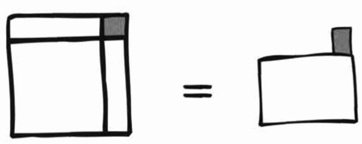

Sin embargo, romper repetidamente un recipiente y renovarlo era una forma muy poco eficaz de descubrir lo que había dentro, y los burócratas de la antigua Mesopotamia pensaron algo mejor. Inscribieron símbolos en el recipiente que hacían una lista de las fichas que contenía. Si había dentro siete esferas, los contables dibujaban siete esferas en la arcilla húmeda de la vasija.

En algún momento los burócratas mesopotámicos se dieron cuenta de que, una vez que habían dibujado los símbolos en el exterior del recipiente, ya no necesitaban los contenidos, y ya no tenían que romper el recipiente para ver qué fichas había dentro.

Este paso obvio pero crucial dio lugar a un conjunto de símbolos numerales escritos, con diferentes formas para diferentes clases de bienes. Todos los demás símbolos numerales, incluidos los que hoy utilizamos, son los descendientes intelectuales de este antiguo artificio burocrático. De hecho, es posible que la sustitución de fichas por símbolos haya constituido también el nacimiento de la propia escritura.

§. Marcas de cuenta

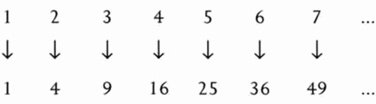

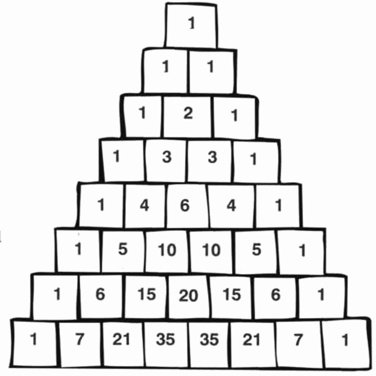

Estas marcas de arcilla no eran ni mucho menos los más antiguos ejemplos de escritura numeral, pero todos los ejemplos anteriores son poco más que rayas, «marcas de cuenta», que registran números como una serie de trazos, tales como

| | | | | | | | | | | | |

para representar el número 13. Las marcas más viejas conocidas de este tipo, 29 muescas grabadas en un hueso de pata de babuino, tienen unos 37.000 años. El hueso se encontró en una cueva en las montañas Lebombo, en la frontera entre Swazilandia y Sudáfrica, por lo que la cueva se conoce como la Cueva de la Frontera, y el hueso es el hueso de Lebombo. A falta de una máquina del tiempo, no hay modo de estar seguros de lo que representan las marcas, pero podemos hacer conjeturas informadas. Un mes lunar tiene 28 días, de modo es posible que las muescas estén relacionadas con las fases de la Luna.

Hay reliquias similares de la Europa antigua. Un hueso de lobo encontrado en la antigua Checoslovaquia tiene 57 marcas dispuestas en once grupos de cinco con dos sueltas, y tiene unos 30.000 años. Dos veces 28 es 56, de modo que esto podría ser un registro lunar de dos meses. Una vez más, parece que no hay modo de comprobar esta sugerencia. Pero las marcas parecen deliberadas, y debieron hacerse por alguna razón.

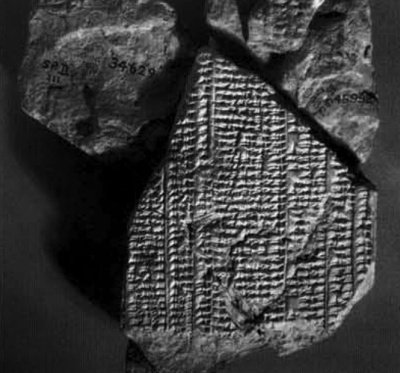

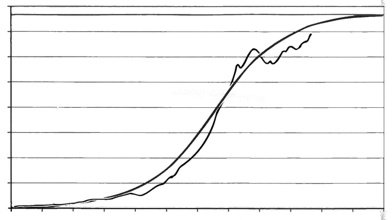

Otra antigua inscripción matemática, el hueso de Ishango en Zaire, tiene 25.000 años (estimaciones previas de 6.000-9.000 años fueron revisadas en 1995). A primera vista las marcas a lo largo del borde del hueso parecen hechas casi al azar, pero quizá haya pautas ocultas. Una fila contiene los números primos entre 10 y 20, a saber, 11, 13, 17 y 19, cuya suma es 60. Otra hilera contiene 9, 11, 19 y 21, que también suman 60. La tercera hilera recuerda un método utilizado a veces para multiplicar dos números por duplicación y por división por dos repetida. Sin embargo, las pautas aparentes pueden ser una simple coincidencia, y también se ha sugerido que el hueso de Ishango es un calendario lunar.

Las marcas de cuenta tienen la ventaja de que pueden irse añadiendo de una en una, durante largos periodos, sin alterar o borrar marcas anteriores. Se siguen utilizando hoy, a menudo en grupos de cinco con el quinto trazo cruzando diagonalmente los cuatro anteriores.

La presencia de marcas de cuenta es profunda, y aún puede verse en los numerales modernos. Nuestros símbolos 1, 2, 3 se derivan, respectivamente, de un solo trazo, dos trazos horizontales unidos por una línea inclinada, y tres trazos horizontales unidos por una línea inclinada.

§. Las marcas se convierten en numerales

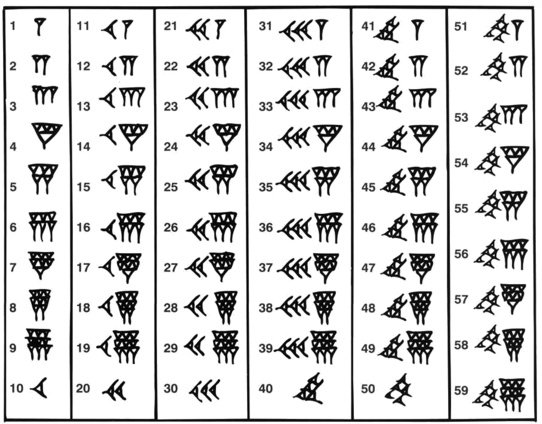

El camino histórico desde las fichas de los contables a los numerales modernos es largo e indirecto. Con el paso de los milenios, los pueblos de Mesopotamia desarrollaron la agricultura, y su forma de vida nómada dio paso a un asentamiento permanente en una serie de ciudades-estado: Babilonia, Erido, Lagash, Sumer, Ur. Los primitivos símbolos inscritos en tablillas de arcilla húmeda se transformaron en pictogramas -símbolos que representan palabras mediante imágenes simplificadas de lo que las palabras significan- y posteriormente los pictogramas se simplificaron y quedaron reducidos a un pequeño número de marcas con forma de cuña, que se imprimían en la arcilla utilizando un estilete seco con un extremo plano y afilado. Podían hacerse diferentes tipos de cuñas manejando el estilete de diferentes maneras. Hacia el 3.000 a.C. los sumerios habían desarrollado una elaborada forma de escritura, ahora llamada cuneiforme: «en forma de cuña».

La historia de este periodo es complicada; diferentes ciudades se hicieron dominantes en tiempos diferentes. La ciudad de Babilonia, en particular, alcanzó gran importancia, y aproximadamente un millón de tablillas de arcilla babilónicas han sido extraídas de las arenas mesopotámicas. Unos pocos cientos de ellas tratan de matemáticas y astronomía, y muestran que los babilonios tenían un amplio conocimiento de ambas disciplinas. En particular, eran astrónomos expertos y desarrollaron un simbolismo sistemático y sofisticado para los números con el que podían representar datos astronómicos con alta precisión.

Los símbolos numerales babilónicos van mucho más allá de un simple sistema de recuento, y son los más antiguos símbolos conocidos en hacerlo.

Se utilizan dos tipos diferentes de cuña: una cuña delgada y vertical para representar el numero 1, y una cuña gruesa horizontal para el número 10.

Estas cuñas se disponían en grupos para indicar los números 2-9 y 20-50.

Sin embargo, esta pauta se detiene en 59, y la cuña delgada toma entonces un segundo significado, el número 60.

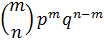

Se dice por ello que el sistema de numeración babilónico es de «base 60», o sexagesimal. Es decir, el valor de un símbolo puede ser un número, o 60 veces dicho número, o 60 veces 60 veces dicho número, dependiendo de la posición del símbolo. En esto es similar a nuestro familiar sistema decimal, en el que el valor de un símbolo se multiplica por 10, o por 100, o por 1.000, dependiendo de su posición. En el número 777, por ejemplo, el primer 7 significa «siete cientos», el segundo significa «setenta» y el tercero significa «siete».

Para un babilonio, una serie de tres repeticiones  del símbolo para «7» tendría un significado diferente, aunque basado en un principio similar. El primer símbolo significaría 7 × 60 × 60, o 25.200; el segundo significaría 7 × 60 = 420; el tercero significaría 7. Por lo tanto, el grupo de tres significaría 25.200 + 420 + 7, que es 25.627 en nuestra notación. Aún pueden encontrarse hoy reliquias de los números babilonios de base 60.

del símbolo para «7» tendría un significado diferente, aunque basado en un principio similar. El primer símbolo significaría 7 × 60 × 60, o 25.200; el segundo significaría 7 × 60 = 420; el tercero significaría 7. Por lo tanto, el grupo de tres significaría 25.200 + 420 + 7, que es 25.627 en nuestra notación. Aún pueden encontrarse hoy reliquias de los números babilonios de base 60.

Los 60 segundos en un minuto, 60 minutos en una hora y 360 grados en un círculo completo se remontan a la antigua Babilonia.

Símbolos babilónicos para los números 1-59

Puesto que es difícil escribir a máquina en cuneiforme, los estudiosos escriben los numerales babilónicos utilizando una mezcla de nuestra notación de base 10 y su notación de base 60. Así, las tres repeticiones del símbolo cuneiforme para 7 se escribirán como 7, 7, 7. Y algo como 23, 11, 14 indicará los símbolos babilónicos para 23, 11 y 14 escritos en orden, con el valor numérico (23 × 60 × 60) + (11 × 60) + 14, lo que da 83.474 en nuestra notación.

§. Los babilonios

Nosotros no sólo utilizamos diez símbolos para representar números arbitrariamente grandes: también utilizamos los mismos símbolos para representar números arbitrariamente pequeños. Para hacerlo empleamos la «coma decimal». Los dígitos a la izquierda de la coma representan números enteros; los que están a la derecha de la coma representan fracciones. Fracciones especiales son los múltiplos de una décima, una centésima y así sucesivamente. Por lo tanto 25,47, pongamos por caso, significa 2 decenas + 5 unidades + 4 décimas + 7 centésimas.

Los babilonios conocían este truco y lo utilizaron con un efecto extraordinario en sus observaciones astronómicas. Los estudiosos denotan al equivalente babilónico de la coma decimal por un punto y coma (;), pero ésta es una «coma sexagesimal» y los múltiplos a su derecha son múltiplos de 1/60, (1/60 × 1/60) = 1/3600 y así sucesivamente. Como ejemplo, la lista de números 12, 59; 57, 17 significa

12 × 60 + 59 + 57/60 + 17/3600

que es aproximadamente 779,955.

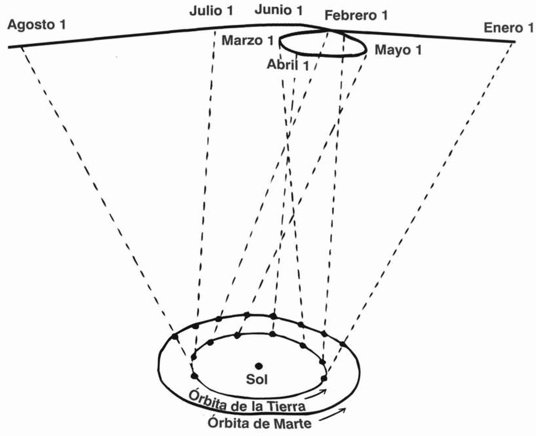

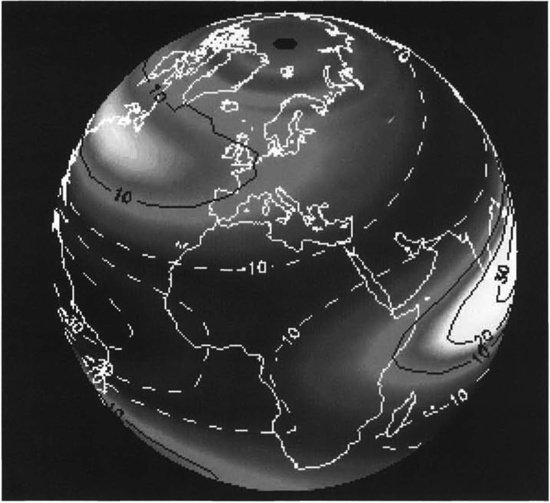

Se conocen casi 2.000 tablillas babilónicas con información astronómica, aunque muchas de éstas son pura rutina, consistentes en descripciones de maneras de predecir eclipses, tablas de sucesos astronómicos regulares y breves extractos. Unas 300 tablillas son más ambiciosas y más excitantes; tabulan observaciones del movimiento de Mercurio, Marte, Júpiter y Saturno, por ejemplo.

Por fascinante que pueda ser, la astronomía babilónica es algo tangencial a nuestra historia principal, que es la de las matemáticas «puras» babilónicas. Pero parece probable que la aplicación a la astronomía fuera un acicate para la búsqueda de las áreas más cerebrales de dicha disciplina. Por ello es justo reconocer cuán precisos eran los astrónomos babilonios cuando se trataba de observar sucesos celestes. Por ejemplo, encontraron que el periodo orbital de Marte (estrictamente, el tiempo transcurrido entre apariciones sucesivas en la misma posición en el cielo) era 12, 59; 57, 17 días en su notación, aproximadamente 779,955 días, como ya se ha señalado.

La cifra moderna es 779,936 días.

Para qué les servían los númerosLa tabla babilónica de Júpiter: Los babilonios utilizaban su sistema de numeración para el comercio y la contabilidad cotidiana, pero también lo utilizaban para un fin más sofisticado: la astronomía.

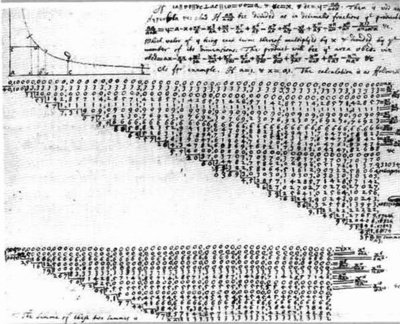

Tabla babilónica de JúpiterPara esto, la capacidad de su sistema para representar números fraccionarios con gran precisión era esencial. Varios centenares de tablillas registran datos planetarios. Entre ellas hay una única tablilla, muy dañada, que detalla el movimiento diario del planeta Júpiter durante un periodo de unos 400 días. Fue escrita en la misma Babilonia, alrededor del 163 a.C. Una entrada típica de la tablilla lista los números

126 8 16;

6, 46, 58

-0;0,45,18

-0;0,11,42

+0;0,0,10,

que corresponden a varias cantidades empleadas para calcular la posición del planeta en el cielo. Nótese que los números se escriben con tres lugares sexagesimales, ligeramente mejor que cinco cifras decimales.

§. Los antiguos egipcios

Quizá la más grande de las civilizaciones antiguas fue la de Egipto, que floreció en las orillas del Nilo y en el Delta del Nilo entre el 3150 a.C. y el 31 a.C., con un extenso periodo «predinástico» anterior que se extiende hacia atrás hasta el 6000 a.C. y un declive gradual bajo el dominio romano del 3 1 a.C. en adelante. Los egipcios eran constructores consumados, tenían un sistema muy desarrollado de creencias y ceremonias religiosas y eran registradores obsesivos. Pero sus logros matemáticos eran modestos comparados con las alturas alcanzadas por los babilonios.

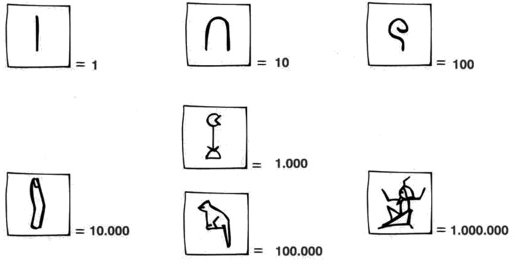

El antiguo sistema egipcio para escribir números naturales es muy simple y directo. Hay símbolos para los números 1, 10, 100, 1.000, y así sucesivamente. Repitiendo estos símbolos hasta nueve veces, y combinando luego los resultados, se puede representar cualquier número natural. Por ejemplo, para escribir el número 5.724 los egipcios agruparían cinco de sus símbolos para 1.000, siete símbolos para 100, dos símbolos para 10 y cuatro símbolos para 1.

Símbolos numerales egipcios

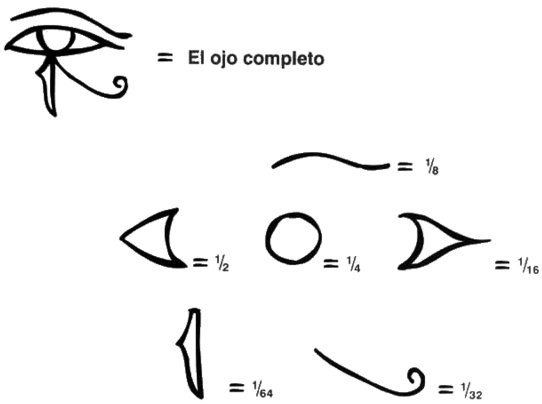

Las fracciones provocaban graves dolores de cabeza a los egipcios. En diversos períodos utilizaron varias notaciones diferentes para fracciones. En el Reino Antiguo (2.700-2.200 a.C.), una notación especial para nuestras fracciones ½, ¼, ⅛, 1/16, 1/32 y 1/64 se obtenía por división por dos repetida. Estos símbolos utilizaban partes del jeroglífico «ojo de Horus» u «ojo de la cobra».

El sistema egipcio más conocido para las fracciones fue ideado durante el Reino Medio (2.200-1.700 a.C.). Empieza con una notación para cualquier fracción de la forma 1 /n, donde n es un entero positivo. El símbolo  (el jeroglífico para la letra R) se escribe sobre los símbolos egipcios estándar para n. Por ejemplo, 1/n se escribe

(el jeroglífico para la letra R) se escribe sobre los símbolos egipcios estándar para n. Por ejemplo, 1/n se escribe . Las demás fracciones se expresan entonces añadiendo varias de estas «fracciones unidad». Por ejemplo,

. Las demás fracciones se expresan entonces añadiendo varias de estas «fracciones unidad». Por ejemplo,

5/6 = ½ + 1/3.

Es interesante que los egipcios no escribían 2/5 como 1/5 + 1/5. Parece que su regla era: utilizar fracciones unidad distintos. Había también notaciones diferentes para algunas de las fracciones más simples, tales como ½, ⅔ y ¾.

La notación egipcia para las fracciones era engorrosa y muy poco adecuada para el cálculo. Les servía bastante bien en los registros oficiales, pero fue casi completamente ignorada por las culturas posteriores.

El número 5724 en jeroglíficos egipcios

Fracciones especiales formadas con partes del ojo de la cobra

Símbolos especiales para fracciones especiales

§. Números y personas

Guste o no la aritmética, no se pueden negar los profundos efectos que han tenido los números en el desarrollo de la civilización humana. La evolución de la cultura y la de las matemáticas han ido de la mano durante los últimos cuatro milenios. Sería difícil desenredar causa y efecto; yo dudaría en argumentar que la innovación matemática impulsa el cambio cultural, o que las necesidades culturales determinan la dirección del progreso matemático. Pero ambas afirmaciones contienen algo de verdad, porque matemáticas y cultura evolucionan conjuntamente.

Hay, no obstante, una diferencia significativa. Los cambios culturales están muy «en la superficie». Los nuevos tipos de vivienda, las nuevas formas de transporte, incluso los nuevos modos de organizar las burocracias gubernamentales, son relativamente obvios para todo ciudadano. Las matemáticas, sin embargo, tienen lugar fundamentalmente entre bastidores. Cuando los babilonios utilizaban sus observaciones astronómicas para predecir eclipses solares, por ejemplo, el ciudadano medio quedaba impresionado por la precisión con que los sacerdotes predecían estos sucesos sorprendentes, incluso si la mayoría de los sacerdotes tenían poca o ninguna idea de los métodos empleados. Ellos sabían cómo leer tablillas que listaban datos de eclipses, pero lo que importaba era cómo utilizarlos. Cómo se habían construido era un arte arcano, que quedaba para los especialistas.

Algunos sacerdotes pueden haber tenido una buena educación matemática -todos los escribas instruidos la tenían, y los sacerdotes instruidos tomaban, en sus primeros años, prácticamente las mismas lecciones que los escribas-, pero una apreciación de las matemáticas no era realmente necesaria para disfrutar de los beneficios que surgían de los nuevos descubrimientos en la disciplina. Así ha sido siempre y, sin duda, así seguirá siendo. Los matemáticos apenas reciben crédito por cambiar nuestro mundo. ¿Cuántas veces vemos todo tipo de milagros modernos atribuidos a los «computadores», sin la más mínima apreciación de que los computadores sólo trabajan eficazmente si son programados para utilizar sofisticados «algoritmos» -procedimientos para resolver problemas- y que la base de todos los algoritmos está en las matemáticas?

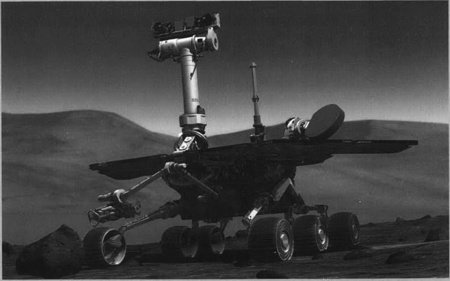

Las matemáticas más visibles son las relacionadas con la aritmética, pero la invención de las calculadoras de bolsillo, las cajas registradoras que suman cuánto hay que pagar, y los programas de pago de impuestos que nos hacen las cuentas, están ocultando cada vez más a la aritmética entre bastidores. Pese a todo, la mayoría de nosotros somos conscientes de que la aritmética está allí. Dependemos por completo de los números, ya sea para seguir las obligaciones legales, recaudar impuestos, comunicar instantáneamente con el otro lado del planeta, explorar la superficie de Marte o evaluar el último medicamento maravilloso. Todas estas cosas se remontan a la antigua Babilonia y a los escribas y maestros que descubrieron maneras eficaces de registrar números y calcular con ellos. Aquéllos utilizaban sus habilidades aritméticas con dos fines principales: asuntos cotidianos y mundanos de los seres humanos ordinarios, tales como la contabilidad y la medida de tierras, y actividades intelectuales como predecir eclipses o registrar los movimientos del planeta Júpiter a través del cielo nocturno.

La evolución de la cultura y la de las matemáticas han ido de la mano durante los últimos cuatro milenios.

Hoy hacemos lo mismo. Utilizamos matemáticas sencillas, poco más que aritmética, para centenares de tareas minúsculas: cuánto tratamiento antiparásitos poner en el estanque de un jardín, cuántos rollos de papel de pared tenemos que comprar para empapelar el dormitorio o si ahorraremos dinero yendo un poco más lejos en busca de gasolina más barata. Y nuestra cultura utiliza matemáticas sofisticadas para la ciencia, la tecnología y, cada vez más, también para el comercio. La invención de la notación numeral y la aritmética figuran, junto a las del lenguaje y la escritura, como unas de las innovaciones que nos transformaron de monos adiestrables en seres humanos genuinos.

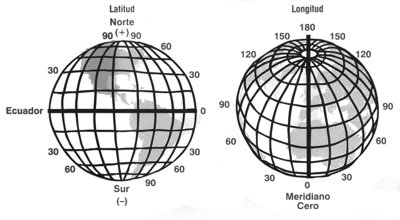

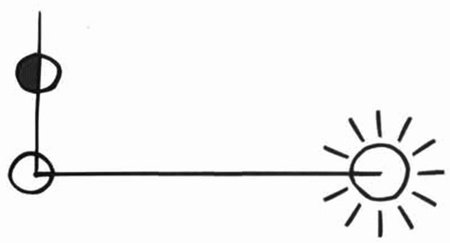

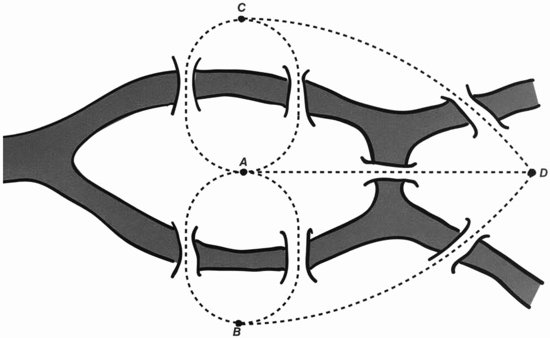

Para qué nos sirven los númerosLa mayoría de los modernos automóviles de gama alta están ahora equipados con navegación por satélite, y sistemas individuales de navegación por satélite pueden comprarse a un precio relativamente barato. Un pequeño dispositivo, acoplado a nuestro automóvil, nos dice dónde estamos exactamente en cualquier momento y nos presenta un mapa -a menudo con espectaculares gráficos en colores y con perspectivas- que muestra las carreteras vecinas. Un sistema de voz puede incluso decirnos por dónde ir para llegar a un destino especificado. Si esto suena como algo sacado de la ciencia ficción, lo es. Un componente esencial, que no es parte de la pequeña caja acoplada al automóvil, es el sistema de posicionamiento global (GPS), que comprende 24 satélites que orbitan alrededor de la Tierra (a veces más, cuando se lanzan los satélites de reemplazo). Estos satélites envían señales, y estas señales pueden utilizarse para deducir la posición del automóvil con un margen de unos pocos metros.

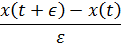

Las matemáticas entran en juego en muchos aspectos de la red GPS, pero aquí mencionamos sólo uno: cómo se utilizan las señales para calcular la posición del automóvil.

Las señales de radio viajan a la velocidad de la luz, que es aproximadamente 300.000 kilómetros por segundo. Un computador a bordo del automóvil -un chip en la caja que compramos- puede calcular la distancia del automóvil a cualquier satélite dado si conoce cuánto ha tardado la señal en viajar desde el satélite al automóvil.

Este tiempo es normalmente del orden de una décima de segundo, pero ahora es fácil medirlo de forma precisa. El truco consiste en estructurar la señal de modo que contenga información sobre el tiempo.

En efecto, el satélite y el receptor en el automóvil cantan una misma canción, y comparan su compás. Las «notas» procedentes del satélite irán ligeramente retrasadas respecto a las producidas en el automóvil. En esta analogía, las letras podrían ir así:

Automóvil… una paloma, trátala con cariño que es...

Satélite…si a tu ventana llega una paloma...

Aquí la canción del satélite va unas tres palabras detrás de la misma canción en el automóvil. Satélite y receptor deben generar la misma «canción», y «notas» sucesivas deben ser identificables, de modo que la diferencia de tiempo es fácil de observar.

Por supuesto, el sistema de navegación por satélite no utiliza realmente una canción. La señal consiste en una serie de pulsos breves cuya duración está determinada por un «código pseudo- aleatorio». Éste consiste en una secuencia de números que parece aleatoria pero que realmente está basada en una regla matemática. Tanto el satélite como el receptor conocen la regla, de modo que pueden generar la misma secuencia de pulsos.

Capítulo 2

La lógica de la forma

Los primeros pasos en geometría

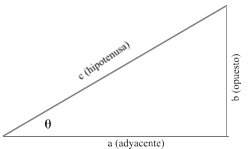

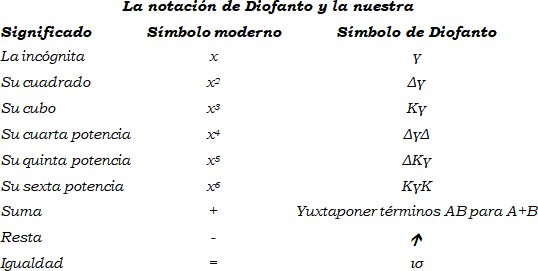

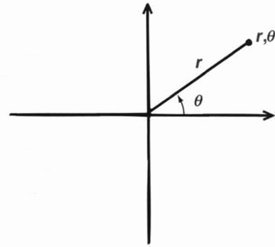

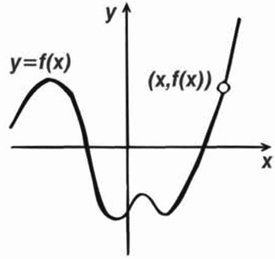

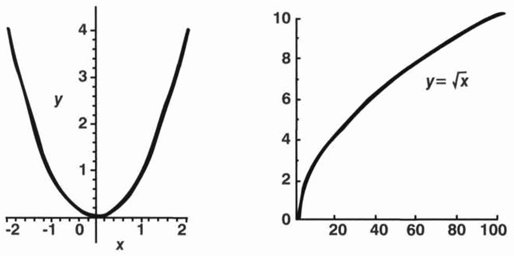

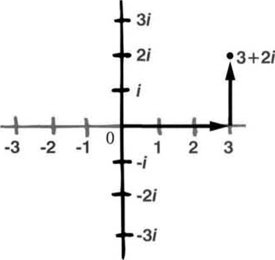

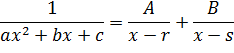

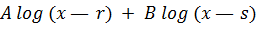

En matemáticas hay dos tipos principales de razonamiento: el simbólico y el visual. El razonamiento simbólico tuvo su origen en la notación numeral, y pronto veremos cómo llevó a la invención del álgebra, en cuyos símbolos pueden representarse números abstractos («la incógnita») antes que concretos («7»).

A partir de la Edad Media las matemáticas se basaron cada vez más en el uso de símbolos, como confirmará una ojeada a cualquier libro de texto moderno de matemáticas.

Los comienzos de la geometría

Además de símbolos, los matemáticos usan diagramas, lo que abre varios tipos de razonamiento visual. Las imágenes son menos formales que los símbolos, y por esta razón su uso ha sido mal visto a veces. Hay una sensación ampliamente extendida de que una imagen es de algún modo menos rigurosa, lógicamente hablando, que un cálculo simbólico. Es cierto que las imágenes dejan más lugar para diferencias de interpretación que los símbolos. Además, las imágenes pueden contener hipótesis ocultas: no podemos dibujar un triángulo «general»; cualquier triángulo que dibujemos tendrá un tamaño y una forma particulares, que quizá no sean representativos de un triángulo arbitrario. Sin embargo, la intuición visual es una característica tan poderosa del cerebro humano que las imágenes desempeñan un papel destacado en matemáticas. De hecho, después del número, introducen un segundo concepto importante en la disciplina: la forma.

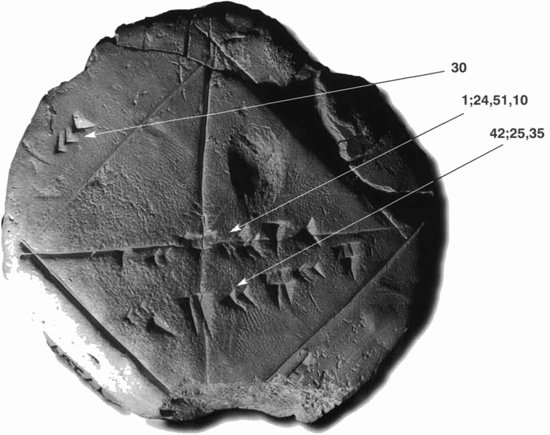

La fascinación de los matemáticos por las formas se remonta a muy atrás. Existen diagramas en las tablillas de arcilla babilónicas. Por ejemplo, la tablilla catalogada como YBC 7289 muestra un cuadrado y dos diagonales. Los lados del cuadrado están marcados con numerales cuneiformes para 30.

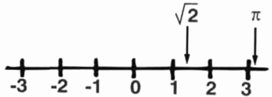

Sobre una diagonal está marcado 1;24,51,10 y debajo de ella 42;25,35, que es su producto por 30 y, por lo tanto, la longitud de dicha diagonal. De modo que 1; 24,5 1,10 es la longitud de la diagonal de un cuadrado más pequeño, con lados unidad. El teorema de Pitágoras nos dice que esta diagonal es la raíz cuadrada de 2, que escribimos √2. La aproximación 1; 24, 51, 10 para √2 es muy buena.

Tablilla YBC 7269 y sus numerales cuneiformes

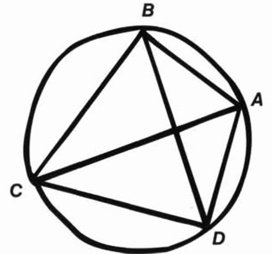

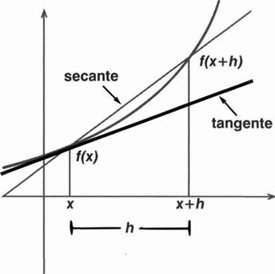

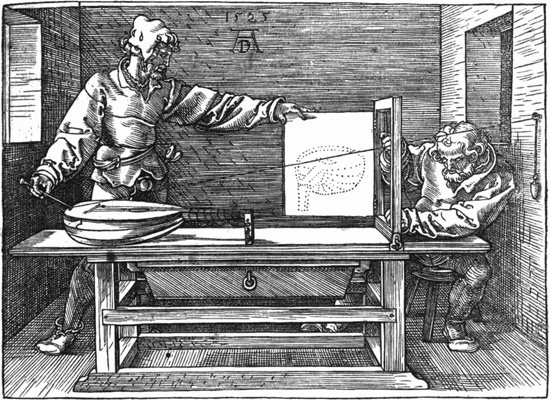

El primer uso sistemático de diagramas, junto con un uso limitado de símbolos y una fuerte dosis de lógica, se da en los escritos geométricos de Euclides de Alejandría. La obra de Euclides seguía una tradición que se remontaba al menos al culto pitagórico, que floreció alrededor del 500 a.C., pero Euclides insistía en que cualquier enunciado matemático debe tener una demostración lógica antes de que pueda asumirse como verdadero. Por ello los escritos de Euclides combinan dos innovaciones distintas: el uso de figuras y la estructura lógica de las demostraciones. Durante siglos la palabra «geometría» estuvo estrechamente asociada con ambas.

En este capítulo vamos a seguir la historia de la geometría desde Pitágoras, pasando por Euclides y su precursor Eudoxo, hasta el periodo final de la Grecia clásica y los sucesores de Euclides, Arquímedes y Apolonio. Estos primeros geómetras prepararon el camino para todo el trabajo posterior sobre pensamiento visual en matemáticas. También fijaron cánones de demostración lógica que no fueron superados durante milenios.

§. Pitágoras

Hoy casi damos por supuesto que las matemáticas ofrecen una clave para las leyes subyacentes en la Naturaleza. La primera reflexión sistemática en esta línea de la que hay noticia procede de los pitagóricos, un culto más bien místico que data aproximadamente del 600 a.C. al 400 a.C. Su fundador, Pitágoras, nació en Samos alrededor del 569 a.C. Cuándo y dónde murió es un misterio, pero en el 460 a.C. el culto que él fundó fue atacado y destruido, y sus lugares de reunión asaltados y quemados. En uno de ellos, la casa de Milón de Crotona, fueron masacrados más de cincuenta pitagóricos.

Muchos supervivientes huyeron a Tebas en el Alto Egipto. Posiblemente Pitágoras era uno de ellos, pero incluso esto es una conjetura pues, leyendas aparte, no sabemos prácticamente nada sobre Pitágoras. Su nombre es bien conocido, básicamente debido a su famoso teorema sobre triángulos rectángulos, pero ni siquiera sabemos si Pitágoras lo demostró.

Sabemos mucho más sobre la filosofía y las creencias de los pitagóricos. Entendían que las matemáticas tratan con conceptos abstractos, no con la realidad. Sin embargo, creían también que estas abstracciones estaban encarnadas de algún modo en conceptos «ideales», que existían en algún reino extraño de la imaginación, de modo que, por ejemplo, un círculo dibujado en la arena con un palo es un intento fallido de un círculo ideal, perfectamente redondo e infinitamente fino.

El aspecto más influyente de la filosofía del culto pitagórico es la creencia en que el universo se funda en los números.

Expresaban esta creencia en simbolismo mitológico y la apoyaban con observaciones empíricas. Por el lado místico, consideraban que el número I es la fuente primaria de todas las cosas en el universo.

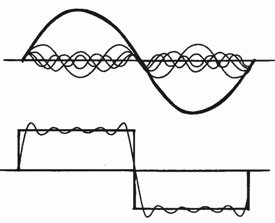

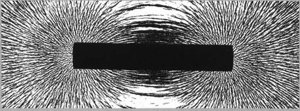

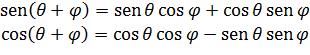

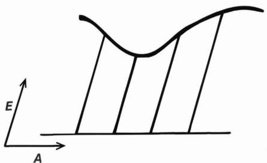

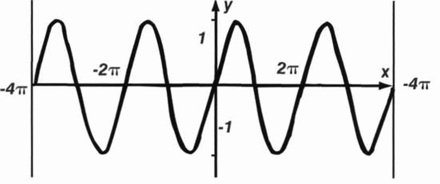

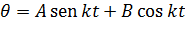

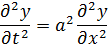

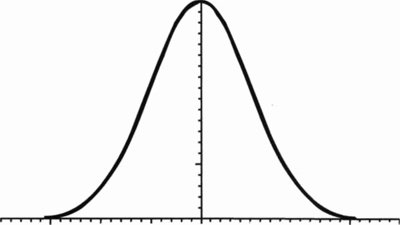

La armonía del mundoEl principal apoyo empírico para el concepto pitagórico del universo numérico procedía de la música, en donde habían advertido algunas notables relaciones entre sonidos armónicos y razones numéricas simples. Utilizando experimentos sencillos, ellos descubrieron que si una cuerda pulsada produce una nota de un tono particular, entonces una cuerda de longitud mitad produce una nota extraordinariamente armoniosa, ahora llamada la octava. Una cuerda de una longitud dos tercios produce la siguiente nota más armoniosa, y una de tres cuartos de longitud también produce una nota armoniosa.

Hoy estos aspectos numéricos de la música se remiten a la física de las cuerdas vibrantes, que se mueven en pautas ondulatorias. El número de ondas que pueden encajar en una longitud dada de cuerda es un número entero, y estos números enteros determinan las razones numéricas simples. Si los números no forman una razón simple, entonces las ilotas correspondientes interfieren, produciendo «batidos» discordantes que son desagradables al oído. La historia completa es más compleja, e incluye aquello a lo que el cerebro está acostumbrado, pero hay un argumento físico preciso tras el descubrimiento pitagórico.

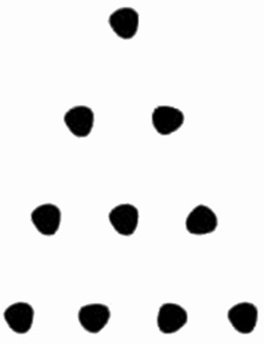

Los números 2 y 3 simbolizaban los principios femenino y masculino. El número 4 simbolizaba la armonía, y también los cuatro elementos (Tierra, Aire, Fuego, Agua) a partir de los cuales está hecho todo. Los pitagóricos creían que el número 10 tenía profunda trascendencia mística, porque 10 = 1 + 2 + 3 + 4, que combina la unidad primaria, el principio femenino, el principio masculino y los cuatro elementos. Además, estos números formaban un triángulo, y la totalidad de la geometría griega se basaba en propiedades de los triángulos.

Los pitagóricos reconocían la existencia de nueve cuerpos celestes: el Sol, la Luna, Mercurio, Venus, la Tierra, Marte, Júpiter y Saturno, más el Fuego Central, que era diferente del Sol. Tan importante era el número 10 en su visión de la cosmología que creían que había un décimo cuerpo, la Anti-Tierra, perpetuamente oculto a nosotros tras el Sol.

El número diez forma un triángulo

Como hemos visto, los números 1, 2, 3,..., llevaban de manera natural a un segundo tipo de número, las «fracciones», que los matemáticos llaman números racionales. Un número racional es una fracción a/b donde a, b son números naturales (y b es distinto de 0; de lo contrario, la fracción no tiene sentido). Las fracciones subdividen a los números naturales en partes arbitrariamente finas, de modo que en particular la longitud de una línea en una figura geométrica puede aproximarse tanto como queramos por un número racional. Parece natural imaginar que con suficientes subdivisiones se llegaría al número exactamente; si fuera así, todas las longitudes serían racionales.

Si esto fuera cierto, haría la geometría mucho más sencilla, porque dos longitudes cualesquiera serían múltiplos enteros de una longitud común (quizá pequeña), y por ello podrían obtenerse empalmando montones de copias de esta longitud común. Esto quizá no suena muy importante, pero con ello toda la teoría de longitudes, áreas y especialmente figuras «semejantes» -figuras con la misma forma pero diferentes tamaños- sería mucho más sencilla. Todo podría demostrarse utilizando diagramas formados a partir de muchos montones de copias de una forma básica.

Por desgracia, este sueño no puede realizarse. Según la leyenda, uno de los seguidores de Pitágoras, Hipaso de Metaponto, descubrió que este enunciado es falso. En concreto, demostró que la diagonal de un cuadrado unidad es irracional: no es una fracción exacta. Se dice (con base dudosa, pero es una buena historia) que cometió el error de anunciar este hecho cuando los pitagóricos estaban cruzando el Mediterráneo en barco, y sus compañeros de culto quedaron tan irritados que le arrojaron por la borda y se ahogó.

Lo más probable es que simplemente fuera expulsado del culto. Cualquiera que fuera su castigo, parece que a los pitagóricos no les gustó su descubrimiento.

La interpretación moderna de la observación de Hipaso es que √2 es irracional. Para los pitagóricos, este hecho brutal era un duro golpe para su creencia casi religiosa en que el universo estaba enraizado en los números (por lo que ellos entendían los números naturales). Las fracciones -razones de números enteros- encajaban muy bien en esta visión del mundo, pero los números que demostrablemente no eran fracciones no lo hacían. Y por ello, ya fuera ahogado o expulsado, el pobre Hipaso se convirtió en una de las primeras víctimas de la irracionalidad, por así decir, de las creencias religiosas.

Estas dos formas son semejantes

§. Irracionales

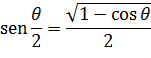

Finalmente los griegos encontraron una manera de manejar los irracionales. Funciona porque cualquier número irracional puede ser aproximado por un número racional. Cuanto mejor es la aproximación, más complicado se hace dicho racional, y siempre hay algún error. Pero haciendo el error cada vez menor, hay una posibilidad de aproximar las propiedades de los irracionales explotando propiedades análogas a las de los números racionales que los aproximan. El problema está en establecer esta idea de una forma que sea compatible con la aproximación griega a la geometría y la demostración. Esto resulta ser factible, pero complicado.

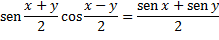

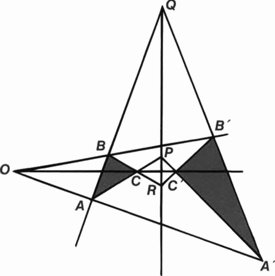

¿Es la razón a:b igual a la razón c:d?

La teoría griega de los irracionales fue concebida por Eudoxo alrededor del 370 a.C. Su idea consiste en representar cualquier magnitud, racional o irracional, como la razón de dos longitudes; es decir, en términos de un par de longitudes. Así, dos-tercios se representa por dos líneas, una de longitud dos y otra de longitud tres (una razón 2:3). Análogamente, √2 se representa por el par formado por la diagonal de un cuadrado unidad y su lado (una razón √2:1). Nótese que ambos pares de líneas pueden construirse geométricamente.

El punto clave consiste en definir cuándo dos de estas razones son iguales.

La teoría griega de los irracionales fue concebida por Eudoxo alrededor del 370 a.C.

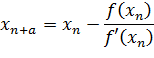

¿Cuándo es a:b = c:d? A falta de un sistema de números apropiado, los griegos no podían hacerlo dividiendo una longitud por otra y comparando a + b con c + d. En su lugar, Eudoxo encontró un engorroso pero preciso método de comparación que podía realizarse dentro de las convenciones de la geometría griega. La idea consiste en tratar de comparar a y c formando múltiplos enteros ma y nc. Esto puede hacerse empalmando m copias de a extremo con extremo, y lo mismo con n copias de b. Utilizamos los mismos dos múltiplos m y n para comparar mb y nd. Si las razones a:b y c:d no son iguales, dice Eudoxo, entonces podemos encontrar m y n para exagerar la diferencia a tal extremo que ma > nc pero mb < nd. De hecho, podemos definir la igualdad de razones de esta manera.

Esta definición requiere acostumbrarse. Está hecha muy cuidadosamente a medida de las limitadas operaciones permitidas en la geometría griega.

Sin embargo funciona; permitió a los geómetras griegos tomar teoremas que podían ser demostrados fácilmente para razones racionales y extenderlos a razones irracionales.

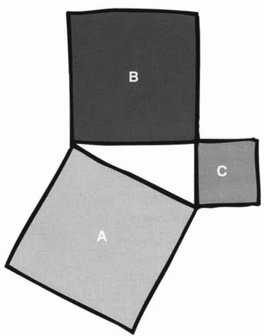

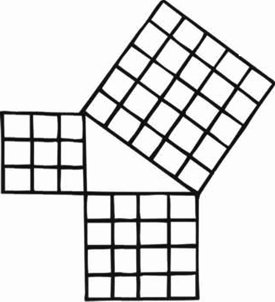

Teorema de Pitágoras: si el triángulo tiene un ángulo recto, entonces el área del cuadrado más grande, A, es la misma que la de los otros dos, B y C. juntos

A menudo utilizaban un método llamado «exhaustion», que les permitía demostrar teoremas que nosotros demostraríamos actualmente utilizando la idea de «límite» y el cálculo infinitesimal. De esta manera demostraron que el área de un círculo es proporcional al cuadrado de su radio. La demostración parte de un hecho más simple, que se encuentra en Euclides: las áreas de dos polígonos semejantes están en la misma proporción que los cuadrados de los lados correspondientes.

El círculo plantea nuevos problemas porque no es un polígono. Por ello, los griegos consideraron dos secuencias de polígonos: una dentro del círculo, y la otra fuera. Ambas secuencias se acercan cada vez más al círculo, y la definición de Eudoxo implica que la razón de las áreas de los polígonos aproximantes es la misma que la razón de las áreas de los círculos.

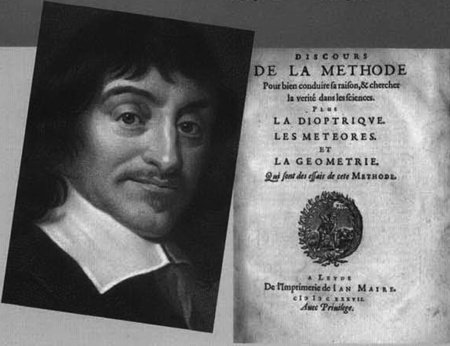

§. Euclides

El geómetra griego más conocido, aunque probablemente no el matemático más original, es Euclides de Alejandría. Euclides fue un gran sintetizador, y su texto de geometría, los Elementos, se convirtió en un éxito de ventas perenne. Euclides escribió al menos diez textos sobre matemáticas, pero sólo cinco de ellos sobreviven; todos a través de copias posteriores, y diez sólo en parte. No tenemos documentos originales de la antigua Grecia. Los cinco supervivientes euclidianos son los Elementos, la División de figuras, los Datos, los Fenómenos y la Óptica.

Los Elementos es la obra maestra geométrica de Euclides, y ofrece un tratamiento definitivo de la geometría de dos dimensiones (el plano) y tres dimensiones (el espacio). La División de figuras y los Datos contienen varios complementos y comentarios sobre geometría. Los Fenómenos están dirigidos a los astrónomos, y tratan de la «geometría esférica», la geometría de figuras dibujadas en la superficie de una esfera. La Óptica es también geométrica, y podría considerarse mejor como una incipiente investigación de la geometría de la perspectiva: cómo transforma el ojo humano una escena tridimensional en una imagen bidimensional.

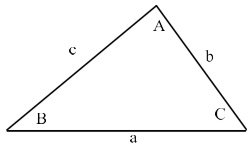

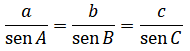

Quizá la mejor manera de pensar en la obra de Euclides es como un examen de la lógica de las relaciones espaciales. Si una forma tiene ciertas propiedades, éstas pueden implicar lógicamente otras propiedades. Por ejemplo, si un triángulo tiene los tres lados iguales -un «triángulo equilátero»-, entonces los tres ángulos deben ser iguales. Este tipo de enunciado, que lista algunas hipótesis y luego afirma sus consecuencias lógicas, se denomina un «teorema». Este teorema concreto relaciona una propiedad de los lados de un triángulo con una propiedad de sus ángulos. Un ejemplo menos intuitivo y más famoso es el teorema de Pitágoras.

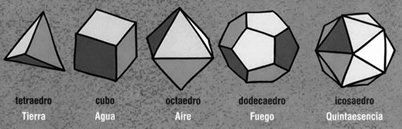

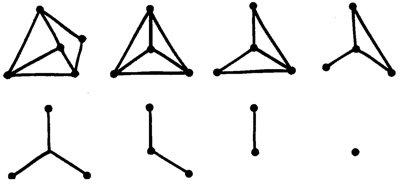

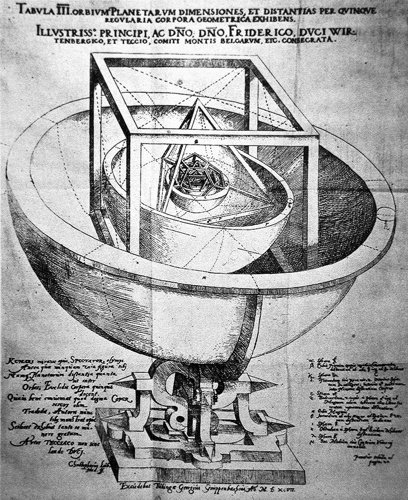

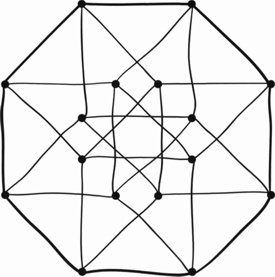

Poliedros regularesUn sólido es regular (o platónico) si está formado por caras idénticas. Los pitagóricos conocían cinco sólidos de este tipo

El tetraedro, formado a partir de cuatro triángulos equiláteros.

El cubo (o hexaedro), formado a partir de seis cuadrados.

El octaedro, formado a partir de ocho triángulos equiláteros.

El dodecaedro, formado a partir de 12 pentágonos regulares.

El icosaedro, formado a partir de 20 triángulos equiláteros.

Los Elementos se dividen en 13 libros, que se siguen unos a otros en una secuencia lógica. Analizan la geometría del plano y algunos aspectos de la geometría del espacio. El punto culminante es la demostración de que hay exactamente cinco sólidos regulares: el tetraedro, el cubo, el octaedro, el dodecaedro y el icosaedro. Las formas básicas permitidas en geometría plana son líneas rectas y círculos, a veces en combinación; por ejemplo, un triángulo está formado por tres líneas rectas. En geometría espacial encontramos también planos, cilindros y esferas.

Ellos los asociaron con los cuatro «elementos» de la antigüedad -tierra, aire, fuego y agua- y con un «quinto elemento», la quintaesencia.

Para los matemáticos modernos lo más interesante en la geometría de Euclides no es su contenido, sino su estructura lógica. A diferencia de sus predecesores, Euclides no se limita a afirmar que un teorema es verdadero.

El ofrece una demostración.

¿Qué es una demostración? Es una especie de historia matemática, en la que cada paso es una consecuencia lógica de algunos de los pasos previos. Cada enunciado que se afirma tiene que justificarse haciendo referencia a enunciados previos y demostrando que es una consecuencia lógica de ellos. Euclides comprendió que este proceso no puede llevarse hacia atrás indefinidamente: tiene que empezar en alguna parte, y estos enunciados iniciales no pueden ser demostrados, o de lo contrario el proceso de demostración empieza realmente en algún lugar diferente.

Para empezar a rodar, Euclides hizo una lista de varias definiciones: enunciados claros y precisos de lo que significan ciertos términos técnicos, tales como «línea» o «círculo».

Euclides de Alejandría

325 - 265 a. C.Euclides es famoso por su libro de geometría, Los Elementos, que fue un importante, de hecho el principal, texto de enseñanza de la geometría durante dos milenios.

Sabemos muy poco de la vida de Euclides. Enseñó en Alejandría. Alrededor del 450 a.C. el filósofo griego Proclo escribió:

«Euclides... vivió en la época del primer Ptolomeo, pues Arquímedes, que siguió de cerca al primer Ptolomeo, menciona a Euclides... Ptolomeo preguntó en cierta ocasión [a Euclides] si había un camino más corto para estudiar geometría que los Elementos, a lo que éste contestó que no había ningún camino real a la geometría. Por lo tanto era más Joven que el circulo de Platón, pero más viejo que Eratóstenes y Arquímedes... era un platónico, pues simpatizaba con su filosofía, e hizo de la construcción de las denominadas figuras platónicas ¡sólidos regulares] el objetivo de los Elementos».

Una definición típica es «un ángulo obtuso es un ángulo mayor que un ángulo recto». La definición le proporcionaba la terminología que necesitaba para enunciar sus hipótesis indemostradas, que clasificaba en dos tipos: nociones comunes y postulados. Una típica noción común es «cosas que son iguales a la misma cosa son iguales entre sí». Un postulado típico es «todos los ángulos rectos son iguales entre sí».

Hoy día agrupamos ambos tipos y les llamamos axiomas. Los axiomas de un sistema matemático son las hipótesis subyacentes que hacemos sobre el mismo. Consideramos los axiomas como las reglas del juego, e insistimos en que se juegue de acuerdo con las reglas. Ya no preguntamos si las reglas son «verdaderas», ya no pensamos que sólo pueda jugarse a un juego. Alguien que quiera jugar a este juego concreto debe aceptar las reglas; si no lo hace, es libre de jugar a un juego diferente, pero no será el juego determinado por estas reglas concretas.

En los días de Euclides, y durante los casi los 2.000 años siguientes, los matemáticos no pensaban así ni mucho menos. En general veían los axiomas como «verdades autoevidentes», tan obvias que nadie podía cuestionarlas seriamente. Por ello Euclides hizo todo lo que pudo para hacer todos sus axiomas obvios... y estuvo muy cerca de conseguirlo. Pero un axioma, el «axioma de las paralelas», es inusualmente complicado y poco intuitivo, y muchos trataron de deducirlo de hipótesis más sencillas. Más tarde veremos a qué notables descubrimientos llevó esto.

Paso a paso, a partir de estos comienzos simples, los Elementos continúan ofreciendo demostraciones de teoremas geométricos cada vez más sofisticados. Por ejemplo, la Proposición 5 del Libro I demuestra que los ángulos en la base de un triángulo isósceles (un triángulo con dos lados iguales) son iguales.

Este teorema fue conocido por generaciones de escolares Victorianos como el «pons asinorum» o puente para asnos: el diagrama se parece a un puente, y era el primer obstáculo serio para los estudiantes que trataban de aprender la asignatura de memoria en lugar de entenderla. La Proposición 32 del Libro I demuestra que los ángulos de un triángulo suman 180º. La Proposición 47 del Libro I es el Teorema de Pitágoras.

Euclides deducía cada teorema de teoremas previos y varios axiomas. Construyó una torre lógica, que subía cada vez más hacia el cielo, con los axiomas como cimientos y la deducción lógica como el mortero que unía los ladrillos.

Hoy nos sentimos menos satisfechos con la lógica de Euclides porque tiene muchas lagunas. Euclides da muchas cosas por supuestas; su lista de axiomas está lejos de ser completa. Por ejemplo, puede parecer obvio que si una recta pasa por un punto dentro de un círculo, entonces debe cortar al círculo en alguna parte, al menos si se prolonga lo suficiente. Ciertamente parece obvio si se dibuja una imagen, pero hay ejemplos que demuestran que no se sigue de los axiomas de Euclides. Euclides lo hizo bastante bien, pero supuso que propiedades aparentemente obvias de los diagramas no necesitaban una demostración ni una base axiomática.

Esta omisión es más seria de lo que podría parecer. Hay algunos ejemplos famosos de razonamiento falaz que surgen de errores sutiles en las figuras.

Uno de ellos «demuestra» que todo triángulo tiene dos lados iguales.

§. ¿Jerigonza?

El Libro V de los Elementos va en una dirección muy diferente, y más bien oscura, de la de los Libros I-IY No parece geometría convencional. De hecho, a primera vista se lee básicamente como una jerigonza. ¿Qué tenemos que hacer, por ejemplo, con la Proposición I del Libro V? Dice: si ciertas magnitudes son equimúltiplos de otras magnitudes, entonces si cualquier múltiplo de una de las magnitudes lo es una de las otras, dicho múltiplo también lo será de todas.

El lenguaje (que he simplificado un poco) no ayuda, pero la demostración aclara lo que Euclides pretendía. El matemático inglés del siglo XIX Augustus de Morgan explicaba la idea en lenguaje simple en su libro de texto de geometría: «Diez pies y diez pulgadas son diez veces tanto como un pie y una pulgada».

¿Qué quiere Euclides aquí? ¿Son trivialidades vestidas como teoremas?

“¿Son trivialidades vestidas como teoremas? En absoluto.”

¿Son sinsentidos místicos? En absoluto. Este material puede parecer oscuro, pero nos lleva a la parte más profunda de los Elementos: las técnicas de Eudoxo para tratar razones irracionales. Hoy día los matemáticos prefieren trabajar con números, y puesto que éstos son más familiares, interpretaré a menudo las ideas griegas en dicho lenguaje.

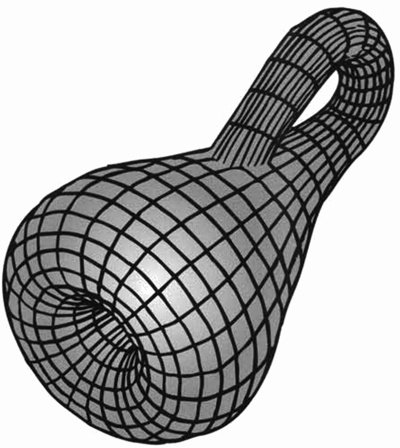

Euclides no podía evitar enfrentarse a las dificultades de los números irracionales, porque el clímax de los Elementos -y para muchos su principal objetivo- era la demostración de que existen exactamente cinco sólidos regulares: el tetraedro, el cubo (o hexaedro), el octaedro, el dodecaedro y el icosaedro. Euclides demostró dos cosas: no hay otros sólidos regulares, y estos cinco existen realmente, pueden construirse geométricamente y sus caras encajan perfectamente, sin el más mínimo error.

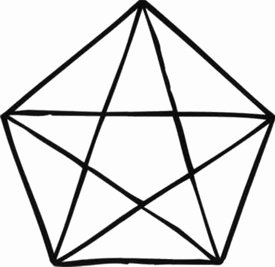

Dos de los sólidos regulares, el dodecaedro y el icosaedro, incluyen al pentágono regular: el dodecaedro tiene caras pentagonales, y las cinco caras del icosaedro que rodean a cualquier vértice determinan un pentágono.

Los pentágonos regulares están directamente relacionados con lo que Euclides llamaba «razón extrema y media».

La razón entre las diagonales y los lados es áurea

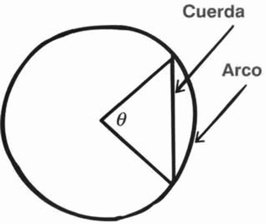

Sobre una línea recta AB, se construye un punto C de modo que la razón AB : AC es igual a AC : BC. Es decir, la línea entera guarda la misma proporción con el segmento más grande que el segmento más grande guarda con el más pequeño. Si dibujamos un pentágono e inscribimos una estrella de cinco puntas, los lados de la estrella están relacionados con los lados del pentágono por esta razón particular.

Hoy día llamamos a esta razón el número áureo. Es igual a 1 + (√5/2), y este número es irracional. Su valor numérico es aproximadamente 1,618. Los griegos pudieron demostrar que era irracional explotando la geometría del pentágono. Por ello Euclides y sus predecesores eran conscientes de que, para tener una comprensión adecuada del dodecaedro y el icosaedro, debían entender los irracionales.

Esta es, al menos, la visión convencional de los Elementos.

David Fowler argumenta en su libro Las matemáticas de la Academia de Platón que hay una visión alternativa: en esencia, la inversa. Tal vez el objetivo principal de Euclides era la teoría de los irracionales, y los sólidos regulares eran tan sólo una aplicación.

Razón extrema y media (ahora llamada razón áurea). La razón entre la línea superior y la del centro es igual a la razón entre la línea central y la inferior

La evidencia puede interpretarse de una forma u otra, pero una característica de los elementos encaja mejor en esta teoría alternativa. Buena parte del material sobre «teoría de números» no es necesario para la clasificación de los sólidos regulares; entonces, ¿por qué Euclides incluyó este material?

Pi con enorme precisiónEl valor de π ha sido calculado ahora con varios miles de millones de cifras decimales, utilizando métodos más sofisticados. Tales cálculos son de interés por sus métodos, para poner a prueba sistemas de computación, y por pura curiosidad, pero el resultado mismo tiene poca importancia. Las aplicaciones prácticas de n no requieren, en general, más de cinco o seis cifras. El récord actual es 51.539.600.000 cifras decimales, calculadas por Yasumasa Kanada y Daisuke Takahashi. Ellos realizaron dos cálculos independientes utilizando dos métodos diferentes, para obtener 51.539.607.552 cifras de n. Los resultados coincidían en los primeros 51.539.607.510 cifras, por lo que redujeron la proclamación de su récord a 51.539.600.000 cifras exactas.

Sin embargo, el mismo material está estrechamente relacionado con los números irracionales, lo que podría explicar por qué fue incluido.

§. Arquímedes

El más grande de los matemáticos antiguos fue Arquímedes. Hizo importantes contribuciones a la geometría, estuvo en la vanguardia de las aplicaciones de las matemáticas al mundo natural y fue un ingeniero consumado.

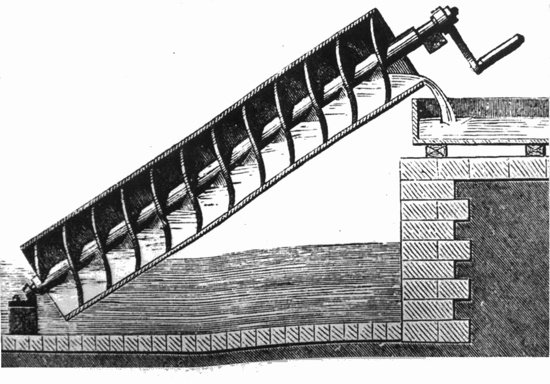

Arquímedes de Siracusa

287 - 212 a.C.Arquímedes nació en Siracusa, en la Magna Grecia (la actual Sicilia), hijo del astrónomo Fidias. Visitó Egipto, donde supuestamente inventó el tornillo de Arquímedes, que hasta hace muy poco era ampliamente utilizado para elevar agua del Nilo para irrigación. Es probable que visitara a Euclides en Alejandría, y seguro que mantuvo correspondencia con matemáticos alejandrinos.

Sus habilidades matemáticas fueron insuperables y de amplio alcance. Les dio un uso práctico y construyó enormes máquinas de guerra basadas en su ley de la palanca, capaces de lanzar rocas enormes contra el enemigo. Sus máquinas fueron utilizadas con gran efecto en el sitio romano de Alejandría en el 212 a.C. Utilizó incluso la geometría de la reflexión óptica para concentrar los rayos solares sobre una flota romana invasora e incendiar las naves.

Sus libros conservados (sólo en copias posteriores) son Sobre equilibrios en el plano, la Cuadratura de la parábola, Sobre la esfera y el cilindro, Sobre los cuerpos flotantes, Medida del círculo y El arenario, junto con El método, descubierto en 1906 por Johan Heiberg.

Pero para los matemáticos, Arquímedes será siempre recordado por su obra sobre círculos, esferas y cilindros, que ahora asociamos con el número π («pi»), que es aproximadamente 3,14159. Por supuesto, los griegos no trabajaban directamente con n: ellos lo veían geométricamente como la razón entre la circunferencia de un círculo y su diámetro.

Culturas anteriores habían advertido que la circunferencia de un círculo es siempre el mismo múltiplo de su diámetro, y sabían que este múltiplo era aproximadamente 3 1/7, quizá un poco mayor. Los babilonios utilizaban 3 ⅛. Pero Arquímedes fue mucho más lejos; sus resultados iban acompañados de demostraciones rigurosas, en el espíritu de Eudoxo. Hasta donde sabían los griegos, la razón entre la circunferencia de un círculo y su diámetro podría ser irracional. Ahora sabemos que realmente es así, pero la demostración tuvo que esperar hasta 1770, cuando Johann Heinrich ideó una. (El valor que se da a veces en la escuela, 3 1/7, es conveniente aunque sólo aproximado.) Sea como fuere, puesto que Arquímedes no pudo demostrar que π es racional, tuvo que suponer que podría no serlo.

Tornillo de Arquímedes

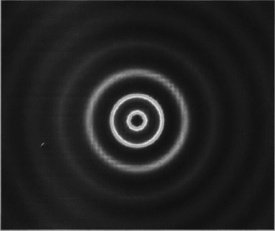

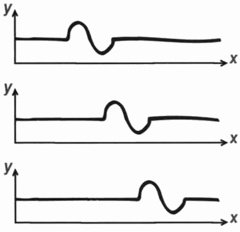

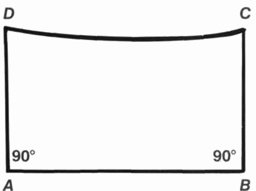

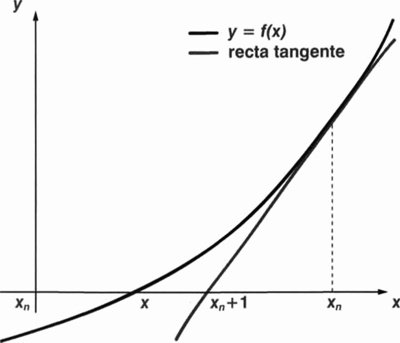

La geometría griega trabajaba mejor con polígonos: formas hechas de líneas rectas. Pero un círculo es curvo, de modo que Arquímedes se acercó al mismo aproximándolo por polígonos. Para estimar π él comparó la circunferencia de un círculo con los perímetros de dos series de polígonos: una serie situada en el interior del círculo, y la otra a su alrededor.

Los perímetros de los polígonos dentro del círculo deben ser más cortos que el círculo, mientras que los de fuera del círculo deben ser más largos que el círculo.

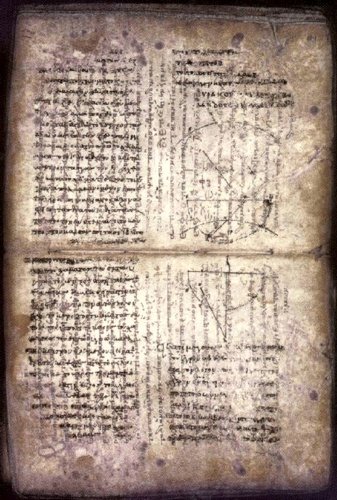

El palimpsesto de Arquímedes

Para hacer el cálculo más fácil, Arquímedes construía sus polígonos bisecando repetidamente los lados de un hexágono regular (un polígono de seis lados) para obtener polígonos regulares con 12 lados, 24, 48 y así sucesivamente. Se detuvo en 96. Sus cálculos demostraban que

3 10/71 < π < 3 1/7

es decir, π está en algún lugar entre 3,1408 y 3,1429 en notación decimal actual.

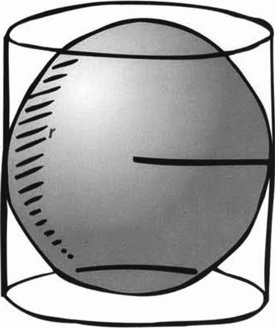

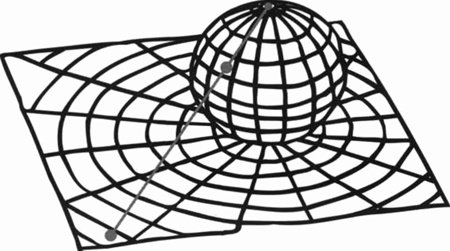

La obra de Arquímedes sobre la esfera es de especial interés, porque no sólo conocemos su demostración rigurosa sino la forma en que la encontró -que decididamente no era rigurosa-. La demostración se da en su libro Sobre la esfera y el cilindro.

Una esfera y su cilindro circunscrito

Él demuestra que el volumen de una esfera es dos-tercios del de un cilindro circunscrito, y que las áreas de aquellas partes de la esfera y del cilindro que yacen entre dos planos paralelos cualesquiera son iguales. En lenguaje moderno, Arquímedes demostró que el volumen de una esfera es 4πr3/3, donde r es el radio, y el área de su superficie es 4πr2 Estos hechos básicos se siguen utilizando hoy.

La demostración hace un uso consumado de la exhaustion. Este método tiene una limitación importante: hay que saber cuál es la respuesta antes de tener muchas posibilidades de demostrarla. Durante siglos los estudiosos no tenían ninguna idea de cómo Arquímedes conjeturó la respuesta.

Pero en 1906 el estudioso danés Heiberg estaba estudiando un pergamino del siglo XIII en el que había escritas unas oraciones. Él advirtió líneas tenues de una inscripción anterior que había sido borrada para dejar lugar para las oraciones. Descubrió que el documento original era una copia de varias obras de Arquímedes, algunas de ellas previamente desconocidas.

(Y lo que es más sorprendente, ahora se sabe que el mismo manuscrito contiene fragmentos de obras perdidas de otros dos autores antiguos.)

Una obra de Arquímedes, el Método de los teoremas mecánicos, explica cómo conjeturar el volumen de una esfera. La idea consiste en hacer rebanadas infinitamente delgadas de la esfera y colocar las rebanadas en un plato de una balanza; en el otro plato se cuelgan rebanadas similares de un cilindro y un cono, cuyos volúmenes Arquímedes ya conocía. La ley de la palanca da el valor buscado para el volumen.

El pergamino fue vendido por dos millones de dólares en 1998 a un comprador privado.

§. Problemas para los griegos

La geometría griega tenía limitaciones, algunas de las cuales superó introduciendo nuevos métodos y conceptos. Euclides sólo admitía las construcciones geométricas que podían realizarse usando una vara no marcada («regla») y un par de compases (en lo sucesivo «compás»; la palabra «par» es técnicamente necesaria, por la misma razón por la que cortamos papel con un par de tijeras, pero no seamos pedantes). A veces se dice que él hizo de esto un requisito, pero no está explicitado como una regla sino que está implícito en sus construcciones. Con instrumentos extra -idealizados de la misma manera que la curva trazada por un compás está idealizada como un círculo perfecto- son posibles nuevas construcciones.

Por ejemplo, Arquímedes sabía que se puede trisecar un ángulo utilizando una vara recta en la que hay dos marcas fijas. Los griegos llamaban a tales procesos «construcciones neusis».

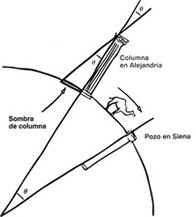

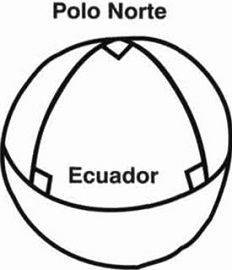

Para qué les servía la geometríaAlrededor del 250 a.C. Eratóstenes de Cirene utilizó la geometría para estimar el tamaño de la Tierra.

Él advirtió que a mediodía en el solsticio de verano, el Sol estaba casi exactamente encima de Siena (actualmente Asuán), porque se reflejaba en el fondo de un pozo vertical.

El mismo día del año, la sombra de una alta columna indicaba que la posición del Sol en Alejandría estaba a un cincuentavo de un círculo completo (unos 7,2º) respecto a la vertical. Los griegos sabían que la Tierra era esférica, y Alejandría estaba casi en dirección norte desde Siena, de modo que la geometría de una sección circular de la esfera implicaba que la distancia de Alejandría a Siena es la cincuentava parte de la circunferencia de la Tierra.

Cómo midió Eratóstenes el tamaño de la TierraEratóstenes sabía que una caravana de camellos tardaba 50 días en ir de Alejandría a Siena, y recorría una distancia de 100 estadios cada día; luego la distancia de Alejandría a Siena son 5.000 estadios, lo que hace la circunferencia de la Tierra de 250.000 estadios. Por desgracia no sabemos con seguridad qué longitud tenía un estadio, pero se estima en 157 metros, lo que lleva a una circunferencia de 39.250 km. La cifra moderna es 39.840 km.

Ahora sabemos (como los griegos debieron haber sospechado) que una trisección exacta del ángulo con regla y compás es imposible, de modo que la contribución de Arquímedes se extiende a lo que realmente es posible. Otros dos problemas famosos de la época son la duplicación del cubo (construir un cubo cuyo volumen sea el doble del de un cubo dado) y la cuadratura del círculo (construir un cuadrado con la misma área de un círculo dado).

Secciones cónicas

Se sabe también que ambos son imposibles utilizando regla y compás.

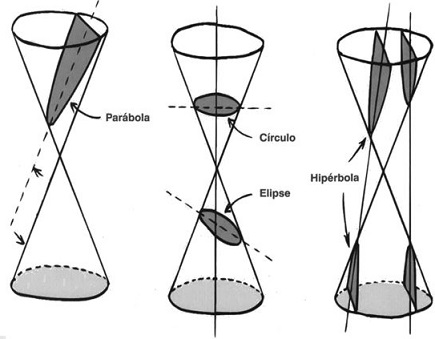

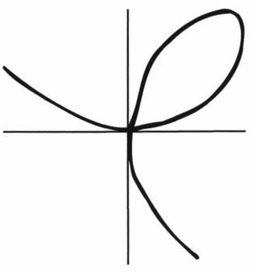

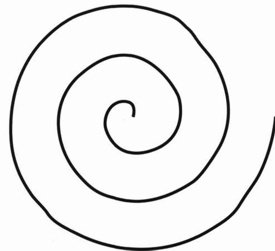

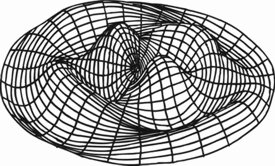

Una ampliación trascendental de las operaciones permitidas en geometría, que dio fruto en el trabajo árabe sobre la ecuación cúbica alrededor del año 800 y tuvo aplicaciones importantes en mecánica y astronomía, fue la introducción de una nueva clase de curvas, las secciones cónicas.

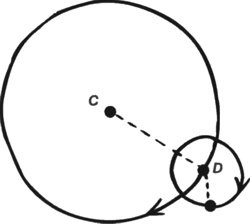

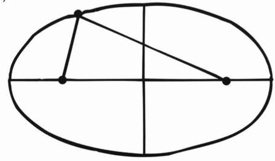

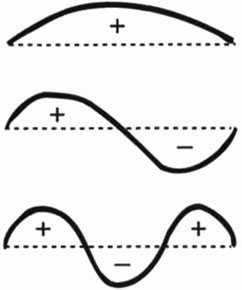

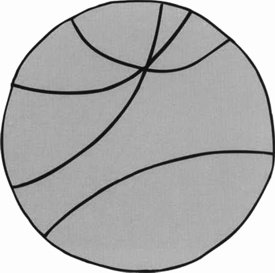

Estas curvas, que son extraordinariamente importantes en la historia de las matemáticas, se obtienen seccionando un cono doble con un plano. Hoy abreviamos el nombre en cónicas. Se dan en tres tipos principales:

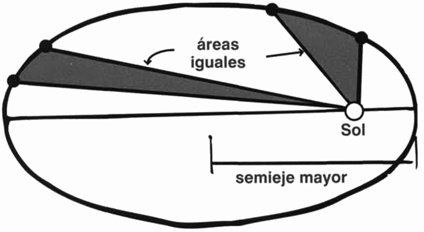

- La elipse, una curva ovalada cerrada que se obtiene cuando el plano corta sólo a una mitad del cono. Los círculos son elipses especiales.

- La hipérbola, una curva con dos ramas infinitas, que se obtiene cuando el plano corta las dos mitades del cono.

- La parábola, una curva transicional «entre» elipses e hipérbolas, en el sentido en que es paralela a una recta que pasa por el vértice del cono y yace en el cono.

Una parábola sólo tiene una rama, pero se extiende hasta el infinito.

Las secciones cónicas fueron estudiadas con detalle por Apolonio de Perga, quien viajó desde Perga, en Asia Menor, a Alejandría para estudiar con Euclides. Su obra maestra, las Secciones cónicas de aproximadamente el 230 a.C., contiene 487 teoremas. Euclides y Arquímedes habían estudiado algunas propiedades de los conos, pero se necesitaría todo un libro para resumir los teoremas de Apolonio. Una idea importante merece mención aquí. Es la noción de los focos de una elipse (o de una hipérbola). Los focos son dos puntos especiales asociados con estos dos tipos de cónica. Entre sus principales propiedades distinguimos una: la suma de las distancias de un punto cualquiera de la elipse a sus dos focos es constante (igual al diámetro mayor de la elipse). Los focos de una hipérbola tienen una propiedad similar, pero ahora tomamos la diferencia de las dos longitudes.

“Los griegos sabían cómo trisecar ángulos y cómo duplicar el cubo utilizando cónicas... también podían cuadrar el círculo.”

Los griegos sabían cómo trisecar ángulos y cómo duplicar el cubo utilizando cónicas. Con la ayuda de otra; curvas especiales, especialmente la cuadratriz, también podían cuadrar el círculo.

Las matemáticas griegas aportaron dos ideas cruciales al desarrollo humano. La más obvia fue una comprensión sistemática de la geometría. Utilizando la geometría como una herramienta, los griegos entendieron el tamaño y la forma de nuestro planeta, su relación con el Sol y la Luna, incluso los movimientos complicados del resto del Sistema Solar. Utilizaron la geometría para excavar largos túneles partiendo de ambos extremos para encontrarse en el centro, lo que reducía el tiempo de construcción a la mitad. Construían máquinas gigantescas y poderosas, basadas en principios simples como la ley de la palanca, con fines tanto pacíficos como bélicos. Explotaron la geometría en la construcción de buques y en la arquitectura, donde edificios como el Partenón nos muestran que matemáticas y belleza no están tan alejadas. La elegancia visual del Partenón deriva de muchos trucos matemáticos astutos, utilizados por el arquitecto para superar las limitaciones del sistema visual humano y las irregularidades en el propio terreno en el que descansaba el edificio.

La segunda aportación griega fue el uso sistemático de la deducción lógica para asegurar que lo que se estaba afirmando también podía justificarse.

El argumento lógico nadó de su filosofía, pero encontró su forma más desarrollada y explícita en la geometría de Euclides y sus sucesores. Sin sólidos fundamentos lógicos no podrían haber aparecido las matemáticas posteriores.

El nuevo estadio de Wembley. En su construcción se han utilizado principios básicos descubiertos en la Antigua Grecia y desarrollados durante los siglos siguientes por muchas culturas.

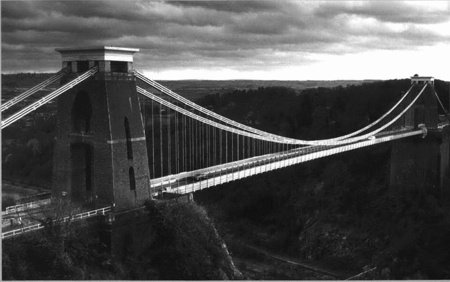

Ambas influencias siguen siendo hoy vitales. La ingeniería moderna -la fabricación y el diseño asistido por computador, por ejemplo- descansa firmemente sobre los principios geométricos descubiertos por los griegos. Todo gran edificio que se levanta está diseñado de modo que no se venga abajo; muchos están diseñados para resistir terremotos. Cualquier torre, cualquier puente colgante, cualquier estadio de fútbol es un tributo a los geómetras de la antigua Grecia.

El pensamiento racional, la argumentación lógica, son igualmente vitales. Nuestro mundo es demasiado complejo, y potencialmente demasiado peligroso, para que basemos nuestras decisiones en lo que queremos creer y no en lo que es realmente.

Hiparía de Alejandría

370 - 475Hiparía es la primera mujer matemática de la que hay noticia. Era hija de Teón de Alejandría, también un matemático. Probablemente fue de su padre de quien aprendió las matemáticas. Hacia el año 400 ella se había convertido en la directora de la Escuela Platónica de Alejandría, donde daba clases de filosofía y matemáticas.

No sabemos si Hiparía hizo contribuciones originales a las matemáticas, pero ayudó a Teón a escribir un comentario sobre el Almagesto de Ptolomeo, y quizá también le haya ayudado a preparar una nueva edición de los Elementos en la que se basaron todas las ediciones posteriores. Ella escribió comentarios sobre la Aritmética de Diofanto y las Cónicas de Apolonio.

Entre los estudiantes de Hiparía había varias figuras destacadas en la religión en auge de la cristiandad, entre ellas Silesio de Cirene. Hay registro de algunas de las cartas que éste le escribió, donde alaba sus capacidades. Por desgracia, muchos de los primeros cristianos consideraban que la filosofía y la ciencia de Hiparía estaban enraizadas en el paganismo, lo que llevó a algunos a rechazar su influencia. En el 412, Cirilo, el nuevo patriarca de Alejandría, entró en rivalidad política con Orestes, el prefecto romano. Hiparía era buena amiga de Orestes y sus capacidades como maestra y oradora fueron vistas como una amenaza por los cristianos. Ella se convirtió en un blanco de los disturbios políticos y fue descuartizada por una turba. Una fuente culpa a una secta fundamentalista, los monjes de Nitria, que apoyaban a Cirilo. Otra, culpa a la plebe alejandrina. Una tercera fuente afirma que ella formó parte de una rebelión política, y su muerte era inevitable.

Su muerte fue brutal, desmembrada por una multitud con tejas cortantes (algunos dicen que con conchas de ostras). Su cuerpo mutilado fue entonces quemado. Este castigo puede ser prueba de que Hiparía fue condenada por brujería -la primera bruja importante en ser asesinada por los primeros cristianos- porque el castigo para la brujería prescrito por Constantino II era que «sus carnes sean desgarradas hasta los huesos con ganchos de hierro».

El método científico está construido deliberadamente para superar un deseo humano profundamente asentado que consiste en suponer que lo que queremos que sea cierto -lo que afirmamos «conocer»- es realmente cierto.

"... cualquier estadio de fútbol es mi tributo a los geómetras de la Antigua Grecia."

En ciencia se pone el acento en tratar de demostrar que aquello de lo que uno está profundamente convencido es falso. Las ideas con más probabilidad de ser correctas son las que sobreviven a los intentos rigurosos de refutarlas.

Para qué nos sirve la geometríaLa expresión de Arquímedes para el volumen de una esfera se sigue utilizando hoy. Una aplicación, que requiere conocer π con gran precisión, es la unidad patrón de masa para el conjunto de la ciencia. Durante muchos años, por ejemplo, un metro se definía como la longitud de una barra metálica concreta cuando se medía a una temperatura concreta.

Muchas unidades básicas se definen ahora en términos de cosas tales como cuánto tarda un átomo de un elemento específico en vibrar un enorme número de veces. Pero otras aún se basan en objetos físicos, y la masa es uno de estos casos. Un kilogramo se define actualmente como la masa de un cilindro concreto, hecho de platino e iridio y conservado en París. El cilindro se ha construido con una precisión extraordinariamente alta. La densidad del metal también ha sido medida con mucha precisión. La fórmula es necesaria para calcular el volumen del cilindro, que relaciona densidad con masa.

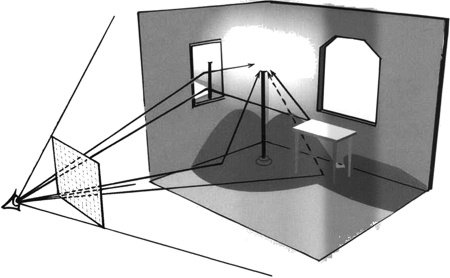

Principio de trazado de rayos y una imagen de muestraOtro uso moderno de la geometría se da en los gráficos por computador. Las películas hacen un amplio uso de imágenes generadas por computador (CGI), y a menudo es necesario generar imágenes que incluyen reflexiones -en un espejo, en un vaso de vino, algo que atrape la luz.

Sin tales reflexiones la imagen no parecería realista. Una manera eficaz de hacerlo consiste en «rastrear rayos». Cuando miramos una escena desde una dirección particular, nuestro ojo detecta un rayo de luz que ha rebotado en los objetos de la escena y entra en el ojo procedente de dicha dirección. Podemos seguir la trayectoria de este rayo trabajando hacia atrás. En cualquier superficie reflectante rebota de modo que el rayo original y el rayo reflejado forman ángulos iguales en la superficie. La traducción de este hecho geométrico en cálculos numéricos permite al computador rastrear el rayo hacia atrás por muchos rebotes que pudieran ser necesarios antes de que choque con algo opaco. (Pueden ser necesarios varios rebotes; por ejemplo, si el vaso de vino está colocado delante de un espejo.)

Capítulo 3

Notaciones y números

El origen de nuestros símbolos numerales

Estamos tan acostumbradosal sistema de números actual, con su uso de los diez dígitos decimales 0, 1, 2, 3, 4, 5, 6, 7, 8 y 9 (en los países de Occidente), que puede producir sorpresa el advertir que hay modos completamente diferentes de escribir números. Incluso hoy, diversas culturas -la arábiga, la china, la coreana- usan diferentes símbolos para los diez dígitos, aunque todas ellas combinan estos símbolos para formar números mayores utilizando el mismo método «posicional» (centenas, decenas, unidades).

Pero las diferencias en notación pueden ser más radicales que eso.

No hay nada especial en el número 10. Resulta que es el número de dedos de las manos en el ser humano, que son ideales para contar, pero si en su lugar hubiéramos desarrollado siete dedos, o doce, sistemas muy similares hubiesen funcionado igual de bien, quizá mejor en algunos casos.

§. Numerales romanos

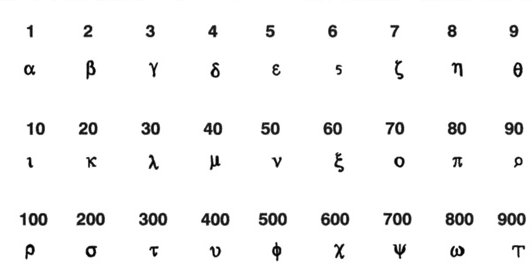

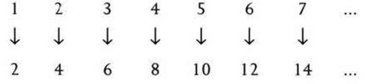

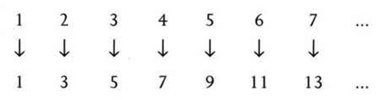

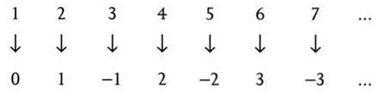

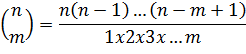

La mayoría de los occidentales conocen al menos un sistema alternativo, los números romanos, en el que, por ejemplo, el año 2007 se escribe MMVII.