A Simon Mlodinow

Parte 1

Los pensadores erguidos

La experiencia más bella y profunda que puede tener un hombre es el sentido del misterio. Es el principio que subyace a la religión y a todos los empeños serios de las artes y las ciencias. Quien no haya tenido nunca esta experiencia, me parece que, si no muerto, al menos está ciego.

1. El anhelo de conocimiento

2. Curiosidad

3. Cultura

4. Civilización

5. Razón

1. El anhelo de conocimiento

Mi padre me habló en cierta ocasión de un escuálido preso del campo de concentración de Buchenwald que tenía conocimientos de matemáticas. Lo que a una persona le viene a la cabeza cuando oye la palabra «pi» nos dice algo sobre ella. Para el «matemático» era la relación entre la circunferencia de un círculo y su diámetro. Si le hubieran preguntado a mi padre, que apenas tenía educación primaria, me habría contestado que era un círculo de masa de harina rellena de manzana[I].

Un día, a pesar del abismo que los separaba, el preso matemático le propuso a mi padre que resolviera un problema. Mi padre le dio vueltas durante unos cuantos días, pero no logró desentrañarlo. Cuando volvió a ver al preso, le preguntó por la solución. El hombre no se la quería dar, le decía que tenía que descubrirla por sí mismo. Pasó algún tiempo, y mi padre volvió a preguntárselo, pero el otro preso se aferraba a su secreto como si fuera un lingote de oro. Mi padre intentó reprimir su curiosidad, pero no pudo. En medio del hedor y la muerte que lo rodeaban, se obsesionó con la respuesta. Por fin el otro preso le propuso un trato: le revelaría la solución si le daba su mendrugo de pan. No sé lo que pesaría mi padre por aquel entonces, pero cuando lo liberó el ejército estadounidense no llegaba a los cuarenta kilos. Pese a ello, su anhelo de saber era tan fuerte que se había desprendido de su mendrugo de pan a cambio de la respuesta.

Fue al final de mi adolescencia cuando mi padre me contó este episodio, que me afectó profundamente. La familia de mi padre había desaparecido, sus posesiones habían sido confiscadas y su cuerpo privado de alimento, debilitado, golpeado. Los nazis los habían despojado de todo lo palpable, pero su deseo de pensar y razonar y conocer había sobrevivido. Era prisionero, pero su mente era libre para vagar, y lo hizo. Comprendí entonces que la búsqueda del conocimiento es el más humano de nuestros deseos, y que, por diferentes que fueran nuestras circunstancias, mi propia pasión por entender el mundo tenía su origen en el mismo instinto que la de mi padre.

Cuando me dediqué a estudiar ciencias, en la universidad y después, mi padre no me preguntaba tanto sobre las cuestiones técnicas de lo que aprendía como sobre su significado subyacente: de dónde venían las teorías, por qué me parecían hermosas, qué nos decían sobre nosotros como seres humanos. Este libro, escrito décadas más tarde, es mi intento de dar por fin respuesta a aquellas preguntas.

Hace varios millones de años, los humanos empezamos a erguirnos, alterando nuestros músculos y esqueleto de manera que nos permitiera caminar en una postura erecta, lo que liberó nuestras manos para reconocer y manipular los objetos de nuestro entorno y ensanchó el panorama de nuestra visión, que ahora nos permitía explorar en la lejanía. Pero al tiempo que erguíamos la postura, nuestra mente se elevaba por encima de la de otros animales y nos permitía explorar el mundo no ya con la vista, sino con el pensamiento. Caminamos erguidos pero, por encima de todo, somos pensadores.

La nobleza de la raza humana radica en nuestro anhelo de conocimiento, y lo que nos hace únicos como especie queda reflejado en los logros que hemos alcanzado, tras miles de años de esfuerzo, en nuestro empeño por descifrar el enigma que es la naturaleza. Si a un humano de la antigüedad le hubieran dado un microondas para calentar su carne de uro, tal vez pensara que en su interior había un ejército de laboriosos y minúsculos dioses que encendían hogueras diminutas bajo la comida, y luego desaparecían milagrosamente cuando se abría la puerta. Pero igual de milagrosa es la verdad: que un puñado de leyes abstractas, simples e inviolables, explican todo nuestro universo, desde el funcionamiento de un microondas hasta los prodigios naturales del mundo que nos rodea.

A medida que avanzaba nuestro conocimiento del mundo natural, pasamos de percibir las mareas como un fenómeno regido por una diosa a entenderlas como el resultado de la atracción gravitatoria de la Luna, y dejamos de ver las estrellas como dioses que flotan en el firmamento a identificarlas como hornos nucleares desde los cuales nos llegan fotones. Hoy entendemos el funcionamiento interno de nuestro Sol, a cientos de millones de kilómetros de nuestro planeta, y la estructura de un átomo más de mil millones de veces más pequeño que nosotros. Que hayamos logrado descodificar estos y otros fenómenos naturales no es solo un prodigio, es también una historia épica y fascinante.

Hace algún tiempo formé parte del equipo de guionistas de una temporada de la serie televisiva Star Trek: La nueva generación. En mi primera reunión de guiones, sentado a una mesa poblada con todos los guionistas y productores del programa, lancé una idea para un episodio que me entusiasmaba porque en ella intervenía la astrofísica real del viento solar. Todos los ojos estaban centrados en mí, el físico de la sala, mientras excitadamente explicaba los detalles de mi idea y la ciencia que había detrás. Cuando acabé (había tardado menos de un minuto), miré lleno de orgullo y satisfacción a mi jefe, un taciturno productor de mediana edad que en otro tiempo había trabajado como detective de homicidios en la policía de Nueva York. Me miró un momento con un rostro extrañamente ilegible y luego pronunció con gran énfasis: «¡Cierra el pico, jodido empollón!».

Cuando me sobrepuse al bochorno, comprendí que lo que intentaba decirme de tan sucinta manera era que me habían contratado por mi capacidad para contar historias, no para montar unas clases extraescolares sobre la física de las estrellas. Asumí su opinión, y desde entonces he dejado que me guíe en todo lo que escribo. (Su otra sugerencia memorable: si alguna vez sospechas que te van a despedir, baja la calefacción de tu piscina).

En las manos equivocadas, la ciencia, como todos sabemos, puede ser aburrida hasta decir basta. Pero la historia de lo que sabemos y de cómo lo sabemos no es aburrida en absoluto. Al contrario, es tremendamente emocionante. Llena de episodios de descubrimiento que no son menos cautivadores que un episodio de Star Trek o el primer viaje a la Luna, poblada de personajes tan apasionados e idiosincrásicos como los que conocemos en el arte, la música o la literatura, de buscadores cuya insaciable curiosidad llevó a nuestra especie desde sus orígenes en la sabana africana a la sociedad en la que hoy vivimos.

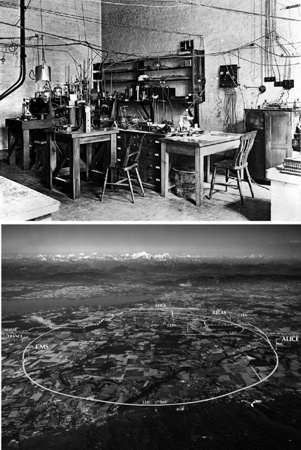

¿Cómo lo lograron? ¿Cómo pasamos de ser una especie que apenas había aprendido a caminar erguida y vivía de frutos, bayas y raíces que recolectaba con sus propias manos a una que vuela en aviones, envía mensajes al instante por todo el mundo y recrea en enormes laboratorios las condiciones del universo primigenio? Esa es la historia que quiero contar, porque conocerla es entender nuestra herencia como seres humanos.

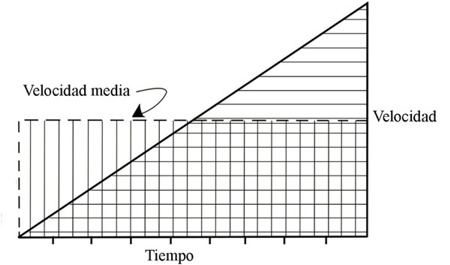

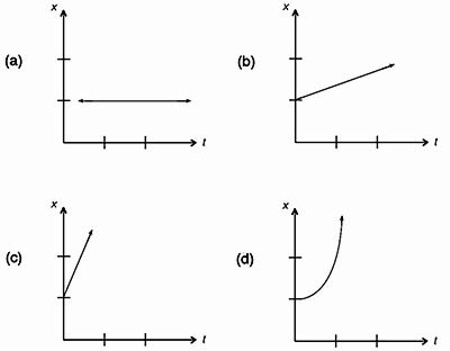

Se ha convertido en un cliché decir que en la actualidad el mundo es plano. Pero si es cierto que las distancias y diferencias entre países se van reduciendo, también lo es que las diferencias entre el hoy y el ayer van aumentando. Cuando se construyeron las primeras ciudades, hacia el 4000 a. C., la manera más rápida de viajar a larga distancia era en una caravana de camellos, que se desplazaba a unos pocos kilómetros por hora. De mil a dos mil años más tarde se inventó el carro[1], que elevó la velocidad máxima hasta unos 30 kilómetros por hora. No fue hasta el siglo XIX cuando la locomotora a vapor permitió al fin viajar deprisa, con velocidades de más de 150 kilómetros por hora a finales de la centuria. Pero aunque a los humanos nos llevó dos millones de años pasar de correr a 15 kilómetros por hora a atravesar un país a 150 kilómetros por hora, solo hicieron falta cincuenta años más para alcanzar el siguiente factor de diez, con la creación de un avión que podía volar a 1500 kilómetros por hora. Y en los años 1980, los humanos ya viajábamos a más de 25 000 kilómetros por hora en la lanzadera espacial.

La evolución de otras tecnologías también muestra la misma aceleración. Es el caso de las comunicaciones. Aun en el siglo XIX, la agencia Reuters usaba palomas mensajeras para enviar las cotizaciones de bolsa entre ciudades[2].

Más tarde, a mediados del siglo XIX, se extendió el telégrafo, y en el siglo XX, el teléfono. Hicieron falta ochenta y un años para que el teléfono fijo alcanzara una penetración de mercado del 75%, pero el teléfono móvil logró lo mismo en veintiocho años, y el teléfono inteligente en tan solo trece. Durante los últimos años, primero el correo electrónico, luego los mensajes de texto, suplantaron en buena medida a las llamadas telefónicas como medio de comunicación, y hoy el teléfono cada vez se usa menos para hacer llamadas y más como ordenador de bolsillo.

«El mundo actual», decía el economista Kenneth Boulding, «es tan distinto del mundo en el que nací como aquel mundo lo era del de Julio César [3]».

Boulding nació en 1910 y murió en 1993. Los cambios que presenció, y muchos otros que se han producido desde entonces, fueron productos de la ciencia y de la tecnología que esta alimenta. Esos cambios forman parte de la vida humana más que en cualquier otro tiempo pasado, y nuestro éxito en el trabajo y en la sociedad depende cada vez más de nuestra habilidad para asimilar las innovaciones y para innovar nosotros mismos. Hoy, incluso quienes no trabajan en la ciencia o la tecnología se enfrentan a retos que los obligan a innovar para seguir siendo competitivos, y por eso la naturaleza del descubrimiento es un tema que nos importa a todos.

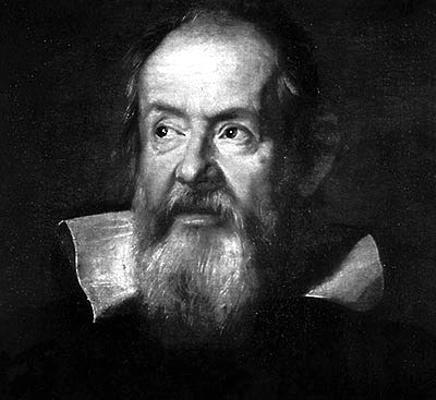

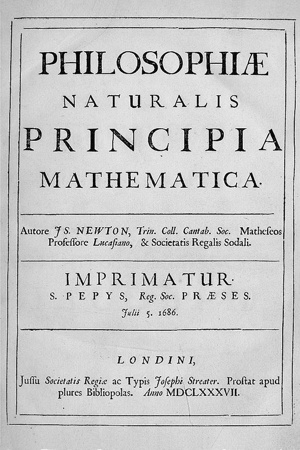

Para ganar perspectiva sobre nuestra posición actual y albergar alguna esperanza de entender adónde nos dirigimos, es necesario saber de dónde venimos. Los mayores triunfos de la historia intelectual del hombre (la escritura y la matemática, la filosofía natural y las diversas ciencias) suelen presentarse aislados, como si cada uno de ellos no tuviera nada que ver con los otros. Pero esa manera de ver las cosas hace hincapié en los árboles, no en el bosque. Olvida, por su propia naturaleza, la unidad del conocimiento humano. El desarrollo de la ciencia moderna, por ejemplo, que a menudo se proclama como la obra de «genios aislados» como Galileo o Newton, no surgió de un vacío social o cultural. Hundió sus raíces en el modo de acercarse al conocimiento que inventaron los antiguos griegos, creció con las grandes preguntas que planteaba la religión, se desarrolló de la mano de nuevas formas artísticas, fue influido por las lecciones de la alquimia y habría sido imposible sin progresos sociales que van del desarrollo de las grandes universidades de Europa a invenciones mundanas como la de los sistemas de correo que conectaron ciudades y países cercanos. La ilustración griega, a su vez, nació de las asombrosas invenciones intelectuales de pueblos más antiguos, en tierras como Mesopotamia y Egipto.

A causa de estas influencias y conexiones, la historia de cómo llegaron los humanos a entender el cosmos no consiste en viñetas aisladas, sino que forma, como la mejor ficción, una narración coherente, un todo unificado cuyas partes tienen numerosas interconexiones, y que comienza en los albores de la humanidad. En lo que sigue, ofrezco una guía selectiva de esa odisea de descubrimiento.

Nuestro viaje se inicia con el desarrollo de la mente de los humanos modernos y se centra en las eras críticas y los puntos de inflexión durante los cuales esa mente realizó saltos hasta nuevas maneras de mirar el mundo. A lo largo del camino, presentaré algunos de los personajes fascinantes cuyas únicas y personales cualidades y modos de pensar desempeñaron un papel importante en esas innovaciones.

Como tantos otros relatos, este se divide en tres partes. La parte I, que se extiende a lo largo de millones de años, sigue la evolución del cerebro humano y su propensión a preguntarse «¿por qué?». Nuestros porqués nos empujaron a nuestras primeras indagaciones espirituales y, con el tiempo, nos llevaron a desarrollar la escritura y la matemática y el propio concepto de ley, que son las herramientas necesarias para la ciencia. En su momento, aquellos porqués nos llevaron a concebir la filosofía, la idea de que el mundo material responde a ritmos y razones que, en principio, podemos comprender.

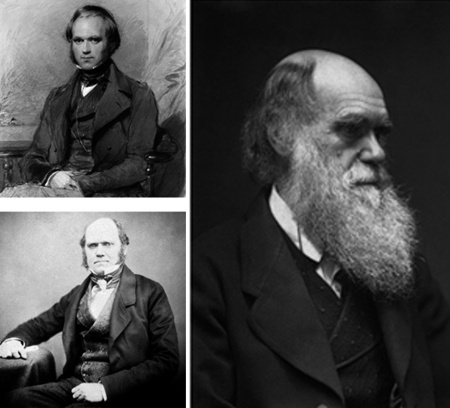

La siguiente fase de nuestro periplo explora el nacimiento de las ciencias duras. Es una historia de revolucionarios que gozaron del don de ver el mundo de otro modo, y de la paciencia, la determinación, el ingenio y el coraje para persistir en su empeño durante los años o incluso décadas que precisaron para desarrollar sus ideas. Estos pioneros, pensadores como Galileo, Newton, Lavoisier y Darwin, lucharon largo y duro contra la doctrina establecida de su tiempo, de manera que sus historias son inevitablemente historias de lucha personal en las que, a veces, estuvo en juego hasta su propia vida.

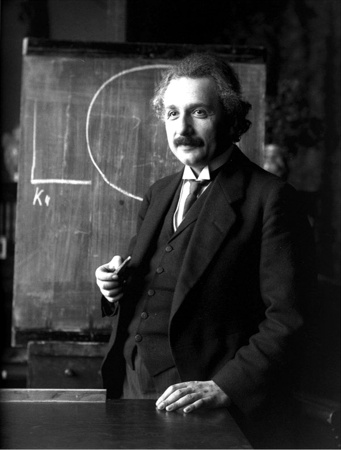

Por último, como en tantos buenos relatos, el nuestro da un giro inesperado justo cuando sus héroes tienen razones para pensar que se acercan al final de su viaje. En un extraño giro argumental, cuando la humanidad creía que había descifrado todas las leyes de la naturaleza, pensadores como Einstein, Bohr y Heisenberg descubrieron un nuevo dominio de la existencia, un dominio invisible en el que había que reescribir aquellas leyes. Ese «otro» mundo, con sus leyes sobrenaturales, se desarrolla a una escala demasiado pequeña para que podamos aprehenderla directamente: el microcosmos del átomo, regido por las leyes de la física cuántica. Son esas leyes las responsables de los grandes y cada vez más rápidos cambios que nuestra sociedad experimenta en la actualidad, pues fue la comprensión del mundo cuántico lo que permitió la invención de los ordenadores, los teléfonos móviles, los televisores, los láseres, la internet, los métodos de imagen en medicina, el mapeo genético y muchas de las nuevas tecnologías que han revolucionado la vida moderna.

Mientras que la Parte 1 de este libro abarca millones de años y la Parte 2 varios siglos, la parte 3 apenas comprende unas pocas décadas, lo que refleja la aceleración exponencial del conocimiento humano, y la novedad de nuestras incursiones en este extraño mundo.

La odisea humana del descubrimiento abarca muchas eras, pero los temas de nuestro empeño por entender el mundo no varían nunca, pues surgen de nuestra propia naturaleza humana. Uno de estos temas le resultará familiar a cualquiera que trabaje en un campo dedicado a la innovación y el descubrimiento: la dificultad de concebir un mundo, o una idea, distintos del mundo o las ideas que ya conocemos.

En los años 1950, Isaac Asimov, uno de los mejores y más creativos autores de ciencia ficción de todos los tiempos, escribió la trilogía Fundación , una serie de novelas en las que la acción se sitúa a muchos miles de años en el futuro. En estas novelas, los hombres se desplazan cada día para trabajar en sus oficinas mientras las mujeres se quedan en casa. En tan solo unas pocas décadas, esa visión del futuro lejano ya era cosa del pasado. Si lo traigo a colación es porque ilustra una limitación casi universal del pensamiento humano: nuestra creatividad queda restringida por el pensamiento convencional que nace de creencias de las que no podemos despojarnos, o que ni siquiera pensamos en cuestionar.

La otra cara de la dificultad de concebir el cambio es la dificultad de aceptarlo, y ese es otro de los temas recurrentes de nuestra historia. A los seres humanos, el cambio puede resultarnos abrumador. El cambio es exigente con nuestra mente, nos aleja del ámbito en que nos sentimos más cómodos, quebranta nuestros hábitos mentales. Produce confusión y desorientación. Requiere que nos despojemos de nuestras viejas maneras de pensar, y ese despojarnos no es elección nuestra sino imposición. Más aún, a menudo los cambios desencadenados por el progreso científico desbaratan sistemas de creencias que comparte un gran número de personas, y que posiblemente afecten a sus profesiones y modos de vida. En consecuencia, las nuevas ideas científicas suelen topar con resistencia, indignación y ridículo.

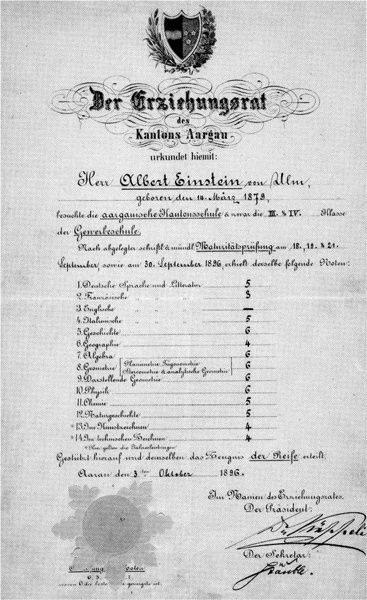

La ciencia es el alma de la tecnología moderna, la raíz de la civilización moderna. Está en la base de muchas de las cuestiones políticas, religiosas y éticas de nuestros días, y las ideas que la sustentan están transformando la sociedad a un ritmo cada vez más rápido. Pero del mismo modo que la ciencia desempeña un papel fundamental en la formación de los patrones del pensamiento humano, no es menos cierto que los patrones del pensamiento humano han jugado un rol decisivo en la formación de nuestras teorías científicas. Y es que la ciencia es, como bien señalaba Einstein, «tan subjetiva y psicológicamente condicionada como cualquier otra rama del empeño humano[4]».

Este libro es un intento por describir los desarrollos de la ciencia con ese espíritu: como un empeño determinado tanto intelectual como culturalmente cuyas ideas solo pueden entenderse mediante un examen de las situaciones personales, psicológicas, históricas y sociales que lo modelaron. Ver la ciencia de este modo no solo arroja luz sobre la propia empresa, sino también sobre la naturaleza de la creatividad y la innovación, y, en un sentido más amplio, sobre la condición humana.

2. Curiosidad

Para entender las raíces de la ciencia, tenemos que examinar las raíces de la especie humana. Los humanos somos la única especie dotada tanto de la capacidad como del deseo de entendernos a nosotros mismos y a nuestro mundo. Ese es el mayor de los dones, el que nos aparta del resto de los animales, y es la razón de que seamos nosotros quienes estudiamos a los ratones y los conejillos de Indias y no ellos los que nos estudien a nosotros. El ansia de conocer, reflexionar y crear, ejercido a lo largo de miles de años, nos ha dado las herramientas para sobrevivir, para construirnos un nicho ecológico único. Usando el poder de nuestro intelecto, no la potencia física, hemos modificado nuestro entorno para que se ajuste a nuestras necesidades, en lugar de permitir que sea nuestro entorno quien nos conforme, o nos venza. Durante millones de años, la fuerza y la creatividad de nuestras mentes han vencido los obstáculos que han puesto a prueba la fuerza y la agilidad de nuestros cuerpos.

De niño, mi hijo Nicolái solía capturar lagartijas que cuidaba como mascotas, algo que uno puede hacer cuando vive en el sur de California. Los dos observamos que cuando nos acercábamos a los animales, primero se quedaban inmóviles y luego, cuando nos agachábamos para cogerlos, salían corriendo. Con el tiempo nos dimos cuenta de que si llevábamos una caja grande, podíamos colocarla invertida sobre la lagartija antes de que se escapara, y luego deslizar por debajo una lámina de cartón para completar la captura. Personalmente, si camino por una calle oscura y desierta y veo algo sospechoso, no me quedo inmóvil; cruzo inmediatamente al otro lado. Así que es bastante lógico suponer que si dos grandes depredadores se me acercasen y me mirasen atentamente mientras sostienen una enorme caja, me temería lo peor y saldría pitando. Las lagartijas, sin embargo, no se cuestionan su situación; actúan únicamente por instinto. Ese instinto desde luego les resultó útil durante los muchos millones de años que precedieron a Nicolái y su caja, pero les falló con mi hijo.

Los humanos quizá no seamos el último grito en condición física, pero gozamos de la habilidad de complementar el instinto con la razón y, lo que es más importante para nuestros propósitos, de hacernos preguntas sobre nuestro entorno. Esos son los prerrequisitos del pensamiento científico, y son características cruciales de nuestra especie. Por eso es ahí donde comienza nuestra aventura: con el desarrollo del cerebro humano, con sus dotes únicas.

Nosotros mismos nos llamamos «humanos», pero en realidad esta palabra no se refiere solamente a nosotros, Homo sapiens sapiens, sino a todo un género que se llama Homo. Este género incluye otras especies como Homo habilis y Homo erectus, pero esos parientes nuestros desaparecieron hace mucho tiempo. En el torneo con una sola eliminación que llamamos evolución, todas las otras especies humanas resultaron ser inadecuadas. Solo nosotros, gracias al poder de nuestras mentes, hemos vencido a todo lo que ha puesto a prueba nuestra supervivencia (hasta el momento).

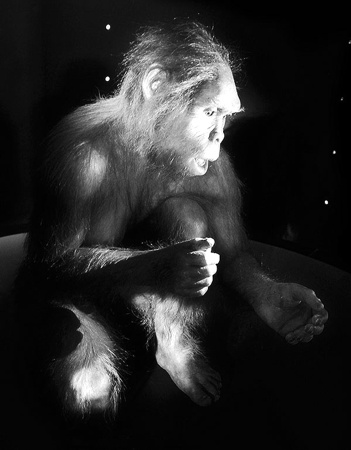

Representación artística de Protungulatum. De Maureen A. O'Leary et al., «The Placental Mammal Ancestor and the Post-K-Pg Radiation of Placentals», Science, 339 (8 de febrero de 2013), pp. 662-667.

No hace mucho tiempo, el hombre que entonces era presidente de Irán dijo que los judíos descendían de los monos y los cerdos. Siempre es esperanzador que un fundamentalista de la religión crea en la evolución, así que no estoy seguro de que deba criticarle, pero en realidad los judíos, como el resto de los humanos, no descienden de los monos y los cerdos, sino de simios y ratas, o al menos de unos animalejos parecidos a las ratas [5].

Conocida como Protungulatum donnae en la literatura científica, nuestra abuelísima, la progenitora de los primates ancestrales y de todos los mamíferos como nosotros, fue, por lo que sabemos, una especie simpática de rabo peludo cuyos miembros pesaban apenas un cuarto de kilo.

Los científicos creen que estos pequeños animales comenzaron a corretear por su hábitat hace unos sesenta y seis millones de años, poco después de que un asteroide de unos diez kilómetros de ancho se estrellase contra la Tierra. Aquella catastrófica colisión lanzó a la atmósfera el polvo suficiente para ahogar los rayos del Sol durante un largo periodo de tiempo, y generó gases invernadero suficientes para disparar las temperaturas una vez se hubo depositado el polvo. El doble golpe de la oscuridad seguida de temperaturas elevadas acabó con un 75% de las especies de plantas y animales, pero para nosotros fue una suerte, pues creó un nicho ecológico en el que unos animales que parían a sus crías podían sobrevivir y propagarse sin ser engullidos por voraces dinosaurios u otros depredadores. Durante las decenas de millones de años que siguieron, mientras, unas tras otras, surgían especies nuevas y se desvanecían hasta extinguirse, una rama del árbol familiar de Protungulatum evolucionó hasta nuestros ancestros monos y simios, y luego siguió ramificándose, hasta producir a nuestros parientes vivos más cercanos, los chimpancés y los bonobos (chimpancés pigmeos) y, por último, al lector de este libro y a todos los seres humanos.

En la actualidad, la mayoría de la gente se siente cómoda con el hecho de que la Abuela tuviera cola y comiera insectos. Yo voy más allá de la simple aceptación: me dejo fascinar y emocionar por nuestra ascendencia, y por la historia de nuestra supervivencia y evolución cultural. Creo que el hecho de que nuestros antepasados fuesen ratas y simios es uno de los hechos más estupendos de nuestra naturaleza: en nuestro asombroso planeta, una rata y sesenta y seis millones de años dieron lugar a científicos que estudian las ratas y al hacerlo descubren sus propias raíces. Por el camino, desarrollamos cultura y religión y ciencia, y reemplazamos los nidos de ramas de nuestros ancestros con resplandecientes rascacielos de acero y hormigón.

La velocidad de este desarrollo intelectual ha ido aumentando drásticamente. La naturaleza necesitó unos sesenta y seis millones de años para producir el «simio» del que descendieron todos los humanos; el resto de nuestra evolución física se produjo en solo unos millones. Es como si, en palabras del psicólogo Julian Jaynes, «toda la vida evolucionase hasta cierto punto, y luego dentro de nosotros mismos diera un giro de noventa grados y sencillamente explotase en una dirección distinta[6]».

Al principio, el cerebro animal evolucionó por la más primaria de las razones: para permitir moverse mejor. La habilidad de moverse, es decir, de encontrar alimento y refugio y de escapar de los enemigos, es, por supuesto, una de las características fundamentales de los animales. Cuando miramos hacia atrás en el camino de la evolución a animales como los nematodos, los gusanos de tierra y los moluscos, vemos que los primeros precursores del cerebro sirven para controlar el movimiento excitando músculos en el orden adecuado. Pero el movimiento no vale de mucho sin la capacidad de percibir el entorno, así que incluso los animales más simples tienen alguna forma de percatarse de lo que los rodea: células que reaccionan ante ciertas sustancias químicas, por ejemplo, o ante los fotones de la luz, enviando impulsos eléctricos a los nervios que gobiernan el control del movimiento. Para cuando apareció Protungulatum donnae, estas células quimiosensibles o fotosensibles habían evolucionado hasta constituir los sentidos del olfato y de la vista, y aquel haz de nervios que controlaba el movimiento de los músculos se había convertido en un cerebro.

Nadie sabe con exactitud cómo se fue organizando el cerebro de nuestros antepasados en componentes funcionales, pero incluso en el cerebro moderno, mucho más de la mitad de las neuronas está dedicada al control motor y a los cinco sentidos. En cambio, la parte de nuestro cerebro que nos separa de los animales «inferiores» es relativamente pequeña, y llegó mucho más tarde.

Uno de los primeros animales casi humanos merodeó por la Tierra hace solo de tres a cuatro millones de años [7].

No lo conocimos hasta un caluroso día de 1974, cuando un antropólogo llamado Donald Johanson, del Instituto sobre los Orígenes Humanos de Berkeley, dio con un diminuto fragmento de un hueso del brazo que sobresalía del abrasado suelo de un arroyo seco en las remotas regiones del norte de Etiopía. Johanson y un estudiante no tardaron en desenterrar otros huesos: de la cadera y de la caja torácica, además de vértebras e incluso un trozo de mandíbula. En total, hallaron casi la mitad del esqueleto de una hembra. Tenía la pelvis femenina, el cráneo pequeño, las piernas cortas y los brazos largos y caídos. No era como para sacarla a bailar, pero aquella dama de hace 3,2 millones de años se considera un vínculo con nuestro pasado, una especie de transición, y posiblemente el antepasado a partir del cual evolucionó todo nuestro género biológico.

Johanson llamó a esta nueva especie Australopithecus afarensis, que significa «simio meridional de Afar», por la región de Etiopía en la que realizó su descubrimiento. También bautizó los huesos como Lucy, por la canción de los Beatles «Lucy in the Sky with Diamonds», que sonaba en la radio del campamento mientras Johanson y su equipo celebraban su hallazgo. Andy Warhol dijo que todo el mundo consigue quince minutos de fama, y tras millones de años, por fin le llegaron a Lucy. O, para ser más precisos, a la mitad de Lucy, porque su otra mitad no apareció nunca.

Es asombroso lo mucho que pueden discernir los antropólogos a partir de unos pocos huesos. Los grandes dientes de Lucy, en unas mandíbulas adaptadas para romper y masticar, sugieren que tenía una dieta vegetariana formada por raíces, semillas y frutos de cubierta dura [8].

Su estructura esquelética indica que tenía un vientre de gran tamaño, necesario para contener el largo intestino que habría requerido para digerir la gran cantidad de materia vegetal que le servía de sustento. Lo más importante, sin embargo, es que la estructura de su columna y de las rodillas indica que caminaba más o menos erguida [9], y un hueso de un miembro de su especie, que Johanson y sus colaboradores descubrieron no muy lejos en 2011, revela un pie parecido al nuestro, con arcos adecuados para caminar, no para agarrarse a las ramas. La especie de Lucy había evolucionado de la vida en los árboles a la vida sobre el suelo, lo que permitió a sus miembros buscar alimento entre un mosaico de ecosistemas de bosque y pradera y sacar provecho de nuevas fuentes de alimento que se encuentran en el suelo, como las raíces y tubérculos ricos en proteínas. A decir de algunos, fue esta forma de vida la que dio origen a todo el género Homo.

Imaginemos que vivimos en una casa y que nuestra madre es la vecina de al lado, y la suya la de al lado, y así sucesivamente. Nuestro linaje humano no es tan lineal, pero, dejando a un lado algunas complejidades, es interesante imaginar que conducimos por esa calle, viajando hacia el pasado y pasando por generación tras generación de antepasados. Si así lo hiciéramos[10], tendríamos que conducir casi seis mil quinientos kilómetros para llegar a la casa de Lucy, una «mujer» que, con apenas un metro de estatura, treinta kilos de peso y el cuerpo cubierto de pelo, se nos antojaría más un chimpancé que una parienta. A medio camino habríamos pasado por la casa de un antepasado separado de Lucy por unas 100 000 generaciones, la primera especie lo bastante parecida a nosotros (por su esqueleto y, según creen los científicos, por su mente) como para que la clasifiquemos dentro del género Homo[11]. Los científicos han llamado a esta especie humana de hace dos millones de años Homo habilis, «humano hábil».

Homo habilis vivió en las inmensas sabanas africanas en un momento en el que, a causa del cambio climático, los bosques se encontraban en recesión. Aquellas llanuras herbáceas no eran un entorno fácil donde subsistir, pues daban cobijo a un gran número de terribles depredadores. Los menos peligrosos de estos depredadores competían por el alimento con Homo habilis; los más peligrosos, intentaban convertir en alimento a aquellos humanos hábiles. Fue justamente gracias a su ingenio como sobrevivían aquellos humanos: tenían un flamante cerebro de mayor tamaño, más o menos el de un pomelo pequeño. En la escala de tamaños de frutas, esa potencia cerebral es menor que la de nuestro melón cantalupo pero el doble que el volumen de la naranja de Lucy [II].

Cuando comparamos especies distintas, sabemos por experiencia que suele haber una correlación aproximada entre la capacidad intelectual y el peso medio del encéfalo relativo al tamaño corporal. De este modo, a partir de su volumen encefálico podemos concluir que el humano hábil suponía una mejora intelectual sobre Lucy y los de su estirpe. Por suerte, podemos estimar el tamaño y la forma del encéfalo de los humanos y otros primates aunque la especie lleve mucho tiempo extinguida, porque su cerebro se ajusta bien a su cráneo, lo que significa que si encontramos un cráneo de primate, básicamente disponemos de un molde del cerebro que en otro tiempo contuvo.

Para que nadie se lleve al engaño de pensar que estoy diciendo que la talla de sombrero es un indicador de la inteligencia, debo aclarar que cuando los científicos afirman que pueden estimar la inteligencia comparando el tamaño cerebral, solo se refieren a las comparaciones entre los tamaños medios de especies distintas. El tamaño del cerebro varía considerablemente entre los individuos de una especie, pero dentro de una especie, el volumen encefálico no se relaciona directamente con la inteligencia[12].

Homo habilis.

El cerebro de Lucy solo era ligeramente mayor que el de un chimpancé, y lo que es más importante, la forma de su cráneo indica que el aumento de la potencia cerebral se concentraba en regiones del cerebro que se ocupan del procesamiento sensorial, mientras que los lóbulos frontal, temporal y parietales, las regiones del cerebro que forman la sede del lenguaje y el razonamiento abstracto, se mantenían relativamente poco desarrolladas. Lucy fue un paso adelante hacia el género Homo, pero no llegaba a alcanzarlo. Eso cambió con Homo habilis.

Como Lucy, el Humano Hábil se mantenía erguido, con las manos libres para llevar cosas, pero a diferencia de Lucy, usaba esa libertad para experimentar con su entorno[13].

Y así fue como, hace unos dos millones de años, un Homo habilis Einstein, o una Marie Curie, o, lo que tal vez sea más probable, varios genios antiguos por su propia cuenta, realizaron el primer gran descubrimiento de la humanidad: si se golpea una piedra con otra en un ángulo oblicuo, se consigue desprender un fragmento de roca afilado, como un cuchillo. Aprender a golpear una piedra contra otra puede no parecer el principio de una revolución social y cultural. Ciertamente, producir un trozo de piedra afilado palidece en comparación con la invención de la bombilla, internet o las galletas de chocolate. Pero fue nuestro primer pasito hacia la comprensión de que éramos capaces de aprender sobre la naturaleza y transformarla para mejorar nuestra propia existencia, y de que podíamos confiar en que nuestro cerebro nos confiriera poderes que complementaban y a menudo excedían los de nuestro cuerpo.

Para una criatura que nunca había visto una herramienta de ningún tipo, una especie de enorme diente artificial que se podía agarrar con la mano y usar para cortar es una invención que cambia la vida, y de hecho ayudó a cambiar por completo la forma en que vivían los humanos. Lucy y su estirpe eran vegetarianos; los estudios microscópicos del desgaste de los dientes de Homo habilis, y las marcas de corte en huesos hallados cerca de sus esqueletos, indican que los Humanos Hábiles usaron sus cuchillos de piedra para añadir carne a su dieta [14].

La dieta vegetariana sometía a Lucy y a los de su especie a la escasez estacional de alimento. Una dieta mixta ayudó a Homo habilis a salvar esos periodos de escasez. Y como la carne es una forma más concentrada de nutrientes que la materia vegetal, los carnívoros requieren una cantidad menor de alimento que los vegetarianos. Por otro lado, no hay que cazar y matar una cabeza de brécol, mientras que procurarse alimento animal puede ser bastante difícil si no se dispone de armas letales, de las que carecían los Humanos Hábiles. En consecuencia, Homo habilis obtenía la mayor parte de la carne de la carroña que dejaban depredadores como los tigres de dientes de sable, que, con sus potentes zarpas delanteras y sus dientes como cuchillos, mataban presas a menudo más grandes de lo que ellos mismos podían consumir. Pero incluso la vida de carroñero puede ser difícil si, como le ocurría a Homo habilis, hay que competir con otras especies. Así que la próxima vez que nos pongamos nerviosos por esperar media hora en nuestro restaurante preferido, debemos intentar recordar que nuestros antepasados, para obtener su sustento, tenían que pelearse con bandas de feroces hienas.

En su lucha por obtener alimento, las piedras afiladas de los Humanos Hábiles debieron hacer más fácil y rápida la tarea de arrancar la carne de los huesos, lo que debió ayudarles a competir en mejores términos con animales que ya nacían con una buena dote de herramientas equivalentes [15].

Así que cuando aparecieron estos instrumentos, se hicieron tremendamente populares, y fueron la herramienta humana predilecta durante casi dos millones de años. De hecho, fueron piedras como estas, esparcidas alrededor de los fósiles de Homo habilis, las que inspiraron el nombre de «Humano Hábil» con el que Louis Leakey y sus colaboradores bautizaron a esta especie a principios de la década de 1960. Desde entonces, estos cantos tallados se han encontrado en tal abundancia en las excavaciones que a menudo hay que andarse con cuidado para no pisarlos.

De unas piedras afiladas a un trasplante de hígado hay mucho trecho, pero, tal como refleja el uso que hacía de sus herramientas, la mente de Homo habilis ya había superado las habilidades de cualquiera de sus parientes simios actuales. Por ejemplo, aun después de años de entrenamiento por investigadores de primates, los bonobos no consiguen dominar el uso de herramientas de piedra simples del tipo de las que empleaba Homo habilis[16]. Estudios recientes con técnicas de neuroimagen sugieren que esta capacidad para diseñar, planificar y usar herramientas surgió con el desarrollo evolutivo de una red especializada en el uso de herramientas en el hemisferio izquierdo de nuestro cerebro[17].

Hay unos pocos y tristes casos de humanos con daños en esa red que se quedan a la altura de los bonobos: pueden identificar herramientas, pero, como yo mismo antes del primer café, no llegan a averiguar cómo usar los instrumentos más simples, como un cepillo de dientes o un peine [18].

Pese a sus avances en la potencia cognitiva, esta especie humana de hace más de dos millones de años, Homo habilis, no es más que una sombra de los humanos modernos: aún tenían un cerebro relativamente pequeño, poca estatura, brazos largos y un rostro que solo un cuidador de zoo podría amar. Pero tras su aparición, no pasaría mucho tiempo (a una escala geológica) antes de que surgieran otras especies de Homo. La más importante de estas, las que la mayoría de los expertos considera el antepasado directo de nuestra propia especie, fue Homo erectus, o «Humano Erguido», que se originó en África hace alrededor de 1,8 millones de años[19].

Los restos de esqueletos nos dicen que esta especie guardaba un parecido mucho mayor con la nuestra que Homo habilis, no solo por estar más erguido, sino también por ser más grande y alto (casi metro y medio de estatura), y tener extremidades largas y un cráneo mucho más grande, lo que permitió la expansión de los lóbulos frontal, temporal y parietales del cerebro.

Aquel cráneo de mayor tamaño tuvo consecuencias para el parto. Una de las cosas de las que no tienen que preocuparse los fabricantes de coches cuando rediseñan uno de sus modelos es cómo conseguir que los nuevos Honda se deshagan del tubo de escape de los modelos anteriores. La naturaleza sí que tiene que preocuparse de cuestiones parecidas, y, en el caso de Homo erectus, el rediseño de la cabeza ocasionó algunos problemas: las hembras de Homo erectus tenían que ser más grandes que sus predecesores para dar a luz a sus bebés de cabeza y cerebro grandes. Así, mientras que una hembra de Homo habilis era solo un 60% mayor que el macho, en promedio la mujer de Homo erectus pesaba un 85% más que su compañero.

Los nuevos cerebros merecieron la pena, porque el Humano Erguido marcó otro cambio abrupto y magnífico en nuestra evolución. Vieron el mundo, y se enfrentaron a sus desafíos de una forma distinta que sus predecesores. En concreto, fueron los primeros humanos con el ingenio y la planificación necesarias para crear herramientas complejas de piedra y madera: hachas, cuchillos y hendedores de cuidada factura que requerían de otras herramientas para su fabricación. Hoy atribuimos a nuestro cerebro la habilidad de crear ciencia y tecnología, arte y literatura, pero la capacidad de nuestro cerebro para concebir herramientas complejas fue mucho más importante para nuestra especie, pues nos ofreció una ventaja que nos ayudó a sobrevivir.

Gracias a sus herramientas avanzadas, los Humanos Erguidos podían cazar, no solo buscar carroña, lo que aumentó la disponibilidad de carne en su dieta. Si las recetas de ternera de los modernos libros de cocina comenzasen por decir, «Cace y mate una ternera», la mayoría nos conformaríamos con recetas de libros como Las delicias de la berenjena. Pero en la historia de la evolución humana, la nueva capacidad de cazar representó un gigantesco salto adelante que permitió un mayor consumo de proteína y una menor dependencia de los enormes volúmenes de vegetales que antes eran necesarios para sobrevivir. Los Humanos Erguidos probablemente hayan sido también la primera especie en aprender que la fricción entre dos materiales genera calor, y en descubrir que el calor enciende el fuego. Con el fuego, Homo erectus pudo hacer lo que ningún otro animal: mantenerse caliente en climas que de otro modo habrían sido demasiado fríos para vivir.

Me resulta reconfortante pensar que, aunque voy a cazar a la carnicería y mi idea de usar una herramienta es llamar al carpintero, provengo de una gente que eran bastante duchos en estas cosas prácticas, por mucho que tuvieran el ceño salido y unos dientes que podrían partir un bastón. Lo más importante es que aquellos nuevos logros de la mente permitieron que Homo erectus se expandiera desde África hacia Europa y Asia, y que persistiera como especie durante más de un millón de años.

Si los avances en nuestra inteligencia nos permitieron fabricar complejas herramientas de caza y cortar la carne, también crearon una necesidad nueva y apremiante, pues perseguir y acorralar a un animal grande y rápido en una sabana es algo que se hace mejor en grupo. Y así fue como, mucho antes de formar equipos de estrellas del baloncesto o el fútbol, nuestro género se vio sometido a una presión evolutiva para desarrollar la suficiente inteligencia social y las habilidades de planificación necesarias para juntarse en grupos y conseguir cazar antílopes y gacelas. Por consiguiente, el nuevo estilo de vida de los Humanos Erguidos favoreció la supervivencia de quienes pudieran comunicarse y planificar mejor. Una vez más, vemos aquí que los orígenes de la naturaleza de los humanos modernos hunde sus raíces en la sabana africana.

Hacia el final del reinado de los Humanos Erguidos, hace tal vez medio millón de años, Homo erectus evolucionó hacia una nueva forma, Homo sapiens, con un poder cerebral todavía mayor. Aquellos primeros o «arcaicos» Homo sapiens no eran todavía seres que pudiéramos reconocer como humanos actuales: tenían el cuerpo más robusto y el cráneo más grande y grueso, pero su cerebro todavía no era tan grande como el nuestro. Anatómicamente, los humanos modernos se clasifican como una subespecie de Homo sapiens que probablemente no surgió de los primeros Homo sapiens hasta más o menos 200 000 a. C.

Casi no lo conseguimos: un sorprendente análisis del ADN realizado recientemente por antropólogos genéticos indica que hace unos 140 000 años un suceso catastrófico, probablemente relacionado con el cambio climático, diezmó la población de humanos modernos, todos los cuales vivían entonces en África. Durante ese periodo, la población entera de nuestra subespecie se desplomó hasta quedar en apenas unos centenares, convirtiéndonos en lo que hoy calificaríamos de «especie en peligro de extinción», como el gorila de montaña o la ballena azul. Isaac Newton, Albert Einstein y cualquier otra persona de la que hayamos oído hablar, además de los varios miles de millones que hoy vivimos en el mundo, todos descienden de aquellos pocos centenares que sobrevivieron[20].

Que entonces nos salváramos por los pelos quizá sea señal de que la nueva subespecie de cerebro más grande todavía no era lo bastante lista para sobrevivir a largo plazo. Pero entonces sufrimos otra transformación, y esta nos confirió unos prodigiosos poderes mentales. No parece que se debiera a un cambio en nuestra anatomía física, ni siquiera en la anatomía de nuestro cerebro. Parece más bien una reorganización del modo de funcionar de nuestro cerebro. Sea como fuere, fue aquella metamorfosis lo que permitió que nuestra especie produjera científicos, artistas, teólogos y, de manera más general, personas que piensan del mismo modo que lo hacemos nosotros.

Los antropólogos se refieren a esa última transformación mental como el desarrollo de «moderna conducta humana». Lo de «moderna conducta» no quiere decir comprar o tomar bebidas alcohólicas mientras se mira un partido, sino al ejercicio del pensamiento simbólico complejo, el tipo de actividad mental que con el tiempo nos llevaría a la moderna cultura humana. Hay cierta polémica sobre cuándo se produjo eso, pero la fecha más aceptada sitúa la transición hacia el 40 000 a. C[21].

Hoy a nuestra subespecie la llamamos Homo sapiens sapiens, o «humano sabio, sabio». (Una especie acaba recibiendo un nombre así cuando ella misma lo escoge). Pero los cambios que condujeron a nuestro cerebro más grande no salieron baratos. Desde el punto de vista del consumo de energía, el moderno cerebro humano es el segundo órgano más caro del cuerpo humano, por detrás del corazón [22].

En lugar de dotarnos de un cerebro con costes operativos, la naturaleza podría habernos concedido unos músculos más fuertes, que, en comparación con el cerebro, consumen tan solo una décima parte de calorías por unidad de masa. Sin embargo, la naturaleza decidió no convertir a nuestra especie en la mejor dotada físicamente[23].

Los humanos no somos especialmente fuertes, ni tampoco los más ágiles. Nuestros parientes más cercanos, el chimpancé y el bonobo, se abrieron paso hasta su nicho ecológico gracias a su capacidad para tirar con una fuerza de más de quinientos kilogramos y gracias a disponer de dientes duros y afilados con los que partir los frutos de cáscara resistente. A diferencia de ellos, yo lo paso mal incluso con las palomitas de maíz.

A falta de una masa muscular impresionante, los humanos tenemos un cráneo descomunal, lo que nos convierte en unos consumidores ineficientes de la energía de los alimentos, ya que nuestro cerebro, que solo representa alrededor del 2% del peso corporal, consume un 20% de la energía que ingerimos. Mientras que otros animales tienen las condiciones para sobreponerse a las asperezas de la vida en la jungla o la sabana, nosotros estamos más preparados para sentarnos en un café a tomar un cortado. Esa tendencia a sentarnos, sin embargo, no debe subestimarse, pues cuando lo hacemos, pensamos y cuestionamos.

En 1918, el psicólogo alemán Wolfgang Köhler publicó un libro, Experimentos sobre la inteligencia de los chimpancés, que habría de convertirse en un clásico. Se trataba de una exposición de los experimentos que había realizado con estos simios mientras era director de una estación que la Academia de Ciencias de Prusia tenía en Tenerife, en las islas Canarias. A Köhler le interesaba entender de qué modo resolvían los problemas los chimpancés, por ejemplo, cómo procurarse alimento que se ha colocado fuera de su alcance, y es mucho lo que sus experimentos revelan sobre los dones mentales que compartimos con otros primates. Pero si comparamos la conducta de los chimpancés con la nuestra, su libro también nos dice mucho sobre los talentos humanos que nos ayudan a compensar nuestras limitaciones físicas.

Uno de los experimentos de Köhler es especialmente revelador. Clavó un plátano en el techo y observó que los chimpancés aprendían a apilar cajas para subirse a ellas y alcanzar la fruta, pero no parecían tener el menor conocimiento de las fuerzas implicadas en lo que hacían. Por ejemplo, a veces intentaban colocar una caja sobre uno de sus cantos, o, si se colocaban piedras en el suelo para que las cajas se inclinasen, no se les ocurría retirarlas [24].

En una versión actualizada del experimento se enseñó a chimpancés y a niños de tres a cinco años a apilar bloques en forma de L para obtener una recompensa. Luego, sin que se dieran cuenta, se cambiaban los bloques por otros trucados de manera que se volcaban cuando los chimpancés o los niños intentaban apilarlos. Los chimpancés persistieron durante un tiempo, y por ensayo y error intentaron sin éxito conseguir la recompensa; sin embargo, no se pararon a examinar los bloques desequilibrados. Los niños también fracasaron en la nueva tarea (que de hecho era imposible), pero no se conformaron con darse por vencidos, sino que examinaron los bloques en un intento por determinar dónde estaba el problema [25].

Desde una temprana edad, los humanos buscamos respuestas, una comprensión teórica de nuestro entorno, nos preguntamos «¿por qué?».

Cualquiera que tenga la menor experiencia con niños sabe de su pasión por preguntar por qué. En los años 1920, el psicólogo Frank Lorimer la hizo oficial: observó a un niño de cuatro años durante un periodo de cuatro días y apuntó todas las veces que el niño preguntó por qué durante ese tiempo [26].

Hubo cuarenta preguntas, por ejemplo ¿por qué la regadera tiene dos asas? o ¿por qué tenemos cejas?, o mi favorita, ¿por qué no tienes barba, mamá? Los niños de todo el mundo hacen sus primeras preguntas a una tierna edad, cuando todavía balbucean y aún no hablan un lenguaje gramatical. El acto de preguntar es tan importante para nuestra especie que hay un indicador universal que nos lo da a conocer: todos los lenguajes, tonales o no tonales, emplean una entonación ascendente parecida para las preguntas [27].

Ciertas tradiciones religiosas ven en el acto de preguntar la más alta forma de aprehensión, y tanto en la ciencia como en la industria, la habilidad para formular las preguntas adecuadas posiblemente sea el mayor talento que uno pueda poseer. Los chimpancés y los bonobos pueden aprender a usar signos rudimentarios para comunicarse con sus entrenadores, incluso para responder preguntas, pero nunca las formulan. Son físicamente potentes, pero no son pensadores.

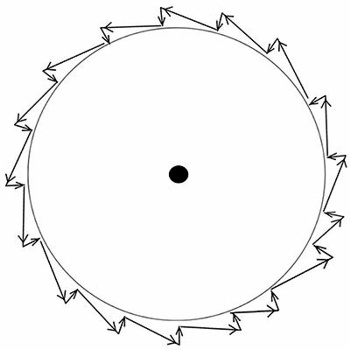

Los humanos nacemos con el ansia por comprender lo que nos rodea, pero parece que también tenemos al nacer (o al menos adquirimos a una edad muy temprana) una intuición sobre cómo funcionan las leyes de la física. Parece que entendamos de forma innata que todos los eventos están causados por otros eventos, y que gocemos de una intuición rudimentaria de las leyes que, tras miles de años de esfuerzo, fue a revelarnos Isaac Newton.

En el Laboratorio de Cognición Infantil de la Universidad de Illinois, los científicos llevan treinta años estudiando la intuición física de los bebés mediante el procedimiento de sentar a las madres con sus hijos frente a un pequeño escenario o una mesa y observar cómo reaccionan los bebés ante los sucesos que allí se representan. La pregunta científica es la siguiente: en lo que atañe al mundo físico, ¿qué saben estos bebés y desde cuándo lo saben? Lo que han descubierto es que poseer cierta intuición sobre cómo funciona la física parece ser un aspecto esencial de lo que significa ser humano, incluso en la más tierna infancia.

En una serie de estudios, se sentaba a unos bebés de seis meses frente a una vía horizontal sujeta a la base de una rampa inclinada [28].

Junto a la rampa, los investigadores colocaban un animal de juguete montado sobre ruedas, mientras que en lo alto de la rampa había un cilindro. En cuanto se soltaba el cilindro, los bebés presenciaban excitados cómo este rodaba cuesta abajo hasta que chocaba con el juguete y lo hacía rodar medio metro por la vía. Luego venía la parte que excitaba a los investigadores: si reproducían el montaje con un cilindro de distinto tamaño en lo alto de la rampa, ¿sabrían predecir los bebés que, tras la colisión, el juguete sería enviado a una distancia proporcional al tamaño del cilindro?

Lo primero que se me ocurrió cuando oí hablar de este experimento fue: ¿cómo sabemos qué predice un bebé? Ya me cuesta bastante entender lo que piensan mis hijos, y con más de diez y veinte años ya saben hablar. ¿Tenía alguna idea de lo que pensaban cuando solo reían, hacían muecas y babeaban? Lo cierto es que cuando pasamos el tiempo suficiente con unos bebés, comenzamos a atribuirles pensamientos por sus expresiones faciales, pero es difícil confirmar científicamente si nuestra intuición es correcta. Si vemos que un bebé arruga la cara como una pasa, ¿se debe a que tiene unos gases muy molestos o a que se ha enterado por la radio de que la bolsa ha caído quinientos puntos? Sé que mi propia expresión sería la misma en los dos casos, pero con los bebés, el aspecto es lo único que tenemos. Sin embargo, los psicólogos disponen de una aplicación para determinar lo que está prediciendo un bebé. Le muestran una cadena de eventos y miden durante cuánto tiempo observa la escena. Si los sucesos no se producen del modo que el bebé espera, seguirá mirando, y cuanto más sorprendente sea lo que ocurre, más tiempo sostendrá la mirada.

En el experimento de la rampa, los científicos hicieron que la mitad de los bebés mirasen una segunda colisión en la que el cilindro era mayor que la primera vez, mientras que los otros presenciaron una segunda colisión en la que el cilindro era menor. En ambos casos, sin embargo, los astutos investigadores dispusieron las cosas de tal modo que el juguete rodase más lejos que en la primera colisión, hasta el final de la vía. Los bebés que vieron el cilindro más grande no reaccionaron de forma excepcional ante los sucesos. Pero los bebés que vieron cómo el juguete llegaba más lejos después de ser golpeado por un cilindro más pequeño lo miraron durante más tiempo, dando la impresión de que se estuvieran rascando la cabeza, si supiesen cómo hacerlo.

Saber que un impacto grande envía el juguete más lejos que un impacto pequeño no le sitúa a la par de Isaac Newton, pero, como ilustra este experimento, parece que los humanos realmente poseemos cierta comprensión innata del mundo físico, un sofisticado instinto de lo que nos rodea que complementa nuestra innata curiosidad y está mucho más desarrollada en los humanos que en otras especies.

A lo largo de millones de años, nuestra especie evolucionó y progresó, adquiriendo un cerebro más potente, esforzándose como individuos para aprender todo lo que pudieran sobre el mundo. El desarrollo de la mente humana moderna fue un desarrollo necesario para entender la naturaleza, pero no suficiente. Por eso, el siguiente capítulo de nuestra historia es el relato de cómo comenzamos a preguntarnos por nuestro entorno y a trabajar intelectualmente en grupo para encontrar respuestas. Es el relato del desarrollo de la cultura humana.

3. Cultura

Los que nos miramos al espejo cada mañana vemos algo que pocos animales llegan a reconocer: a nosotros mismos. Algunos sonreímos ante nuestra imagen y nos lanzamos un beso, otros corremos a cubrir el desastre con maquillaje o a afeitarnos, para no parecer desaliñados. Sea como sea, en el conjunto de los animales, la reacción humana es rara. Si la tenemos es porque a lo largo del sendero de nuestra evolución, los humanos nos hicimos conscientes de nosotros mismos. Más importante aún es que comenzamos a comprender con claridad que al rostro que vemos en los reflejos, con el tiempo, le saldrán arrugas, le crecerá el pelo en lugares bochornosos y, lo peor de todo, dejará de existir. En otras palabras, comenzamos a pensar en la mortalidad.

Nuestro cerebro es nuestra máquina mental, y fue en pos de la supervivencia como desarrollamos uno con la capacidad de pensar simbólicamente, de cuestionar y razonar. Pero una máquina, cuando ya se tiene, se puede dedicar a muchos usos, y a medida que la imaginación de Homo sapiens sapiens avanzaba, y a grandes pasos, darnos cuenta de que un día todos hemos de morir ayudó a que nuestro cerebro se ocupara de cuestiones existenciales como «¿quién se encuentra al cargo del cosmos?». Esta no es una pregunta científica per se, pero el camino hacia preguntas como «¿qué es un átomo?» comenzaron con indagaciones como aquellas, además de otras más personales, como «¿quién soy?» o «¿puedo modificar mi entorno en mi propio beneficio?». Fue entonces, cuando los humanos nos alzamos sobre nuestros orígenes animales y comenzamos a hacer estas indagaciones, cuando dimos nuestro siguiente paso hacia una especie cuya distinción radica en pensar y preguntar.

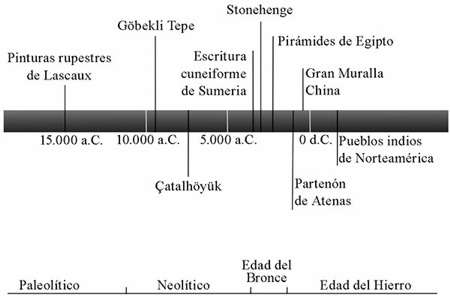

El cambio en los procesos del pensamiento que nos llevaron a los humanos a considerar aquellas cuestiones, probablemente se gestase durante decenas de miles de años, más o menos desde el momento, posiblemente hace unos cuarenta mil años, cuando nuestra subespecie comenzó a manifestar lo que consideramos conductas modernas. Pero no floreció hasta hace unos doce mil años, hacia el final de la última edad de hielo. Los científicos llaman a los dos millones de años que llevan hasta ese periodo Era Paleolítica, y a los siete u ocho mil años siguientes, Era Neolítica. Estos nombres provienen de las raíces griegas palaio, que significa «viejo», neo, que significa «nuevo», y lithos, que significa «piedra»; en otras palabras, Vieja Edad de Piedra (Paleolítico) y Nueva Edad de Piedra (Neolítico), ambas caracterizadas por el uso de herramientas de este material. Aunque a los amplios cambios que nos llevaron de la Vieja a la Nueva Edad de Piedra los calificamos de «revolución neolítica», no tuvo nada que ver con las herramientas de piedra, sino con la forma de pensar, con las preguntas que nos hacíamos, con los problemas de la existencia que consideramos importantes.

Los humanos paleolíticos migraban a menudo, y, como mis hijos adolescentes, seguían la comida. Las mujeres recolectaban plantas, semillas y huevos, en tanto que los hombres solían cazar y buscar carroña. Estos nómadas se desplazaban estacionalmente o incluso diariamente, atesoraban pocas posesiones y vivían siempre a merced de la naturaleza, buscando la abundancia de la naturaleza y soportando sus rigores [29].

Con todo, la tierra era solo lo bastante generosa para sustentar alrededor de dos personas en cinco kilómetros cuadrados, de modo que durante la mayor parte de la Era Paleolítica la gente vivía en pequeños grupos errantes, por lo general de menos de un centenar de individuos. El término «revolución neolítica» se acuñó en los años 1920 para describir la transición de ese estilo de vida a una nueva existencia en la que los humanos comenzaron a establecerse en pequeños poblados formados por una o dos docenas de viviendas, y pasaron de recolectar su alimento a producirlo.

Ese cambio llevó a una tendencia a modificar activamente el entorno en lugar de simplemente reaccionar ante él. En lugar de vivir de aquello que la generosidad de la naturaleza les ofrecía, la gente que vivía en aquellos pequeños poblados recogía materiales sin ningún valor intrínseco en su forma natural para luego modificarlos y convertirlos en objetos valiosos. Por ejemplo, construían chozas con madera, adobe y piedra; forjaban herramientas con el cobre metálico que encontraban en la naturaleza, fabricaban cestos con ramitas, retorcían las fibras extraídas de lino y otras plantas y animales formando hebras con las que luego tejían ropas más ligeras, porosas y fáciles de lavar que las pieles de animales que llevaban antes, y modelaban y cocían cuencos y jarras de arcilla que podían usar para cocinar o almacenar excedentes de comida[30].

A primera vista, la invención de objetos como las jarras de arcilla puede no parecer más profunda que comprender lo difícil que es llevar agua en el bolsillo. Y lo cierto es que hasta hace poco tiempo muchos arqueólogos creían que la revolución neolítica no había sido más que una adaptación dirigida a hacer más fácil la vida. El cambio climático al final de la última edad de hielo, hace unos diez a doce mil años, causó la extinción de muchos animales de gran tamaño y alteró las pautas migratorias de otros. Esto, se razonaba, había afectado a la disponibilidad de alimento para los humanos. Algunos especularon también que el número de humanos había crecido hasta el punto de que la caza y la recolección ya no bastaban para sustentar la población. Los asentamientos y el desarrollo de herramientas complejas eran, bajo esta perspectiva, una reacción a aquellas circunstancias.

Pero esta teoría no carece de problemas. Para empezar, la malnutrición y las enfermedades dejan su impronta en los huesos y los dientes. Durante los años 1980, sin embargo, las investigaciones realizadas sobre los restos esqueléticos del periodo anterior a la revolución neolítica no revelaron ninguno de estos daños, lo que sugiere que la gente de aquella época no sufría privaciones nutricionales. De hecho, los indicios paleontológicos sugieren que los primeros agricultores tenían más problemas de columna, peor dentadura, más anemia y deficiencias vitamínicas, y morían más jóvenes que las poblaciones de recolectores que los precedieron[31].

Más aún, la adopción de la agricultura parece haber sido gradual, no el resultado de una amplia catástrofe climática. Además, muchos de los primeros asentamientos no mostraban signos de haber domesticado plantas o animales.

Solemos imaginar el modo de vida de cazadores y recolectores de los primeros humanos como una dura lucha por la existencia, como un programa de telerrealidad en el que unos famélicos concursantes viven en la jungla y se ven obligados a comer insectos y guano de murciélago. ¿No sería mejor la vida si aquellos recolectores pudieran comprar herramientas y semillas en Leroy Merlin y plantar nabos? No necesariamente, pues los estudios realizados sobre los pocos pueblos de cazadores y recolectores que quedan en lugares prístinos e inalterados de Australia y África hasta los años 1960 sugieren que las sociedades nómadas de hace miles de años podrían haber gozado de «plenitud material [32]».

Por lo general, la vida nómada consiste en asentarse temporalmente en un lugar hasta que se agotan las fuentes de alimento de un área razonable de explotación. Cuando ocurre esto, los recolectores se desplazan. Como tienen que llevarse consigo todas sus posesiones, los pueblos nómadas valoran más las cosas pequeñas que las grandes, están satisfechos con pocos bienes materiales y suelen tener poco sentido de la propiedad. Estos aspectos de la cultura nómada hicieron que a los ojos de los antropólogos occidentales que comenzaron a estudiarlos en el siglo XIX, les parecieran pobres y necesitados. Pero los nómadas, por regla general, no se enfrentan a una dura lucha por el alimento o, de manera más general, por la supervivencia. De hecho, los estudios del pueblo san (los bosquimanos) de África revelaron que sus actividades para obtener alimento eran más eficientes que las de los agricultores de la Europa anterior a la segunda guerra mundial, e investigaciones más amplias sobre grupos de cazadores-recolectores desde el siglo XIX hasta mediados del siglo XX muestran que por término medio el nómada trabaja solamente de dos a cuatro horas al día [33].

Incluso en la árida región de Dobe en África, con una precipitación anual de apenas 150 a 250 milímetros, los recursos alimenticios resultaron ser «variados y abundantes». En cambio, la agricultura primitiva exige deslomarse durante largas horas acarreando piedras y rocas, desbrozando y roturando terrenos duros con las más primitivas herramientas.

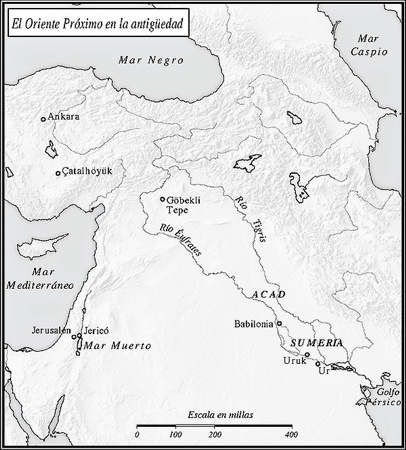

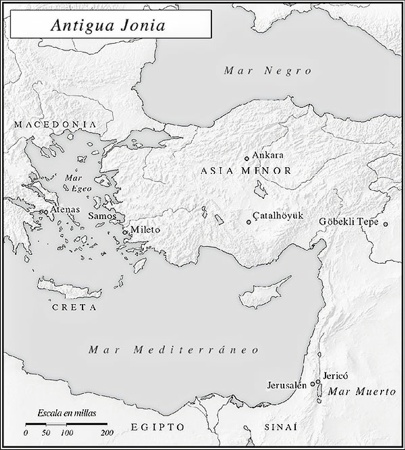

Estas observaciones sugieren que las viejas teorías sobre las razones de la sedentarización de los humanos no nos cuentan la historia completa. Al contrario, hoy muchos creen que la revolución neolítica no fue, en primer término, una revolución inspirada por consideraciones prácticas, sino más bien una revolución mental y cultural alimentada por el crecimiento de la espiritualidad humana. Este punto de vista se asienta en el que quizá sea el más sorprendente y notable descubrimiento arqueológico de los tiempos modernos, que nos sugiere que la nueva manera de relacionarse con la naturaleza no siguió al desarrollo de un modo de vida sedentario, sino que lo precedió. Ese descubrimiento es el gran monumento conocido como Göbekli Tepe, una expresión turca que describe el aspecto que tenía antes de excavarlo: «colina panzuda [34]».

Göbekli Tepe se encuentra en lo alto de una colina en lo que hoy es la provincia de Urfa, en el sureste de Turquía. Es una magnífica estructura construida hace 11 500 años (7000 antes que la Gran Pirámide) gracias a los hercúleos esfuerzos no de pobladores neolíticos, sino de cazadores-recolectores que todavía no habían abandonado el modo de vida nómada. Pero lo más sorprendente es el uso para el que fue erigido. Precediendo a la Biblia hebrea en unos 10 000 años, todo parece indicar que Göbekli Tepe era un santuario religioso.

Los pilares de Göbekli Tepe se encuentran dispuestos en círculos de hasta veinte metros de diámetro. Cada círculo contenía en el centro dos pilares adicionales en forma de T, aparentemente figuras humanoides de cabeza oblonga y cuerpo largo y delgado. El más alto de ellos sobrepasa los cinco metros de altura. Su construcción requirió el transporte de enormes piedras, algunas de hasta dieciséis toneladas, a pesar de que se hizo antes de la invención de las herramientas de metal, antes de la invención de la rueda y antes de que la gente aprendiese a domesticar animales como bestias de carga. Más aún, a diferencia de los edificios religiosos de tiempos posteriores, Göbekli Tepe se construyó antes de que la gente viviera en ciudades que pudieran proveer una fuente grande y organizada de trabajadores. En palabras de National Geographic, «descubrir que los cazadores-recolectores habían construido Göbekli Tepe fue como descubrir que alguien hubiera construido un 747 en su sótano con una navaja».

Los primeros científicos que dieron con el monumento fueron unos antropólogos de la Universidad de Chicago y de la Universidad de Estambul, mientras realizaban una prospección de la región en los años 1960. Observaron varias losas de piedra caliza que sobresalían del suelo, pero no les dieron importancia, considerándolas restos de un cementerio bizantino abandonado. La comunidad de antropólogos emitió un profundo bostezo. Pasaron tres décadas, y en 1994 un agricultor de la región tropezó con su arado en lo alto de lo que resultó ser un enorme pilar enterrado. Klaus Schmidt, un arqueólogo que trabajaba por aquella zona y que había leído el informe de la Universidad de Chicago, decidió echar un vistazo. «Al minuto de verlo, supe que tenía dos opciones», decía. «Marcharme y no decirle nada a nadie, o pasar el resto de mi vida trabajando aquí [35]».

Hizo esto último, estudiando el yacimiento hasta su muerte en 2014.

Como Göbekli Tepe es anterior a la invención de la escritura, no disponemos de fragmentos de textos sagrados que, una vez descodificados, arrojen luz sobre los rituales que allí se practicaban. La conclusión de que Göbekli Tepe era un lugar de adoración se basa en comparaciones con prácticas y sitios religiosos posteriores. Por ejemplo, tallados en los pilares de Göbekli Tepe se encuentran diversos animales, pero a diferencia de las pinturas rupestres de la Era Paleolítica, no se corresponden con los animales que los constructores de Göbekli Tepe debían cazar para subsistir, y tampoco representan iconos relacionados con la caza o con las acciones de la vida diaria, sino que representan animales amenazadores como leones, culebras, jabalíes, escorpiones y una fiera parecida a un chacal con la caja torácica expuesta. Se cree que se trata de personajes simbólicos o míticos, el tipo de animales que más tarde se asociaría con la adoración.

Para los antiguos habitantes, visitar Göbekli Tepe debía representar un compromiso muy serio, pues se encuentra en medio de la nada. De hecho, nunca se han hallado indicios de que nadie viviera jamás en aquella área: ni fuentes de agua, ni casas, ni restos de hogares. Lo que sí encontraron los arqueólogos fueron los huesos de miles de gacelas y uros que debieron ser transportados como alimento desde lejanos lugares de caza. Ir a Göbekli Tepe era hacer un peregrinaje, y los indicios señalan que atraía a cazadores-recolectores nómadas de hasta cien kilómetros a la redonda.

Göbekli Tepe «muestra que primero fueron los cambios socioculturales, luego la agricultura», dice Ian Hodder, arqueólogo de la Universidad de Stanford. En otras palabras, el surgimiento de rituales religiosos realizados en grupo parece haber sido una razón importante para que los humanos comenzaran a asentarse a medida que los centros religiosos atraían a los nómadas hacia sus estrictas órbitas, hasta que se formaron pueblos basados en sistemas compartidos de creencias y significados[36].

Göbekli Tepe se construyó en una época en la que todavía rondaban tigres de dientes de sable[III] por los parajes de Asia, y el último de nuestros parientes no pertenecientes a Homo sapiens, un cazador y fabricante de herramientas con aspecto de hobbit, de apenas un metro de estatura, bautizado como Homo floresiensis, tan solo llevaba algunos siglos extinguido. Y, sin embargo, sus antiguos constructores, por lo que sabemos, ya habían pasado de hacerse preguntas pragmáticas sobre la vida a plantearse también preguntas espirituales. «Puede argumentarse sólidamente», dice Hodder, que Göbekli Tepe «es el verdadero origen de las complejas sociedades modernas [37]».

Otros animales resuelven problemas sencillos para obtener alimento, otros animales usan instrumentos simples, pero una actividad que nunca se ha observado, ni siquiera en una forma rudimentaria, en ningún animal aparte del humano es intentar comprender su propia existencia. Así que cuando los últimos pueblos paleolíticos y los primeros neolíticos desviaron su atención de la simple supervivencia y la dirigieron a verdades «no esenciales» sobre ellos mismos y su entorno, se produjo uno de los pasos más significativos de la historia del intelecto humano. Si Göbekli Tepe es la primera iglesia de la humanidad (al menos que sepamos), merece un lugar de honor en la historia de la religión, pero también en la historia de la ciencia, puesto que refleja un salto en nuestra conciencia existencial, el inicio de una era en la que los humanos comenzamos a dedicar un gran esfuerzo a responder las grandes preguntas sobre el cosmos.

La naturaleza necesitó millones de años para producir, mediante la evolución, una mente humana capaz de hacerse preguntas existenciales, pero en cuanto eso ocurrió, hizo falta una fracción infinitesimal de ese tiempo para que nuestra especie desarrollara culturas que le darían la vuelta a nuestra manera de vivir y pensar. Los pueblos neolíticos empezaron a asentarse en pequeños pueblos y luego, a medida que su arduo trabajo en el campo consiguió aumentar su producción de alimentos, en pueblos de mayor tamaño, de manera que la densidad de población se disparó desde apenas dos personas en cinco kilómetros cuadrados a un par de cientos[38].

El más impresionante de estos nuevos grandes asentamientos era Çatalhöyük, construido hacia 7500 a. C. en las llanuras del centro de Turquía, a apenas unos cientos de kilómetros al oeste de Göbekli Tepe[39].

Los análisis de restos de animales y plantas hallados allí sugieren que sus habitantes cazaban vacas, cerdos y caballos salvajes y recogían tubérculos, gramíneas, bellotas y pistachos, pero se dedicaban poco a la agricultura. Lo que es más sorprendente es que las herramientas y los instrumentos hallados en las casas indican que los habitantes construían y mantenían sus propias casas y realizaban su propio arte. Parece que no existía la división del trabajo. Eso no resultaría extraño en un pequeño poblado de nómadas, pero Çatalhöyük era el hogar de hasta ocho mil personas (unas dos mil familias), todas las cuales, en palabras de un arqueólogo, «iban a lo suyo».

Ruinas de Göbekli Tepe.

Es función de las relaciones sociales dentro de la población, en la medida que esas relaciones afectan a los medios de producción y distribución. En las ciudades se establece una división del trabajo, lo que significa que los individuos y familias dependen de otros para obtener ciertos bienes y servicios. Al centralizar la distribución de varios bienes y servicios que todos necesitan, la ciudad libera a los individuos y familias de la necesidad de hacerlo todo por sí mismos, lo que a su vez permite que algunos se dediquen a actividades especializadas. Por ejemplo, si la ciudad se convierte en un centro donde los excedentes agrícolas cosechados por labradores que viven en los campos circundantes pueden distribuirse entre los habitantes, personas que de otro modo se habrían ocupado de recolectar (o cultivar) alimentos quedan libres para practicar profesiones, y llegar a ser artesanos o sacerdotes. Pero en Çatalhöyük, aunque los habitantes viviesen en casas contiguas, los artefactos indican que cada familia se ocupaba de las actividades prácticas de la vida más o menos con independencia de las otras.

Si cada uno de los grupos familiares tenía que ser autosuficiente, si no había manera de obtener la carne del carnicero, o conseguir que un fontanero arregle las tuberías, o reemplazar un móvil dañado por el agua llevándolo al Apple Store más cercano y fingiendo que no se ha caído en el váter, ¿por qué habrían de molestarse en establecerse pared con pared como en un pueblo?

Línea del tiempo.

La contemplación de la mortalidad humana se convirtió en una de las características de aquellas culturas emergentes. En Çatalhöyük, por ejemplo, vemos indicios de una nueva cultura de la muerte y el morir que difería drásticamente de la que tenían los nómadas. Durante sus largos viajes salvando colinas y vadeando caudalosos ríos, los nómadas no se pueden permitir el lujo de llevar a los débiles y enfermos.

Por esa razón, es habitual en las tribus nómadas que, cuando están en marcha, dejen atrás a los viejos que están demasiado débiles para seguirlos. Las prácticas de quienes se asentaron en Çatalhöyük y otros pueblos olvidados de Oriente Próximo era casi la contraria. Sus unidades familiares extensas a menudo se mantenían físicamente cercanas, no solo en la vida sino también en la muerte: en Çatalhöyük, enterraban a sus muertos bajo el suelo de las casas [41].

Los bebés a veces se enterraban bajo el umbral de la entrada a una habitación. Debajo de un gran edificio, un equipo de excavación descubrió setenta cuerpos. En algunos casos, un año después del enterramiento, los habitantes abrían la tumba y usaban un cuchillo para cortar la cabeza del muerto, que usaban con fines ceremoniales [42].

Los habitantes de Çatalhöyük se preocupaban por su mortalidad, pero también manifestaban un nuevo sentido de la superioridad humana. En la mayoría de las sociedades de cazadores-recolectores, los animales se tratan con gran respeto, como si cazador y presa fuesen compañeros. Los cazadores no pretenden controlar a sus presas, sino que entablan cierto tipo de amistad con los animales que van a ofrecer su vida al cazador. En Çatalhöyük, en cambio, todos los murales representan personas que hostigan y acosan toros, osos y jabalíes. Ya no se veía a los humanos como compañeros de los animales; ahora los dominaban, los usaban igual que las ramitas con las que hacían sus cestos[43].

Esta nueva actitud conduciría con el tiempo a la domesticación de los animales[44].

A lo largo de los dos mil años siguientes se domesticaron las ovejas y las cabras, y luego las vacas y los cerdos. Al principio hubo caza selectiva: se descastaban los rebaños salvajes para conseguir un equilibro de edades y sexo, y se intentaba protegerlos de sus depredadores naturales. Con el tiempo, sin embargo, los humanos fueron haciéndose responsables de todos los aspectos de la vida de aquellos animales. Como los animales domesticados ya no tenían que defenderse por sí mismos, respondieron evolucionando hacia nuevos atributos físicos además de un comportamiento más manso, un cerebro más pequeño y una menor inteligencia. También empezaron a controlar plantas como el trigo, la cebada, las lentejas y los guisantes, entre otros, y fueron dejando la ocupación de recolector para hacerse agricultores.

La invención de la agricultura y la domesticación de los animales catalizaron nuevos saltos intelectuales relacionados con la maximización de la eficiencia de aquellas actividades. Los humanos estaban ahora motivados para aprender y sacar provecho de las reglas y regularidades de la naturaleza. Resultaba útil saber cómo se reproducían los animales y cómo crecían las plantas. Esos fueron los principios de lo que habría de convertirse en la ciencia, pero a falta de método científico o de cualquier apreciación de las ventajas del razonamiento lógico, las ideas mágicas y las ideas religiosas se mezclaban, y a menudo sustituían a las teorías y las observaciones empíricas con un fin que era más práctico que el de la ciencia pura en la actualidad: ayudar a los humanos a ejercer su poder sobre el funcionamiento de la naturaleza.

A medida que los humanos comenzaron a hacer preguntas sobre la naturaleza, la gran expansión de los asentamientos neolíticos proporcionó una nueva manera de darles respuesta. Ahora la búsqueda de conocimiento ya no era necesariamente el empeño de un individuo o de pequeños grupos, sino que podía reunir las contribuciones de un gran número de mentes. Aquellos humanos que prácticamente habían abandonado la práctica de la caza y la recolección de alimentos, ahora unían fuerzas en la caza y recolección de ideas y conocimiento.

Cuando me decidí a hacer un doctorado, el reto que escogí para mi tesis fue desarrollar un nuevo método para encontrar soluciones aproximadas a las ecuaciones cuánticas irresolubles que describen el comportamiento de los átomos de hidrógeno en el fuerte campo magnético que rodea a las estrellas de neutrones, las estrellas más densas y pequeñas que conocemos en el universo. No tengo la menor idea de por qué escogí ese tema, y al parecer tampoco mi director, que enseguida perdió el interés. Pasé un año entero desarrollando varias técnicas de aproximación nuevas que, una tras otra, resultaron no resolver el problema mejor que cualquiera de los métodos existentes, y por tanto no servían para obtener un título de doctor. Entonces ocurrió que un día estuve charlando con un investigador posdoctoral que tenía su despacho en el edificio en el lado opuesto a mi oficina. Él trabajaba en un nuevo enfoque para entender el comportamiento de las partículas elementales llamadas quarks, que se presentan en tres «colores». (Este término, aplicado a los quarks, no tiene nada que ver con la definición cotidiana de «color»). La idea era imaginar (matemáticamente) un mundo con un número infinito de colores, en lugar de tres. A medida que hablábamos sobre los quarks, que no guardan la menor relación con el trabajo que yo estaba haciendo, surgió una nueva idea: ¿Y si resolviera mi problema suponiendo no que vivimos en un mundo de tres dimensiones, sino en uno de infinitas dimensiones?

Si la idea parece extraña y descabellada, es porque lo era. Pero a medida que trabajamos la matemática, descubrimos que, curiosamente, aunque no podía resolver mi problema tal como se manifestaba en el mundo real, sí podía hacerlo si reformulaba el problema en infinitas dimensiones. Una vez tuve la solución, «todo» lo que restaba por hacer para doctorarme era averiguar cómo modificar la respuesta para tener en cuenta que en realidad vivimos en un espacio tridimensional.

Este método resultó ser muy potente: ahora podía hacer los cálculos en un papel y obtener resultados de mucha mayor exactitud que los complejos cálculos por ordenador que otros utilizaban. Tras un año de esfuerzos infructuosos, acabé realizando el núcleo duro de lo que habría de ser mi tesis doctoral sobre la «expansión a gran N» en tan solo unas pocas semanas y, durante el año siguiente, aquel investigador posdoctoral y yo produjimos una serie de artículos en los que aplicábamos la idea a otras situaciones y otros átomos[45].

Al final, un químico galardonado con el premio Nobel llamado Dudley Herschbach leyó sobre nuestro método en una revista con el apasionante nombre dePhysics Today. Le cambió el nombre a la técnica por el de «escalado dimensional» y empezó a aplicarlo a su propio campo [46].